🔥 معرفی دونده مدل Docker – استنباط AI را به محیط DEV محلی خود بیاورید

تصور کنید که مدل های LLMS و Genai را با یک دستور docker واحد اجرا کنید – به صورت محلی ، یکپارچه و بدون هیاهو GPU. آن آینده در اینجا است.

🚢 Docker فقط بازی AI Dev را تغییر داد

داکر رسما راه اندازی کرده است Docker Model Runner، و این یک تغییر دهنده بازی برای توسعه دهندگان است که با AI و Learning Machine کار می کنند. اگر تا به حال آرزو کرده اید که مدل های زبان را اجرا کنید ، تعبیه کنید ، یا ساخت برنامه های هوش مصنوعی درست در لپ تاپ خود – بدون ایجاد محیط های پیچیده – Docker پشت شما را دارد.

Docker Model Runner امکان پذیر است استنباط محلی مدل های هوش مصنوعی از طریق CLI تمیز و ساده – نیازی به درایورهای CUDA ، API های پیچیده یا پشته های سنگین ML نیست. این قدرت ظروف را مانند گذشته هرگز به دنیای هوش مصنوعی می آورد.

✅ tl ؛ dr – با آن چه کاری می توانید انجام دهید؟

- مدل های از پیش ساخته مانند را بکشید

llama3باsmollmباdeepseekمستقیماً از Hub Docker - آنها را از طریق محلی اجرا کنید

docker model run - از API سازگار با OpenAi از ظروف یا میزبان

- ساخت برنامه های Genai تمام عیار با آهنگسازی Docker

- همه اینها – در MacBook خود با Apple Silicon ، با پشتیبانی ویندوز به زودی ارائه می شود

🧪 HADE-ON: چگونه کار می کند

رویکرد داکر ساده مرده است – فقط به روشی که ما آن را دوست داریم.

🧰 آخرین دسک تاپ Docker را نصب کنید

اطمینان حاصل کنید که از ساختاری استفاده می کنید که از مدل Runner پشتیبانی می کند.

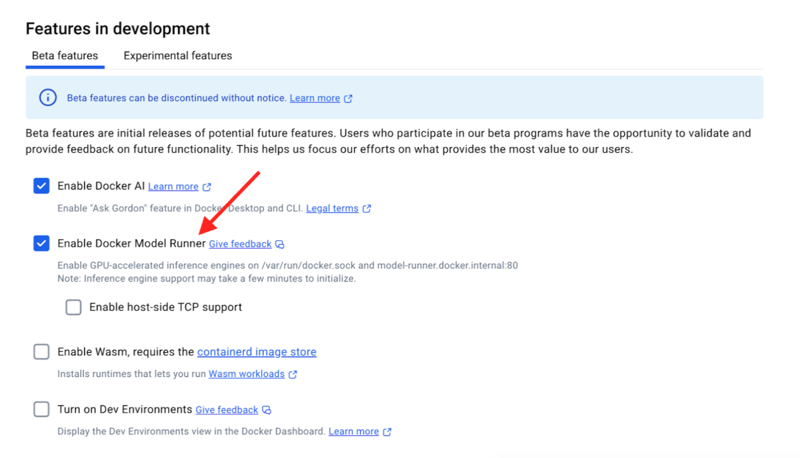

⚙ دونده مدل را فعال کنید

آخرین نسخه Docker Desktop 4.40+ را نصب کنید

حرکت به Docker Desktop → تنظیمات → ویژگی های توسعه → فعال کردن دونده مدل → درخواست و راه اندازی مجدد کنید.

🚀 آن را در 5 مرحله امتحان کنید

docker model status # Check it’s running

docker model list # See available models

docker model pull ai/llama3.2:1B-Q8_0

docker model run ai/llama3.2:1B-Q8_0 "Hello"

#Instantly receive inference results:

#Hello! How can I assist you today?

docker model rm ai/llama3.2:1B-Q8_0

تقریباً جادویی احساس می شود. اولین پاسخ؟ فوری بدون چرخش سرور. نه تأخیر API. فقط جادوی AI محلی خام.

🔌 سازگاری API OpenAi = سعادت ادغام

مدل Runner نقاط پایانی سازگار با OpenAI را در معرض دید قرار می دهد ، به این معنی کد صفر تغییر می کندبشر

از آن استفاده کنید:

- ظروف داخل:

http://ml.docker.internal/ - از میزبان (از طریق سوکت):

--unix-socket ~/.docker/run/docker.sock - از میزبان (از طریق TCP): پروکسی معکوس به بندر 8080

🤖 مدلهای پشتیبانی شده (تا کنون)

در اینجا چند سنگهای قیمتی وجود دارد که امروز می توانید اجرا کنید:

llama3.2:1bsmollm135mmxbai-embed-large-v1deepseek-r1-distill- … و بیشتر ، مدل های از پیش آموزش عمومی بیشتر

💬 دوستانه ، جامعه محور

آنچه این نسخه را واقعاً هیجان انگیز می کند این است که داکر چگونه جامعه کاپیتان ها و آزمایش کنندگان اولیه را درگیر کرد. از انتشار صفر مشتری تا پرتاب نهایی ، بازخورد سوخت پشت لهستانی بود.

🔮 بعدی چیست؟

- ✅ پشتیبانی ویندوز (به زودی)

- it ادغام CI/CD

- ✅ شتاب GPU در به روزرسانی های آینده

- 🧠 مدل های سرپرستی بیشتر در Hub Docker

thoughts افکار نهایی

Docker Model Runner است نه فقط یک ویژگی – این یک تغییر است. این پل بین AI و Devops ، بین استنتاج محلی و ابر است.

دیگر API های دست و پنجه نرم نمی شوند. دیگر سردردهای GPU نیست. فقط تایپ کنید ، بکشید ، اجرا کنید.

هوش مصنوعی ، تجربه Dev را ملاقات کنید. نیرو توسط Docker.

🚀 امروز آن را امتحان کنید