آینده نگری مدل های زبان رونمایی شد: آیا آنها واقعاً از قبل برنامه ریزی می کنند؟

Summarize this content to 400 words in Persian Lang

این خلاصهای از مقالات انگلیسی ساده از یک مقاله تحقیقاتی به نام آیندهنگری مدلهای زبان است: آیا واقعاً از قبل برنامهریزی میکنند؟ اگر این نوع تحلیل ها را دوست دارید، باید به AImodels.fyi بپیوندید یا من را دنبال کنید توییتر.

بررسی اجمالی

این مقاله تحقیقاتی بررسی میکند که آیا مدلهای زبان برای نشانههای آینده هنگام تولید متن برنامهریزی میکنند یا خیر.

روشی را برای اندازه گیری توانایی یک مدل زبان برای برنامه ریزی برای نشانه های آینده پیشنهاد می کند و چندین مدل را با استفاده از این رویکرد ارزیابی می کند.

یافتهها نشان میدهد که مدلهای زبان کنونی قابلیتهای برنامهریزی قوی را نشان نمیدهند و اغلب متن را به صورت نزدیکبینانه تولید میکنند و تنها بر روی نشانهی فوری بعدی تمرکز میکنند.

توضیح انگلیسی ساده

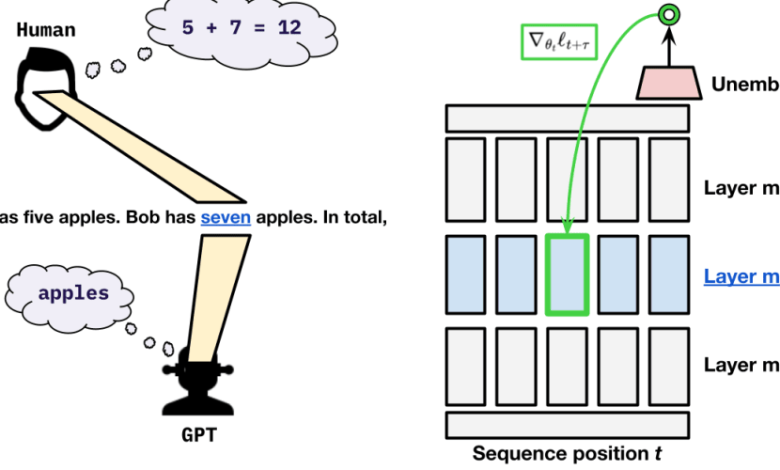

این مقاله تحقیقاتی به بررسی این موضوع میپردازد که آیا مدلهای زبان، که سیستمهای هوش مصنوعی هستند که متنی شبیه انسان تولید میکنند، میتوانند هنگام تولید خروجی خود برنامهریزی کنند یا خیر. وقتی یک مدل زبان جملهای را مینویسد، فقط به کلمه فعلی نگاه نمیکند – بلکه سعی میکند پیشبینی کند که کلمه بعدی بر اساس زمینه چیست. محققان میخواستند بدانند که آیا این مدلها واقعاً چندین قدم جلوتر فکر میکنند یا اینکه عمدتاً بر روی کلمه بعدی فوراً متمرکز شدهاند.

برای آزمایش این موضوع، محققان روشی را برای اندازه گیری قابلیت های برنامه ریزی یک مدل زبان ایجاد کردند. آنها بررسی کردند که مدل ها چقدر می توانند نشانه ها (کلمات) آینده را در متنی که تولید می کنند پیش بینی کنند. ایده این است که مدلهایی که تواناییهای برنامهریزی قویتری دارند، بهتر میتوانند نه تنها کلمه بعدی، بلکه کلمات پایینتر را پیشبینی کنند.

محققان چندین مدل زبان رایج را با استفاده از این معیار برنامه ریزی ارزیابی کردند. یافتههای آنها نشان میدهد که مدلهای زبان کنونی قابلیتهای برنامهریزی قوی را نشان نمیدهند – مدلها عمدتاً بر پیشبینی نشانه فوری بعدی تمرکز دارند، بدون در نظر گرفتن زمینه طولانیمدت. به عبارت دیگر، مدلها در تولید متن خود تا حدودی نزدیکبین هستند و آینده را کاملاً در نظر نمیگیرند.

این تحقیق بینش های مهمی در مورد محدودیت های مدل های زبان مدرن ارائه می دهد. در حالی که این سیستمها میتوانند متن روان و منسجمی تولید کنند، ممکن است فاقد آیندهنگری و تفکر استراتژیک باشند که انسانها اغلب هنگام برقراری ارتباط از خود نشان میدهند. درک این کاستیها میتواند به هدایت تلاشهای آینده برای توسعه هوش مصنوعی زبانی پیچیدهتر و متفکرانهتر کمک کند.

توضیح فنی

این مقاله روشی را برای تعیین کمیت توانایی یک مدل زبان برای برنامهریزی برای نشانههای آینده در طول تولید متن پیشنهاد میکند. ایده کلیدی این است که اندازه گیری شود که چگونه یک مدل می تواند نه تنها توکن بعدی، بلکه چندین گام جلوتر در توکن را پیش بینی کند.

به طور خاص، نویسندگان یک کار “فرا پیش بینی نشانه آینده” را معرفی می کنند. با توجه به یک توالی نیمه تولید شده، مدل باید توزیع را در مورد بعدی پیش بینی کند ک توکن ها سپس محققان ارزیابی می کنند که چگونه پیش بینی های مدل با نشانه های واقعی که در دنباله تکمیل شده ظاهر می شوند مطابقت دارد.

این قابلیت فراپیشبینی بهعنوان پروکسی برای توانایی برنامهریزی مدل استفاده میشود – مدلهایی که میتوانند به طور دقیق نشانههای آینده را پیشبینی کنند، احتمالاً به جای تمرکز بر مرحله فوری بعدی، زمینه بلندمدت را هنگام تولید متن در نظر میگیرند.

نویسندگان چندین مدل زبان محبوب از جمله GPT-2، GPT-3 و T5 را آزمایش کردند. آنها دریافتند که در حالی که این مدلها در معیارهای مدلسازی زبان استاندارد به خوبی عمل میکنند، اما تواناییهای برنامهریزی محدودی را که توسط کار فراپیشبینی توکن آینده اندازهگیری میشود، نشان میدهند. مدلها تمایل دارند پیشبینیهای نزدیکبین انجام دهند و عمدتاً به جای در نظر گرفتن توالی طولانیمدت، روی نشانه بعدی تمرکز میکنند.

این نتایج نشان میدهد که مدلهای زبان فعلی، علیرغم قابلیتهای تولید متن چشمگیرشان، ممکن است فاقد آیندهنگری و استدلال استراتژیک نشاندادهشده توسط انسان در طول ارتباط باشند. توسعه مدلهایی با تواناییهای برنامهریزی قویتر یک جهت مهم برای تحقیقات آینده در زبان هوش مصنوعی است.

تحلیل انتقادی

این مقاله یک رویکرد جدید و متفکرانه برای ارزیابی قابلیت های برنامه ریزی مدل های زبان ارائه می دهد. کار فراپیشبینی نشانههای آینده یک راه مشخص برای تعیین کمیت توانایی یک مدل برای در نظر گرفتن زمینه بلندمدت ارائه میدهد، که یک جنبه مهم از ارتباطات انسانمانند است که توجه نسبتا کمی به آنها شده است.

با این حال، نویسندگان چندین محدودیت را برای کار خود اذعان می کنند. وظیفه ای که آنها پیشنهاد می کنند تا حدودی مصنوعی است و ممکن است به طور کامل تفاوت های ظریف را در مورد نحوه برنامه ریزی انسان برای استفاده از زبان خود در نظر نگیرد. علاوه بر این، این مطالعه بر روی مجموعه خاصی از مدلهای زبان متمرکز است و مشخص نیست که این یافتهها تا چه حد قابل تعمیم به سایر معماریها یا رویکردهای آموزشی هستند.

سوال مهمی که مقاله به آن نمی پردازد این است که تا چه حد توانایی های برنامه ریزی حتی برای موفقیت مدل های زبان در کارهای دنیای واقعی ضروری است. در حالی که توانایی در نظر گرفتن زمینه بلندمدت ممکن است برای کاربردهای خاص مطلوب باشد، ممکن است پیشبینی نزدیکبینانه و سطح نشانه برای بسیاری از موارد استفاده عملی کافی باشد.

تحقیقات بیشتری برای درک بهتر رابطه بین برنامه ریزی، استدلال و تولید زبان در سیستم های هوش مصنوعی مورد نیاز است. بررسی چارچوبهای ارزیابی جایگزین، و همچنین ارتباط بین تواناییهای برنامهریزی و عملکرد پاییندستی، میتواند بینشهای ارزشمندی برای توسعه مدلهای زبانی پیچیدهتر و شبیه انسان به دست دهد.

نتیجه

این مقاله تحقیقاتی با معرفی روشی جدید برای ارزیابی قابلیتهای برنامهریزی مدلهای زبان کمک مهمی میکند. یافتهها نشان میدهد که مدلهای پیشرفته کنونی، در حالی که در تواناییهای تولید متن خود چشمگیر هستند، اغلب فاقد آیندهنگری و تفکر استراتژیک هستند که توسط انسان در طول ارتباط نشان داده میشود.

درک محدودیتهای مدلهای زبان در این زمینه، گامی حیاتی به سمت توسعه سیستمهای هوش مصنوعی است که میتوانند در استفاده متفکرانهتر و آگاهانهتر از زبان مشارکت کنند. بینشهای حاصل از این کار میتواند به هدایت تلاشهای تحقیقاتی آینده با هدف ایجاد مدلهای زبانی با تواناییهای برنامهریزی قویتر کمک کند، که به طور بالقوه منجر به تعاملات طبیعی و مؤثر انسان و هوش مصنوعی میشود.

اگر از این خلاصه لذت بردید، به AImodels.fyi بپیوندید یا من را دنبال کنید توییتر برای محتوای بیشتر هوش مصنوعی و یادگیری ماشین.

این خلاصهای از مقالات انگلیسی ساده از یک مقاله تحقیقاتی به نام آیندهنگری مدلهای زبان است: آیا واقعاً از قبل برنامهریزی میکنند؟ اگر این نوع تحلیل ها را دوست دارید، باید به AImodels.fyi بپیوندید یا من را دنبال کنید توییتر.

بررسی اجمالی

- این مقاله تحقیقاتی بررسی میکند که آیا مدلهای زبان برای نشانههای آینده هنگام تولید متن برنامهریزی میکنند یا خیر.

- روشی را برای اندازه گیری توانایی یک مدل زبان برای برنامه ریزی برای نشانه های آینده پیشنهاد می کند و چندین مدل را با استفاده از این رویکرد ارزیابی می کند.

- یافتهها نشان میدهد که مدلهای زبان کنونی قابلیتهای برنامهریزی قوی را نشان نمیدهند و اغلب متن را به صورت نزدیکبینانه تولید میکنند و تنها بر روی نشانهی فوری بعدی تمرکز میکنند.

توضیح انگلیسی ساده

این مقاله تحقیقاتی به بررسی این موضوع میپردازد که آیا مدلهای زبان، که سیستمهای هوش مصنوعی هستند که متنی شبیه انسان تولید میکنند، میتوانند هنگام تولید خروجی خود برنامهریزی کنند یا خیر. وقتی یک مدل زبان جملهای را مینویسد، فقط به کلمه فعلی نگاه نمیکند – بلکه سعی میکند پیشبینی کند که کلمه بعدی بر اساس زمینه چیست. محققان میخواستند بدانند که آیا این مدلها واقعاً چندین قدم جلوتر فکر میکنند یا اینکه عمدتاً بر روی کلمه بعدی فوراً متمرکز شدهاند.

برای آزمایش این موضوع، محققان روشی را برای اندازه گیری قابلیت های برنامه ریزی یک مدل زبان ایجاد کردند. آنها بررسی کردند که مدل ها چقدر می توانند نشانه ها (کلمات) آینده را در متنی که تولید می کنند پیش بینی کنند. ایده این است که مدلهایی که تواناییهای برنامهریزی قویتری دارند، بهتر میتوانند نه تنها کلمه بعدی، بلکه کلمات پایینتر را پیشبینی کنند.

محققان چندین مدل زبان رایج را با استفاده از این معیار برنامه ریزی ارزیابی کردند. یافتههای آنها نشان میدهد که مدلهای زبان کنونی قابلیتهای برنامهریزی قوی را نشان نمیدهند – مدلها عمدتاً بر پیشبینی نشانه فوری بعدی تمرکز دارند، بدون در نظر گرفتن زمینه طولانیمدت. به عبارت دیگر، مدلها در تولید متن خود تا حدودی نزدیکبین هستند و آینده را کاملاً در نظر نمیگیرند.

این تحقیق بینش های مهمی در مورد محدودیت های مدل های زبان مدرن ارائه می دهد. در حالی که این سیستمها میتوانند متن روان و منسجمی تولید کنند، ممکن است فاقد آیندهنگری و تفکر استراتژیک باشند که انسانها اغلب هنگام برقراری ارتباط از خود نشان میدهند. درک این کاستیها میتواند به هدایت تلاشهای آینده برای توسعه هوش مصنوعی زبانی پیچیدهتر و متفکرانهتر کمک کند.

توضیح فنی

این مقاله روشی را برای تعیین کمیت توانایی یک مدل زبان برای برنامهریزی برای نشانههای آینده در طول تولید متن پیشنهاد میکند. ایده کلیدی این است که اندازه گیری شود که چگونه یک مدل می تواند نه تنها توکن بعدی، بلکه چندین گام جلوتر در توکن را پیش بینی کند.

به طور خاص، نویسندگان یک کار “فرا پیش بینی نشانه آینده” را معرفی می کنند. با توجه به یک توالی نیمه تولید شده، مدل باید توزیع را در مورد بعدی پیش بینی کند ک توکن ها سپس محققان ارزیابی می کنند که چگونه پیش بینی های مدل با نشانه های واقعی که در دنباله تکمیل شده ظاهر می شوند مطابقت دارد.

این قابلیت فراپیشبینی بهعنوان پروکسی برای توانایی برنامهریزی مدل استفاده میشود – مدلهایی که میتوانند به طور دقیق نشانههای آینده را پیشبینی کنند، احتمالاً به جای تمرکز بر مرحله فوری بعدی، زمینه بلندمدت را هنگام تولید متن در نظر میگیرند.

نویسندگان چندین مدل زبان محبوب از جمله GPT-2، GPT-3 و T5 را آزمایش کردند. آنها دریافتند که در حالی که این مدلها در معیارهای مدلسازی زبان استاندارد به خوبی عمل میکنند، اما تواناییهای برنامهریزی محدودی را که توسط کار فراپیشبینی توکن آینده اندازهگیری میشود، نشان میدهند. مدلها تمایل دارند پیشبینیهای نزدیکبین انجام دهند و عمدتاً به جای در نظر گرفتن توالی طولانیمدت، روی نشانه بعدی تمرکز میکنند.

این نتایج نشان میدهد که مدلهای زبان فعلی، علیرغم قابلیتهای تولید متن چشمگیرشان، ممکن است فاقد آیندهنگری و استدلال استراتژیک نشاندادهشده توسط انسان در طول ارتباط باشند. توسعه مدلهایی با تواناییهای برنامهریزی قویتر یک جهت مهم برای تحقیقات آینده در زبان هوش مصنوعی است.

تحلیل انتقادی

این مقاله یک رویکرد جدید و متفکرانه برای ارزیابی قابلیت های برنامه ریزی مدل های زبان ارائه می دهد. کار فراپیشبینی نشانههای آینده یک راه مشخص برای تعیین کمیت توانایی یک مدل برای در نظر گرفتن زمینه بلندمدت ارائه میدهد، که یک جنبه مهم از ارتباطات انسانمانند است که توجه نسبتا کمی به آنها شده است.

با این حال، نویسندگان چندین محدودیت را برای کار خود اذعان می کنند. وظیفه ای که آنها پیشنهاد می کنند تا حدودی مصنوعی است و ممکن است به طور کامل تفاوت های ظریف را در مورد نحوه برنامه ریزی انسان برای استفاده از زبان خود در نظر نگیرد. علاوه بر این، این مطالعه بر روی مجموعه خاصی از مدلهای زبان متمرکز است و مشخص نیست که این یافتهها تا چه حد قابل تعمیم به سایر معماریها یا رویکردهای آموزشی هستند.

سوال مهمی که مقاله به آن نمی پردازد این است که تا چه حد توانایی های برنامه ریزی حتی برای موفقیت مدل های زبان در کارهای دنیای واقعی ضروری است. در حالی که توانایی در نظر گرفتن زمینه بلندمدت ممکن است برای کاربردهای خاص مطلوب باشد، ممکن است پیشبینی نزدیکبینانه و سطح نشانه برای بسیاری از موارد استفاده عملی کافی باشد.

تحقیقات بیشتری برای درک بهتر رابطه بین برنامه ریزی، استدلال و تولید زبان در سیستم های هوش مصنوعی مورد نیاز است. بررسی چارچوبهای ارزیابی جایگزین، و همچنین ارتباط بین تواناییهای برنامهریزی و عملکرد پاییندستی، میتواند بینشهای ارزشمندی برای توسعه مدلهای زبانی پیچیدهتر و شبیه انسان به دست دهد.

نتیجه

این مقاله تحقیقاتی با معرفی روشی جدید برای ارزیابی قابلیتهای برنامهریزی مدلهای زبان کمک مهمی میکند. یافتهها نشان میدهد که مدلهای پیشرفته کنونی، در حالی که در تواناییهای تولید متن خود چشمگیر هستند، اغلب فاقد آیندهنگری و تفکر استراتژیک هستند که توسط انسان در طول ارتباط نشان داده میشود.

درک محدودیتهای مدلهای زبان در این زمینه، گامی حیاتی به سمت توسعه سیستمهای هوش مصنوعی است که میتوانند در استفاده متفکرانهتر و آگاهانهتر از زبان مشارکت کنند. بینشهای حاصل از این کار میتواند به هدایت تلاشهای تحقیقاتی آینده با هدف ایجاد مدلهای زبانی با تواناییهای برنامهریزی قویتر کمک کند، که به طور بالقوه منجر به تعاملات طبیعی و مؤثر انسان و هوش مصنوعی میشود.

اگر از این خلاصه لذت بردید، به AImodels.fyi بپیوندید یا من را دنبال کنید توییتر برای محتوای بیشتر هوش مصنوعی و یادگیری ماشین.