بهترین بازیکنان Thunderstruck در EA Sports FC 25

Summarize this content to 400 words in Persian Lang

Thunderstruck یکی از بهترین تبلیغات در EA Sports FC 25 است که کارتهای زنده را برای جمعآوری و لذت بردن در انتظار امکان ارتقاء بیشتر ارائه میدهد. جدا از پیشرفتهای ظاهری آشکار، این کارتها میتوانند بر اساس نحوه عملکرد تیم مرتبط با آنها در بازیهای واقعی، ارتقاهای بیشتری دریافت کنند.

مرتبط

EA Sports FC 25 – How To Complete The Thunderstruck Kim Min Jae Challenge

Kim Min Jae با رتبه 86 زنده به دست آورید که می تواند بیشتر ارتقا یابد.

در حالی که این کارتها قبل از دریافت هر گونه ارتقاء آینده، بر اساس تواناییهایشان رتبهبندی میشوند، بازیکنان بدون توجه به پیشرفتهای بیشتر، احتمالاً در بین بهترینها باقی خواهند ماند. در حالی که فضای اضافی برای رشد امتیازی است که داشتن این کارتها را سرگرمکننده میکند، اما به اندازه کافی تغییر نمیکنند تا قابلیت استفاده از آنها را کاهش دهند.

کارتهای Thunderstruck بر اساس عملکرد تیم خود، ارتقاهای زیر را دریافت خواهند کرد پنج بعدی (شروع از 29 نوامبر 2024) لیگ داخلی مسابقات:

– اگر تیم آنها دو برنده می شود بازی ها: دو جدید PlayStyles & جدید نقش +

– اگر تیم آنها شش گل می زند یا بیشتر: به علاوه یک رتبه بندی کلی و جدید نقش +

8

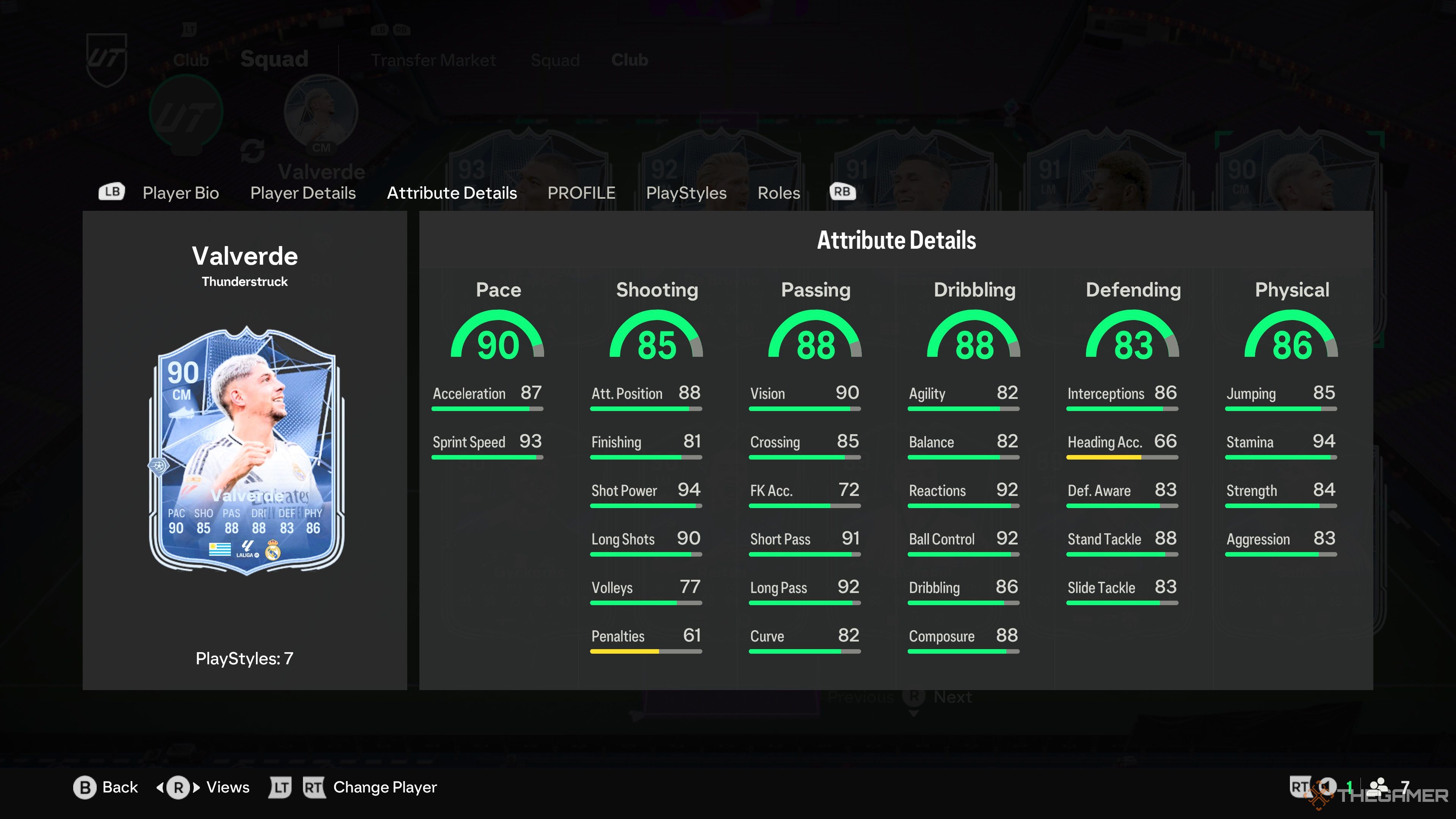

فدریکو والورده – رئال مادرید

پا ضعیف

حرکات مهارتی

چهار ستاره

چهار ستاره

فده والورده افتخار کرده است یکی از بهترین کارت های هافبک در سال های اخیر، با این نسخه Thunderstruck به عنوان یکی از بهترین کارتهای پیش تیم سال که تا به حال دیدهایم. ستاره رئال مادرید قیمت بسیار بالایی نیز دارد، اما با دسترسی به PowerShot PlayStyle Plus، جای تعجب ندارد.

پیوندهای رئال مادرید و انعطاف پذیری والورده برای تغییر از CM به CDM یا RM او را به یک کارت ضروری تبدیل می کند اگر بتوانید قیمت او را بپردازید و قصد دارید در بخش های آنلاین بالاتر رقابت کنید.

7

کوین دی بروین – منچسترسیتی

پا ضعیف

حرکات مهارتی

پنج ستاره

چهار ستاره

در حالی که او در زندگی واقعی با یک آسیب آزاردهنده محدود شده است، کارت Thunderstruck کوین دی بروین هنوز به عنوان یکی از کارت های برتر تبلیغاتی برجسته است. Incisive Pass Plus یکی از بهترین پلی استایل های EA FC 25 است. به بازیکنانی مانند KDB اجازه می دهد تا پاس های واضح را با دقت چشمگیر به هم تیمی های خود ارسال کنند.

مشکلات اصلی دی بروین سرعت و قیمت او است، زیرا او سریع یا چابک نیست، اما همچنان می تواند به خوبی دریبل کند و از طریق دفاع در دست راست قطع کنید.

6

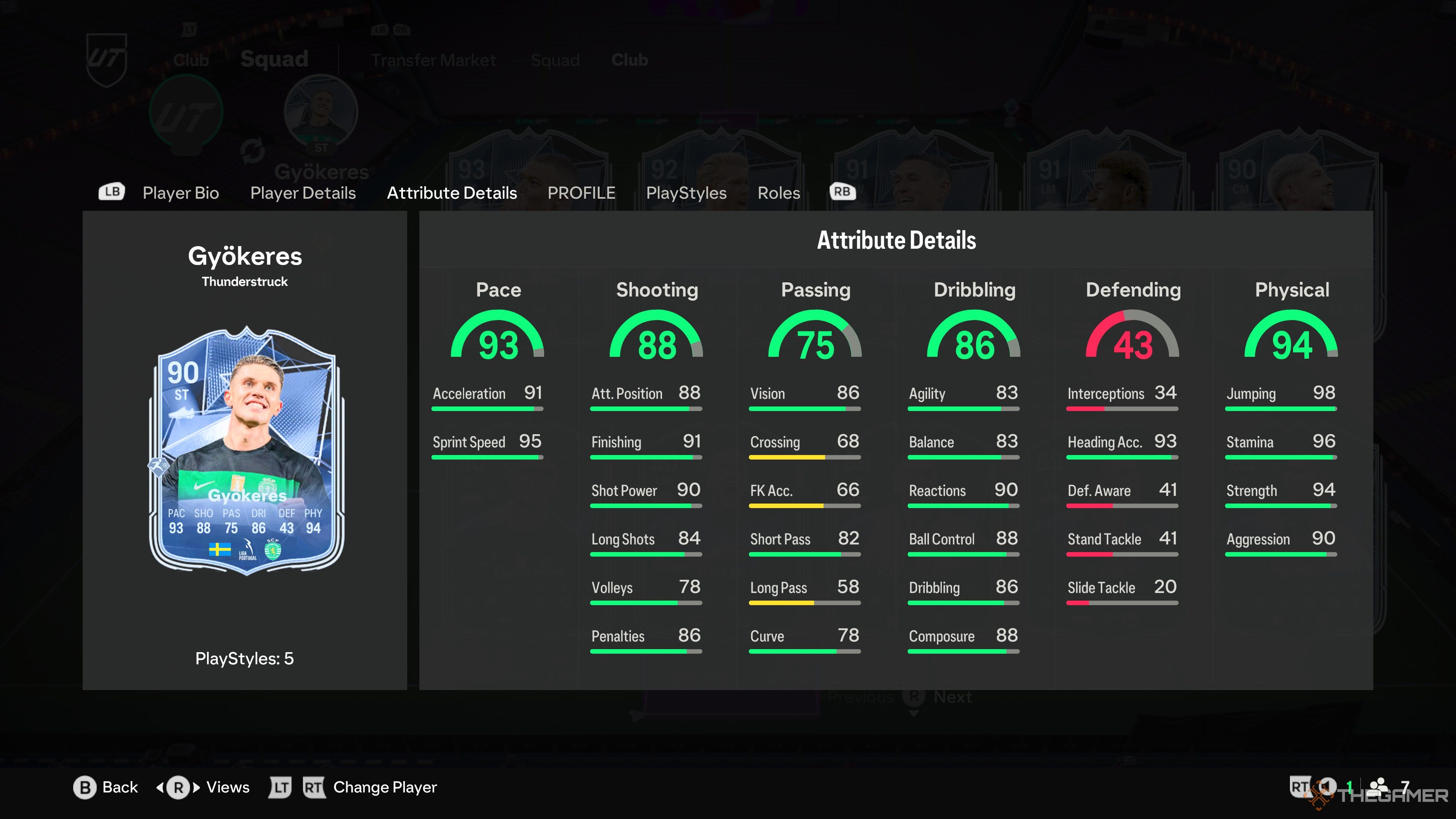

ویکتور گیوکرس – اسپورتینگ سی پی

پا ضعیف

حرکات مهارتی

پنج ستاره

چهار ستاره

ویکتور گیوکرس یکی از بهترین مهاجمانی است که می توانید در EA FC 25 دریافت کنید، با ترکیبی تقریبا باورنکردنی از سرعت و فیزیکی که او را به یکی از سخت ترین بازیکنان برای دفاع تبدیل می کند.

تیراندازی 88 او آخرین بخش از ویژگی های سه گانه مرگبار گیوکرس است که کارت او را زیبا می کند.

مرتبط

EA Sports FC 25: 7 بهترین تیم از انگلستان برای مدیریت در حالت شغلی

با مدیریت این تیم های انگلیس تجربه خوبی کسب کنید.

در حالی که Gyokeres بسیار مقرون به صرفه تر از KDB یا فده والورده است، به قیمت داشتن یکی از سخت ترین لینک ها برای کار در FC 25 است. بازیکنان سوئدی بسیار اندک هستند، در حالی که شما برای گنجاندن بسیاری از لیگ پرتغال با مشکل مواجه خواهید شد. بازیکنان در کنار مهاجم خود صف آرایی کنید.

5

ژول کونده – اف سی بارسلونا

پا ضعیف

حرکات مهارتی

چهار ستاره

سه ستاره

کارت پایه ژول کونده یکی از بهترین گزینه ها در دفاع راست در مراحل اولیه FC 25 بود و این مدافع کناری بارسلونا با یک پیشرفت چشمگیر دیگر بازمی گردد. او را بار دیگر متا مرتبط می کند.

خوشبختانه، لینک های کونده مایل ها بهتر از Gyokeres هستند، زیرا بازیکنان فرانسوی دارای برخی از گزینه های فراوان با کیفیت بالا هستند. Jockey یک PlayStyle Plus عالی برای دفاع راست است، زیرا شما قادر خواهید بود بازیکنان هجومی را به سمت پایین هدایت کنید بدون اینکه توانایی آن را از دست بدهید. در یک لحظه جهت را با آنها تغییر دهید.

4

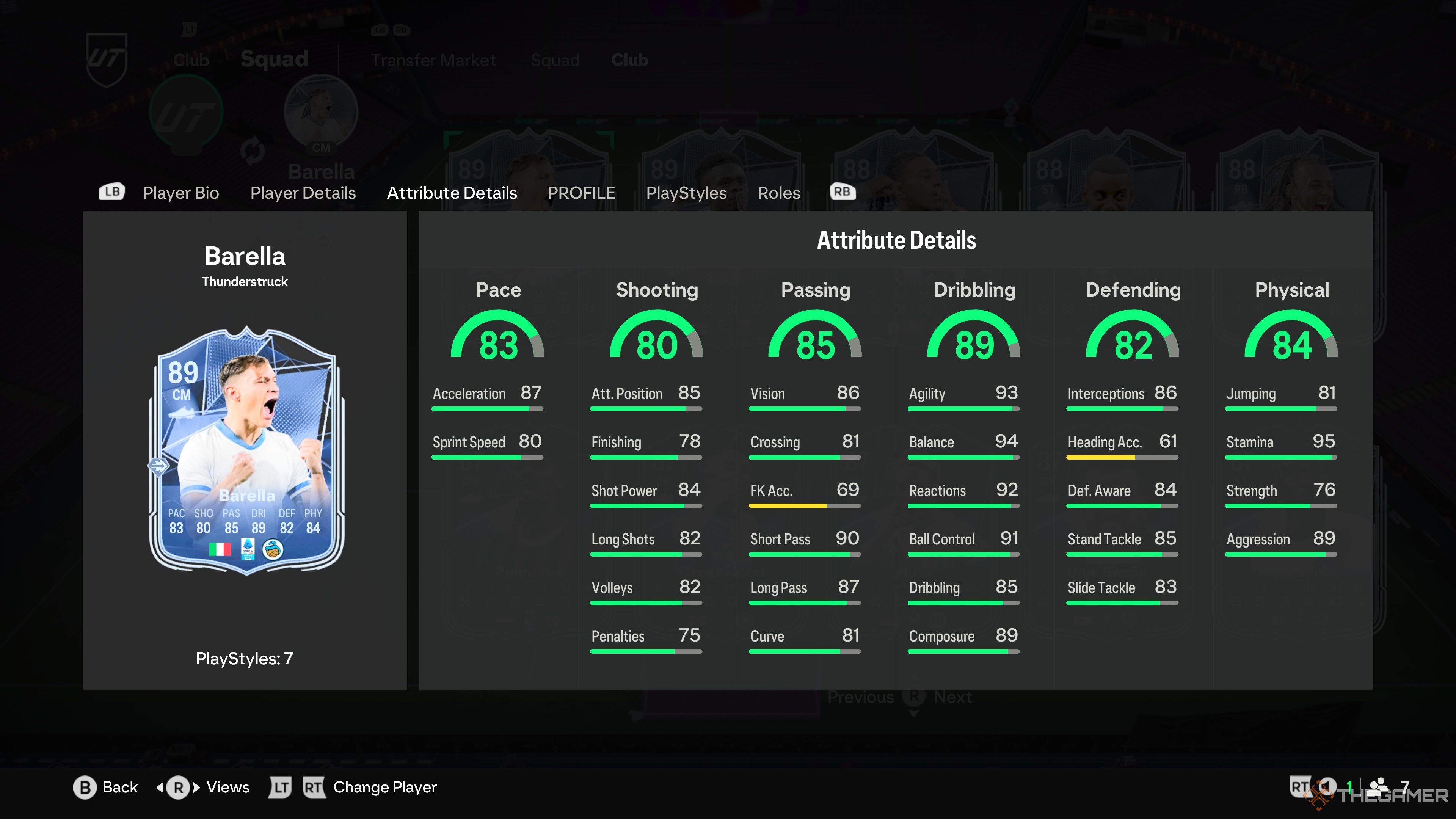

نیکولو بارلا – لومباردیا اف سی

پا ضعیف

حرکات مهارتی

چهار ستاره

چهار ستاره

در حالی که نیکولو بارلا پر زرق و برق ترین بازیکن یا بزرگترین نام در این لیست نیست، کارت Thunderstruck او بالاتر از گزینه های مشابه بر اساس دسترسی، ارزش و کیفیت کلی. ویژگیهای بارلا از صفحه خارج نمیشود، اما او به طور مداوم با حرکات و دریبلهای چشمگیر خود در بازی، از جمله ویژگیهای دیگر، بیش از حد عمل میکند.

او با جثه کوچک خود ترسی به حریفان شما وارد نمی کند، اما حضور بسیار زیاد بارلا در خط میانی او را به یکی از قابل توجه ترین بازیکنان زمین تبدیل می کند.

3

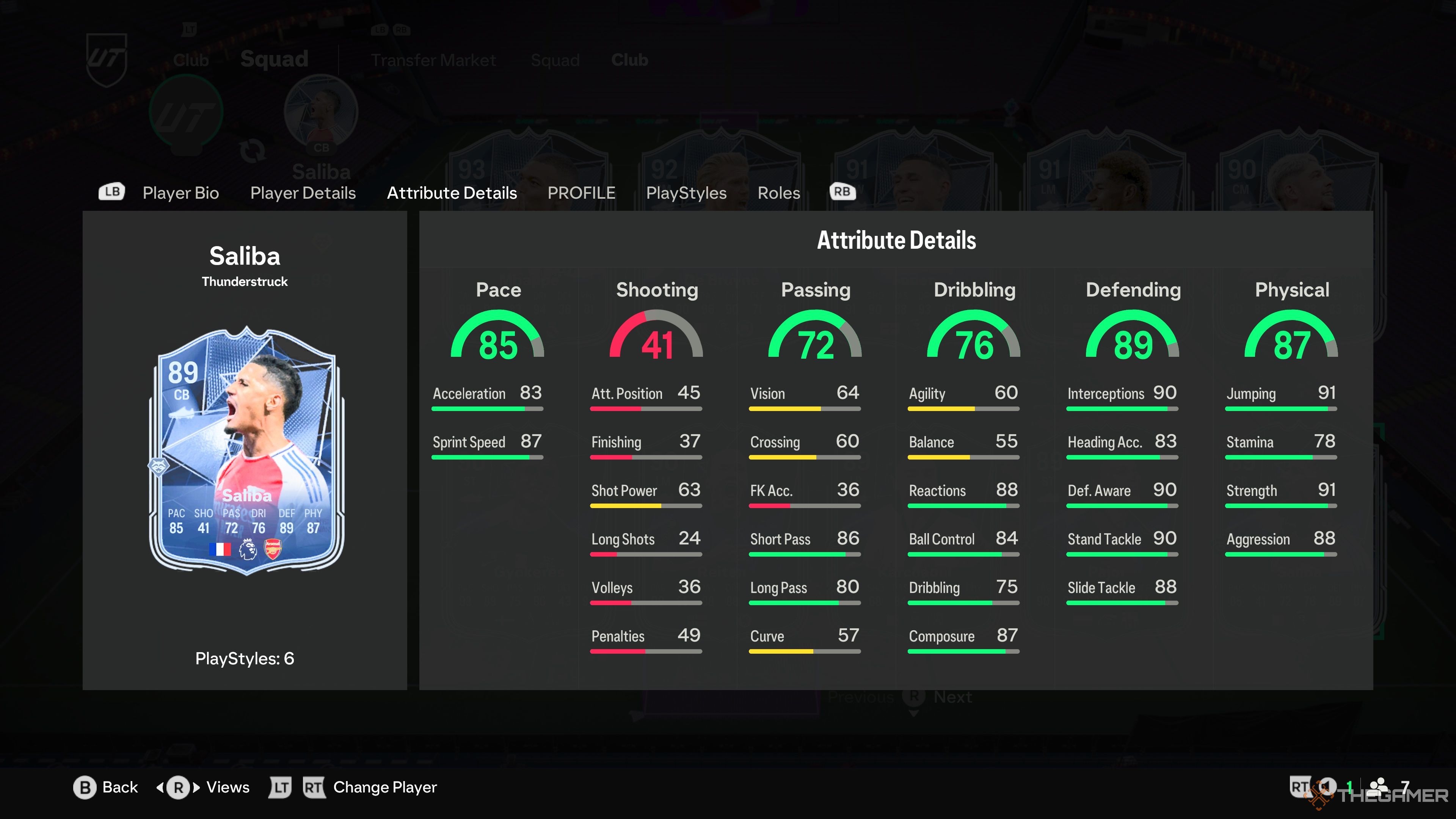

ویلیام سالیبا – آرسنال

پا ضعیف

حرکات مهارتی

سه ستاره

دو ستاره

ویلیام سالیبا یکی از بهترین مدافعان تیم Ultimate است، و این ارتقای عظیمی که او از کارت پایه خود دریافت می کند، با توجه به اینکه نسخه طلایی هنوز چقدر خوب است، حتی بزرگتر به نظر می رسد. دسترسی صلیبا به PlayStyle Plus را پیش بینی کنید او را به یکی از بهترین گزینه ها برای این موقعیت تبدیل می کند.

مرتبط

EA Sports FC 25: 8 بهترین پشتیبان مرکزی زیر 1 میلیون یورو برای ورود به حالت حرفه ای

این مدافعان میانی ارزش پولی را دارند که میپردازید، زیرا همه آنها زیر 1 میلیون یورو قابل خرید هستند.

در حالی که قیمت Saliba او را به اندازه KDB و Fede محدود می کند، اگر سکه هایی برای سرمایه گذاری در این کارت دارید، نباید ماه ها CB خود را تغییر دهید. در حالی که کارتهای دارای دو PlayStyle مطمئناً منحنی قدرت را تغییر میدهند، سالیبا یکی از معدود بازیکنانی است که احتمالاً از این تغییر جان سالم به در میبرد.

2

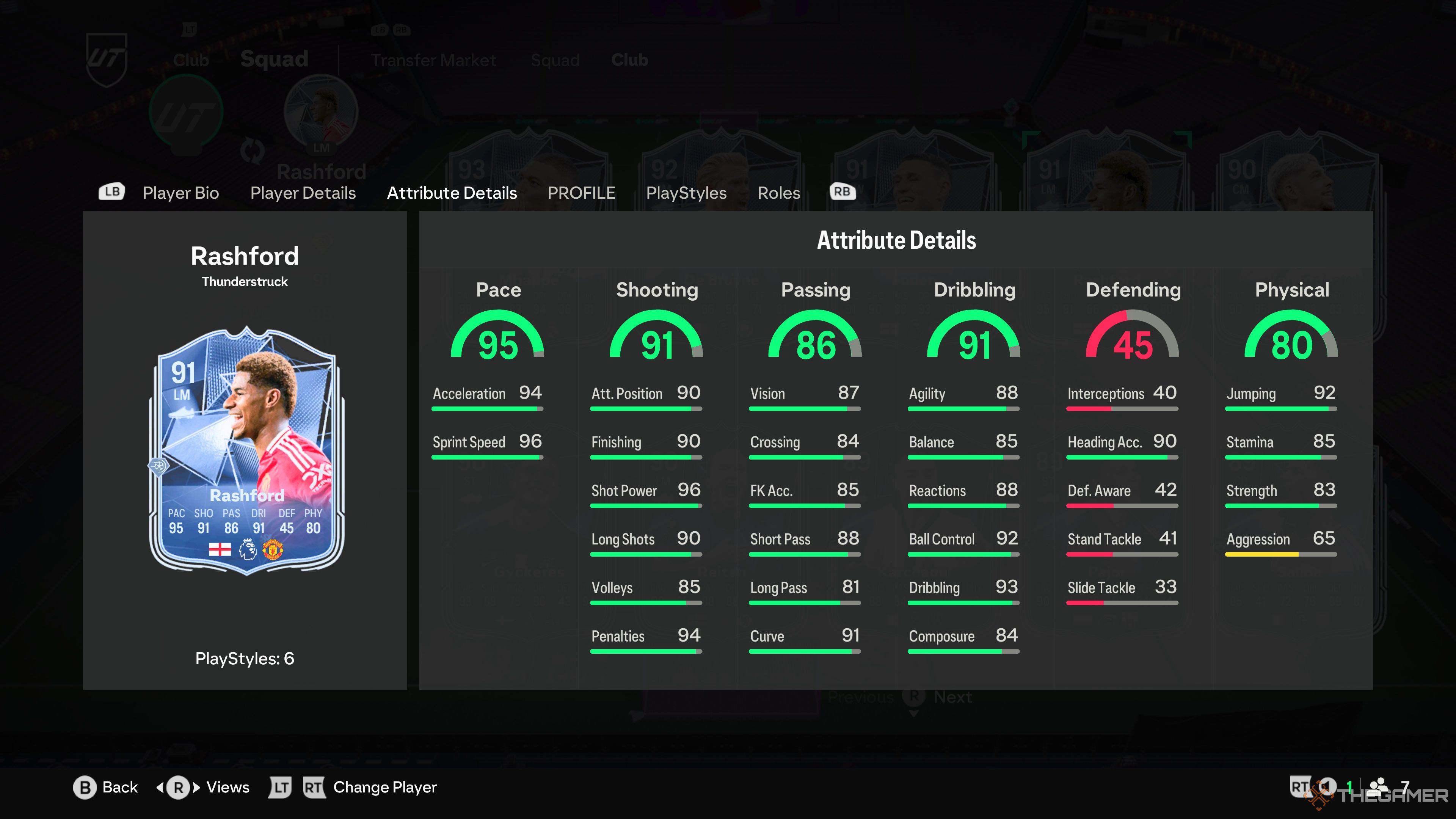

مارکوس راشفورد – منچستریونایتد

پا ضعیف

حرکات مهارتی

چهار ستاره

پنج ستاره

اگر فکر میکردید که برخی از بهترین بازیکنان Thunderstruck تا به حال هزینه زیادی ندارند، پس خود را برای یک برچسب قیمت بزرگ از مارکوس راشفورد آماده کنید، همانطور که این کارت دارد. برخی از مطلوب ترین ویژگی ها می توانید امیدوار باشید در یک بازیکن هجومی

کار کردن با پیوندهای رشفورد و دسترسی او به آن بسیار آسان است پاور شات پلاس او را به یکی از کشندهترین مهاجمان FC 25 تبدیل میکند. با سرعت، شوت و دریبل بیش از 91، رشفورد هیچ نقطه ضعف عمدهای برای صحبت ندارد، مگر اینکه یک پای ضعیف ناقص را تنها عیب در نظر بگیرید.

1

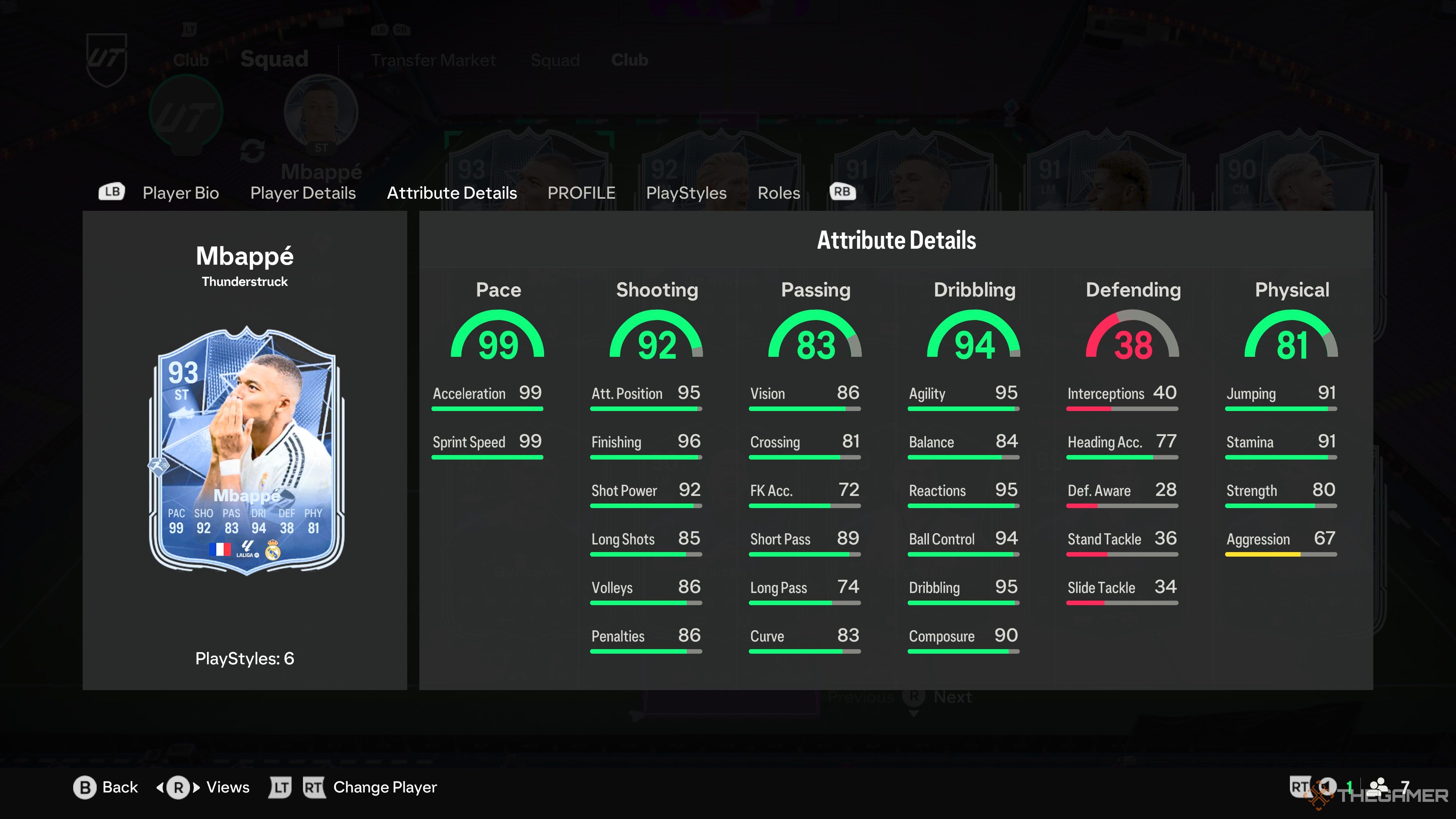

کیلیان امباپه – رئال مادرید

پا ضعیف

حرکات مهارتی

چهار ستاره

پنج ستاره

وقتی امباپه کارت تبلیغاتی جدیدی دریافت میکند، احساس تقلب میکند، زیرا او قبلاً در بین بهترین دریبلزنان FC 25 بود، نه اینکه از جهات دیگر به یک مهاجم تقریباً عالی اشاره کنیم. سرعت فوقالعاده امباپه، و ترکیب مرگبار شوت، دریبل و پاس مناسب، او را به یک تهدید تبدیل میکند.

جدای از ویژگیهایش، امباپه با ویژگیهای معروف «جمی» خود همراه است، جایی که به نظر میرسد ریباندها و انحرافات به شکلی جادویی به پای او ختم میشوند، زیرا او با سرعت خود از میان مدافعان عبور میکند. او را امتحان کنید، خواهید دید که تمام صحبت ها در مورد “اورا” و “مربا” چیزی بیش از وافل است.

حق امتیاز

EA Sports FC

منتشر شد

27 سپتامبر 2024

توسعه دهندگان

EA کانادا، EA رومانی

ناشر(های)

EA Sports

چند نفره

چند نفره آنلاین، چند نفره محلی، همکاری آنلاین، همکاری محلی

موتور

سرمازدگی

ESRB

همه // مرجع الکل و تنباکو، تعامل کاربران، خریدهای درون بازی (شامل موارد تصادفی)

رتبه بندی OpenCritic

قوی

گسترش دهید

Thunderstruck یکی از بهترین تبلیغات در EA Sports FC 25 است که کارتهای زنده را برای جمعآوری و لذت بردن در انتظار امکان ارتقاء بیشتر ارائه میدهد. جدا از پیشرفتهای ظاهری آشکار، این کارتها میتوانند بر اساس نحوه عملکرد تیم مرتبط با آنها در بازیهای واقعی، ارتقاهای بیشتری دریافت کنند.

مرتبط

در حالی که این کارتها قبل از دریافت هر گونه ارتقاء آینده، بر اساس تواناییهایشان رتبهبندی میشوند، بازیکنان بدون توجه به پیشرفتهای بیشتر، احتمالاً در بین بهترینها باقی خواهند ماند. در حالی که فضای اضافی برای رشد امتیازی است که داشتن این کارتها را سرگرمکننده میکند، اما به اندازه کافی تغییر نمیکنند تا قابلیت استفاده از آنها را کاهش دهند.

کارتهای Thunderstruck بر اساس عملکرد تیم خود، ارتقاهای زیر را دریافت خواهند کرد پنج بعدی (شروع از 29 نوامبر 2024) لیگ داخلی مسابقات:

– اگر تیم آنها دو برنده می شود بازی ها: دو جدید PlayStyles & جدید نقش +

– اگر تیم آنها شش گل می زند یا بیشتر: به علاوه یک رتبه بندی کلی و جدید نقش +

8

فدریکو والورده – رئال مادرید

|

پا ضعیف |

حرکات مهارتی |

|---|---|

|

چهار ستاره |

چهار ستاره |

فده والورده افتخار کرده است یکی از بهترین کارت های هافبک در سال های اخیر، با این نسخه Thunderstruck به عنوان یکی از بهترین کارتهای پیش تیم سال که تا به حال دیدهایم. ستاره رئال مادرید قیمت بسیار بالایی نیز دارد، اما با دسترسی به PowerShot PlayStyle Plus، جای تعجب ندارد.

پیوندهای رئال مادرید و انعطاف پذیری والورده برای تغییر از CM به CDM یا RM او را به یک کارت ضروری تبدیل می کند اگر بتوانید قیمت او را بپردازید و قصد دارید در بخش های آنلاین بالاتر رقابت کنید.

7

کوین دی بروین – منچسترسیتی

|

پا ضعیف |

حرکات مهارتی |

|---|---|

|

پنج ستاره |

چهار ستاره |

در حالی که او در زندگی واقعی با یک آسیب آزاردهنده محدود شده است، کارت Thunderstruck کوین دی بروین هنوز به عنوان یکی از کارت های برتر تبلیغاتی برجسته است. Incisive Pass Plus یکی از بهترین پلی استایل های EA FC 25 است. به بازیکنانی مانند KDB اجازه می دهد تا پاس های واضح را با دقت چشمگیر به هم تیمی های خود ارسال کنند.

مشکلات اصلی دی بروین سرعت و قیمت او است، زیرا او سریع یا چابک نیست، اما همچنان می تواند به خوبی دریبل کند و از طریق دفاع در دست راست قطع کنید.

6

ویکتور گیوکرس – اسپورتینگ سی پی

|

پا ضعیف |

حرکات مهارتی |

|---|---|

|

پنج ستاره |

چهار ستاره |

ویکتور گیوکرس یکی از بهترین مهاجمانی است که می توانید در EA FC 25 دریافت کنید، با ترکیبی تقریبا باورنکردنی از سرعت و فیزیکی که او را به یکی از سخت ترین بازیکنان برای دفاع تبدیل می کند.

تیراندازی 88 او آخرین بخش از ویژگی های سه گانه مرگبار گیوکرس است که کارت او را زیبا می کند.

مرتبط

EA Sports FC 25: 7 بهترین تیم از انگلستان برای مدیریت در حالت شغلی

با مدیریت این تیم های انگلیس تجربه خوبی کسب کنید.

در حالی که Gyokeres بسیار مقرون به صرفه تر از KDB یا فده والورده است، به قیمت داشتن یکی از سخت ترین لینک ها برای کار در FC 25 است. بازیکنان سوئدی بسیار اندک هستند، در حالی که شما برای گنجاندن بسیاری از لیگ پرتغال با مشکل مواجه خواهید شد. بازیکنان در کنار مهاجم خود صف آرایی کنید.

5

ژول کونده – اف سی بارسلونا

|

پا ضعیف |

حرکات مهارتی |

|---|---|

|

چهار ستاره |

سه ستاره |

کارت پایه ژول کونده یکی از بهترین گزینه ها در دفاع راست در مراحل اولیه FC 25 بود و این مدافع کناری بارسلونا با یک پیشرفت چشمگیر دیگر بازمی گردد. او را بار دیگر متا مرتبط می کند.

خوشبختانه، لینک های کونده مایل ها بهتر از Gyokeres هستند، زیرا بازیکنان فرانسوی دارای برخی از گزینه های فراوان با کیفیت بالا هستند. Jockey یک PlayStyle Plus عالی برای دفاع راست است، زیرا شما قادر خواهید بود بازیکنان هجومی را به سمت پایین هدایت کنید بدون اینکه توانایی آن را از دست بدهید. در یک لحظه جهت را با آنها تغییر دهید.

4

نیکولو بارلا – لومباردیا اف سی

|

پا ضعیف |

حرکات مهارتی |

|---|---|

|

چهار ستاره |

چهار ستاره |

در حالی که نیکولو بارلا پر زرق و برق ترین بازیکن یا بزرگترین نام در این لیست نیست، کارت Thunderstruck او بالاتر از گزینه های مشابه بر اساس دسترسی، ارزش و کیفیت کلی. ویژگیهای بارلا از صفحه خارج نمیشود، اما او به طور مداوم با حرکات و دریبلهای چشمگیر خود در بازی، از جمله ویژگیهای دیگر، بیش از حد عمل میکند.

او با جثه کوچک خود ترسی به حریفان شما وارد نمی کند، اما حضور بسیار زیاد بارلا در خط میانی او را به یکی از قابل توجه ترین بازیکنان زمین تبدیل می کند.

3

ویلیام سالیبا – آرسنال

|

پا ضعیف |

حرکات مهارتی |

|---|---|

|

سه ستاره |

دو ستاره |

ویلیام سالیبا یکی از بهترین مدافعان تیم Ultimate است، و این ارتقای عظیمی که او از کارت پایه خود دریافت می کند، با توجه به اینکه نسخه طلایی هنوز چقدر خوب است، حتی بزرگتر به نظر می رسد. دسترسی صلیبا به PlayStyle Plus را پیش بینی کنید او را به یکی از بهترین گزینه ها برای این موقعیت تبدیل می کند.

مرتبط

EA Sports FC 25: 8 بهترین پشتیبان مرکزی زیر 1 میلیون یورو برای ورود به حالت حرفه ای

این مدافعان میانی ارزش پولی را دارند که میپردازید، زیرا همه آنها زیر 1 میلیون یورو قابل خرید هستند.

در حالی که قیمت Saliba او را به اندازه KDB و Fede محدود می کند، اگر سکه هایی برای سرمایه گذاری در این کارت دارید، نباید ماه ها CB خود را تغییر دهید. در حالی که کارتهای دارای دو PlayStyle مطمئناً منحنی قدرت را تغییر میدهند، سالیبا یکی از معدود بازیکنانی است که احتمالاً از این تغییر جان سالم به در میبرد.

2

مارکوس راشفورد – منچستریونایتد

|

پا ضعیف |

حرکات مهارتی |

|---|---|

|

چهار ستاره |

پنج ستاره |

اگر فکر میکردید که برخی از بهترین بازیکنان Thunderstruck تا به حال هزینه زیادی ندارند، پس خود را برای یک برچسب قیمت بزرگ از مارکوس راشفورد آماده کنید، همانطور که این کارت دارد. برخی از مطلوب ترین ویژگی ها می توانید امیدوار باشید در یک بازیکن هجومی

کار کردن با پیوندهای رشفورد و دسترسی او به آن بسیار آسان است پاور شات پلاس او را به یکی از کشندهترین مهاجمان FC 25 تبدیل میکند. با سرعت، شوت و دریبل بیش از 91، رشفورد هیچ نقطه ضعف عمدهای برای صحبت ندارد، مگر اینکه یک پای ضعیف ناقص را تنها عیب در نظر بگیرید.

1

کیلیان امباپه – رئال مادرید

|

پا ضعیف |

حرکات مهارتی |

|---|---|

|

چهار ستاره |

پنج ستاره |

وقتی امباپه کارت تبلیغاتی جدیدی دریافت میکند، احساس تقلب میکند، زیرا او قبلاً در بین بهترین دریبلزنان FC 25 بود، نه اینکه از جهات دیگر به یک مهاجم تقریباً عالی اشاره کنیم. سرعت فوقالعاده امباپه، و ترکیب مرگبار شوت، دریبل و پاس مناسب، او را به یک تهدید تبدیل میکند.

جدای از ویژگیهایش، امباپه با ویژگیهای معروف «جمی» خود همراه است، جایی که به نظر میرسد ریباندها و انحرافات به شکلی جادویی به پای او ختم میشوند، زیرا او با سرعت خود از میان مدافعان عبور میکند. او را امتحان کنید، خواهید دید که تمام صحبت ها در مورد “اورا” و “مربا” چیزی بیش از وافل است.