غواصی در مهندسی داده: اولین هفته من در ZoomCamp 2025 DataTalksClub

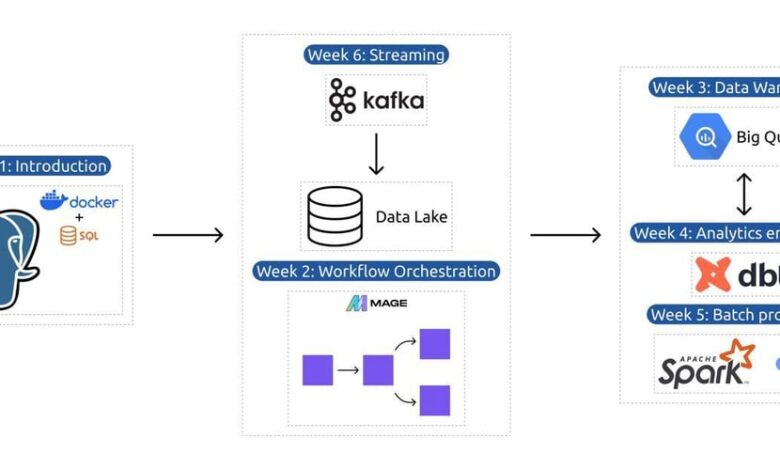

امسال، یکی از اهداف کلیدی من ارتقاء سطح مهارت های حرفه ای ام است، به ویژه در زمینه هایی که با رشد شغلی من هماهنگ است. هفته گذشته، با پیوستن به گروه DataTalk's Data Engineering ZoomCamp 2025، یک برنامه رایگان نه هفتهای که عمیقاً به موارد ضروری و کاربردی مهندسی داده میپردازد، گام بزرگی به سوی این هدف برداشتم.

فقط یک هفته بعد، و من قبلاً خیلی چیزها یاد گرفته ام! در اینجا خلاصه ای سریع از آنچه تاکنون پوشش داده ایم آورده شده است:

1. مبانی داکر: برنامه های کاربردی کانتینرسازی

ما با Docker شروع کردیم، ابزاری قدرتمند برای ایجاد، استقرار و اجرای برنامهها در کانتینرها. کانتینرها محیط های سبک وزن و ایزوله ای هستند که یک برنامه کاربردی و وابستگی های آن را بسته بندی می کنند و اجرای مداوم آن را در محیط های مختلف آسان می کنند.

مفاهیم کلیدی:

- تصاویر: الگوهای فقط خواندنی که برای ایجاد کانتینرها استفاده می شوند

- ظروف: نمونه های در حال اجرا از تصاویر Docker

- Dockerfile: اسکریپتی که نحوه ساخت یک تصویر Docker را تعریف می کند

- حجم ها: ذخیره سازی دائمی برای کانتینرها، تضمین از بین رفتن داده ها هنگام حذف یک کانتینر

دست روی: ما یک پایگاه داده PostgreSQL را کانتینری کردیم و آن را با استفاده از Docker اجرا کردیم. این به ما اجازه داد تا در عرض چند دقیقه یک محیط پایگاه داده کاملاً کاربردی را راه اندازی کنیم!

2. Docker Compose: مدیریت برنامه های کاربردی چند کانتینری

در مرحله بعد، Docker Compose را بررسی کردیم، ابزاری برای تعریف و اجرای برنامههای Docker چند کانتینری. با استفاده از یک فایل docker-compose.yaml، سرویس ها، شبکه ها و حجم ها را برای برنامه خود پیکربندی کردیم.

تنظیم مثال:

- یک ظرف پایگاه داده PostgreSQL

- یک کانتینر pgAdmin برای مدیریت پایگاه داده

- هر دو کانتینر از طریق یک شبکه Docker سفارشی متصل می شوند

دستورات:

-

docker-compose up -d: خدمات را در حالت جدا شروع کنید -

docker-compose down: سرویس ها را متوقف و حذف کنید

3. Terraform: Infrastructure as Code (IaC)

در سمت ابر، ما به Terraform، یک ابزار منبع باز Infrastructure-as-Code (IaC) وارد شدیم. Terraform به شما این امکان را می دهد که با استفاده از یک زبان پیکربندی اعلامی، زیرساخت را تعریف و تهیه کنید.

مفاهیم کلیدی:

- مدیریت دولتی: Terraform وضعیت زیرساخت شما را در یک فایل tfstate ردیابی می کند

- ارائه دهندگان: افزونه هایی که با API های ابری تعامل دارند (مانند GCP، AWS)

- منابع: اجزای زیرساخت شما (به عنوان مثال، ماشین های مجازی، پایگاه های داده)

دست روی: ما از Terraform برای خودکار کردن راهاندازی منابع ابری در Google Cloud Platform (GCP) از جمله سطلهای ذخیرهسازی و ماشینهای مجازی استفاده کردیم.

4. برنامه واقعی: مجموعه داده های نیویورک TLC

برای گره زدن همه چیز به هم، ما با مجموعه داده های TLC نیویورک، یک مجموعه داده در دنیای واقعی که برای تجزیه و تحلیل تاکسی و به اشتراک گذاری سواری استفاده می شود، کار کردیم. ما مفاهیمی را که یاد گرفتیم-Docker، PostgreSQL و Terraform- برای جذب، ذخیره و تجزیه و تحلیل داده ها به کار بردیم.

5. بعدی چیست؟

این تازه آغاز راه است! در طول هشت هفته آینده، ما عمیقتر به خطوط لوله داده، هماهنگسازی جریان کار و موارد دیگر خواهیم پرداخت. من برای ادامه این سفر و به اشتراک گذاشتن آموخته هایم در این راه هیجان زده هستم.

یک تشکر بزرگ از @alexeygrigorev و کل تیم DataTalksClub برای راهنمایی و پشتیبانی آنها. این سفر هم چالشبرانگیز و هم پربار بوده است، و من نمیتوانم منتظر بمانم تا ببینم بعد به کجا میبرم!

شما چطور؟ آیا در زمینه مهندسی داده یا فناوریهای ابری مهارت بیشتری دارید؟ در نظرات به من اطلاع دهید!