Ashpez – برنامه تحویل غذا

ساختن چیزی مفید و به اشتراک گذاشتن آن با جهان یکی از شادی های توسعه دهنده است. به همین دلیل من از معرفی اشپس ، منبع باز ، هیجان زده ام. کاربرد تحویل مواد غذایی تمام پشته من با استفاده از Next.JS 14 و CMS LOAD ایجاد کردم. این یک برنامه پاسخگو و پر از ویژگی است که همه چیز را از سفارش غذا گرفته تا مدیریت رستوران ها-همه در یک مکان انجام می دهد. این که آیا شما یک توسعه دهنده هستید که به دنبال یک پروژه عملی برای کشف هستید ، یک صاحب مشاغل که رویای یک بستر تحویل مواد غذایی سفارشی را دارد ، یا فقط یک کنجکاو کنجکاو ، Ashpez در اینجا برای شیرجه زدن به شما است. اوه ، و در اینجا یک جایزه جالب وجود دارد-با یک فایل FIGMA بسته بندی شده با طراحی آماده برای رفتن همراه است

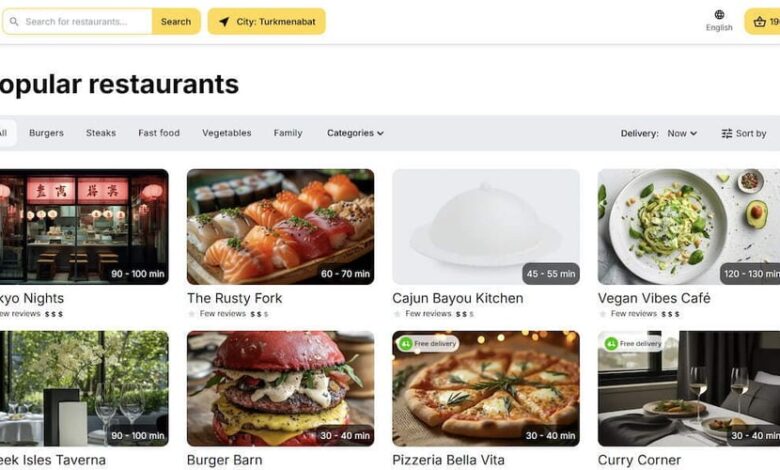

تحویل غذا ، ساده شده

Ashpez برنامه کاربر در جایی است که افراد می توانند ثبت نام کنند ، منوها را مرور کنند ، غذا سفارش دهند و تحویل های خود را ردیابی کنند. از سوی دیگر ، این یک صفحه سرپرست قدرتمند است که صاحبان رستوران می توانند منوها و سفارشات خود را مدیریت کنند ، در حالی که سرپرستان نظارت بر کل سیستم را دارند. کاملاً پاسخگو است ، به این معنی که از نظر تلفن یا دسک تاپ شما عالی به نظر می رسد ، و با ابزارهای مدرن ساخته شده است تا سریع و انعطاف پذیر باشد.

چرا Next.js و CMS بارگذاری؟

من Next.JS 14 را انتخاب کردم (که اخیراً به 15 ارتقا یافته است) زیرا این یک نیروگاه برای توسعه کامل است. روتر برنامه ، داخلی i18n برای پشتیبانی چند زبانه ، و ارائه سرور بدون درز ، آن را برای یک برنامه پویا مانند این مناسب ساخت. به علاوه ، اکوسیستم آن – فکر می کنید پرس و جو Tanstack برای واکشی داده ها ، Jotai برای مدیریت دولت و Shadcn برای اجزای UI زرق و برق دار – به من اجازه دهید به جای اختراع مجدد Whee ، روی ویژگی ها تمرکز کنم

برای پس زمینه ، CMS بار بار نمایش را به سرقت برد. این یک CMS انعطاف پذیر و دوستانه است که به زیبایی با Next.js. ادغام می شود. جفت شده با MongoDB ، همه چیز را از تأیید اعتبار کاربر گرفته تا داده های رستوران با سهولت انجام می دهد. نیازی به یک پس زمینه سفارشی حجیم نیست – بار پرداخت به من یک صفحه و API API را از جعبه به من می دهد ، که من برای پشتیبانی از تحویل مواد غذایی چند منظوره تنظیم کرده ام.

زیر کاپوت چیست؟

در اینجا طعم آنچه Ashpez ارائه می دهد وجود دارد:

- ویژگی های مشتری: ثبت نام ، ورود به سیستم ، سفارش غذا ، تحویل پیگیری و مشاهده تاریخچه سفارش خود-همه با به روزرسانی های زمان واقعی و یک طراحی پاسخگو.

- پانل مدیر: مدیریت رستوران ها ، اختصاص دادن صاحبان ، منوهای ترفند و به روزرسانی وضعیت سفارش. این برنامه از نقش هایی مانند Admin (کنترل کامل) ، صاحب رستوران (دامنه خودشان) و مهمان (فقط نمایش) پشتیبانی می کند.

- نکات برجسته فنی: Next.JS 14 ، Payload CMS ، MongoDB ، GraphQL ، Tanstack Query ، Jotai ، Zod با-قلاب-فرم و دم از طریق Shadcn. این SEO دوستانه ، در دسترس (A11y) و چند زبانه آماده با Next-Intl است.

- پشتیبانی چند منظوره: یک پلتفرم ، بسیاری از رستوران ها – برای یک شبکه تحویل مواد غذایی مقیاس پذیر.

آن را در GitHub بررسی کنید.

خودتان آن را امتحان کنید

آیا می خواهید آن را در عمل ببینید؟ نسخه ی نمایشی زنده در اینجا ، با پانل مدیر در /adminبشر از این حساب های مهمان استفاده کنید تا در اطراف _ (فقط در هر جلسه مرورگر به مشتری و مدیر وارد نشوید – اسناد را برای این دلیل بررسی کنید):

بیایید یک چیز عالی را بپزیم

به سمت repo بروید ، نسخه ی نمایشی را امتحان کنید و به من اطلاع دهید که چه فکر می کنید. یک ویژگی در ذهن دارید؟ یک اشکال پیدا کردید؟ یک مسئله را باز کنید یا یک PR ارسال کنید – دوست دارم ببینم کجا می توانیم این را با هم جمع کنیم.

Bon Appétit ، و برنامه نویسی مبارک!