چک لیست تجربه محتوا 2025: نگه دارید، بکشید، ایجاد کنید

آیا توجه کرده اید؟ ما قبلاً وارد دوره جدید شده ایم علامت دیجیتالهتینگ–تجربیات: دوره هفتم بازاریابی (بر اساس کتابی به همین نام توسط بازاریابان حرفه ای، رابرت رز و کارلا جانسون).

و تجربه مشتری مبتنی بر محتوا این روزها برای برندها بسیار مهم است.

در این مقاله:

در واقع، این بسیار مهم است که پیشبینی میشود بازار تولید محتوای دیجیتال با سرعت رشد کند CAGR 13.9٪ در طول دوره پیش بینی از 2025 تا 2030.

اما آیا واقعاً نیاز دارید که تعداد زیادی محتوا را روی مخاطبان هدف خود اسپری کنید (و دعا کنید) تا در آنها غرق شوند؟ قطعا نه.

شما نباید اجازه دهید شرکت شما به یک شرکت تبدیل شود بازاریابی محتوا کارخانه فقط به خاطر آن

برای این کار، بیایید با این چک لیست تجربه محتوا برای آینده بازاریابی، تمیز کردن بهار را انجام دهیم:

- نگه دارید ← نگه داشتن تمام موارد ضروری (باید)

- حذف/کشتن ← دور ریختن وسایل غیر ضروری در سطل زباله دیجیتال

- ایجاد کنید ← تولید چیز دیگری که قبلاً در نظر نگرفته اید (یا در امتحانش تردید نکرده اید).

بنابراین، جارو دیجیتال خود را آماده کنید – و ما ادامه می دهیم!

چه چیزهایی را در استراتژی محتوای خود حفظ و اولویت بندی کنید

بیایید با چند چیز که باید آنها را در اولویت قرار دهیم شروع کنیم.

قطعات آموزشی همیشه سبز

اگر این فرآیند را با بی نظمی کمد لباس مقایسه کنیم، آنگاه «همیشه سبز»های آموزنده، کلاسیک های بی انتها خواهند بود که هرگز آنها را دور نمی اندازید، حتی اگر 10 یا 15 ساله باشند. و دلیلش اینجاست

آنها صرف نظر از اینکه برای مخاطبان شما مرتبط و ارزشمند باقی می مانند گرایش های دیجیتال مارکتینگ یا فصل ها بعلاوه، آنها یک ماموریت نجیب دارند – آموزش مشتریان شما و ایجاد یک روشنگر تجربه محتوا مهم نیست چه سالی است.

چنین همیشه سبز انواع محتوا به شرح زیر می باشند:

- واژه نامه ها

- مقاله های توضیح دهنده

- آموزش های تصویری

- فهرست ابزار

- مقایسه پست ها

- راهنمای عیب یابی و غیره

به عنوان مثال:

به این راهنمای مراقبت از گیاهان همیشه سبز (گاهی اوقات به معنای واقعی کلمه!) نگاه کنید Bloomscape به عنوان نکات برجسته داستان که مستقیماً در دسترس است، اضافه شده است. شبکه اینستاگرام برای راحتی

منبع

اما فراموش نکنید محتوای همیشه سبز خود را هر از گاهی با اطلاعات تازه (و معنی دار) به روز کنید. این مانند خشکشویی کردن کت قدیمی مورد علاقهتان است—هنوز کاملاً مناسب است، با این حال تازهتر و براقتر به نظر میرسد.

به عنوان مثال:

ببینید Userpilot چگونه همیشه سبز را ویرایش کرد محتوای B2B قطعه، فهرستی با «بیش از 50 ابزار نصب کاربر برای SaaS [Updated for 2025 & Categorized]”

منبع

اخبار در طاقچه (و مکان در صورت وجود و مرتبط با کسب و کار شما)

آیا بخش «اخبار صنعت» را در برنامه محتوایی خود دارید؟

عالی! آن را به طور سیستماتیک نگه دارید و آن را تمدید کنید تا سرفصلهای مرتبط با تخصصی را به اشتراک بگذارید که بر کسب و کار شما تأثیر میگذارد یا حتی شکل جدیدی به آن میدهد.

به گفته آدریان آیورگا، بنیانگذار و رئیس 617 بوستون موورز (خدمات جابجایی در بوستون، MA)، به روز ماندن با اخبار جامعه برای افراد کوچک ضروری است مشاغل محلی و چک لیست تجربه محتوای آنها. او توصیه می کند:

🗣️

“گوش خود را در محل خود به زمین ببرید. با این کار شما چیزی فراتر از یک برند می شوید. شما در حال حاضر از طریق احساس با هم بودن بخشی از گفتگو و جامعه هستید، همیشه در یک صفحه خبری باقی میمانید و به آنچه اتفاق میافتد و تأثیر آن بر مشتریان و برند شما اهمیت میدهید.”

این قدرت است بازاریابی جغرافیایی هدفمند در افزایش تجربیات محتوا به صورت محلی

اما!

این بدان معنا نیست که شما باید تک تک لحظات یا رویدادها را پوشش دهید (البته مگر اینکه یک رسانه خبری باشید). فقط روی مواردی تمرکز کنید که به طور خاص به یک روش یا روش دیگر به تجارت شما مربوط می شود.

به عنوان مثال:

617 جابجایی بوستون به مخاطبان محلی خود یک هشدار دوستانه دادند لینکدین: “ترافیک سنگین و محدودیت های شدید پارکینگ” در منطقه Fenway/Kenmore به دلیل پایان فصل Red Sox. به عبارت دیگر، آنها یک خبر محلی را به یک نکته متحرک برای مشتریان همان محله تبدیل کردند.

منبع

یا در اینجا یک خبر مشابه دیگر (و توصیه های حرکتگران) در پست لینکدین در مورد موزیکال تینا ترنر روی صحنه آمده است.

منبع

داستان سرایی انسان بیش از هوش مصنوعی

با وجود رونق هوش مصنوعی مولد در تولید محتوا، مردم همچنان به نظرات دیگران اعتماد بیشتری دارند. اعداد زیر به وضوح این را ثابت می کند.

بیش از نیمی از مردم (55%) در وب سایت هایی که به شدت به مقالات وبلاگ تولید شده توسط هوش مصنوعی متکی هستند احساس ناراحتی کنید.

در رسانه های اجتماعی، کاربران هنگام مشاهده محتوای هوش مصنوعی احساسات متفاوتی دارند:

- برای 19٪ → برند فاقد خلاقیت و تخیل است.

- برای 20٪ → غیرقابل اعتماد یا حتی تنبل به نظر می رسد.

- برای 25٪ → غیر شخصی است.

برعکس، به عنوان جفری ژو، مدیرعامل و بنیانگذار وام انجیر، اظهارات:

🗣️

به عنوان مثال:

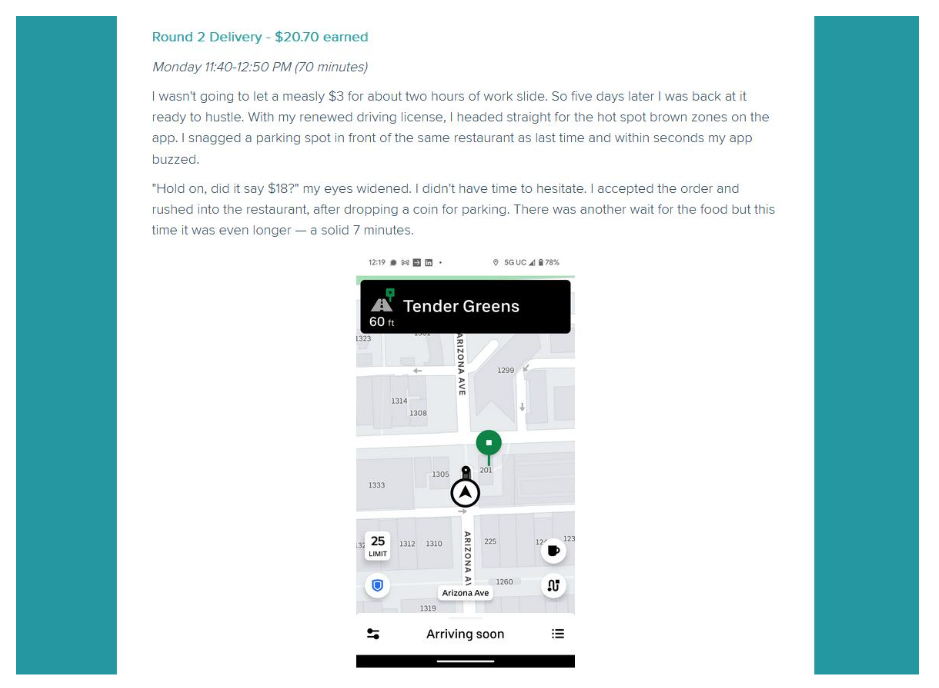

با رعایت این کلمات، تیم Fig Loans تلاشهای جانبی مختلف را به عنوان فرصتهای کسب درآمد – از راه رفتن سگ تا تحویل غذا – با برداشتهای شخصی آزمایش میکند (“من” روایت با اسکرین شات و عکس).

هدف؟ برای کمک به دیگران در تصمیم گیری های مالی عاقلانه تر، یک نظر صادقانه در یک زمان.

در اینجا چند راه دیگر برای برندها وجود دارد محتوا را انسانی تر کنید (حتی اگر قبلاً با هوش مصنوعی تولید شده باشد):

یک اعتراف مخفی داشته باشید مانند:چرا من صبح های دوشنبه را دوست دارم حتی زمانی که همه از آنها در محل کار متنفر هستند“؟ آن را بیرون بریزید. تصویری از زندگی دفتر خود ضبط کرده اید؟ آن را به اشتراک بگذارید! نکته کلیدی این است که شما معتبر باشید.

چه چیزی را از چک لیست تجربه محتوای خود حذف کنید

این بخش به معنای واقعی کلمه یک سم زدایی دیجیتال برای برند شما است. بنابراین، بیایید از شر محتوایی خلاص شویم که نه مخاطب شما را جذب می کند و نه تبدیل به آن می کند.

کمپین های فصلی گذشته یا معاملات تعطیلات

آیا هنوز “فروش تابستانی 2024” صفحه فرود برای بازاریابی فصلی؟

باید حرف بزنیم…

سال 2025 است، تابستان گذشته است و تبلیغات فصلی قدیمی یا کمپین های بازاریابی تعطیلات مثل پارسال هستند کریسمس درخت – احساسی، واقعی، اما تا بهار بسیار نامناسب.

وقت آن است که آنها را رها کنید اگر هنوز این موارد را دارید:

- قلب های روز ولنتاین از سال 2024

- گل های بهاری از سال 2023

- هالووین فانوس های جک که از سال 2022 در صفحه اصلی شما آویزان شده اند

- و غیره (شما متوجه شدید).

اینگونه صفحات فرود دیگر ارزش و ترافیکی ندارند. بنابراین، چرا آنها را نگه دارید؟

بهترین جایگزین:

صفحه را حذف یا بازیافت کنید (برای ایجاد محتوای پایدار). تبلیغات قدیمی تعطیلات/فصلی را با موارد جدید جایگزین کنید. سال، عنوان، پیشنهاد، تصاویر بصری یا عناصر دیگر را بهروزرسانی کنید (مثلاً الف تایمر شمارش معکوس تعطیلات).

به عنوان مثال:

GANT همین را حفظ می کند جمعه سیاه صفحه فرود اما هر سال آن را با فروش های جدید به روز می کند.

منبع

ترفندهای دستکاری

دستکاری بازاریابی نیست. دوره و زمانی که برندها آگاهانه دستکاری می کنند روانشناسی مشتری، آنها در معرض خطر ارائه تجربیات محتوای وحشتناک هستند (و در نتیجه اعتماد مشتری را از دست می دهند).

به عنوان مثال:

شما به وضوح می توانید فریب و دستکاری را در clickbait ردیابی کنید خطوط موضوع ایمیل، مانند این:سلام، لطفا فراموش نکنید که سفارشات خود را تایید کنید!”

📝

هیچ چیزی از برند سفارش داده نشده است.) گاهی اوقات، آنها با ” شروع می شوند.اقدام لازم است“، اما هیچ اقدام اجباری و فوری لازم نیست.

بهترین جایگزین:

محتوای صادقانه ای تولید کنید که فریب ندهد، اما همچنان مشتری را کنجکاو کند. چند نمونه موضوع کنجکاوی برای افزایش نرخ باز شدن در بازاریابی ایمیلیصادقانه و اخلاقی:

- “شوهر من با اینها ابرویی بالا انداخت!”– چاقو

- این راز درخشان ترین پوست شماست-درخشش

- چرا اکنون این غذا در منوی هر رستورانی وجود دارد؟-خورنده

- من قبلاً این کار را نکرده بودم …– Anglers.com

اضافه کردن کلمات کلیدی قدیمی برای سئو

به یاد داشته باشید زمانی که پر کردن کلمات کلیدی در دست همه بود برگه تقلب SEO? آره روزگار عجیبی و آنها (بالاخره!) تمام شده اند.

امروزه پر کردن بیش از حد صفحات وب با کلمات کلیدی یکی از موارد است بدترین اشتباهات سئو، بی سر و صدا عملکرد وب سایت شما را از بین می برد و آن را عمیقاً در نتایج جستجو دفن می کند.

گوگل وبسایتها را با کاهش رتبهبندی یا حتی حذف کامل آنها از SERP جریمه میکند.

موتورهای جستجو مانند گوگل هوشمند هستند، اما خوانندگان شما حتی باهوش تر هستند. آنها میتوانند از یک مایل دورتر، هرزنامههای کلمه کلیدی را به این شکل «بو کنند».

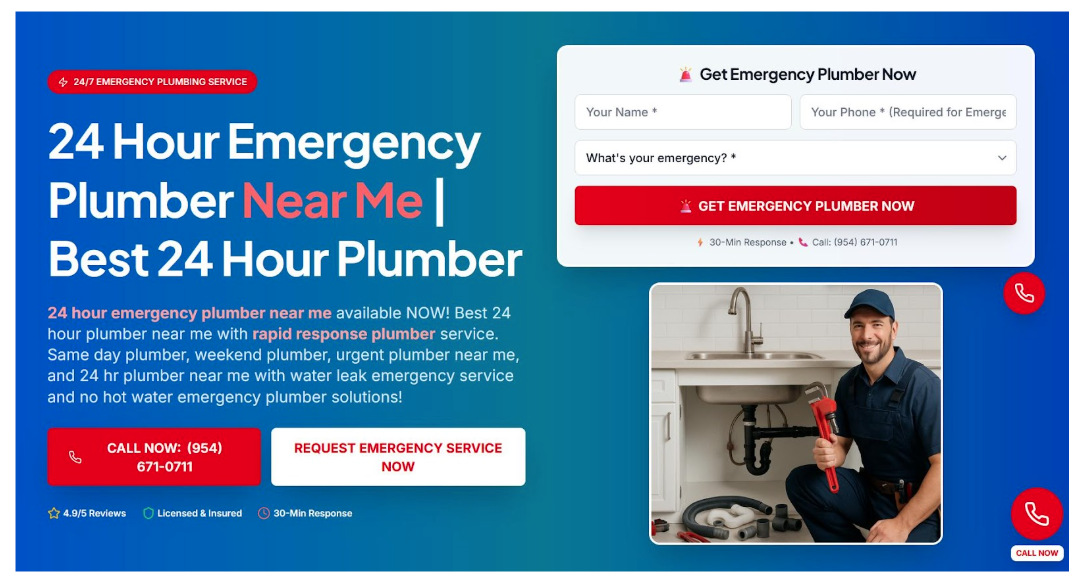

منبع

حتی مانند یک جمله خوانده نمی شود (کاملاً بیش از حد برای سئوی محلی):”لوله کش اورژانس 24 ساعته نزدیک من” یا ”لوله کش فوری نزدیک من” و ایجاد یک تجربه محتوای ضعیف حداقل به نظر ناخوشایند است.

بنابراین، اگر شما می خواهید هک رشد سئو برای بازاریابی محتوای موثر در سال 2025 و پس از آن، به اینجا می رسد.

بهترین جایگزین:

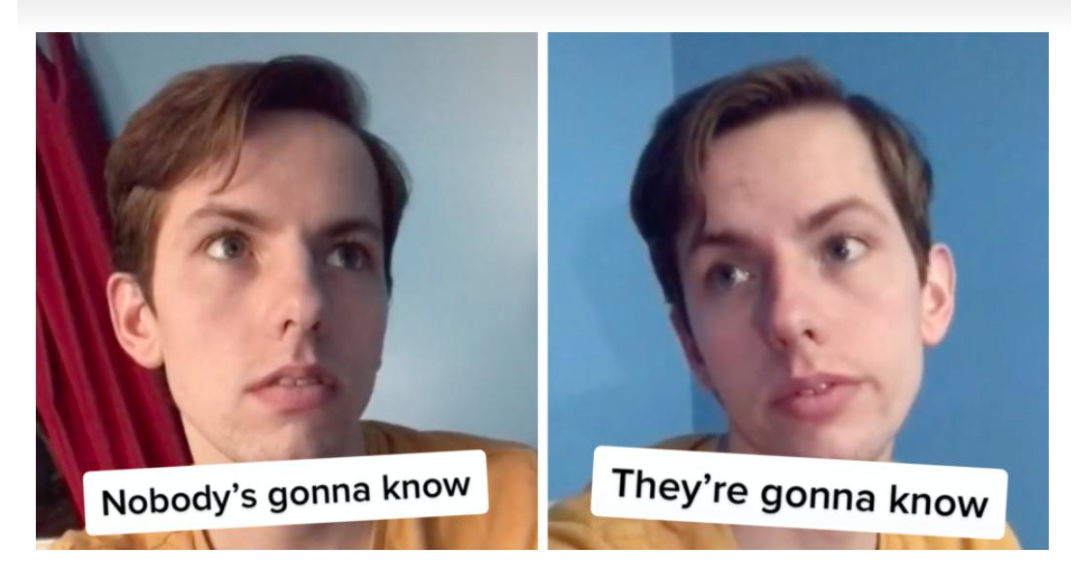

برای قرار دادن کلمات کلیدی طبیعی تر تلاش کنید و ابتدا برای مردم محتوا بنویسید. کلمات کلیدی خود را به طور طبیعی تر مانند چاشنی بپاشید، نه آنطور که کل فلفلدان را در آنجا ریخته اید (شاید هیچ کس نداند – خوب، آنها می دانند!).

منبع

چه چیزی را به چک لیست ایجاد محتوای خود اضافه کنید

سوالات متداول برای AEO و GEO

بیایید با آن روبرو شویم – سئو دیگر یک کلمه رایج نیست. AEO (بهینه سازی موتور پاسخگویی) و GEO (بهینه سازی موتور مولد) هستند. و سوالات متداول نان و کره برای هر دو است.

علاوه بر صفحه سوالات متداول عمومی در وب سایت خود، اضافه کردن یک صفحه را در نظر بگیرید ویجت پرسش و پاسخ به هر صفحه محصول یا پست وبلاگ. این یک ابزار فوق العاده برای بهینه سازی صفحات وب شما برای AEO و GEO است، زمانی که مردم به دنبال پاسخ مستقیم هستند.

به این ترتیب، نه تنها برای پاسخ های گوگل یا نتایج موتورهای مولد رتبه بالاتری کسب خواهید کرد، بلکه یک تجربه محتوای مثبت نیز ایجاد خواهید کرد. چگونه؟

همه چیز در “اورکا!لحظه ای که بازدیدکننده وب سایت (به احتمال زیاد یک مشتری بالقوه) بدون رفتن به جای دیگری اطلاعات مورد نیاز را پیدا می کند.

به عنوان مثال:

از یکی از بریتانیا یاد بگیرید شرکت های حقوقی. وکلای آزبورنز تعبیه شده اند آسیب شخصی سوالات متداول در صفحه خدمات برای بهبود تجربه مشتری و AEO محلی: “آیا به یک وکیل آسیب شخصی در نزدیکی خود نیاز دارم؟”

محتوای تعاملی و بازی سازی شده

اگر همچنان سعی می کنید مخاطبان خود را با دیوارهای متنی بی روح جذب کنید، زمان آن رسیده است که محتوای خود را به سطح بعدی از تجربه های جذاب مشتری ببرید.

به قول آنا ژانگ، رئیس بازاریابی در U7BUY، “محتوای استاتیک چیزی از گذشته است.وی خاطرنشان می کند:

🗣️

عناصر محتوا برای تعامل

- محصول یاب مسابقه

- تست شخصیت

- نظرسنجی یا مینی نظرسنجی

- اینفوگرافیک پویا که شامل شناور کردن یا لغزش برای نمایش داده ها است

- نوار لغزنده قبل و بعد

- ماشین حساب

- کد QR

به عنوان مثال:

Contiki یک مسابقه شخصیت شناسی ایجاد کرد و آن را از طریق ایمیل نیز به اشتراک گذاشت:شما کدام شخصیت «بال چهارم» هستید؟”

عناصر محتوا برای گیمیفیکیشن

- بازی ویدیویی کوچک (مثلاً یک بازی دو بعدی یا بازی سه بعدی)

- شکار یا جستجوی لاشخور

- نشان دستاورد

- چالش مبتنی بر سطوح

- چرخش به برد پاپ آپ گیمی شده

به عنوان مثال:

به این مورد از گیمیفیکیشن درون برنامه ای نگاه کنید بانکداری آنلاین. برای تجلیل از 10 میلیون مشتری، مونوبانک یک بازی “شکار لیمو” را راه اندازی کرد.

منبع

نتیجه؟

تعامل کاربران هفت برابر افزایش یافت. در اوج، تقریباً 750000 کاربر به طور همزمان به دنبال لیمو در برنامه بودند.

ویدیوهای کوتاه بیشتر

شما نمی توانید آن را انکار کنید ویدیوی کوتاه بازاریابی در عصر جنون رسانه های اجتماعی که ناشی از بی حوصلگی انسان است، امری ضروری است. در واقع، 73% از مصرفکنندگان ویدیوهای کوتاه را ترجیح میدهند و 56 درصد افراد زیر 60 ثانیه را ترجیح میدهند.

در این زمینه، معادن طلای تعامل کاربر و رشد فالوور در پلتفرمهای اجتماعی عمدتاً این سه هستند:

شما نمیتوانید این نوع ویدیوها را برای چک لیست ایجاد محتوای خود از دست بدهید، بهویژه زمانی که میخواهید هدف ژنرال Z، تشنه محتوای ریز بصری است که آنها را به تماشا و در نهایت تبدیل به خرید می کند.

به عنوان مثال:

در حالی که مخاطبان جوانتر را در TikTok هدف قرار میدهند، تیم Ninja Transfers آنها را از طریق چالشهای پاسخ ویدیویی درگیر میکند. در اینجا چگونه است.

آنها ویدیوهای جدید TikTok را به عنوان پاسخ به کاربران تولید می کنند که شرکت را جرأت می کنند انتقال های مختلف DTF را روی پوشاک امتحان کند. و در اینجا یکی از آنها است چاپ تی شرت سفارشی چالش: “آیا امکان چاپ یک بافت واقعی وجود دارد؟”

@ninjatransfers درخواست شما 💬 انتقال dtf ماست 😉 چه سوالات دیگری را تبدیل به انتقال کنیم؟! #dtfprinting #dtftransfers #dtftransfer #customparel

♬ صدای اصلی – ALTÉGO

این چک لیست را دنبال کنید و از محتوای فوق العاده لذت ببرید

اکنون که می دانید برای سال 2025 و بعد از آن چه چیزهایی را باید حفظ، حذف و ایجاد کنید، راه خود را به سمت فرآیند مدیریت تجربه محتوا هوشمندتر (و تعاملی تر!) طی کنید.

و این کار را با POWR در وب سایت خود انجام دهید. POWR را کاوش کنید پلاگین ها و برنامه هااز زمانسنجها و لغزندهها گرفته تا فرمهای تعاملی، ظاهر شدن و تبدیل بازدیدکنندگان وبتان به انجامدهنده (و سپس، در حالت ایدهآل، خریداران)، نه فقط بهکارگیرندههای بیکار.