بهترین بازی های PS3 در هر یک از سال های چرخه کنسول

Summarize this content to 400 words in Persian Lang

نکات برجسته

نوستالژی دوران پلی استیشن 3 را با انتخاب های مورد علاقه ما در هر سال، از Resistance تا Persona 5، زنده کنید.

بازیهای کلاسیک FPS مانند BioShock و God of War 3 مجموعهای غنی از عناوین باکیفیت را در ژانرهای مختلف نشان میدهند.

Uncharted 2، Batman: Arkham City، Far Cry 3 و The Last of Us تجربههای داستانی و گیمپلی فوقالعادهای را به نمایش میگذارند.

وقتی میتوانی صادقانه بگوییم که دوران پلیاستیشن 3 دوران نوستالژیکی است، میدانی که پیر میشوی. شاید شما در همان قایق هستید و به کنسولی نگاه میکنید که به تازگی به نظر میرسد، حتی اگر در سال 2006 منتشر شد. یا شاید جوانتر باشید، و این سیستم جوهره نوستالژی است زیرا اولین کنسول شما و دلیل آن بود. گیمر شدی

4:25 مرتبط 26 بازی آنلاین که به پلی استیشن پلاس نیاز ندارند این بازی های آنلاین را می توان بدون اشتراک پلی استیشن پلاس بازی کرد! زمان دانلود آنهاست.

و اگرچه PS3 ورودی های نسبتا جدیدی از صنعت مستقل دریافت کرده است، عمر این کنسول از سال 2006 تا 2017 ادامه یافت، زمانی که تولید آن متوقف شد. با بسیاری از آثار کلاسیک، ما لیستی از انتخاب های مورد علاقه خود را از هر سال تهیه کردیم. اگر مورد علاقه شما موفق نشد پیشاپیش عذرخواهی می کنیم.

12 مقاومت: سقوط انسان (2006)

یک FPS کلاسیک

مقاومت: سقوط انسان منتشر شد 17 نوامبر 2006 ناشر(های) سرگرمی کامپیوتری سونی متاسکور 86

معمولاً مدتی طول می کشد تا یک کنسول جدید مجموعه ای از بازی های جذاب داشته باشد. خوشبختانه، Resistance در همان ابتدا وجود داشت و دلیل خوبی برای شروع یک گیمر بودن ارائه کرد. یا گزینه خوبی برای دریافت چند سال بعد، پس از مقرون به صرفه شدن PS3.

در هر صورت، Resistance و دنبالههای آن تبدیل به یک سریال شگفتانگیز شدند، حتی اگر یکی از محبوبترین سریالهای موجود نباشد، و همه آنها به خوبی ادامه میدهند. این یک انتخاب عالی برای طرفداران شوتر است.

11 BioShock (2007)

یک FPS کلاسیک دیگر

BioShock منتشر شد 21 آگوست 2007 توسعه دهندگان بازی های غیر منطقی چه مدت به ضرب و شتم 12 ساعت متاسکور 96 در دسترس بودن PS Plus Premium (Remastered) گسترش دهید

یکی دیگر از نمونه های عالی از سری FPS با اولین ورودی عالی BioShock است که احتمالا قبلاً نام آن را شنیده اید. برخی از حالات ترسناک شدید، روایتی زیبا، و پیچیدگی کامل داستانی دارد – چیزی که ما آن را خراب نمی کنیم.

توصیه میکنیم اگر قبلاً این کار را نکردهاید، سری بزنید، و اگر از اولین مورد لذت بردید، به سراغ سایر ورودیها بروید، زیرا از ابتدا تا انتها زمان بسیار خوبی است.

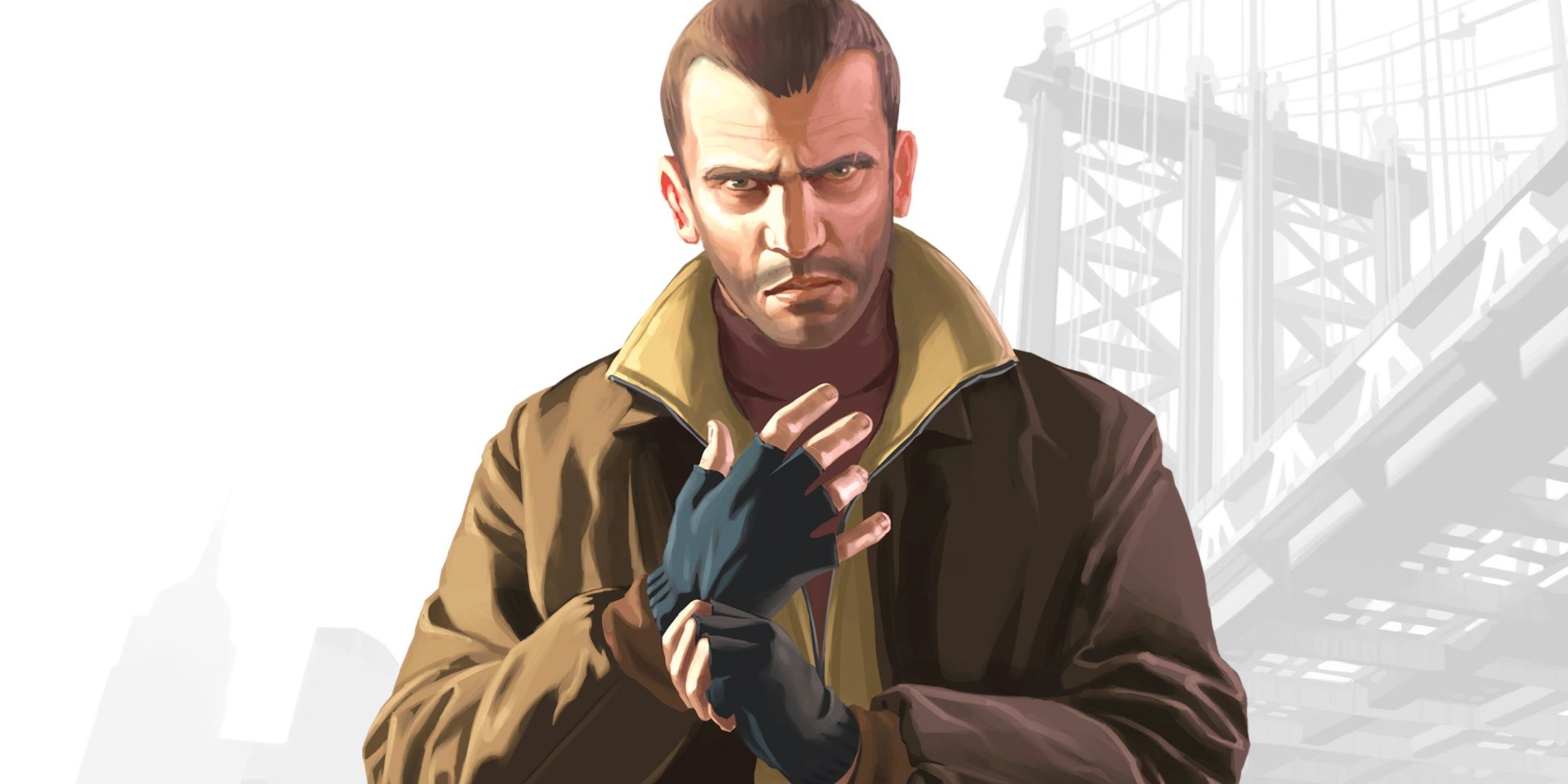

10 Grand Theft Auto 4 (2008)

بیا بریم بولینگ

GTA مجموعهای است که در این مرحله نیازی به معرفی ندارد، جایی که حتی افراد غیر گیمر نیز تا حدودی تصوری از آن دارند. GTA 4 به لطف شخصیت ها، داستان و، خوب، تمام ویژگی های اصلی که GTA را به یاد ماندنی می کند، موفقیت بزرگی کسب کرد.

مرتبط 8 قهرمان بازی Rockstar، رتبه بندی شده اند راک استار در کاتالوگ بازی خود دارای شخصیت های شگفت انگیزی است.

اگرچه صحنههای آن به اندازه دنبالهاش سینمایی نیستند، اما هسته گیمپلی آن بسیار خوب است و GTA 4 را تا به امروز به خریدی عالی تبدیل کرده است.

9 Uncharted 2: Among Thieves (2009)

ضرب و شتم بسیاری در طول راه

Uncharted 2: Among Thieves منتشر شد 13 اکتبر 2009 ناشر(های) سرگرمی کامپیوتری سونی چه مدت به ضرب و شتم 10.5 ساعت

امسال سالی است که تعداد زیادی از هیتترهای سنگین منتشر شد و کار ما را برای انتخاب یکی از آنها بسیار سخت تر می کند. بین Batman Arkham اصلی، Assassin's Creed 2، راه اندازی مجدد Mortal Kombat و بسیاری دیگر، این جایی بود که PS3 واقعاً شروع به درخشش کرد.

جایزه در اینجا همچنان به Uncharted 2 برای بهبود استادانه همه چیز از پیش درآمد خود، که قبلاً یک بازی عالی بود، تعلق می گیرد. و این بازی است که Naughty Dog را به خاطر بازی های فیلم مانندش به شهرت رساند.

8 God Of War 3 (2010)

انتقام من اکنون به پایان می رسد

خدای جنگ 3 منتشر شد 16 مارس 2010 چه مدت به ضرب و شتم 10 ساعت متاسکور 92 در دسترس بودن PS Plus Premium (Remastered) گسترش دهید

اگر صحبت از یک سال پر از کلاسیک شد، در سال 2010 نیز عناوین بسیار خوبی داشتیم. با این حال، آنها مجبور بودند با پایان سری God of War رقابت کنند – تا اینکه تصمیم گرفتند اسطوره ها را تغییر دهند و بیشتر بسازند.

God of War 3 همچنین یک نمونه عالی برای بهبود بازی های در حال حاضر عالی است. قسمت سوم – بدون احتساب پیش درآمدها یا عناوین بینالمللی – گیمپلی فوقالعاده قبلی را بهبود میبخشد و سفر کریتوس برای تبدیل شدن به یک هیولای واقعی را به اوج میرساند.

7 Batman: Arkham City (2011)

Feat Woman

شهر بتمن آرکام منتشر شد 18 اکتبر 2011 چه مدت به ضرب و شتم 14 ساعت متاسکور 96 در دسترس بودن PS Plus حق بیمه گسترش دهید

PS3 ممکن است الگویی از دنباله هایی داشته باشد که کارهای قبلی را بهبود می بخشد، اما این برای ما خوب است. این بار، بتمن کسی است که پیشرفت هایی را دریافت می کند، با نقشه جهانی بهتر برای کاوش، داستان بهتر و گیم پلی روان تر – چیزهایی که قبلاً در Asylum عالی بودند.

این بازی نه تنها این سری را به عنوان یک کلاسیک واقعی تثبیت کرد، بلکه این نسخه از بتمن را به نسخه قطعی بسیاری از طرفداران شوالیه تاریکی – از جمله این نویسنده – تبدیل کرد.

6 Far Cry 3 (2012)

تعریف دیوانگی

Far Cry 3 منتشر شد 29 نوامبر 2012 توسعه دهندگان یوبی سافت مونترال چه مدت به ضرب و شتم 20 ساعت در دسترس بودن PS Plus فوق العاده و پریمیوم

ما هنوز با دنبالهها تمام نشدهایم زیرا Far Cry 3 وظیفه کلاسیک ساختن کل مجموعه را بر عهده دارد. همراه با بهبود همه چیز از قبل و ایجاد چیزهای جدید، داستان نیز در اینجا به یک موفقیت تبدیل شد.

و شما می توانید بسیاری از موفقیت های آن را بر روی کاریزمای Vaas Montenegro قرار دهید، شخصیتی که حتی شخصیت منفی اصلی بازی نیست و همچنان به چهره بازی تبدیل شده است. او همچنین دلیلی است که بازیهای Far Cry از این مرحله به بعد روی افراد شرور سرمایهگذاری زیادی میکنند.

5 The Last Of Us (2013)

از قارچ بترسید

آخرین ما منتشر شد 14 ژوئن 2013 چه مدت به ضرب و شتم 15 ساعت متاسکور 95

ببخشید اگر منتظر بازی GTA 5 بودید، اما وقتی صحبت از هویت PS3 به میان می آید، بازی های کمی تاثیری مشابه The Last of Us داشته اند که از تمام ترفندهایی که Naughty Dog از Uncharted یاد گرفته استفاده می کند، اما اکنون در یک داستان تاریک تر است.

این حتی ممکن است بهترین بازی در این لیست باشد، حداقل از نظر فنی، با مواردی مانند طراحی سطح، روایت و گیم پلی. عناوین بسیار کمی به این سطح از کیفیت می رسند و آنهایی که به این سطح می رسند معمولاً توسط همان شرکت ساخته می شوند.

4 دارک سولز 2 (2014)

زمان برای مردن

دارک سولز 2 منتشر شد 11 مارس 2014 توسعه دهندگان از نرم افزار

اگر به دنبالهها برگردیم، اکنون Dark Souls 2 را داریم. اگرچه Dark Souls یا بهتر است بگوییم Demon's Souls تا اولین بازی FromSoftware فاصله زیادی دارد، این سری چیزی است که آنها را به خاطر خلق تجربیات چالش برانگیز با گیمپلی و باسهای خود مشهور کرده است – ایجاد ژانر شبیه روح. در این فرآیند

مرتبط اولین 15 بازی منتشر شده بر روی PS1 پلی استیشن اصلی به سرعت قلب ما را ربود، و در اینجا نگاهی داریم به اولین عناوینی که تا به حال بر روی این کنسول افسانه ای منتشر شده است.

Dark Souls 2 برای این سری بازی را تغییر داد و دنباله ها چقدر از طرفداران زیادی برخوردار شدند. این ویژگی فوق العاده خوب است که نشان از طراحی عالی بازی آنها دارد.

بازی Hideo Kojima

Metal Gear Solid 5: The Phantom Pain مخفی کاریاکشن-ماجراجوییتیراندازماجراجویی منتشر شد 1 سپتامبر 2015 چه مدت به ضرب و شتم 46 ساعت

Metal Gear Solid که توسط مارتین اسکورسیزی در صنعت بازی ساخته شده است، همیشه انتخاب خوبی برای کنسول شما است و Phantom Pain نیز از این قاعده مستثنی نیست. اگر از بازی های تیراندازی و روایت جذاب لذت می برید – اگرچه شروع از اینجا می تواند گیج کننده باشد – این یک انتخاب عالی است.

برای کسانی که نمیدانند، این بازی روی مخفی کاری نیز تمرکز دارد، به این معنی که شما نمیتوانید بدون عواقب بزرگ به همه افراد شلیک کنید، که این بخشی از سرگرمی است. با این حال، همیشه می توانید تلاش کنید.

2 Persona 5 (2016)

OG Metaverse

پرسونا 5 OpenCritic رتبه بندی منتقدان برتر:94/100 منتشر شد 15 سپتامبر 2016 توسعه دهندگان پی استودیو چه مدت به ضرب و شتم 100 ساعت

در حال حاضر، PS4 در حال تثبیت خود بود، و برخی از ورودی های قبلی نیز در حال حاضر در آن موجود بودند. Persona 5 نیز از این قاعده مستثنی نیست و یکی از آن بازی هایی است که در دو نسل از کنسول ها عرضه می شود.

با این حال، پایان دادن به چرخه کنسول ها با یک بازی عالی مانند این یک راه خوب برای بیرون رفتن با صدای بلند است. Persona یکی از زیباترین RPG های موجود است و این تنها بخشی از چیزی است که آن را عالی می کند.

1 Just Dance 2018 (2017)

سال ما را نیز گیج کرد

در آخرین سال قطعی آن، بازی های زیادی روی PS3 منتشر نشد. هنوز هم میتوانید از Just Dance لذت ببرید، مجموعهای از بازیهای رقص معمولی که فرصتی عالی برای ایجاد لحظات احمقانه با دوستان است.

همچنین مانند ورودیهای قبلی، این مورد برای PS4 نیز منتشر شد، که امروزه در صورت بهروزرسانی کنسولهای شما، دستیابی به آن را آسانتر میکند.

4:18 بعدی بهترین بازی های پلی استیشن 4 در تمام دوران تک تک این بازیهای PS4 یک بازی ضروری است.

نکات برجسته

- نوستالژی دوران پلی استیشن 3 را با انتخاب های مورد علاقه ما در هر سال، از Resistance تا Persona 5، زنده کنید.

- بازیهای کلاسیک FPS مانند BioShock و God of War 3 مجموعهای غنی از عناوین باکیفیت را در ژانرهای مختلف نشان میدهند.

- Uncharted 2، Batman: Arkham City، Far Cry 3 و The Last of Us تجربههای داستانی و گیمپلی فوقالعادهای را به نمایش میگذارند.

وقتی میتوانی صادقانه بگوییم که دوران پلیاستیشن 3 دوران نوستالژیکی است، میدانی که پیر میشوی. شاید شما در همان قایق هستید و به کنسولی نگاه میکنید که به تازگی به نظر میرسد، حتی اگر در سال 2006 منتشر شد. یا شاید جوانتر باشید، و این سیستم جوهره نوستالژی است زیرا اولین کنسول شما و دلیل آن بود. گیمر شدی

4:25

مرتبط

26 بازی آنلاین که به پلی استیشن پلاس نیاز ندارند

این بازی های آنلاین را می توان بدون اشتراک پلی استیشن پلاس بازی کرد! زمان دانلود آنهاست.

و اگرچه PS3 ورودی های نسبتا جدیدی از صنعت مستقل دریافت کرده است، عمر این کنسول از سال 2006 تا 2017 ادامه یافت، زمانی که تولید آن متوقف شد. با بسیاری از آثار کلاسیک، ما لیستی از انتخاب های مورد علاقه خود را از هر سال تهیه کردیم. اگر مورد علاقه شما موفق نشد پیشاپیش عذرخواهی می کنیم.

12 مقاومت: سقوط انسان (2006)

یک FPS کلاسیک

مقاومت: سقوط انسان

- منتشر شد

- 17 نوامبر 2006

- ناشر(های)

- سرگرمی کامپیوتری سونی

- متاسکور

- 86

معمولاً مدتی طول می کشد تا یک کنسول جدید مجموعه ای از بازی های جذاب داشته باشد. خوشبختانه، Resistance در همان ابتدا وجود داشت و دلیل خوبی برای شروع یک گیمر بودن ارائه کرد. یا گزینه خوبی برای دریافت چند سال بعد، پس از مقرون به صرفه شدن PS3.

در هر صورت، Resistance و دنبالههای آن تبدیل به یک سریال شگفتانگیز شدند، حتی اگر یکی از محبوبترین سریالهای موجود نباشد، و همه آنها به خوبی ادامه میدهند. این یک انتخاب عالی برای طرفداران شوتر است.

11 BioShock (2007)

یک FPS کلاسیک دیگر

یکی دیگر از نمونه های عالی از سری FPS با اولین ورودی عالی BioShock است که احتمالا قبلاً نام آن را شنیده اید. برخی از حالات ترسناک شدید، روایتی زیبا، و پیچیدگی کامل داستانی دارد – چیزی که ما آن را خراب نمی کنیم.

توصیه میکنیم اگر قبلاً این کار را نکردهاید، سری بزنید، و اگر از اولین مورد لذت بردید، به سراغ سایر ورودیها بروید، زیرا از ابتدا تا انتها زمان بسیار خوبی است.

10 Grand Theft Auto 4 (2008)

بیا بریم بولینگ

GTA مجموعهای است که در این مرحله نیازی به معرفی ندارد، جایی که حتی افراد غیر گیمر نیز تا حدودی تصوری از آن دارند. GTA 4 به لطف شخصیت ها، داستان و، خوب، تمام ویژگی های اصلی که GTA را به یاد ماندنی می کند، موفقیت بزرگی کسب کرد.

مرتبط

8 قهرمان بازی Rockstar، رتبه بندی شده اند

راک استار در کاتالوگ بازی خود دارای شخصیت های شگفت انگیزی است.

اگرچه صحنههای آن به اندازه دنبالهاش سینمایی نیستند، اما هسته گیمپلی آن بسیار خوب است و GTA 4 را تا به امروز به خریدی عالی تبدیل کرده است.

9 Uncharted 2: Among Thieves (2009)

ضرب و شتم بسیاری در طول راه

Uncharted 2: Among Thieves

- منتشر شد

- 13 اکتبر 2009

- ناشر(های)

- سرگرمی کامپیوتری سونی

- چه مدت به ضرب و شتم

- 10.5 ساعت

امسال سالی است که تعداد زیادی از هیتترهای سنگین منتشر شد و کار ما را برای انتخاب یکی از آنها بسیار سخت تر می کند. بین Batman Arkham اصلی، Assassin's Creed 2، راه اندازی مجدد Mortal Kombat و بسیاری دیگر، این جایی بود که PS3 واقعاً شروع به درخشش کرد.

جایزه در اینجا همچنان به Uncharted 2 برای بهبود استادانه همه چیز از پیش درآمد خود، که قبلاً یک بازی عالی بود، تعلق می گیرد. و این بازی است که Naughty Dog را به خاطر بازی های فیلم مانندش به شهرت رساند.

8 God Of War 3 (2010)

انتقام من اکنون به پایان می رسد

اگر صحبت از یک سال پر از کلاسیک شد، در سال 2010 نیز عناوین بسیار خوبی داشتیم. با این حال، آنها مجبور بودند با پایان سری God of War رقابت کنند – تا اینکه تصمیم گرفتند اسطوره ها را تغییر دهند و بیشتر بسازند.

God of War 3 همچنین یک نمونه عالی برای بهبود بازی های در حال حاضر عالی است. قسمت سوم – بدون احتساب پیش درآمدها یا عناوین بینالمللی – گیمپلی فوقالعاده قبلی را بهبود میبخشد و سفر کریتوس برای تبدیل شدن به یک هیولای واقعی را به اوج میرساند.

7 Batman: Arkham City (2011)

Feat Woman

PS3 ممکن است الگویی از دنباله هایی داشته باشد که کارهای قبلی را بهبود می بخشد، اما این برای ما خوب است. این بار، بتمن کسی است که پیشرفت هایی را دریافت می کند، با نقشه جهانی بهتر برای کاوش، داستان بهتر و گیم پلی روان تر – چیزهایی که قبلاً در Asylum عالی بودند.

این بازی نه تنها این سری را به عنوان یک کلاسیک واقعی تثبیت کرد، بلکه این نسخه از بتمن را به نسخه قطعی بسیاری از طرفداران شوالیه تاریکی – از جمله این نویسنده – تبدیل کرد.

6 Far Cry 3 (2012)

تعریف دیوانگی

Far Cry 3

- منتشر شد

- 29 نوامبر 2012

- توسعه دهندگان

- یوبی سافت مونترال

- چه مدت به ضرب و شتم

- 20 ساعت

- در دسترس بودن PS Plus

- فوق العاده و پریمیوم

ما هنوز با دنبالهها تمام نشدهایم زیرا Far Cry 3 وظیفه کلاسیک ساختن کل مجموعه را بر عهده دارد. همراه با بهبود همه چیز از قبل و ایجاد چیزهای جدید، داستان نیز در اینجا به یک موفقیت تبدیل شد.

و شما می توانید بسیاری از موفقیت های آن را بر روی کاریزمای Vaas Montenegro قرار دهید، شخصیتی که حتی شخصیت منفی اصلی بازی نیست و همچنان به چهره بازی تبدیل شده است. او همچنین دلیلی است که بازیهای Far Cry از این مرحله به بعد روی افراد شرور سرمایهگذاری زیادی میکنند.

5 The Last Of Us (2013)

از قارچ بترسید

آخرین ما

- منتشر شد

- 14 ژوئن 2013

- چه مدت به ضرب و شتم

- 15 ساعت

- متاسکور

- 95

ببخشید اگر منتظر بازی GTA 5 بودید، اما وقتی صحبت از هویت PS3 به میان می آید، بازی های کمی تاثیری مشابه The Last of Us داشته اند که از تمام ترفندهایی که Naughty Dog از Uncharted یاد گرفته استفاده می کند، اما اکنون در یک داستان تاریک تر است.

این حتی ممکن است بهترین بازی در این لیست باشد، حداقل از نظر فنی، با مواردی مانند طراحی سطح، روایت و گیم پلی. عناوین بسیار کمی به این سطح از کیفیت می رسند و آنهایی که به این سطح می رسند معمولاً توسط همان شرکت ساخته می شوند.

4 دارک سولز 2 (2014)

زمان برای مردن

دارک سولز 2

- منتشر شد

- 11 مارس 2014

- توسعه دهندگان

- از نرم افزار

اگر به دنبالهها برگردیم، اکنون Dark Souls 2 را داریم. اگرچه Dark Souls یا بهتر است بگوییم Demon's Souls تا اولین بازی FromSoftware فاصله زیادی دارد، این سری چیزی است که آنها را به خاطر خلق تجربیات چالش برانگیز با گیمپلی و باسهای خود مشهور کرده است – ایجاد ژانر شبیه روح. در این فرآیند

مرتبط

اولین 15 بازی منتشر شده بر روی PS1

پلی استیشن اصلی به سرعت قلب ما را ربود، و در اینجا نگاهی داریم به اولین عناوینی که تا به حال بر روی این کنسول افسانه ای منتشر شده است.

Dark Souls 2 برای این سری بازی را تغییر داد و دنباله ها چقدر از طرفداران زیادی برخوردار شدند. این ویژگی فوق العاده خوب است که نشان از طراحی عالی بازی آنها دارد.

بازی Hideo Kojima

Metal Gear Solid 5: The Phantom Pain

مخفی کاری

اکشن-ماجراجویی

تیرانداز

ماجراجویی

- منتشر شد

- 1 سپتامبر 2015

- چه مدت به ضرب و شتم

- 46 ساعت

Metal Gear Solid که توسط مارتین اسکورسیزی در صنعت بازی ساخته شده است، همیشه انتخاب خوبی برای کنسول شما است و Phantom Pain نیز از این قاعده مستثنی نیست. اگر از بازی های تیراندازی و روایت جذاب لذت می برید – اگرچه شروع از اینجا می تواند گیج کننده باشد – این یک انتخاب عالی است.

برای کسانی که نمیدانند، این بازی روی مخفی کاری نیز تمرکز دارد، به این معنی که شما نمیتوانید بدون عواقب بزرگ به همه افراد شلیک کنید، که این بخشی از سرگرمی است. با این حال، همیشه می توانید تلاش کنید.

2 Persona 5 (2016)

OG Metaverse

پرسونا 5

- رتبه بندی منتقدان برتر:94/100

- منتشر شد

- 15 سپتامبر 2016

- توسعه دهندگان

- پی استودیو

- چه مدت به ضرب و شتم

- 100 ساعت

در حال حاضر، PS4 در حال تثبیت خود بود، و برخی از ورودی های قبلی نیز در حال حاضر در آن موجود بودند. Persona 5 نیز از این قاعده مستثنی نیست و یکی از آن بازی هایی است که در دو نسل از کنسول ها عرضه می شود.

با این حال، پایان دادن به چرخه کنسول ها با یک بازی عالی مانند این یک راه خوب برای بیرون رفتن با صدای بلند است. Persona یکی از زیباترین RPG های موجود است و این تنها بخشی از چیزی است که آن را عالی می کند.

1 Just Dance 2018 (2017)

سال ما را نیز گیج کرد

در آخرین سال قطعی آن، بازی های زیادی روی PS3 منتشر نشد. هنوز هم میتوانید از Just Dance لذت ببرید، مجموعهای از بازیهای رقص معمولی که فرصتی عالی برای ایجاد لحظات احمقانه با دوستان است.

همچنین مانند ورودیهای قبلی، این مورد برای PS4 نیز منتشر شد، که امروزه در صورت بهروزرسانی کنسولهای شما، دستیابی به آن را آسانتر میکند.

4:18

بعدی

بهترین بازی های پلی استیشن 4 در تمام دوران

تک تک این بازیهای PS4 یک بازی ضروری است.