فقط یک بازی ضروری وجود دارد که در ژانویه راه اندازی می شود

ژانویه بدترین ماه سال است. همه چیزهای سرگرم کننده در مورد کریسمس به پایان رسیده است، و اکنون باید یک آخر هفته را صرف کنار گذاشتن تمام تزئینات و کشف چگونگی خلاص شدن از شر کل درخت کنید. شما شکست خورده اید، هوا بد است، و وقت آن است که به سر کار، مدرسه یا هر دو برگردید. من باید تمام سال بیمه ماشینم را در ژانویه پرداخت کنم و تعطیلات بعدی تا اردیبهشت نیست. و بدتر از همه، هیچ بازی ویدیویی جدیدی وجود ندارد.

مرتبط

اگر Dynasty Warriors: Origins را خریداری کرده اید، تا به حال چقدر از آن لذت می برید؟

من واقعا آن را احساس می کنم. مطمئن نبودم که چقدر از بازیگران لاغرتر لذت ببرم. نگاه کردن به آن از زاویهای متفاوت نسبت به نوشتههای قبلی، از آنجایی که از چندین جهت یک حرکت رادیکال است، فکر میکنم این یک پایه فوقالعاده برای آینده Dynasty Warriors است. یک بازی جنگجویان سامورایی را با همین روش اجرا کنید!

دلایل زیادی وجود دارد که ناشران بازیها را در ژانویه منتشر نمیکنند، اما همه آنها به نگرانیهای مالی خلاصه میشوند. مردم پس از کریسمس کمترین میزان درآمد قابل تصرف را دارند. فکر میکنید همه آن گیفتکارتهای پلیاستیشن که بچهها از خالهها و عموهایشان گرفتهاند، همچنان ژانویه را به ماه جذابی برای بازیهای جدید تبدیل میکنند، اما همه آنها قبل از روز سال نو در پوستههای Fortnite و گذرنامههای جنگی استفاده شدهاند. یک بازی ژانویه نیز هرگز جایزه بازی سال TGA را نبرده است. اگر بازی بزرگی دارید، انتشار آن در ژانویه ایده خوبی نیست.

خوشبختانه در برنامه بازیهای کوچکتر فضایی باقی میماند تا کانون توجه را به خود جلب کند. برخلاف فیلمهایی که ژانویه را بهعنوان محل تخلیه فیلمهایی در نظر میگیرند که استودیوها میخواهند ما را فراموش کنیم، هنوز هم یک ماه عالی برای بازیهای مستقل و ورودیهای جدید در سریهای خاص است. این ژانویه هر دو را برای ما به ارمغان می آورد، اما واقعاً فقط یک بازی وجود دارد که باید در این ماه انجام دهید.

بازگشت علاقه مندی های قدیمی

با معرفی اخیر نینتندو سوییچ 2، Donkey Kong Country Returns HD (که در 16 ژانویه راه اندازی می شود) ممکن است آخرین پورت Wii باشد که روی سوییچ اصلی دریافت می کنیم. هفت سال از آخرین Donkey Kong، پورت سوییچ Tropical Freeze که برای اولین بار در سال 2014 برای Wii U منتشر شد، می گذرد. هر دو بازی های Donkey Kong عالی هستند و به همان اندازه که بازدید مجدد از Donkey Kong Country Returns در سال جاری زیبا خواهد بود. ، این یک یادآوری سخت است که به نظر می رسد DK هرگز عشقی را که سزاوارش است دریافت نمی کند.

در مورد آن، سری OG Musou با Dynasty Warriors: Origins در 17 ژانویه بازگشته است. طرفداران طولانی مدت در مورد این تجدید نظر تردید دارند زیرا فهرستی نسبت به ورودی های گذشته به شدت کاهش یافته است، اما پیش نمایش ما، از یک تازه وارد به مجموعه است. ، خوشبین بود. احتمالاً تا زمانی که Elden Ring: Nightreign اواخر سال جاری عرضه شود، این هککنندهترین و هککنندهترین چیزی است که میخواهید داشته باشید.

اگر یک گیمر صبور رایانه شخصی هستید، می توانید در این ماه منتظر بازی Final Fantasy 7 Rebirth و Marvel's Spider-Man 2 باشید.

Sniper Elite: Resistance در 30 ژانویه راه اندازی می شود. ورودی بعدی در سری شبیه ساز تک تیرانداز، یکی دیگر از بازی های تیرانداز مخفی تاکتیکی WW2 است که دارای داستانی موازی با Sniper Elite 5 است. در کنار این کمپین، Resistance چندین گزینه چند نفره از جمله Axis کلاسیک دارد. حالت تهاجم، نبردهای 16 نفره و حالت بقای co-op.

اگر در این ماه فقط یک بازی انجام می دهید…

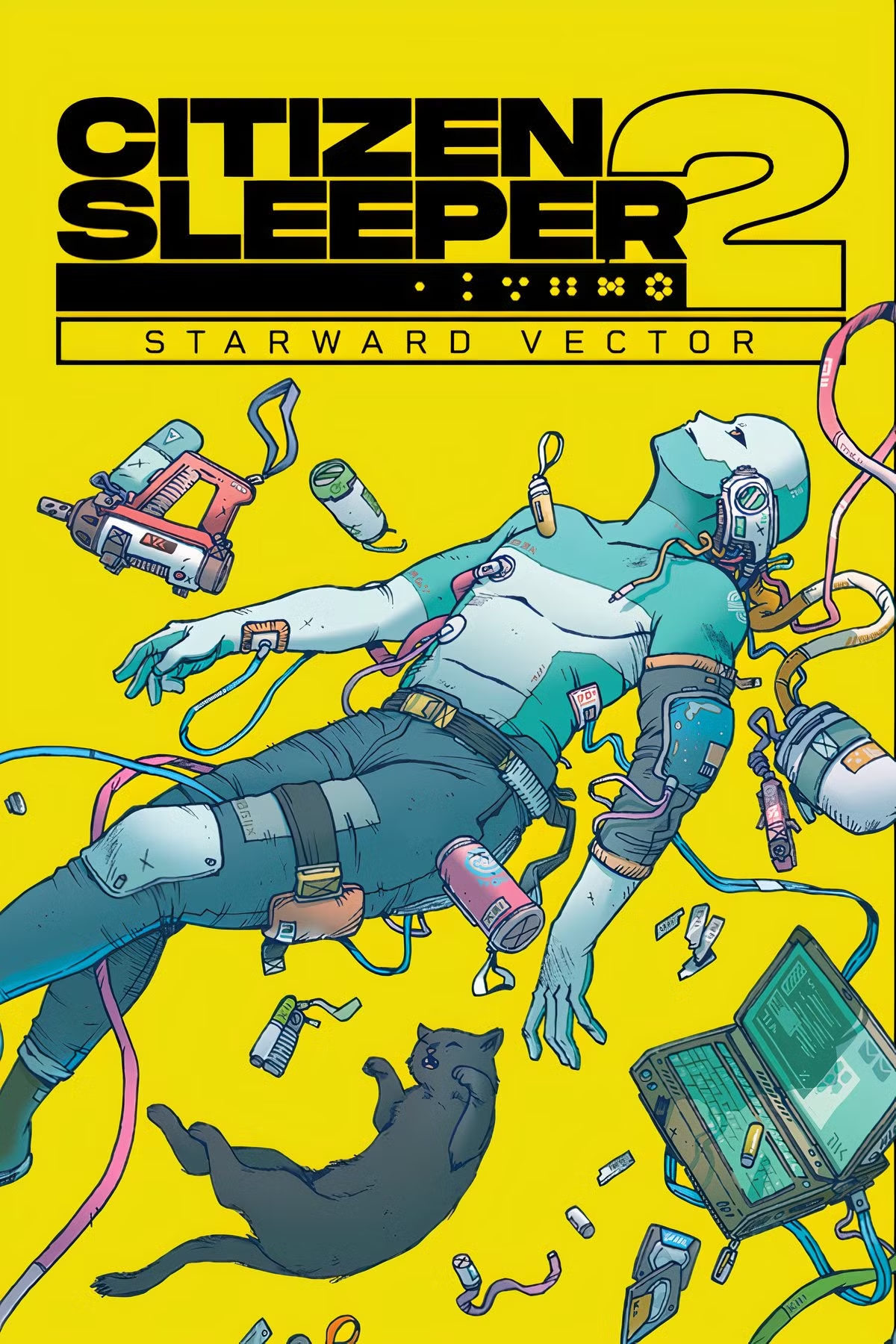

مطمئنم تعلیق داره تو رو میکشه 31 ژانویه تاریخ انتشار Citizen Sleeper 2: Starward Vector است، یک بازی RPG تاس محور و دنباله TheGamer's Game of the Year 2022. اگر Citizen Sleeper اصلی را بازی نکرده اید، چند هفته فرصت دارید تا آن را اصلاح کنید. آن اشتباه تنها حدود هفت ساعت طول می کشد تا کامل شود، یا 13 ساعت برای تکمیل 100 درصد، که احتمالاً می خواهید انجام دهید.

عاقبت همان فرض را از اولی می گیرد – اندرویدی فراری در حال فرار از شرکت بزرگ عصر فضا که آنها را ایجاد کرده است – اما به جای ساختن زندگی برای خود در یک ایستگاه فضایی متروک، این بار از آن می پرید. سیاره به سیاره با خدمه خودت.

Citizen Sleeper یکی از جذاب ترین بازی های RPG در تمام دوران است و دنباله آن قصد دارد از هر نظر بزرگتر و بهتر باشد. اگر در این ماه فقط یک بازی انجام می دهید، این همان بازیی است که نمی توانید آن را از دست بدهید.

دنباله موردانتظار یکی از تحسینشدهترین بازیهای RPG سال ۲۰۲۲، Citizen Sleeper 2: Starward Vector، بازیکنان را به کمربند ستارهوار میبرد، مجموعهای از زیستگاهها در کمربند سیارکی پر از اسرار، داستانها و شخصیتهایی که تلاش میکنند زندگی خود را تامین کنند. .

شما یک خوابیده هستید، تقلید از ذهن انسانی که در یک بدن مصنوعی قرار دارد. شما در حال فرار از شرکتی هستید که شما را ساخته و گروهی که به دنبال کنترل شماست. یک کشتی را فرماندهی کنید، شبکه ای از خدمه و متحدان بسازید و در حالی که به دنبال ساختن آینده ای برای خود هستید، قراردادهای چالش برانگیزی را به عهده بگیرید.

یک کلاس را انتخاب کنید، مهارت های خود را پیکربندی کنید و خدمه خود را در گیم پلی منحصر به فرد الهام گرفته از رومیزی جمع کنید. آینده شما به ریختن یک تاس بستگی دارد، زیرا در دنیایی پیچیده انتخاب های دشواری می کنید. با اختراع مجدد سیستمهای برنده جایزه Citizen Sleeper، این بازی RPG تاس محور هم طرفداران بازی اصلی و هم بازیکنان جدید را راضی میکند.