ساختن پلتفرم هوش مصنوعی مولد: شیرجه ای عمیق در معماری و پیاده سازی

Summarize this content to 400 words in Persian Lang

به عنوان یک توسعه دهنده در فضای هوش مصنوعی، درک معماری پلتفرم های هوش مصنوعی مولد بسیار مهم است. این سیستم ها در خط مقدم برنامه های مدرن هوش مصنوعی قرار دارند و قادر به تولید متن، تصاویر و غیره شبیه انسان هستند. در این مقاله، جنبه های فنی ساخت چنین پلتفرمی را با تمرکز بر اجزای کلیدی و اجرای آنها بررسی خواهیم کرد.

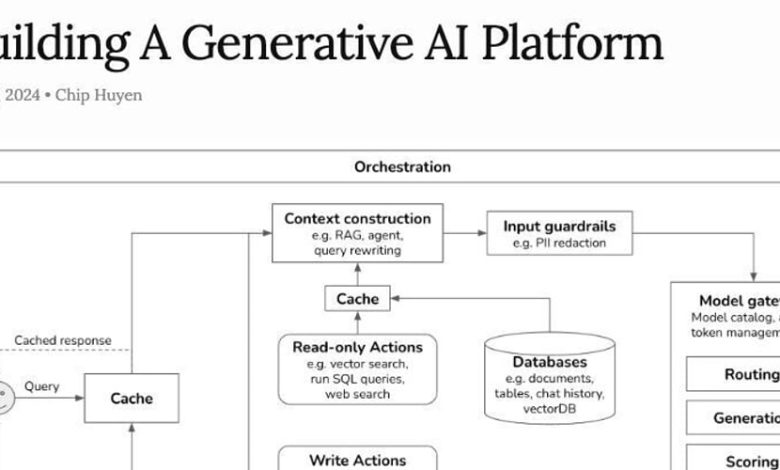

مروری بر #معمارییک پلتفرم هوش مصنوعی مولد معمولاً از چندین مؤلفه به هم پیوسته تشکیل شده است:

لایه ارکستراسیونماژول ساخت زمینهگاردریل ورودی/خروجیدروازه مدلسیستم ذخیره سازیAction Handlers (فقط خواندنی و نوشتاری)لایه پایگاه دادهپشته مشاهده پذیری

بیایید به هر یک از این مؤلفه ها بپردازیم و پیاده سازی فنی آنها را مورد بحث قرار دهیم.#1. لایه ارکستراسیونلایه ارکستراسیون مغز عملیات است. این معمولاً به عنوان یک سیستم توزیع شده با استفاده از فناوری هایی مانند Apache Airflow یا Kubernetes پیاده سازی می شود.

from airflow import DAG

from airflow.operators.python_operator import PythonOperator

def process_query(query):

# Implement query processing logic

pass

def generate_response(context):

# Implement response generation logic

pass

with DAG(‘ai_platform_workflow’, default_args=default_args, schedule_interval=None) as dag:

process_task = PythonOperator(

task_id=’process_query’,

python_callable=process_query,

op_kwargs={‘query’: ‘{{ dag_run.conf[“query”] }}’}

)

generate_task = PythonOperator(

task_id=’generate_response’,

python_callable=generate_response,

op_kwargs={‘context’: ‘{{ ti.xcom_pull(task_ids=”process_query”) }}’}

)

process_task >> generate_task

وارد حالت تمام صفحه شوید

از حالت تمام صفحه خارج شوید

این DAG یک گردش کار ساده را برای پردازش یک پرس و جو و ایجاد یک پاسخ تعریف می کند.

#2. ماژول ساخت زمینهماژول ساخت زمینه اغلب از تکنیک هایی مانند RAG (Retrieval-Augmented Generation) و بازنویسی پرس و جو استفاده می کند. در اینجا یک پیاده سازی ساده با استفاده از کتابخانه langchain آورده شده است:

from langchain import PromptTemplate, LLMChain

from langchain.llms import OpenAI

from langchain.retrievers import ElasticSearchBM25Retriever

# Initialize retriever

retriever = ElasticSearchBM25Retriever(es_url=”http://localhost:9200″, index_name=”documents”)

# Define prompt template

template = “””

Context: {context}

Query: {query}

Generate a response based on the above context and query.

“””

prompt = PromptTemplate(template=template, input_variables=[“context”, “query”])

# Initialize LLM

llm = OpenAI()

llm_chain = LLMChain(prompt=prompt, llm=llm)

def enhance_context(query):

relevant_docs = retriever.get_relevant_documents(query)

context = “\n”.join([doc.page_content for doc in relevant_docs])

return llm_chain.run(context=context, query=query)

وارد حالت تمام صفحه شوید

از حالت تمام صفحه خارج شوید

این قطعه کد نحوه استفاده از RAG را برای بهبود زمینه یک پرس و جو قبل از ارسال آن به مدل زبان نشان می دهد.

#3. گاردریل ورودی/خروجیاجرای نرده محافظ شامل ایجاد فیلترهایی برای ورودی و خروجی است. در اینجا یک مثال اساسی است:

import re

def input_filter(query):

# Remove potential SQL injection attempts

query = re.sub(r’\b(UNION|SELECT|FROM|WHERE)\b’, ”, query, flags=re.IGNORECASE)

# Remove any non-alphanumeric characters except spaces

query = re.sub(r'[^\w\s]’, ”, query)

return query

def output_filter(response):

# Remove any potential harmful content

harmful_words = [‘exploit’, ‘hack’, ‘steal’]

for word in harmful_words:

response = re.sub(r’\b’ + word + r’\b’, ‘[REDACTED]’, response, flags=re.IGNORECASE)

return response

وارد حالت تمام صفحه شوید

از حالت تمام صفحه خارج شوید

این توابع فیلتر اولیه را برای پرس و جوهای ورودی و پاسخ های خروجی فراهم می کنند.

#4. دروازه مدلدروازه مدل دسترسی به مدل های مختلف هوش مصنوعی را مدیریت می کند. در اینجا یک پیاده سازی ساده وجود دارد:

class ModelGateway:

def __init__(self):

self.models = {}

self.token_usage = {}

def register_model(self, model_name, model_instance):

self.models[model_name] = model_instance

self.token_usage[model_name] = 0

def get_model(self, model_name):

return self.models.get(model_name)

def generate(self, model_name, prompt):

model = self.get_model(model_name)

if not model:

raise ValueError(f”Model {model_name} not found”)

response = model.generate(prompt)

self.token_usage[model_name] += len(prompt.split())

return response

gateway = ModelGateway()

gateway.register_model(“gpt-3”, OpenAIModel())

gateway.register_model(“t5″, T5Model())

وارد حالت تمام صفحه شوید

از حالت تمام صفحه خارج شوید

این دروازه امکان ثبت چندین مدل را فراهم می کند و میزان استفاده از رمز را پیگیری می کند.

#5. سیستم ذخیره سازیپیاده سازی یک سیستم کش می تواند عملکرد را به میزان قابل توجهی بهبود بخشد. در اینجا یک حافظه پنهان معنایی اولیه وجود دارد:

import faiss

import numpy as np

class SemanticCache:

def __init__(self, dimension):

self.index = faiss.IndexFlatL2(dimension)

self.responses = []

def add(self, query_vector, response):

self.index.add(np.array([query_vector]))

self.responses.append(response)

def search(self, query_vector, threshold):

D, I = self.index.search(np.array([query_vector]), 1)

if D[0][0]

وارد حالت تمام صفحه شوید

از حالت تمام صفحه خارج شوید

این حافظه پنهان از FAISS برای جستجوی شباهت کارآمد در جاسازیهای پرس و جو استفاده میکند.

#6. اکشن هندلرهاAction handler منطق کسب و کار را برای عملیات های مختلف پیاده سازی می کند:

“` Class ReadOnlyActions:@staticmethoddef vector_search (پرس و جو، فهرست):# منطق جستجوی برداری را پیاده سازی کنیدعبور کند

@staticmethod

def sql_query(query, database):

# Implement SQL query logic

pass

وارد حالت تمام صفحه شوید

از حالت تمام صفحه خارج شوید

کلاس WriteActions:@staticmethoddef update_database (داده، پایگاه داده):# منطق به روز رسانی پایگاه داده را پیاده سازی کنیدعبور کند

@staticmethod

def send_email(recipient, content):

# Implement email sending logic

pass

وارد حالت تمام صفحه شوید

از حالت تمام صفحه خارج شوید

These classes provide a framework for implementing various actions that the AI platform might need to perform.

**#7. Database Layer**

The database layer typically involves multiple types of databases:

وارد حالت تمام صفحه شوید

از حالت تمام صفحه خارج شوید

از pymongo import MongoClientاز واردات elasticsearch Elasticsearch

mongo_client = MongoClient('mongodb://localhost:27017/')doc_store = mongo_client[‘ai_platform’][‘documents’]

es_client = Elasticsearch([{‘host’: ‘localhost’, ‘port’: 9200}])vector_index = 'جاسازی ها'

واردات sqlite3conn = sqlite3.connect('platform.db')

This setup includes MongoDB for document storage, Elasticsearch for vector search, and SQLite for relational data.

**#8. Observability Stack**

Implementing proper observability is crucial for maintaining and improving the platform:

“`import logging

from prometheus_client import Counter, Histogram

# Logging

logging.basicConfig(level=logging.INFO)

logger = logging.getLogger(__name__)

# Metrics

request_counter = Counter(‘ai_platform_requests_total’, ‘Total number of requests’)

latency_histogram = Histogram(‘ai_platform_request_latency_seconds’, ‘Request latency in seconds’)

# Example usage

@latency_histogram.time()

def process_request(request):

request_counter.inc()

logger.info(f”Processing request: {request}”)

# Process the request

pass

وارد حالت تمام صفحه شوید

از حالت تمام صفحه خارج شوید

این تنظیم شامل ثبت اولیه و معیارهای Prometheus برای نظارت بر تعداد درخواست ها و تأخیرها است.

#نتیجه گیریساختن یک پلتفرم هوش مصنوعی مولد یک کار پیچیده است که نیازمند ادغام دقیق چندین مؤلفه است. هر بخش از سیستم نقش مهمی در ارائه محتوای دقیق، کارآمد و ایمن تولید شده توسط هوش مصنوعی ایفا می کند. همانطور که پلتفرم هوش مصنوعی خود را توسعه می دهید، به یاد داشته باشید که این معماری فقط یک نقطه شروع است. شما باید آن را بر اساس نیازهای خاص و موارد استفاده خود تطبیق داده و گسترش دهید.

حوزه هوش مصنوعی به سرعت در حال پیشرفت است و بهروز ماندن با آخرین پیشرفتها بسیار مهم است. به آزمایش، یادگیری، و فشار دادن به مرزهای ممکن با هوش مصنوعی مولد ادامه دهید!

به عنوان یک توسعه دهنده در فضای هوش مصنوعی، درک معماری پلتفرم های هوش مصنوعی مولد بسیار مهم است. این سیستم ها در خط مقدم برنامه های مدرن هوش مصنوعی قرار دارند و قادر به تولید متن، تصاویر و غیره شبیه انسان هستند. در این مقاله، جنبه های فنی ساخت چنین پلتفرمی را با تمرکز بر اجزای کلیدی و اجرای آنها بررسی خواهیم کرد.

مروری بر #معماری

یک پلتفرم هوش مصنوعی مولد معمولاً از چندین مؤلفه به هم پیوسته تشکیل شده است:

لایه ارکستراسیون

ماژول ساخت زمینه

گاردریل ورودی/خروجی

دروازه مدل

سیستم ذخیره سازی

Action Handlers (فقط خواندنی و نوشتاری)

لایه پایگاه داده

پشته مشاهده پذیری

بیایید به هر یک از این مؤلفه ها بپردازیم و پیاده سازی فنی آنها را مورد بحث قرار دهیم.

#1. لایه ارکستراسیون

لایه ارکستراسیون مغز عملیات است. این معمولاً به عنوان یک سیستم توزیع شده با استفاده از فناوری هایی مانند Apache Airflow یا Kubernetes پیاده سازی می شود.

from airflow import DAG

from airflow.operators.python_operator import PythonOperator

def process_query(query):

# Implement query processing logic

pass

def generate_response(context):

# Implement response generation logic

pass

with DAG('ai_platform_workflow', default_args=default_args, schedule_interval=None) as dag:

process_task = PythonOperator(

task_id='process_query',

python_callable=process_query,

op_kwargs={'query': '{{ dag_run.conf["query"] }}'}

)

generate_task = PythonOperator(

task_id='generate_response',

python_callable=generate_response,

op_kwargs={'context': '{{ ti.xcom_pull(task_ids="process_query") }}'}

)

process_task >> generate_task

این DAG یک گردش کار ساده را برای پردازش یک پرس و جو و ایجاد یک پاسخ تعریف می کند.

#2. ماژول ساخت زمینه

ماژول ساخت زمینه اغلب از تکنیک هایی مانند RAG (Retrieval-Augmented Generation) و بازنویسی پرس و جو استفاده می کند. در اینجا یک پیاده سازی ساده با استفاده از کتابخانه langchain آورده شده است:

from langchain import PromptTemplate, LLMChain

from langchain.llms import OpenAI

from langchain.retrievers import ElasticSearchBM25Retriever

# Initialize retriever

retriever = ElasticSearchBM25Retriever(es_url="http://localhost:9200", index_name="documents")

# Define prompt template

template = """

Context: {context}

Query: {query}

Generate a response based on the above context and query.

"""

prompt = PromptTemplate(template=template, input_variables=["context", "query"])

# Initialize LLM

llm = OpenAI()

llm_chain = LLMChain(prompt=prompt, llm=llm)

def enhance_context(query):

relevant_docs = retriever.get_relevant_documents(query)

context = "\n".join([doc.page_content for doc in relevant_docs])

return llm_chain.run(context=context, query=query)

این قطعه کد نحوه استفاده از RAG را برای بهبود زمینه یک پرس و جو قبل از ارسال آن به مدل زبان نشان می دهد.

#3. گاردریل ورودی/خروجی

اجرای نرده محافظ شامل ایجاد فیلترهایی برای ورودی و خروجی است. در اینجا یک مثال اساسی است:

import re

def input_filter(query):

# Remove potential SQL injection attempts

query = re.sub(r'\b(UNION|SELECT|FROM|WHERE)\b', '', query, flags=re.IGNORECASE)

# Remove any non-alphanumeric characters except spaces

query = re.sub(r'[^\w\s]', '', query)

return query

def output_filter(response):

# Remove any potential harmful content

harmful_words = ['exploit', 'hack', 'steal']

for word in harmful_words:

response = re.sub(r'\b' + word + r'\b', '[REDACTED]', response, flags=re.IGNORECASE)

return response

این توابع فیلتر اولیه را برای پرس و جوهای ورودی و پاسخ های خروجی فراهم می کنند.

#4. دروازه مدل

دروازه مدل دسترسی به مدل های مختلف هوش مصنوعی را مدیریت می کند. در اینجا یک پیاده سازی ساده وجود دارد:

class ModelGateway:

def __init__(self):

self.models = {}

self.token_usage = {}

def register_model(self, model_name, model_instance):

self.models[model_name] = model_instance

self.token_usage[model_name] = 0

def get_model(self, model_name):

return self.models.get(model_name)

def generate(self, model_name, prompt):

model = self.get_model(model_name)

if not model:

raise ValueError(f"Model {model_name} not found")

response = model.generate(prompt)

self.token_usage[model_name] += len(prompt.split())

return response

gateway = ModelGateway()

gateway.register_model("gpt-3", OpenAIModel())

gateway.register_model("t5", T5Model())

این دروازه امکان ثبت چندین مدل را فراهم می کند و میزان استفاده از رمز را پیگیری می کند.

#5. سیستم ذخیره سازی

پیاده سازی یک سیستم کش می تواند عملکرد را به میزان قابل توجهی بهبود بخشد. در اینجا یک حافظه پنهان معنایی اولیه وجود دارد:

import faiss

import numpy as np

class SemanticCache:

def __init__(self, dimension):

self.index = faiss.IndexFlatL2(dimension)

self.responses = []

def add(self, query_vector, response):

self.index.add(np.array([query_vector]))

self.responses.append(response)

def search(self, query_vector, threshold):

D, I = self.index.search(np.array([query_vector]), 1)

if D[0][0]

این حافظه پنهان از FAISS برای جستجوی شباهت کارآمد در جاسازیهای پرس و جو استفاده میکند.

#6. اکشن هندلرها

Action handler منطق کسب و کار را برای عملیات های مختلف پیاده سازی می کند:

“` Class ReadOnlyActions:

@staticmethod

def vector_search (پرس و جو، فهرست):

# منطق جستجوی برداری را پیاده سازی کنید

عبور کند

@staticmethod

def sql_query(query, database):

# Implement SQL query logic

pass

کلاس WriteActions:

@staticmethod

def update_database (داده، پایگاه داده):

# منطق به روز رسانی پایگاه داده را پیاده سازی کنید

عبور کند

@staticmethod

def send_email(recipient, content):

# Implement email sending logic

pass

These classes provide a framework for implementing various actions that the AI platform might need to perform.

**#7. Database Layer**

The database layer typically involves multiple types of databases:

از pymongo import MongoClient

از واردات elasticsearch Elasticsearch

mongo_client = MongoClient('mongodb://localhost:27017/')

doc_store = mongo_client[‘ai_platform’][‘documents’]

es_client = Elasticsearch([{‘host’: ‘localhost’, ‘port’: 9200}])

vector_index = 'جاسازی ها'

واردات sqlite3

conn = sqlite3.connect('platform.db')

This setup includes MongoDB for document storage, Elasticsearch for vector search, and SQLite for relational data.

**#8. Observability Stack**

Implementing proper observability is crucial for maintaining and improving the platform:

```import logging

from prometheus_client import Counter, Histogram

# Logging

logging.basicConfig(level=logging.INFO)

logger = logging.getLogger(__name__)

# Metrics

request_counter = Counter('ai_platform_requests_total', 'Total number of requests')

latency_histogram = Histogram('ai_platform_request_latency_seconds', 'Request latency in seconds')

# Example usage

@latency_histogram.time()

def process_request(request):

request_counter.inc()

logger.info(f"Processing request: {request}")

# Process the request

pass

این تنظیم شامل ثبت اولیه و معیارهای Prometheus برای نظارت بر تعداد درخواست ها و تأخیرها است.

#نتیجه گیری

ساختن یک پلتفرم هوش مصنوعی مولد یک کار پیچیده است که نیازمند ادغام دقیق چندین مؤلفه است. هر بخش از سیستم نقش مهمی در ارائه محتوای دقیق، کارآمد و ایمن تولید شده توسط هوش مصنوعی ایفا می کند. همانطور که پلتفرم هوش مصنوعی خود را توسعه می دهید، به یاد داشته باشید که این معماری فقط یک نقطه شروع است. شما باید آن را بر اساس نیازهای خاص و موارد استفاده خود تطبیق داده و گسترش دهید.

حوزه هوش مصنوعی به سرعت در حال پیشرفت است و بهروز ماندن با آخرین پیشرفتها بسیار مهم است. به آزمایش، یادگیری، و فشار دادن به مرزهای ممکن با هوش مصنوعی مولد ادامه دهید!