چگونه شورش های جناحی را در Frostpunk 2 متوقف کنیم

Summarize this content to 400 words in Persian Lang

فراستپانک 2 می تواند یک تجربه گیم پلی وحشیانه، مدیریت بقا و همچنین مسائل پیچیده اجتماعی و سیاسی باشد. با این دنباله (در میان دمای بسیار زیر صفر و منابع کمیاب)، خواهید آموخت که خطرناک ترین چیزی که در دنیای پسا آخرالزمانی با آن روبرو خواهید شد، همنوعان خود هستند.

البته، بشر در شرایط مناسب می تواند به همان اندازه که یک تهدید باشد، موهبت باشد. در اینجا، فقط یک تظاهرات یا یک شورش در نیو لندن میتواند تنها چیزی باشد که جزر و مد یک تجربه بسیار موفق – یا بسیار سربالایی – را تغییر میدهد. با این حال، راه اندازی آنها کمی پیچیده تر از آن چیزی است که فکر می کنید.

تجمعات و شورش ها چیست؟

تجمعات و شورش ها نتیجه مستقیم شور و روابط است بین شما و جناح ها و جناح ها با یکدیگر.

تجمعات ناشی از افزایش شور و شوق و روابط مثبت بین شما و یک جناح شورش ها ناشی از افزایش شور و اشتیاق و روابط منفی (چه با شما و چه با جناح های دیگر).

در داستان اصلی، تنها دو جناح هستند که می توانند تجمع و شورش برپا کنند. این دو گروهی هستند که در وسط نوار روابط شما قرار می گیرند و این تنها گروه هایی هستند که شور و حرارت آنها را می توان مشاهده کرد. به عنوان مثال، اگر شما یک مسیر ایمانی را بازی کنید، این گروه ها حافظان ایمان و تکامل کنندگان خواهند بود. به همین ترتیب، یک مسیر Order دارای استالوارت ها و زائران خواهد بود.

شما قادر خواهید بود با نگاه کردن به مشت های قرمز، شور و حرارت یک گروه را مشخص کنید روی نماد یک گروه به تصویر کشیده شده است. با افزایش شور و شوق، احتمال انجام یک تجمع یا شورش (بسته به روابطشان) افزایش می یابد.

شما می توانید با نواری که در زیر تصویر آیکون آنها قرار دارد، علاقه یک گروه را نسبت به خود تعیین کنید.

کوتاه و قرمز به معنای نامطلوب یا خصمانه. سفید و نیمه راه کامل نشان می دهد بی طرفی. طلا و کامل (نیم دایره) نشان می دهد روابط خوب.

شما می توانید با وعده های شکسته یا عملی شده، با تأمین مالی تحقیقات آنها یا درخواست پول مالیات بیشتر، یا با ترویج یا محکوم کردن آنها، بر روابط تأثیر بگذارید. برخی رویدادهای داستانی همیشه بر شور و شوق یک جناح تأثیر میگذارند (مثلاً انتخاب فراست یا شکست دادن فراست).

رالی چه مزایایی دارد؟

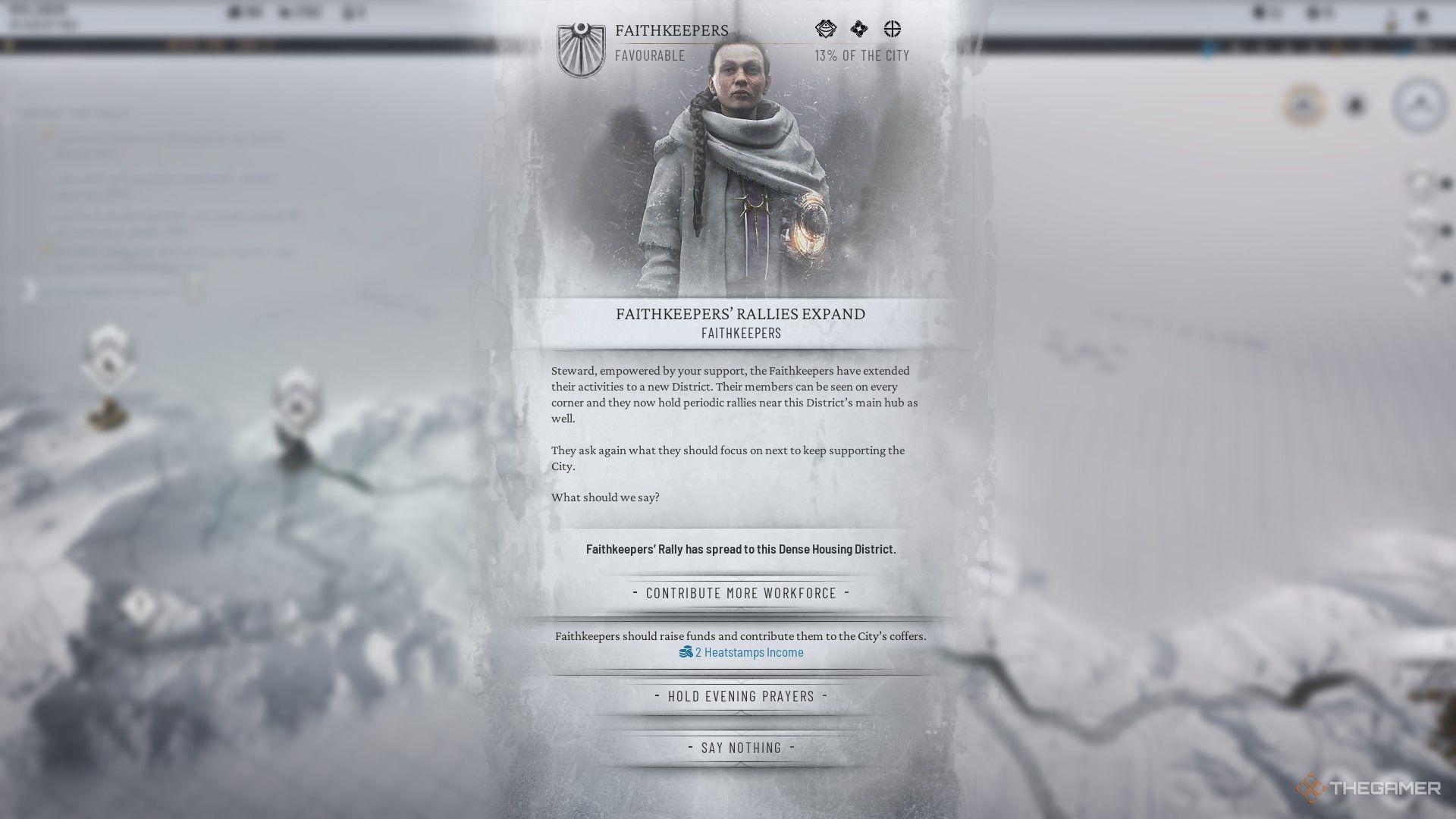

وقتی جناحی شما را به اندازه کافی دوست دارد یا شور و اشتیاق کافی دارد، ممکن است شروع به تجمع کنند. این رالی میتواند بین مناطق (معمولاً در محلههای مسکونی در ابتدا) با ادامه تجمع یا با افزایش شور و حرارت گسترش یابد.

با شروع یک تجمع، بسته به اینکه گروه چقدر شما را دوست دارد، می توانید مزایای زیر را از یک رالی بخواهید:

برای آن جناح بیشتر جذب کنید درآمد اضافی Heat Token یا یک اقدام ویژه درجه سوم (وابسته به گروه)

هشدار داده شود که گاهی تجمعات می تواند تنش را با گروه مخالف خود افزایش دهد. به عنوان مثال، مبارزات پرشور استالوارت ها ممکن است باعث روابط منفی با زائران شود. برخی اعتراضات ممکن است فعالانه تلاش کنند تا تجمعات جاری را به هم بزنند و در نتیجه تنش بیشتری ایجاد کنند.

تجمعات طولانی همیشه سودمند نیستند اگر تنشها بین گروههای شما در حال افزایش است و یا اگر نمیخواهید شور و حرارت جناح تجمع کننده یا مخالف آن را افزایش دهید.

علاوه بر افزایش تنش، تجمعهای طولانیتر میتوانند نسبت افراد در هر گروه را تغییر دهند. بسته به اینکه میخواهید بازیتان چگونه انجام شود، ممکن است نخواهید تعداد گروههای متشکل از تظاهرات به نقطهای از افراطگرایی و تسلط بالقوه افزایش یابد.

با این حال، اگر به مزایای رالی نیاز دارید یا می توانید تنش گروه مقابل را کنترل کنید، تجمعات قابل تمدید است اگر لطف یک جناح به شما با قدرت ادامه یابد. اگر رابطه آنها از منطقه طلایی برای سفیدی خنثی تر خارج شود، آنها به پایان خواهند رسید.

به نظر می رسد که اگر یک تجمع گسترده شود،

شما همچنان از مزایای اولین انتخابی که انجام دادید بهره خواهید برد و در عین حال از مزایای رالی گسترده نیز بهره مند خواهید شد

به عنوان یک جایزه اضافه شده بنابراین، اگر Heatstamps را به عنوان اولین رالی منطقه خود انتخاب کنید، و Recruit را برای رالی گسترده انتخاب کنید، هر دو مزیت را خواهید دید. در عوض، اگر Heatstamps را برای هر دو انتخاب کنید، از مزایای x2 برخوردار خواهید شد.

اگر یک جناح شورش کند چه اتفاقی می افتد؟

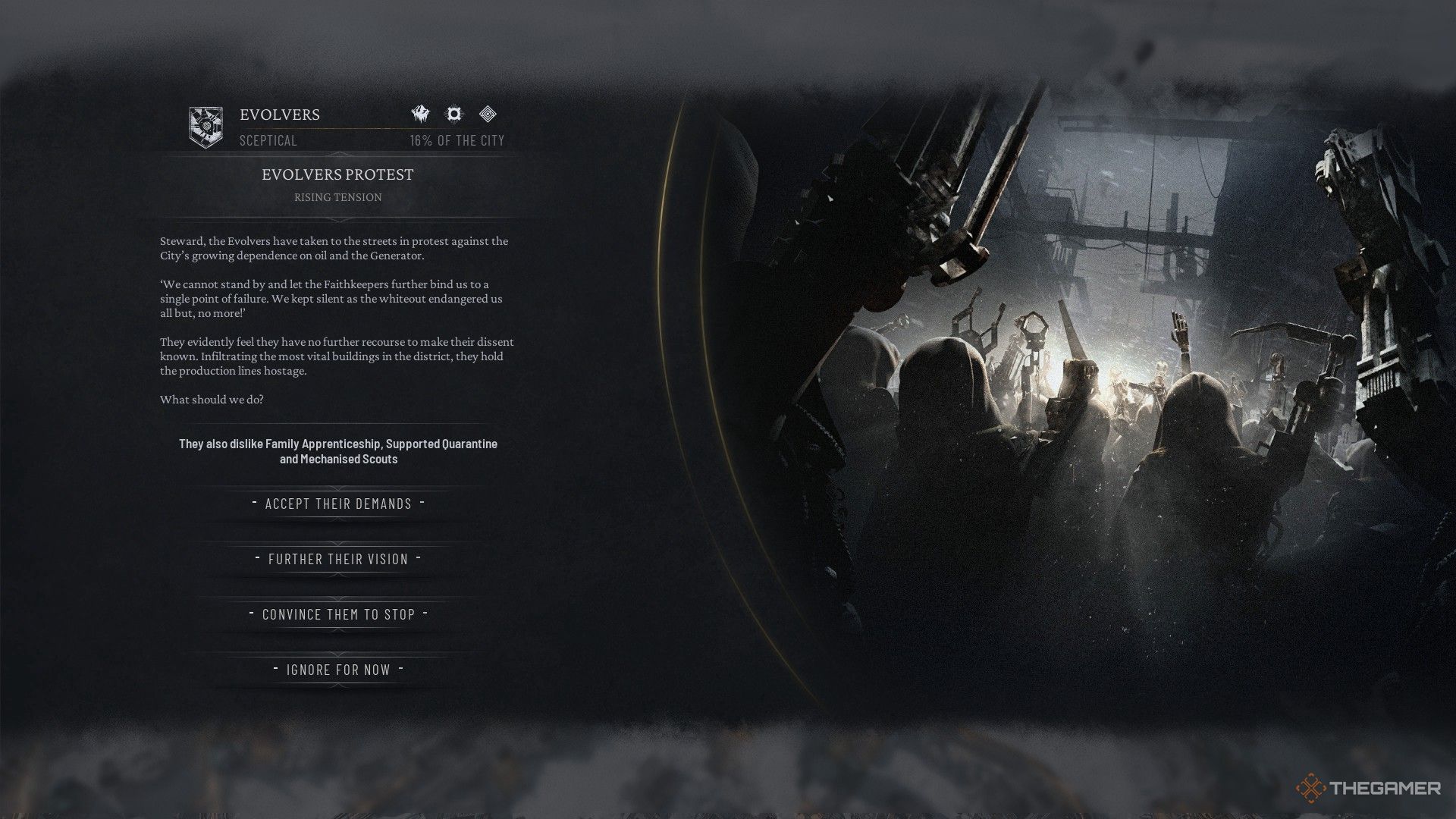

شورشهای جناحی زمانی اتفاق میافتند که شور و شوق هر سازمان مطابق با روابط ضعیف افزایش یابد (به عبارت دیگر: آنها با شور زیاد، روابط کم تحریک میشوند). با این حال، شورش ها به عنوان شورش کامل شروع نمی شوند.

بلکه شورش ها ابتدا با اعتراضات ملایم تر شروع می شوند و با ادامه روابط ضعیف به تدریج به یک شورش کامل تبدیل خواهد شد. شما یک را خواهید دید نشانه برای تدارک اعتراض در نوار وضعیت یک جناح، به شما فرصت می دهد تا قبل از تبدیل شدن به یک مشکل آن را خاموش کنید.

در حالت Story، شورش و اعتراض یک عمل قفل شده است که تا زمانی که به فصل سوم نرسیده باشید، اتفاق نمی افتد. سعی کنید تا بعداً (خدا را شکر!) تحت هیچ شرایطی نمی توانید اعتراض یا شورش را راه بیندازید.

اگر نتوانید یک اعتراض را قبل از شروع آن سرکوب کنید، این فرصت را خواهید داشت با تحقق بخشی از خواسته های خود، اعتراض را متوقف کنند. به طور کلی، شما معمولاً این گزینه ها را خواهید داشت:

لغو قوانین که جناح دوست نداشتن گذشتن در مورد چندین مورد تحقیق کنید به انتخاب آنها با یک استراتژی از خودتان بیایید اعتماد آنها را افزایش دهد (مانند تامین مالی پروژه های خود)

اگر دارید

روابط قوی

با مخالفت مستقیم جناح معترض، ممکن است

پایان دادن به اعتراضات

برای شما بدون نیاز به هیچ اقدامی

این می تواند راه خوبی برای توقف زودهنگام اعتراضات باشد، اما اگر شور و روابط بد با جناح مخالف ادامه پیدا کند، اعتراض در جای دیگری از نو آغاز خواهد شد. هنوز هم توصیه می شود

سعی کنید نگرانی ها را کاهش دهید

از جناح های معترض به جای اینکه اجازه دهید متحدانتان به جای شما آنها را مورد خطاب قرار دهند.

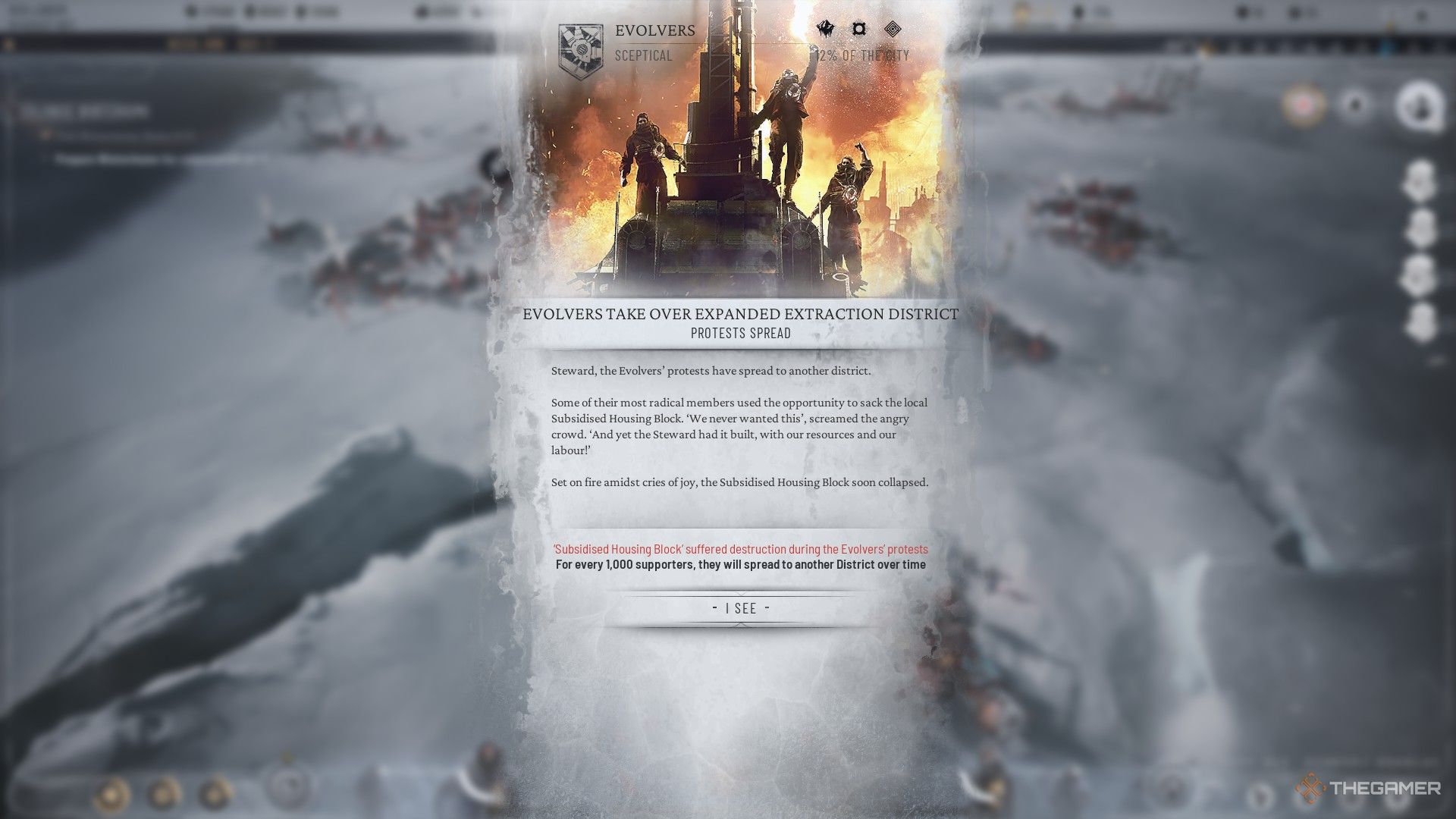

اگر به موقع اعتراضی را سرکوب نکنید، شروع به گسترش به سایر ولسوالی ها خواهد کرد. اعتراضات خفیف شروع می شود، اما آنها شامل نگرانی های زیر هستند و می توانند به آنها تبدیل شوند:

کمبود نیروی کار و کاهش بهره وری تعطیلی اجباری کل ولسوالی ها افراد مجروح (اعتراضات) یا حتی قتل (شورش) تخریب دائمی ولسوالی ها افزایش تنش با جناح های رقیب، احتمالاً جناح دیگری از اعتراضات را ایجاد می کند

در طول فصل سوم، شما

توانایی حذف را بدست آورید

یا

آشتی دادن

الف

شورش

جناح

.

این زمانی اتفاق می افتد که شما وظیفه دارید

پیدا کردن وینترهوم

یک بار دیگر وقتی کلنی ایجاد شد، چند انتخاب به شما داده می شود. این انتخاب ها شامل خواهد شد

حذف اجباری آشوبگران

به وینترهوم،

آشتی دادن آنها

با جناح مخالف خود، یا تبدیل شدن به یک رهبر آهنین بر سر لندن جدید. مهم نیست که انتخاب کنید، شما این توانایی را خواهید داشت

یا تمبر

یا

آشتی دادن

شما

جناح آشوبگر

.

اگر شورش های زیادی داشته باشید، قابل درک است که تنش شما به نقطه شکست می رسد. گذراندن بیش از حد طولانی در این ایالت ممکن است باعث شود که جناح ها به برکناری شما از سمت خود رأی دهند و تبعید بعدی (بازی خودکار).

اگر با شورش های زیاد مشکل دارید، اقدامات زیر را در نظر بگیرید:

در نظر بگیرید که به آنها مهر گرمایی بدهید پروژه های خود را تامین مالی کنند. یک جناح را تبلیغ کنید قدرت خود را در مجلس افزایش دهند. برج های نگهبانی، زندان ها و سایر روش های اجرای قانون را نصب کنید برای مبارزه با شور و جنایت امضا کنید (به هر طریقی) یک “قاعده” در قوانین مجلس، قدرت خود را برای تسلط بهتر بر شهروندان خود گسترش دهید.

فراستپانک 2 می تواند یک تجربه گیم پلی وحشیانه، مدیریت بقا و همچنین مسائل پیچیده اجتماعی و سیاسی باشد. با این دنباله (در میان دمای بسیار زیر صفر و منابع کمیاب)، خواهید آموخت که خطرناک ترین چیزی که در دنیای پسا آخرالزمانی با آن روبرو خواهید شد، همنوعان خود هستند.

البته، بشر در شرایط مناسب می تواند به همان اندازه که یک تهدید باشد، موهبت باشد. در اینجا، فقط یک تظاهرات یا یک شورش در نیو لندن میتواند تنها چیزی باشد که جزر و مد یک تجربه بسیار موفق – یا بسیار سربالایی – را تغییر میدهد. با این حال، راه اندازی آنها کمی پیچیده تر از آن چیزی است که فکر می کنید.

تجمعات و شورش ها چیست؟

تجمعات و شورش ها نتیجه مستقیم شور و روابط است بین شما و جناح ها و جناح ها با یکدیگر.

- تجمعات ناشی از افزایش شور و شوق و روابط مثبت بین شما و یک جناح

- شورش ها ناشی از افزایش شور و اشتیاق و روابط منفی (چه با شما و چه با جناح های دیگر).

در داستان اصلی، تنها دو جناح هستند که می توانند تجمع و شورش برپا کنند. این دو گروهی هستند که در وسط نوار روابط شما قرار می گیرند و این تنها گروه هایی هستند که شور و حرارت آنها را می توان مشاهده کرد. به عنوان مثال، اگر شما یک مسیر ایمانی را بازی کنید، این گروه ها حافظان ایمان و تکامل کنندگان خواهند بود. به همین ترتیب، یک مسیر Order دارای استالوارت ها و زائران خواهد بود.

شما قادر خواهید بود با نگاه کردن به مشت های قرمز، شور و حرارت یک گروه را مشخص کنید روی نماد یک گروه به تصویر کشیده شده است. با افزایش شور و شوق، احتمال انجام یک تجمع یا شورش (بسته به روابطشان) افزایش می یابد.

شما می توانید با نواری که در زیر تصویر آیکون آنها قرار دارد، علاقه یک گروه را نسبت به خود تعیین کنید.

- کوتاه و قرمز به معنای نامطلوب یا خصمانه.

- سفید و نیمه راه کامل نشان می دهد بی طرفی.

- طلا و کامل (نیم دایره) نشان می دهد روابط خوب.

شما می توانید با وعده های شکسته یا عملی شده، با تأمین مالی تحقیقات آنها یا درخواست پول مالیات بیشتر، یا با ترویج یا محکوم کردن آنها، بر روابط تأثیر بگذارید. برخی رویدادهای داستانی همیشه بر شور و شوق یک جناح تأثیر میگذارند (مثلاً انتخاب فراست یا شکست دادن فراست).

رالی چه مزایایی دارد؟

وقتی جناحی شما را به اندازه کافی دوست دارد یا شور و اشتیاق کافی دارد، ممکن است شروع به تجمع کنند. این رالی میتواند بین مناطق (معمولاً در محلههای مسکونی در ابتدا) با ادامه تجمع یا با افزایش شور و حرارت گسترش یابد.

با شروع یک تجمع، بسته به اینکه گروه چقدر شما را دوست دارد، می توانید مزایای زیر را از یک رالی بخواهید:

- برای آن جناح بیشتر جذب کنید

- درآمد اضافی Heat Token

- یا یک اقدام ویژه درجه سوم (وابسته به گروه)

هشدار داده شود که گاهی تجمعات می تواند تنش را با گروه مخالف خود افزایش دهد. به عنوان مثال، مبارزات پرشور استالوارت ها ممکن است باعث روابط منفی با زائران شود. برخی اعتراضات ممکن است فعالانه تلاش کنند تا تجمعات جاری را به هم بزنند و در نتیجه تنش بیشتری ایجاد کنند.

تجمعات طولانی همیشه سودمند نیستند اگر تنشها بین گروههای شما در حال افزایش است و یا اگر نمیخواهید شور و حرارت جناح تجمع کننده یا مخالف آن را افزایش دهید.

علاوه بر افزایش تنش، تجمعهای طولانیتر میتوانند نسبت افراد در هر گروه را تغییر دهند. بسته به اینکه میخواهید بازیتان چگونه انجام شود، ممکن است نخواهید تعداد گروههای متشکل از تظاهرات به نقطهای از افراطگرایی و تسلط بالقوه افزایش یابد.

با این حال، اگر به مزایای رالی نیاز دارید یا می توانید تنش گروه مقابل را کنترل کنید، تجمعات قابل تمدید است اگر لطف یک جناح به شما با قدرت ادامه یابد. اگر رابطه آنها از منطقه طلایی برای سفیدی خنثی تر خارج شود، آنها به پایان خواهند رسید.

به نظر می رسد که اگر یک تجمع گسترده شود،

شما همچنان از مزایای اولین انتخابی که انجام دادید بهره خواهید برد و در عین حال از مزایای رالی گسترده نیز بهره مند خواهید شد

به عنوان یک جایزه اضافه شده بنابراین، اگر Heatstamps را به عنوان اولین رالی منطقه خود انتخاب کنید، و Recruit را برای رالی گسترده انتخاب کنید، هر دو مزیت را خواهید دید. در عوض، اگر Heatstamps را برای هر دو انتخاب کنید، از مزایای x2 برخوردار خواهید شد.

اگر یک جناح شورش کند چه اتفاقی می افتد؟

شورشهای جناحی زمانی اتفاق میافتند که شور و شوق هر سازمان مطابق با روابط ضعیف افزایش یابد (به عبارت دیگر: آنها با شور زیاد، روابط کم تحریک میشوند). با این حال، شورش ها به عنوان شورش کامل شروع نمی شوند.

بلکه شورش ها ابتدا با اعتراضات ملایم تر شروع می شوند و با ادامه روابط ضعیف به تدریج به یک شورش کامل تبدیل خواهد شد. شما یک را خواهید دید نشانه برای تدارک اعتراض در نوار وضعیت یک جناح، به شما فرصت می دهد تا قبل از تبدیل شدن به یک مشکل آن را خاموش کنید.

در حالت Story، شورش و اعتراض یک عمل قفل شده است که تا زمانی که به فصل سوم نرسیده باشید، اتفاق نمی افتد. سعی کنید تا بعداً (خدا را شکر!) تحت هیچ شرایطی نمی توانید اعتراض یا شورش را راه بیندازید.

اگر نتوانید یک اعتراض را قبل از شروع آن سرکوب کنید، این فرصت را خواهید داشت با تحقق بخشی از خواسته های خود، اعتراض را متوقف کنند. به طور کلی، شما معمولاً این گزینه ها را خواهید داشت:

- لغو قوانین که جناح دوست نداشتن گذشتن

- در مورد چندین مورد تحقیق کنید به انتخاب آنها

- با یک استراتژی از خودتان بیایید اعتماد آنها را افزایش دهد (مانند تامین مالی پروژه های خود)

اگر دارید

روابط قوی

با مخالفت مستقیم جناح معترض، ممکن است

پایان دادن به اعتراضات

برای شما بدون نیاز به هیچ اقدامی

این می تواند راه خوبی برای توقف زودهنگام اعتراضات باشد، اما اگر شور و روابط بد با جناح مخالف ادامه پیدا کند، اعتراض در جای دیگری از نو آغاز خواهد شد. هنوز هم توصیه می شود

سعی کنید نگرانی ها را کاهش دهید

از جناح های معترض به جای اینکه اجازه دهید متحدانتان به جای شما آنها را مورد خطاب قرار دهند.

اگر به موقع اعتراضی را سرکوب نکنید، شروع به گسترش به سایر ولسوالی ها خواهد کرد. اعتراضات خفیف شروع می شود، اما آنها شامل نگرانی های زیر هستند و می توانند به آنها تبدیل شوند:

- کمبود نیروی کار و کاهش بهره وری

- تعطیلی اجباری کل ولسوالی ها

- افراد مجروح (اعتراضات) یا حتی قتل (شورش)

- تخریب دائمی ولسوالی ها

- افزایش تنش با جناح های رقیب، احتمالاً جناح دیگری از اعتراضات را ایجاد می کند

اگر شورش های زیادی داشته باشید، قابل درک است که تنش شما به نقطه شکست می رسد. گذراندن بیش از حد طولانی در این ایالت ممکن است باعث شود که جناح ها به برکناری شما از سمت خود رأی دهند و تبعید بعدی (بازی خودکار).

اگر با شورش های زیاد مشکل دارید، اقدامات زیر را در نظر بگیرید:

- در نظر بگیرید که به آنها مهر گرمایی بدهید پروژه های خود را تامین مالی کنند.

- یک جناح را تبلیغ کنید قدرت خود را در مجلس افزایش دهند.

- برج های نگهبانی، زندان ها و سایر روش های اجرای قانون را نصب کنید برای مبارزه با شور و جنایت

- امضا کنید (به هر طریقی) یک “قاعده” در قوانین مجلس، قدرت خود را برای تسلط بهتر بر شهروندان خود گسترش دهید.