راهنمای درک قطعی فرآیند ETL در مهندسی داده

Proceso de ETL (Extract, Transform, Load)

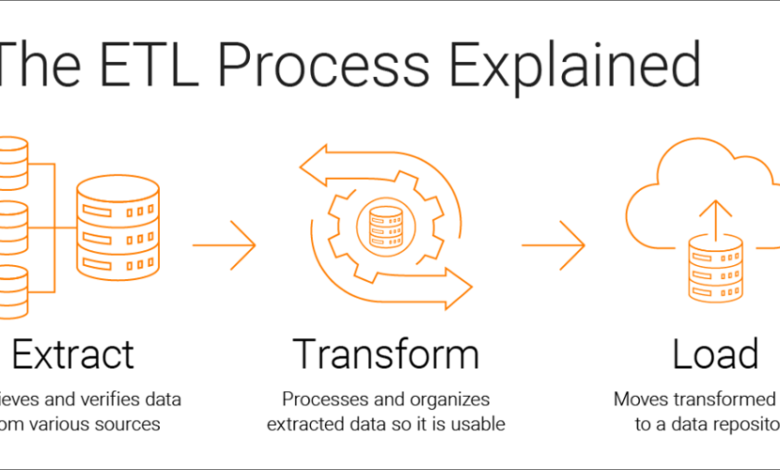

فرآیند ETL (Extract, Transform, Load) در یکپارچه سازی داده ها اساسی است و برای انتقال و تبدیل داده ها از منابع متعدد به یک سیستم ذخیره سازی داده مانند انبار داده استفاده می شود. هر مرحله از فرآیند ETL در زیر توضیح داده شده است:

1. استخراج (عصاره)

مرحله استخراج شامل به دست آوردن داده ها از منابع مختلف داده است. این منابع می توانند پایگاه داده ها، فایل های مسطح، API ها و غیره باشند. هدف جمع آوری تمام داده های لازم برای تجزیه و تحلیل است.

مثال:

import pandas as pd

# Extracción de datos desde una base de datos SQL

import sqlalchemy

engine = sqlalchemy.create_engine('mysql+pymysql://user:password@host/dbname')

df = pd.read_sql('SELECT * FROM tabla_origen', engine)

# Extracción de datos desde un archivo CSV

df_csv = pd.read_csv('ruta/al/archivo.csv')

2. دگرگونی

در مرحله تبدیل، داده های استخراج شده تمیز، یکپارچه و تبدیل می شوند تا با فرمت مورد نیاز سیستم هدف مطابقت داشته باشند. این ممکن است شامل deduplication، تبدیل نوع داده، عادی سازی، تجمیع و غیره باشد.

مثال:

# Limpieza de datos

df.dropna(inplace=True) # Eliminar filas con valores nulos

df['columna'] = df['columna'].astype(int) # Convertir tipo de datos

# Integración de datos

df_combined = pd.concat([df, df_csv], ignore_index=True)

# Transformación de datos

df_combined['nueva_columna'] = df_combined['columna1'] + df_combined['columna2']

3. بارگذاری کنید

مرحله بارگذاری شامل انتقال داده های تبدیل شده به سیستم ذخیره سازی مقصد، مانند انبار داده یا پایگاه داده تحلیلی است. این مرحله ممکن است شامل درج داده ها در جداول، به روز رسانی رکوردهای موجود و غیره باشد.

مثال:

# Carga de datos a una base de datos SQL

df_combined.to_sql('tabla_destino', engine, if_exists='replace', index=False)

ابزارهای ETL

ابزارهای مختلفی وجود دارد که فرآیند ETL را تسهیل می کند، برخی از محبوب ترین آنها عبارتند از:

- Databricks: بستری برای اجرای کد که امکان پردازش داده ها را فراهم می کند.

- آپاچی نی فای: ابزار یکپارچه سازی داده ها در زمان واقعی.

- استعداد: پلت فرم یکپارچه سازی داده ها که راه حل های ETL را ارائه می دهد.

- چسب AWS: سرویس ETL کاملاً مدیریت شده در ابر AWS.

- جریان هوای آپاچی: پلت فرم برنامه نویسی گردش کار که می تواند برای هماهنگی فرآیندهای ETL استفاده شود.

- کارخانه داده: هماهنگ کننده فرآیند داده (دریافت، تبدیل و سرویس)

نتیجه گیری

فرآیند ETL برای یکپارچه سازی و تجزیه و تحلیل داده ها ضروری است و به داده های خام اجازه می دهد تا به اطلاعات ارزشمند برای تصمیم گیری تبدیل شوند. با ابزار مناسب و پیاده سازی مناسب، فرآیند ETL می تواند کارآمد و مقیاس پذیر باشد.