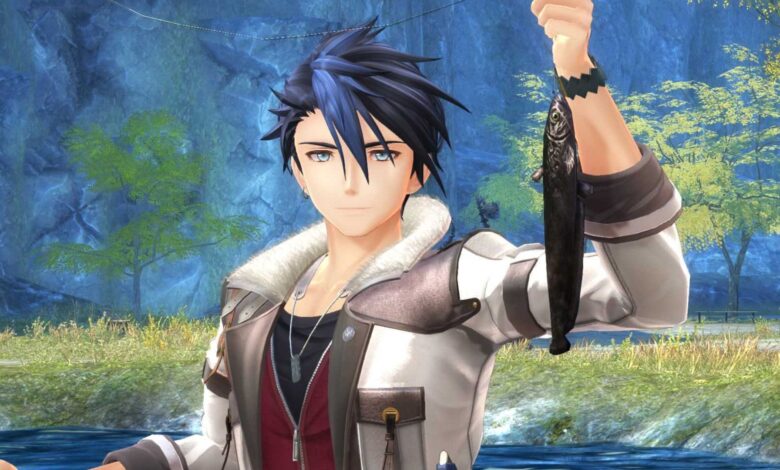

چگونه می توان هر ماهی را در مسیرهای پیاده روی از طریق Daybreak 2 گرفت

سریال Trails همیشه چیزی برای ماهیگیری داشته است ، و اگرچه دیدن مینیگیم که در مسیرهای پیاده روی در طول روز از بین رفته است ناامید کننده بود ، خوشبختانه بازگشت دیدنی در دنباله را به خود اختصاص داده است. مسیرهای پیاده روی از طریق Daybreak 2 اکنون اجازه می دهد ون یک میله را به نزدیکترین بدن آب ریخته تا تمام ماهی های کوچک (و بسیار بزرگ) را در داخل بگیرد.

مربوط

مسیرهای پیاده روی از طریق بررسی Daybreak 2 – دنباله ای که واقعاً ارزش دنبال کردن ندارد

مسیرهای پیاده روی از طریق Daybreak 2 چندین پیشرفت گسترده دارند ، اما یک داستان بی پروا با سفر زمانی ضعیف اجرا شده ، توصیه را دشوار می کند.

ماهی های زیادی برای گرفتن وجود دارد ، با پاداش مناسب برای گرفتن همه آنها، همراه با منابعی مانند سپتیت و کوارتز برای وارد کردن حمل و نقل بزرگ. در اینجا راهنمای یک مرحله ای شما برای همه چیز ماهیگیری و اینکه چگونه می توانید در بزرگترین آنها حلقه کنید.

از کجا طعمه بگیرید و میله خود را ارتقا دهید

درست مثل اینکه یک کارگر فقط به اندازه ابزار خود خوب است ، یک ماهیگیر فقط به اندازه میله خود خوب است. مسیرهای پیاده روی از طریق Daybreak 2 به شما یک میله آزاد می دهد تا از آن شروع کنید ، اما شما مسئولیت نگهداری آن را بر عهده دارید. در طول بازی می توانید ارتقاء های مختلفی را به میله خود انجام دهید، اگر می خواهید ماهی های بزرگی را فرود بیاورید ، باید انجام دهید.

در طول بازی چندین مغازه وجود دارد که تجهیزات ماهیگیری و طعمه را می فروشند ، اما موارد بهتر فقط بیشتر در حال پیشرفت در داستان هستندبشر در زیر لیستی از تمام تجهیزات ماهیگیری که می توانید خریداری کنید پیدا خواهید کرد و وقتی داستان برای خرید در دسترس قرار می گیرد.

|

لوازم جانبی |

ذخیره |

محل |

اثر |

|

دستکش ماهیگیری |

لوازم ماهیگیری سرطانی – پیش نویس |

میانه |

به شما زمان بیشتری می دهد تا ماهی را قلاب کنید |

|

چنگک |

سوغات و کالاهای گرین – قانون 1 -A |

مسخره |

زاویه reeling میله خود را بزرگ می کند |

|

غلتک |

لوازم ماهیگیری سرطانی – قانون 1 -B |

میانه |

انقلاب نشانگر میله شما را تثبیت می کند |

|

دسته برق |

Liujin'an Goldfish & Tackle – ACT 2 -A |

Langport – سه ماهه دوم |

کشش موفقیت آمیز باعث افزایش فشار بیشتر شما می شود |

|

تیتانیوم قلاب |

Liujin'an Goldfish & Tackle – ACT 2 -A |

Langport – سه ماهه دوم |

شانس گرفتن یک ماهی بزرگ را افزایش می دهد |

|

خط کربن |

لوازم ماهیگیری سرطانی – قانون 2 -B |

میانه |

سرعت تخلیه سنج شما را کاهش می دهد |

|

قرقره ریسندگی |

لوازم ماهیگیری سرطانی – قطعات |

جزیره نمت |

انقلاب نشانگر میله شما را تثبیت می کند |

|

کمربند ماهیگیری |

لوازم ماهیگیری سرطانی – قطعات |

جزیره نمت |

به شما زمان بیشتری می دهد تا ماهی را قلاب کنید |

|

میله همه منظوره |

لوازم ماهیگیری سرطانی – قانون 3: مسیر A |

میانه |

زاویه reeling میله خود را بزرگ می کند |

|

فلاشابو |

لوازم ماهیگیری سرطانی – قانون 3: مسیر A |

میانه |

شانس گرفتن یک ماهی بزرگ را افزایش می دهد |

هر ماهی را از کجا پیدا کنیم

اکنون که کاملاً مجهز هستید ، وقت آن است که ماهی را بگیرید. شما قادر خواهید بود میله خود را تقریباً به هر بدن بزرگی از آب بریزید و برخی از ماهی ها را پیدا کنید ، و بسته به آنچه می کشید ، این می تواند به طعمه ای که استفاده می کنید بستگی داشته باشدبشر هر نوع طعمه ای را می توان برای گرفتن هر ماهی در Daybreak 2 استفاده کرد. بسته به طعمه شما ، احتمال ابتلا به ماهی های خاص افزایش می یابدبشر

از کوفته ها و کوفته های لوکس می توان برای گرفتن ماهی های بزرگ و نادر استفاده کرد ، اگرچه آگاه هستند که محدود هستند.

مکانهای نسبتاً واضحی وجود دارد که ماهی ها در کمین خواهند بود ، و بین بدن آب ، متقاطع زیادی وجود دارد اما برخی از ماهی ها در مناطق دزدکی پنهان شده اند که به راحتی می تواند شما را از کنار بگذارد. اینجا وجود دارد همه 28 گونه ماهی و جایی که می توانید آنها را بدست آورید.

|

ماهی |

محل |

عمل |

|---|---|---|

|

زحمت کشیدن |

کنار رودخانه |

پیش نویس |

|

کپور |

کنار رودخانه |

پیش نویس |

|

قزل آلا رنگین کمان |

کنار رودخانه |

پیش نویس |

|

خرچنگ برفی |

Messeldam – شمال سوغات و کالاهای گرین |

قانون 1-A |

|

رنگ قرمز |

Messeldam – شمال سوغات و کالاهای گرین |

قانون 1-A |

|

گیل |

Messeldam – شمال سوغات و کالاهای گرین |

قانون 1-A |

|

ببر |

LANGPORT: بخش دوم – در شمال Liujin'an Goldfish & Tackle |

قانون 2-A |

|

کپور نجیب |

LANGPORT: بخش دوم – در شمال Liujin'an Goldfish & Tackle |

قانون 2-A |

|

خرچنگ |

Langport: بخش دوم – گرفتن به عنوان بخشی از Langport Cook -Off 4SPG |

قانون 2-A |

|

مروارید |

کنار رودخانه |

عمل 2-b |

|

ماهی قزل آلا |

کنار رودخانه |

عمل 2-b |

|

پفکر |

کنار رودخانه |

عمل 2-b |

|

تئاتر |

کنار رودخانه |

عمل 2-b |

|

کپور Quicksilver |

جزیره نمت – نزدیک اسکله ها در نزدیکی هواپیما |

قطعات |

|

کوسه گلوتون |

جزیره نمت – نزدیک اسکله ها در نزدیکی هواپیما |

قطعات |

|

جنجال |

جزیره نمت – نزدیک اسکله ها در نزدیکی هواپیما |

قطعات |

|

دارایی |

جزیره نمت – نزدیک اسکله ها در نزدیکی هواپیما |

قطعات |

|

پفک دار |

جزیره نمت – نزدیک اسکله ها در نزدیکی هواپیما |

قطعات |

|

آبش |

جزیره نمت – نزدیک اسکله ها در نزدیکی هواپیما |

قطعات |

|

مارلین |

جزیره نمت – نزدیک اسکله ها در نزدیکی هواپیما |

قطعات |

|

بدبختی |

جزیره نمت – محل ماهیگیری از صخره ای در جنوب شرقی الج |

قطعات |

|

جرقه |

جزیره نمث – محل ماهیگیری در دریاچه نزدیک به ویرانه ها |

قطعات |

|

سکه مرمر |

جزیره نمث – محل ماهیگیری در دریاچه نزدیک به ویرانه ها |

قطعات |

|

کنگیرو |

پارک یادبود دیرک – در رودخانه در حدود نیمه راه |

قانون 3: مسیر a |

|

آروانا شمالی |

پارک یادبود دیرک – در رودخانه در حدود نیمه راه |

قانون 3: مسیر a |

|

لاسی |

منطقه بلک نور – محل ماهیگیری در زیر پله های جنوب نوار Beckon |

قانون 3: مسیر a |

|

ماه سفید |

Tyrell District (شب) – در چشمه بسیار کوچک در کنار رستوران شرقی Caiyunge |

قانون 3: مسیر D |

|

مگنا گارولز |

پارک یادبود دیرک – گرفتن به عنوان بخشی از ماهی افسانه 4Spg |

فینال |

نحوه گرفتن ماهی درجه A

سرانجام ، بیایید بیش از ماهی های درجه یک برویم. شما نه تنها به خاطر گرفتن یک دسته از ماهی های A-Rank از ورود به سیستم دستاورد خود پاداش می گیرید ، بلکه ماهی های درجه A نیز هستند با برخی از کوارتز های بسیار مفید نیز به شما پاداش دهیدبشر با این حال ، در واقع گرفتن آنها به آسانی نیست که فقط خط خود را به اقیانوس بپیچید و به بهترین ها امیدوار باشید.

ابتدا شما نیاز دارید نقاط ماهیگیری را پیدا کنید، که می توانید انجام دهید با استفاده از یک جستجوی ساده Shardبشر با مکان نما ماهیگیری خود روی محل حرکت کنید و خواهید دید که آیا یک ماهی این شانس را دارد که “گرفتن بزرگ” باشدبشر در این نقاط است که ماهی A-Rank خود را پیدا خواهید کرد ، اما به خاطر داشته باشید که هستید برای به دست آوردن میله خود بسیار لازم است تا آنها را به روز کنید، و آن اگر از طعمه گران تر استفاده کنید ، احتمال افزایش می یابدبشر

jrpg

عمل RPG

RPG

عمل

- عاری از

-

14 فوریه 2025

- ESRB

-

t برای نوجوا

- توسعه دهنده (ها)

-

Nihon Falcom ، PH3 GmbH