18 نکته YouTube برای رشد کانال خود در سال 2024

Summarize this content to 300 words in Persian Lang

یوتیوب است را به دو دلیل برای برندها و تولیدکنندگان مشتاق محتوا مناسب است: الف مخاطبان بالقوه عظیم و یکی از با ارزش ترین برنامه های کسب درآمد از محتوا از هر پلتفرم اجتماعی اگر میخواهید از این فرصتها استفاده کنید، به فهرست نکات برتر یوتیوب ما نیاز دارید.

به هر حال، یوتیوب دومین وب سایت پربازدید در جهان است و 83 درصد از بزرگسالان آمریکایی در این پلت فرم هستند. کاربران روزانه یک میلیارد ساعت محتوای ویدیویی را پخش می کنند. اما به دور از اشباع بیش از حد است. در واقع، هرگز زمان بهتری برای راه اندازی یک کانال یوتیوب وجود نداشته است.

این 18 نکته YouTube برای مبتدیان، سازندگان متوسط و متخصصان به شما کمک میکند تا بازدیدها را به دست آورید، مردم را تشویق به مشترک شدن در کانالتان کنید و از روز اول و بعد از آن رشد کنید.

به سمت راست به مرتبط ترین بخش بروید یا همین الان شروع به خواندن کنید!

بدست بیاور بسته رایگان 5 الگوی بنر قابل تنظیم YouTube اکنون. در زمان صرفه جویی کنید و حرفه ای به نظر برسید و در عین حال برند خود را به سبک تبلیغ کنید.

8 نکته YouTube برای مبتدیان

برای شروع آماده اید؟ این نکات مبتدی YouTube باعث می شود کانال خود را با پای راست راه اندازی کنید و آن را برای رشد و موفقیت تنظیم کنید.

1. نام کانال مناسب را انتخاب کنید

اولین کاری که باید انجام دهید این است که یک نام برای کانال YouTube خود انتخاب کنید. بهترین راه برای نشان دادن نوع محتوایی که قصد ایجاد آن را دارید چیست؟

نام کامل کانال یوتیوب:

- نام شرکت یا شخصی شما در آن وجود دارد

- کلمه یا عبارتی دارد که آن را دسته بندی می کند

- کوتاه و آسان برای گفتن است

برخی از نمونههای کانال عبارتند از Abbie Emmons، نویسنده مستقلی که محتوا را به اشتراک میگذارد تا به دیگران کمک کند تا اولین رمان خود را بنویسند، همانطور که حدس زدهاید، دکتر مایک، پزشکی که محتوای پزشکی را به اشتراک میگذارد، و Yoga With Adriene، کانالی که یوگای کامل را به اشتراک میگذارد. کارهای روزمره.

برندهایی مانند Surfer، Visme و ناب فالوور تمایل دارند فقط به نام تجاری خود بچسبند و پیدا کردن آنها را آسان می کند.

با این حال، نامهای تصادفی بیشتری را در آنجا خواهید یافت، مانند Unspeakable، یک کانال بازی، Cocomelon، یک کانال قافیههای مهد کودک، و That Practical Mom، کانالی که توصیههای زندگی را از یک مادر به اشتراک میگذارد.

جایگاه خود را در نظر بگیرید (اطلاعات بیشتری در مورد آن در نکته بعدی)، انواع محتوایی که می خواهید به اشتراک بگذارید، و اگر منطقی است فقط از نام یا نام تجاری خود استفاده کنید. یا چرا مولد نام یوتیوب ما را امتحان نمی کنیم و اجازه نمی دهیم هوش مصنوعی این کار را برای شما انجام دهد؟

2. طاقچه مناسب را انتخاب کنید

راحت باشید، این آسان تر از انتخاب نام کانال است. چرا؟ زیرا برخلاف مرگ و مالیات، میتوانید جایگاه محتوای خود را تغییر دهید.

شما ممکن است فکر شما آنقدر به چیزی علاقه دارید که صدها ساعت محتوا را پر کنید. اما، زمانی که کار سخت شود و نخواهید زود بیدار شوید، مطمئناً متوجه خواهید شد و فیلم دیگری در مورد آن فیلم بگیرید.

اما در حالی که شما می توان بعداً جایگاه خود را تغییر دهید، ممکن است مخاطبانی را که قبلاً ساخته اید از خود دور کند—بنابراین مدتی را صرف تعریف کانال خود کنید.

برای انتخاب جایگاه خود، از خود بپرسید:

- انجام چه کاری حس زمان را از دست می دهم؟

- در مورد چه چیزی می توانستم ساعت ها با دوستانم صحبت کنم؟

- در اوقات فراغت، چه چیزی را به صورت آنلاین جستجو/تماشا/آموزش می کنم؟

اگر در حال ایجاد یک کانال YouTube برای نام تجاری خود هستید، این مرحله کمی ساده تر می شود. کسب و کار شما چه می کند؟ این جایگاه شماست.

برای استفاده از مارک هایی که در آخرین نکته ذکر کردیم:

- Surfer، یک ابزار SEO، ویدیوهایی را در مورد نوشتن محتوای بسیار بهینه به اشتراک می گذارد

- Visme، یک ابزار طراحی گرافیکی، ویدیوهایی را در مورد ایجاد تصاویر بصری به اشتراک می گذارد

- ناب فالوور، یک ابزار مدیریت رسانه های اجتماعی، ویدئوهایی را در مورد استفاده از رسانه های اجتماعی برای بازاریابی به اشتراک می گذارد

منطقی است، درست است؟

اوه، و اگر خودتان نگران حضور در دوربین هستید، ما هزاران ایده برای کانال YouTube بیچهره داریم که باید در نظر بگیرید.

3. کانال خود را بهینه کنید

با بهینه سازی کامل و پر کردن نمایه خود، کانال خود را برای موفقیت تنظیم کنید. حتی اگر تعداد مشترکان شما هنوز تک رقمی است، مطمئن شوید که از همان ابتدا ثابت به نظر می رسید.

برای انجام این کار، باید اضافه کنید:

- عکس پروفایل. به عنوان یک خالق، این باید تصویری حرفه ای از خودتان باشد. به عنوان یک برند، این باید لوگوی شما باشد

- هنر کانال. تصویری ایجاد کنید که به نشان دادن انتظارات بینندگان از کانال شما کمک کند

- واترمارک ویدیویی. برای شناسایی بیشتر، یک واترمارک (به طور ایده آل آرم کانال خود) که در گوشه همه ویدیوهای شما ظاهر می شود اضافه کنید.

- توضیحات کانال توضیح دهید که کانال شما در مورد چه چیزی خواهد بود، یا از ژنراتور توضیح کانال YouTube ما استفاده کنید

- لینک ها/اطلاعات تماس پیوندهایی را به سایر کانال های رسانه های اجتماعی خود و همچنین یک آدرس ایمیل یا وب سایت اضافه کنید تا به افراد اجازه دهید با شما در تماس باشند

- ویدیوی ویژه. ویدیوی مقدماتی عالی را برای زندگی در بالای کانال YouTube خود انتخاب کنید

- کانال خود را تایید کنید تأیید شدن در YouTube به افزایش اعتبار شما کمک می کند و به مشترکین کمک می کند به کانال شما اعتماد کنند

شما می توانید همه این تغییرات را در سفارشی سازی کانال منطقه استودیوی YouTube شما. ارائه تمام این اطلاعات از قبل به مردم کمک می کند تا بفهمند که آیا می خواهند مشترک شوند و محتوای شما را دنبال کنند یا نه.

به علاوه، به نظر می رسد بسیار جذاب تر است. در اینجا یک نمونه از کانالی است که کاملاً بهینه شده است:

4. یک برنامه پست ثابت تنظیم کنید

اگر می خواهید کانال YouTube خود را رشد دهید، باید ثابت قدم باشید. یعنی تنظیم یک برنامه انتشار واقعی و چسبیدن به آن.

یک برنامه پست معمولی یک بار در هفته است، اما باید مطمئن شوید که این یک آهنگ واقعی برای شماست. وقتی تازه شروع به کار می کنید، ایجاد و ویرایش ویدیوهایتان ممکن است زمان زیادی طول بکشد.

سازگاری بیش از فرکانس اهمیت دارد. اگر فقط هر دو هفته یک بار بتوانید ویدیو بسازید، خوب است.

فرسودگی خالق یک مسئله بزرگ است. TikToker و YouTuber Jack Innanen آن را اینطور خلاصه کردند: “من به نقطه ای می رسم که “من باید امروز یک ویدیو بسازم” و تمام روز را با ترس از این روند سپری می کنم.

پایبند بودن به یک برنامه زمانبندی پایدار باعث میشود بدون خستگی به جلو حرکت کنید، و این شانس را افزایش میدهد که به اندازه کافی در سفر سازنده خود بمانید تا نتایج را ببینید.

5. روی تجهیزات ویدئویی با کیفیت بالا سرمایه گذاری کنید

اگر می خواهید به عنوان یک خالق جدی YouTube دیده شوید، به محتوای باکیفیت نیاز دارید. یکی از بخش های اصلی تولید محتوای با کیفیت بالا داشتن تجهیزات با کیفیت بالا است.

در حالی که وقتی تازه سفر YouTube خود را شروع می کنید نیازی به خرج کردن پول زیادی برای خرید تجهیزات پیشرفته ندارید، دوربین گوشی هوشمند شما آن را برای سطح تولیدی که YouTube نیاز دارد کاهش نمی دهد.

در عوض، روی برخی تجهیزات ویدئویی مناسب سرمایه گذاری کنید. برخی از اصول اولیه عبارتند از:

- دوربین فیلمبرداری

- تثبیت کننده دوربین (به عنوان مثال، سه پایه)

- میکروفون

- نورپردازی

- صفحه سبز

- نرم افزار ویرایش ویدیو

6. در هر ویدیو پیشرفت های کوچکی ایجاد کنید

نکته بازاریابی تند یوتیوب: بدون داشتن ویدیو نمی توانید بازدید و مشترکین داشته باشید.

همانطور که یوتیوببر محبوب علی ابدال میگوید، “اولین ویدیوی شما بد خواهد بود.” او توصیه می کند به جای اینکه سعی کنید هر ویدیویی را “بهترین” کنید، سعی کنید هر بار یک عنصر کوچک را بهبود بخشید. دنباله عنوان جدید را امتحان کنید، مقداری موسیقی پس زمینه اضافه کنید یا یک نرم افزار ویرایش جدید را آزمایش کنید.

این تغییرات کوچک به مرور زمان برای بهبود کانال شما بدون اینکه زیاد باشد اضافه میشوند.

منبع: علی ابدال در یوتیوب

7. تصاویر کوچک چشم نواز ایجاد کنید

تصویر کوچک ویدیوی شما چیزی است که واقعاً مردم را جذب می کند. آنها در یک میلی ثانیه تصمیم می گیرند که آیا ویدیوی شما ارزش تماشا را دارد یا خیر.

برخی از سازندگان تا ۲ ساعت برای ساختن یک تصویر کوچک صرف میکنند. یکی از یوتیوببرها حتی چندین گزینه را انتخاب میکند و میگوید: «طراح من حدود 3-4 ساعت برای ساخت 6-7 ویدیو برای هر ویدیو صرف میکند. اگر یک انگشت شست بد عمل کند، آن را عوض می کنیم.»

تصویر بندانگشتی شما باید آنقدر خوب باشد که مردم حتی نیازی به خواندن عنوان نداشته باشند تا بفهمند ویدیو در مورد چیست.

هنر با ریز عکسهای Flo با یک پالت رنگ و سبک مشترک مارک خوبی دارد، بنابراین بینندگان میتوانند فوراً آموزشهای خود را در نتایج جستجو تشخیص دهند.

چند نکته طراحی بند انگشتی:

- از نمادها یا لوگوها استفاده کنید (در صورت وجود برای موضوع شما)

- متن را حداقل نگه دارید

- عناصر خلاقانه را برای جلب توجه اضافه کنید، مانند نقاشی دستی، نورهای نئون و غیره (بسته به برند شما)

8. توضیحات ویدیوی خود را به طور کامل پر کنید

شما محدودیت کاراکتر 5000 کاراکتری در توضیحات YouTube خود دارید که می تواند برابر با 800 کلمه باشد. این به خودی خود یک وبلاگ کوچک است، بنابراین از اشغال فضایی نترسید.

ابتدا، و در اولین نکته «متوسط» YouTube خود درباره این موضوع بیشتر بحث خواهیم کرد، شما میخواهید یک کلمه کلیدی را در اولین بیت توضیح ویدیوی خود بگنجانید تا به الگوریتم YouTube کمک کند تا به وضوح بفهمد ویدیوی شما چیست.

به این مثال از کانال یوتیوب خود ناب فالوور نگاه کنید. این ویدیو همه چیز در مورد گرایش های رسانه های اجتماعی است و ما مطمئن شده ایم که این کلمه کلیدی را در تمام توضیحات گنجانده ایم:

هنگامی که ویدیوی خود را با توضیحات مختصری و کلمه کلیدی معرفی کردید، بهتر است مهر زمانی را نیز درج کنید. اگر به بالا نگاه کنید، خواهید دید که ما این کار را در توضیحات ویدیوی خودمان انجام داده ایم.

مهرهای زمانی ویدیویی که به عنوان فصل نیز شناخته میشوند، پیوندهای قابل کلیکی هستند که به بینندگان اجازه میدهند از اطراف یک ویدیو رد شوند. بدون آنها، اگر افراد به راحتی نتوانند آنچه را که به دنبال آن هستند پیدا کنند، ممکن است آنجا را ترک کنند.

می توانید مهرهای زمانی را به صورت دستی اضافه کنید یا YouTube می تواند آنها را به طور خودکار ایجاد کند. برای افزودن دستی آنها، آنها را در توضیحات ویدیوی خود تایپ کنید. برای ایجاد یک لیست قابل کلیک، باید حداقل سه مُهر زمانی اضافه کنید و آنها را مانند «01:05 Name of Chapter» قالب بندی کنید.

همچنین میتوانید آپلودهای گذشته را ویرایش کنید تا مُهرهای زمانی را به این روش درج کنید. پس از ذخیره توضیحات، مُهرهای زمانی قابل کلیک مانند مثال بالا را خواهید دید.

از آنجا، میخواهید از بقیه قسمت توضیحات استفاده کنید تا درباره شما، کسبوکارتان به بینندگان بگویید و به پلتفرمهای دیگرتان پیوند دهید.

این میتواند یک الگوی دیگ بخار باشد که تقریباً برای هر ویدیو یکسان است، اگرچه اگر فروش ویژهای دارید یا هر محصولی را در ویدیوی خود ذکر میکنید، آن را تغییر دهید.

در غیر این صورت، همیشه شامل موارد زیر باشد:

- پیوندهایی به پروفایل های اجتماعی دیگر شما

- وب سایت شما و/یا یک صفحه فرود خاص

- یک توضیح کوتاه درباره شما/شرکت شما

- اطلاعات تماس

هنوز کمک می خواهید؟ یکی از قالبهای توضیحات ویدیوی رایگان و قابل ویرایش ما را بگیرید یا از تولیدکننده توضیحات ویدیوی YouTube ما بهره ببرید.

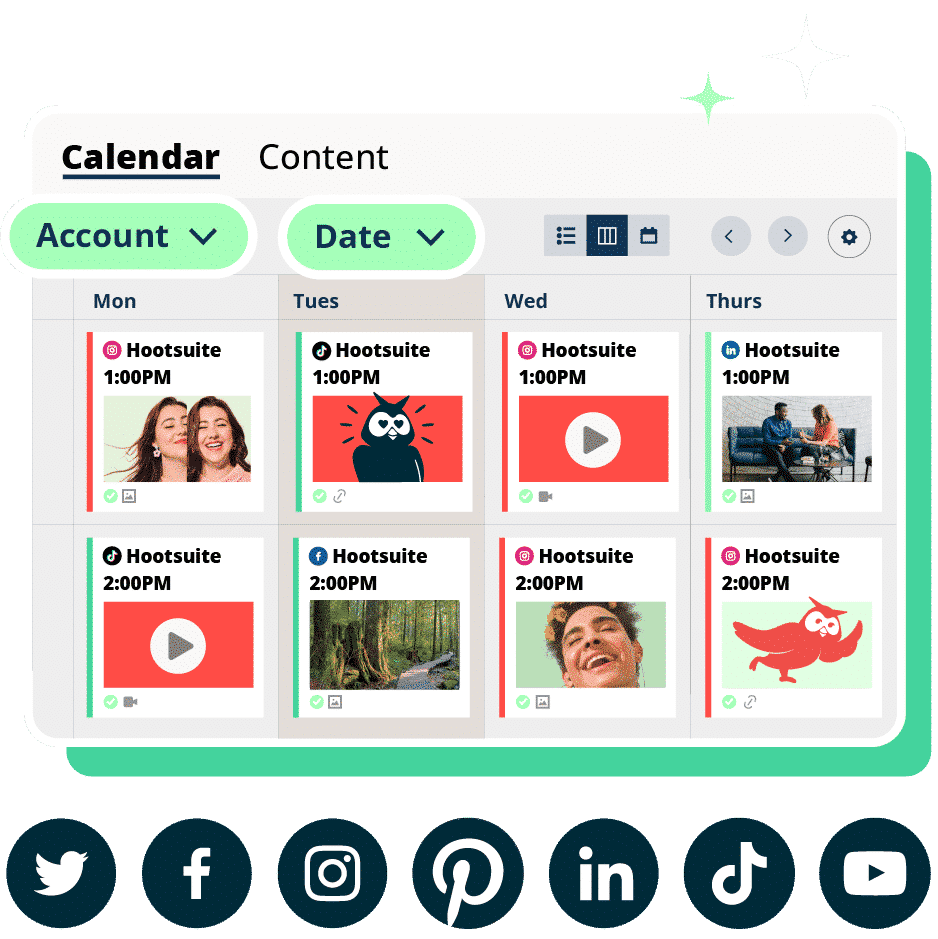

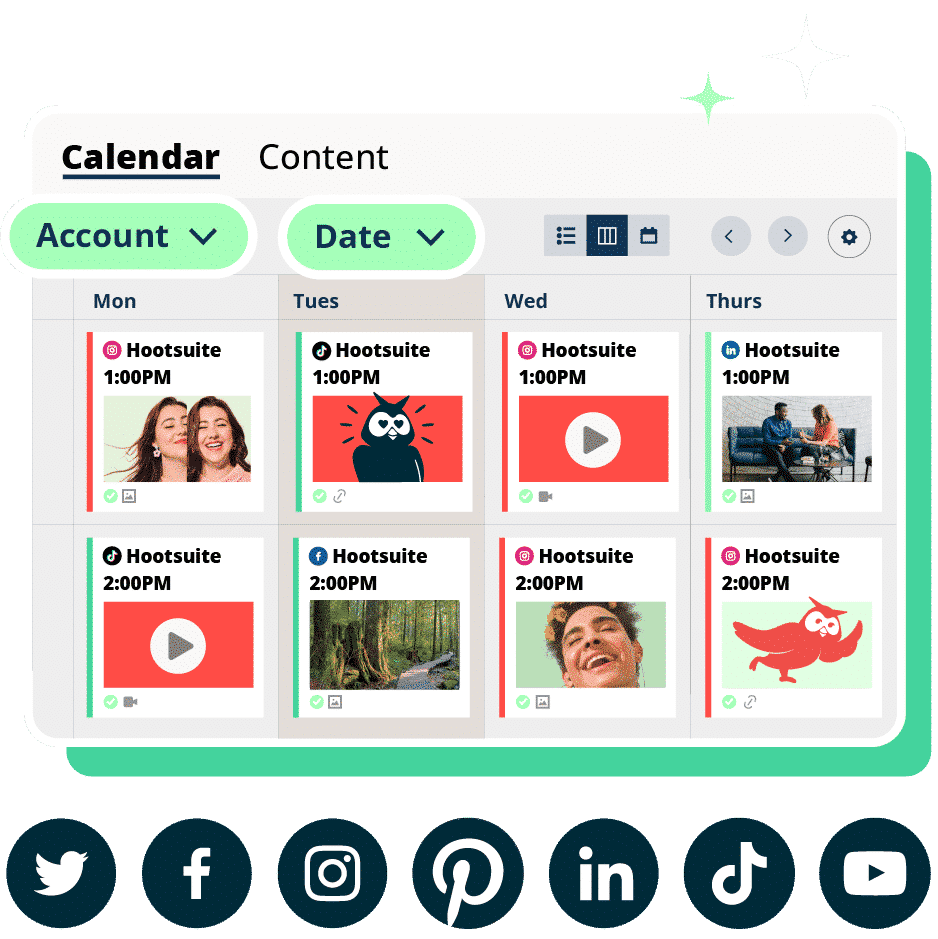

شماره 1 ابزار رسانه های اجتماعی

ايجاد كردن. برنامه. انتشار. مشغول کردن. اندازه گرفتن. پیروزی.

آزمایشی 30 روزه رایگان

5 نکته و ترفند متوسط YouTube

هنگامی که برای مدتی کانال YouTube خود را داشتید، ممکن است آماده باشید تا آن را به سطح بعدی ببرید. این نکات و ترفندهای میانی به شما کمک می کند تا در مسیر درست رشد قرار بگیرید.

9. ویدیوهای خود را برای جستجو بهینه کنید

یوتیوب یک موتور جستجو است، مانند گوگل – به جز نتایج جستجو که همه ویدیو هستند. این بدان معناست که شما باید از تاکتیکهای سئوی YouTube مانند استفاده از کلمات کلیدی تمرکز استفاده کنید که به نمایش ویدیوهای شما در جستجو کمک میکند.

کلمات کلیدی به الگوریتم YouTube کمک می کنند تا بفهمد ویدیوی شما در مورد چیست و احتمال نمایش آن در ستون «پیشنهاد شده» در کنار ویدیوهای مرتبط (در زیر) و همچنین در نتایج جستجوی مرتبط بیشتر می شود. این بدان معناست که شانس بیشتری برای دستیابی به بینندگان جدید دارید.

کلمات کلیدی می توانند به سادگی یک کلمه باشند، اما عبارات دو یا چند کلمه اغلب به YouTube و افراد ایده بهتری از موضوع شما می دهد، مانند “تحلیل رقبای رسانه های اجتماعی”، همانطور که در مثال بالا مشاهده می کنید.

در اینجا زیاده روی نکنید – یک کلمه کلیدی در عنوان شما خوب است. به علاوه: آن را کوتاه نگه دارید.

بررسیها نشان میدهد که عناوین ویدیوهای کمتر از 10 کلمه بهترین عملکرد را در نتایج جستجوی YouTube دارند و 81٪ از ویدیوهای دارای رتبه برتر زیر این محدودیت قرار دارند.

مهمتر از آن، حداکثر 60 کاراکتر برای طول عنوان خود، که حدود 8 تا 10 کلمه (با فاصله) است، هدف بگیرید. شما مجاز به 100 کاراکتر هستید، اما فقط 60 نویسه اول در نتایج جستجو نشان داده می شود.

بی اطلاع از کلمات کلیدی؟ ما نکات بیشتری در مورد جستجوی کلمات کلیدی YouTube داریم، یا یک ابزار آنلاین رایگان مانند KeywordsPeopleUse را برای یافتن سریع … کلمات کلیدی مورد استفاده مردم امتحان کنید.

10. بر تجزیه و تحلیل خود نظارت کنید

برای رفتن به جلو، باید به عقب برگردید … در زمان. نه با Delorean، بلکه با بررسی تجزیه و تحلیل YouTube خود حداقل ماهانه.

تجزیه و تحلیل خود را در منوی سمت چپ در YouTube Studio پیدا کنید.

معیارهای کلیدی برای کمک به درک عملکرد کانالتان:

- مشترکین: از جمله لغو اشتراک

- ویدیوهای برتر: به مخاطبان خود آنچه را که می خواهند بیشتر بدهید

- زمان تماشای کانال: این باید هر ماه روند صعودی داشته باشد، یا ممکن است لازم باشد استراتژی محتوای خود را دوباره مرور کنید

- منابع ترافیک: ببینید بینندگان چگونه شما را پیدا می کنند، از جمله کلمات کلیدی جستجو

بهعلاوه، میتوانید دموگرافیک و موارد دیگر را کاوش کنید، از جمله آمار درآمد آگهی پس از برآورده کردن شرایط واجد شرایط بودن YouTube Partner Program برای کسب درآمد از محتوای خود.

11. محتوای خود را با لیست های پخش سازماندهی کنید

فهرستهای پخش YouTube به شما کمک میکنند در نتایج جستجو رتبهبندی بالاتری داشته باشید، زیرا کاربران بیشتر به تماشای ویدیوی بعدی ادامه میدهند، که بازدید کلی و زمان تماشای شما را افزایش میدهد—و باعث میشود YouTube فکر کند که شما بسیار باحال هستید.

میتوانید ویدیوهای سازندگان دیگر را به فهرستهای پخش خود اضافه کنید – که ایده خوبی برای همکاریهای بعدی است – اما در ابتدا خودتان آن را بسازید. ویدیوهای خود را بر اساس موضوع گروه بندی کنید یا یک سری خاص را با هم نگه دارید. (نکته جایزه: بعداً وقتی با یک حساب تأیید شده فانتزی بزرگ و مشهور شوید، می توانید لیست پخش سریال های رسمی ایجاد کنید.)

میتوانید فهرستهای پخش خود را در استودیوی YouTube مدیریت کنید محتوا > فهرستهای پخش یا با اضافه کردن سریع یک مورد جدید از بالا ايجاد كردن منو.

در اینجا یک نمونه از آنچه می تواند در کانال شما باشد آورده شده است:

12. با سایر کانال های یوتیوب همکاری کنید

یکی از راه های عالی برای افزایش دسترسی شما، همکاری با سایر YouTubers در ویدیوها است. برای مثال، اگر کانال دیگری به شما معرفی یا نام برده است، به مخاطبان جدیدی از مشترکین بالقوه دسترسی پیدا میکنید.

یک کانال YouTube را پیدا کنید که محتوای مشابه شما ایجاد کند (البته اگر یک برند هستید، بهتر است از رقبای مستقیم خودداری کنید و به جای آن روی کار با سازندگان یا مارک های مکمل تمرکز کنید) و در مورد شراکت صحبت کنید.

یک ویدیو (یا دو – یکی برای هر کانال) با هم ایجاد کنید، سپس از آن به عنوان راهی برای تبلیغ کانال های YouTube یکدیگر استفاده کنید.

13. ویدیوهای خود را زیرنویس کنید

زیرنویسهای بسته ویدیوهای شما باعث میشود محتوای شما برای همه قابل دسترس و فراگیر باشد. تقریباً از هر 5 نفر یک نفر درجاتی از اختلال شنوایی را تجربه می کند و حدود 5 درصد از جمعیت جهان ناشنوا یا کم شنوا هستند. زیرنویس تضمین می کند که هیچ یک از مخاطبان بالقوه خود را حذف نمی کنید.

میتوانید رونوشتهای نوشتاری خود را تهیه کنید یا از YouTube بهطور خودکار آن را با تشخیص خودکار گفتار زیرنویس کنید.

برای سازندگانی که تازه شروع به کار کردهاند، زیرنویسهای خودکار YouTube یک گزینه عالی است. اگر یوتیوب هر کلمه ای را اشتباه دریافت کرد، می توانید زیرنویس ها را ویرایش کنید، و ویرایش بسیار سریعتر از تایپ زیرنویس ها از ابتدا است.

با این حال، هنگامی که کانال شما شروع به رشد کرد یا درآمد کسب کرد، فردی را استخدام کنید تا به طور حرفه ای ویدیوهای شما را رونویسی کند. حتی فراتر بروید و روی ویدیوهای خود به چندین زبان زیرنویس کنید—YouTube زیرنویس ها را به زبان دلخواه بینندگان نشان می دهد—تا مخاطب جهانی ایجاد کنید.

5 نکته در سطح متخصص در کانال YouTube

به همه این نکات دیگر تسلط دارید؟ در اینجا چند نکته تخصصی برای کمک به شما برای رسیدن به سطح بعدی با کانال YouTube خود آورده شده است.

14. از کانال خود کسب درآمد کنید

وقتی شروع به رشد کانال خود کردید، چرا از یوتیوب درآمد کسب نکنید؟ این پلتفرم دارای یک طرح درآمدزایی عالی است و بهطور متوسط هر سازنده YouTube تقریباً 5000 دلار در ماه درآمد کسب میکند.

این بدان معناست که اگر بتوانید به آن پایبند باشید و طرفداران زیادی ایجاد کنید، یوتیوب میتواند یک سرگرمی جانبی عالی باشد – یا حتی جایگزین شغل تمام وقت شما شود.

برای کسب درآمد از کانال YouTube خود، باید در برنامه شریک YouTube (YPP) پذیرفته شوید. الزامات واجد شرایط بودن عبارتند از:

- از خط مشی های کسب درآمد از کانال YouTube پیروی کنید

- در یک کشور/منطقه واجد شرایط زندگی کنید

- دستورالعمل های جامعه را دنبال کنید

- تأیید صحت ۲ مرحلهای را روشن کنید

- دسترسی به ویژگیهای پیشرفته (شکل پیشرفته تأیید YouTube)

- یک حساب AdSense فعال مرتبط با کانال YouTube خود داشته باشید

- حداقل 1000 مشترک داشته باشید

- دارند یا 4000 ساعت تماشای عمومی معتبر در 12 ماه گذشته یا 10 میلیون بازدید عمومی معتبر Shorts در 90 روز گذشته

پس از رسیدن به آستانه، می توانید برای برنامه شریک YouTube درخواست دهید. در صورت پذیرش، میتوانید از تبلیغات نشان داده شده در ویدیوهای YouTube خود درآمد دریافت کنید.

15. YouTube Shorts را امتحان کنید

شورت های یوتیوب برای تبلیغ کانال شما بسیار مهم است که به ویژه برای سازندگان جدید مهم است. از سه ماهه دوم 2023، YouTube Shorts بیش از 2 میلیارد کاربر فعال ماهانه دارد.

Short ها ویدئوهای کوتاه عمودی مشابه ویدیوهای TikTok یا حلقه های اینستاگرام هستند. آنها در یک بخش اختصاصی شورتها نمایش داده میشوند که کاربران آنها را تند تند میکشند.

یک قطعه 15 ثانیه ای از آخرین ویدیوی خود بگیرید و آن را به صورت کوتاه آپلود کنید. بهتر از آن، در حین ویرایش هر ویدیو، چند قطعه از آن را بردارید و اکنون 2 تا 3 فیلم کوتاه برای انتشار در طول هفته دارید.

راهنمای YouTube Shorts ما را بخوانید تا نکاتی برای استفاده حداکثری از این قالب جدید هیجان انگیز داشته باشید.

16. استاد ویرایش ویدیو

محتوای YouTube شما – آنچه می گویید، نحوه بیان آن، ویژگی منحصر به فرد آن و غیره- چیزی است که مردم را جذب می کند، اما ویرایش خوب ویدیو چیزی است که باعث می شود آنها را تماشا کنند و برگردند.

ویرایش خیلی بیشتر از فیلمبرداری واقعی ویدیو طول می کشد، اما زمان خوبی صرف شده است. از یوتیوبرهای مورد علاقه خود الهام بگیرید تا شروع به کشف سبک و تکنیک های ویرایش خود کنید. ویدیوهای شما فوراً مانند ویدیوهای آنها شیک به نظر نخواهند رسید، اما بهتر خواهید شد.

روی نرم افزار ویرایش ویدیو با کیفیت بالا سرمایه گذاری کنید و حرفه ای شوید. این نه تنها ویدیوهای شما را بهتر و بهتر می کند، بلکه فرآیند ویرایش را بسیار سریعتر و آسان تر می کند.

بسته به بودجه خود، می توانید به محض راه اندازی کانال خود، به یک ویرایشگر ویدیوی حرفه ای برون سپاری کنید. با این حال، برای اکثر سازندگان، توانایی انجام این کار تنها پس از شروع کسب درآمد کانال آنها به دست می آید.

در هر صورت، مطمئن شوید که در ویرایش ویدیو تسلط دارید، سپس برای خود هدفی تعیین کنید که وقتی حساب YouTube شما شروع به ساخت مبلغ مشخصی در ماه کرد، یک ویرایشگر استخدام کنید. وقت شما را برای تمرکز بر تولید محتوا آزاد می کند.

17. در کنفرانس های یوتیوب شرکت کنید

شرکت در کارگاهها یا کنفرانسهایی را برای YouTuberها در نظر بگیرید که به سازندگان کمک میکنند درباره رشد کانالهایشان بیشتر بیاموزند. اینها همچنین می توانند مکانی عالی برای ایجاد شبکه و ایجاد ارتباط با سایر YouTubers باشند.

چند کنفرانس که باید در نظر گرفته شود عبارتند از:

- VidCon

- VidSummit

- اجلاس وب

این کنفرانسها میتواند مکانی عالی برای دریافت نکات رشد بیشتر، ارائه ایدههای جدید و یادگیری مهارتهای جدید باشد که میتواند به شما در بهبود بیشتر کانالتان کمک کند.

18. یک استراتژی توزیع محتوا ایجاد کنید

انتشار ویدیوهای یوتیوب خود در کانال خود و نامگذاری آن در یک روز تقریباً کافی نیست. شما به یک استراتژی توزیع محتوا نیاز دارید که بتواند به شما کمک کند حتی به مخاطبان بیشتری دسترسی پیدا کنید.

اگرچه تلاشهای سئوی YouTube شما باید به شما کمک کند تا دسترسی خود را در این پلتفرم افزایش دهید، راههای دیگری برای تبلیغ ویدیوهای خود در خارج از پلتفرم وجود دارد.

استراتژی تبلیغ ویدیوی YouTube شما باید شامل تاکتیکهایی مانند موارد زیر باشد:

- در سایر کانال های رسانه های اجتماعی خود به اشتراک بگذارید

- پیوند به خبرنامه ایمیل خود

- در انجمن ها و انجمن های آنلاین به اشتراک بگذارید

- در وبلاگ یا وب سایت خود جاسازی کنید

- از کارتهای ویدیویی YouTube و صفحههای پایانی برای پیوند دادن به ویدیوهای دیگر استفاده کنید

- لیست پخش ایجاد کنید تا محتوای مشابه را گروه بندی کنید

- برای تقویت ویدیوهای خود، تبلیغات YouTube را اجرا کنید

- با اینفلوئنسرهای YouTube شریک شوید تا به مخاطبان بیشتری دسترسی پیدا کنید

- از توضیحات ویدیوی خود به سایر ویدیوهای YouTube پیوند دهید

برای شروع و رشد کانال YouTube خود در سال 2024 آماده اید؟ با ناب فالوور ویدیوهای YouTube خود و سایر محتوای رسانه های اجتماعی خود را در یک مکان برنامه ریزی، منتشر و تجزیه و تحلیل کنید. امروز آن را رایگان امتحان کنید.

با فایل های از کلویی وست.

با ناب فالوور کانال YouTube خود را سریعتر رشد دهید. به راحتی نظرات را تعدیل کنید، ویدیو را برنامه ریزی کنید و در فیس بوک، اینستاگرام و X/Twitter منتشر کنید.

یوتیوب است را به دو دلیل برای برندها و تولیدکنندگان مشتاق محتوا مناسب است: الف مخاطبان بالقوه عظیم و یکی از با ارزش ترین برنامه های کسب درآمد از محتوا از هر پلتفرم اجتماعی اگر میخواهید از این فرصتها استفاده کنید، به فهرست نکات برتر یوتیوب ما نیاز دارید.

به هر حال، یوتیوب دومین وب سایت پربازدید در جهان است و 83 درصد از بزرگسالان آمریکایی در این پلت فرم هستند. کاربران روزانه یک میلیارد ساعت محتوای ویدیویی را پخش می کنند. اما به دور از اشباع بیش از حد است. در واقع، هرگز زمان بهتری برای راه اندازی یک کانال یوتیوب وجود نداشته است.

این 18 نکته YouTube برای مبتدیان، سازندگان متوسط و متخصصان به شما کمک میکند تا بازدیدها را به دست آورید، مردم را تشویق به مشترک شدن در کانالتان کنید و از روز اول و بعد از آن رشد کنید.

به سمت راست به مرتبط ترین بخش بروید یا همین الان شروع به خواندن کنید!

بدست بیاور بسته رایگان 5 الگوی بنر قابل تنظیم YouTube اکنون. در زمان صرفه جویی کنید و حرفه ای به نظر برسید و در عین حال برند خود را به سبک تبلیغ کنید.

8 نکته YouTube برای مبتدیان

برای شروع آماده اید؟ این نکات مبتدی YouTube باعث می شود کانال خود را با پای راست راه اندازی کنید و آن را برای رشد و موفقیت تنظیم کنید.

1. نام کانال مناسب را انتخاب کنید

اولین کاری که باید انجام دهید این است که یک نام برای کانال YouTube خود انتخاب کنید. بهترین راه برای نشان دادن نوع محتوایی که قصد ایجاد آن را دارید چیست؟

نام کامل کانال یوتیوب:

- نام شرکت یا شخصی شما در آن وجود دارد

- کلمه یا عبارتی دارد که آن را دسته بندی می کند

- کوتاه و آسان برای گفتن است

برخی از نمونههای کانال عبارتند از Abbie Emmons، نویسنده مستقلی که محتوا را به اشتراک میگذارد تا به دیگران کمک کند تا اولین رمان خود را بنویسند، همانطور که حدس زدهاید، دکتر مایک، پزشکی که محتوای پزشکی را به اشتراک میگذارد، و Yoga With Adriene، کانالی که یوگای کامل را به اشتراک میگذارد. کارهای روزمره.

برندهایی مانند Surfer، Visme و ناب فالوور تمایل دارند فقط به نام تجاری خود بچسبند و پیدا کردن آنها را آسان می کند.

با این حال، نامهای تصادفی بیشتری را در آنجا خواهید یافت، مانند Unspeakable، یک کانال بازی، Cocomelon، یک کانال قافیههای مهد کودک، و That Practical Mom، کانالی که توصیههای زندگی را از یک مادر به اشتراک میگذارد.

جایگاه خود را در نظر بگیرید (اطلاعات بیشتری در مورد آن در نکته بعدی)، انواع محتوایی که می خواهید به اشتراک بگذارید، و اگر منطقی است فقط از نام یا نام تجاری خود استفاده کنید. یا چرا مولد نام یوتیوب ما را امتحان نمی کنیم و اجازه نمی دهیم هوش مصنوعی این کار را برای شما انجام دهد؟

2. طاقچه مناسب را انتخاب کنید

راحت باشید، این آسان تر از انتخاب نام کانال است. چرا؟ زیرا برخلاف مرگ و مالیات، میتوانید جایگاه محتوای خود را تغییر دهید.

شما ممکن است فکر شما آنقدر به چیزی علاقه دارید که صدها ساعت محتوا را پر کنید. اما، زمانی که کار سخت شود و نخواهید زود بیدار شوید، مطمئناً متوجه خواهید شد و فیلم دیگری در مورد آن فیلم بگیرید.

اما در حالی که شما می توان بعداً جایگاه خود را تغییر دهید، ممکن است مخاطبانی را که قبلاً ساخته اید از خود دور کند—بنابراین مدتی را صرف تعریف کانال خود کنید.

برای انتخاب جایگاه خود، از خود بپرسید:

- انجام چه کاری حس زمان را از دست می دهم؟

- در مورد چه چیزی می توانستم ساعت ها با دوستانم صحبت کنم؟

- در اوقات فراغت، چه چیزی را به صورت آنلاین جستجو/تماشا/آموزش می کنم؟

اگر در حال ایجاد یک کانال YouTube برای نام تجاری خود هستید، این مرحله کمی ساده تر می شود. کسب و کار شما چه می کند؟ این جایگاه شماست.

برای استفاده از مارک هایی که در آخرین نکته ذکر کردیم:

- Surfer، یک ابزار SEO، ویدیوهایی را در مورد نوشتن محتوای بسیار بهینه به اشتراک می گذارد

- Visme، یک ابزار طراحی گرافیکی، ویدیوهایی را در مورد ایجاد تصاویر بصری به اشتراک می گذارد

- ناب فالوور، یک ابزار مدیریت رسانه های اجتماعی، ویدئوهایی را در مورد استفاده از رسانه های اجتماعی برای بازاریابی به اشتراک می گذارد

منطقی است، درست است؟

اوه، و اگر خودتان نگران حضور در دوربین هستید، ما هزاران ایده برای کانال YouTube بیچهره داریم که باید در نظر بگیرید.

3. کانال خود را بهینه کنید

با بهینه سازی کامل و پر کردن نمایه خود، کانال خود را برای موفقیت تنظیم کنید. حتی اگر تعداد مشترکان شما هنوز تک رقمی است، مطمئن شوید که از همان ابتدا ثابت به نظر می رسید.

برای انجام این کار، باید اضافه کنید:

- عکس پروفایل. به عنوان یک خالق، این باید تصویری حرفه ای از خودتان باشد. به عنوان یک برند، این باید لوگوی شما باشد

- هنر کانال. تصویری ایجاد کنید که به نشان دادن انتظارات بینندگان از کانال شما کمک کند

- واترمارک ویدیویی. برای شناسایی بیشتر، یک واترمارک (به طور ایده آل آرم کانال خود) که در گوشه همه ویدیوهای شما ظاهر می شود اضافه کنید.

- توضیحات کانال توضیح دهید که کانال شما در مورد چه چیزی خواهد بود، یا از ژنراتور توضیح کانال YouTube ما استفاده کنید

- لینک ها/اطلاعات تماس پیوندهایی را به سایر کانال های رسانه های اجتماعی خود و همچنین یک آدرس ایمیل یا وب سایت اضافه کنید تا به افراد اجازه دهید با شما در تماس باشند

- ویدیوی ویژه. ویدیوی مقدماتی عالی را برای زندگی در بالای کانال YouTube خود انتخاب کنید

- کانال خود را تایید کنید تأیید شدن در YouTube به افزایش اعتبار شما کمک می کند و به مشترکین کمک می کند به کانال شما اعتماد کنند

شما می توانید همه این تغییرات را در سفارشی سازی کانال منطقه استودیوی YouTube شما. ارائه تمام این اطلاعات از قبل به مردم کمک می کند تا بفهمند که آیا می خواهند مشترک شوند و محتوای شما را دنبال کنند یا نه.

به علاوه، به نظر می رسد بسیار جذاب تر است. در اینجا یک نمونه از کانالی است که کاملاً بهینه شده است:

4. یک برنامه پست ثابت تنظیم کنید

اگر می خواهید کانال YouTube خود را رشد دهید، باید ثابت قدم باشید. یعنی تنظیم یک برنامه انتشار واقعی و چسبیدن به آن.

یک برنامه پست معمولی یک بار در هفته است، اما باید مطمئن شوید که این یک آهنگ واقعی برای شماست. وقتی تازه شروع به کار می کنید، ایجاد و ویرایش ویدیوهایتان ممکن است زمان زیادی طول بکشد.

سازگاری بیش از فرکانس اهمیت دارد. اگر فقط هر دو هفته یک بار بتوانید ویدیو بسازید، خوب است.

فرسودگی خالق یک مسئله بزرگ است. TikToker و YouTuber Jack Innanen آن را اینطور خلاصه کردند: “من به نقطه ای می رسم که “من باید امروز یک ویدیو بسازم” و تمام روز را با ترس از این روند سپری می کنم.

پایبند بودن به یک برنامه زمانبندی پایدار باعث میشود بدون خستگی به جلو حرکت کنید، و این شانس را افزایش میدهد که به اندازه کافی در سفر سازنده خود بمانید تا نتایج را ببینید.

5. روی تجهیزات ویدئویی با کیفیت بالا سرمایه گذاری کنید

اگر می خواهید به عنوان یک خالق جدی YouTube دیده شوید، به محتوای باکیفیت نیاز دارید. یکی از بخش های اصلی تولید محتوای با کیفیت بالا داشتن تجهیزات با کیفیت بالا است.

در حالی که وقتی تازه سفر YouTube خود را شروع می کنید نیازی به خرج کردن پول زیادی برای خرید تجهیزات پیشرفته ندارید، دوربین گوشی هوشمند شما آن را برای سطح تولیدی که YouTube نیاز دارد کاهش نمی دهد.

در عوض، روی برخی تجهیزات ویدئویی مناسب سرمایه گذاری کنید. برخی از اصول اولیه عبارتند از:

- دوربین فیلمبرداری

- تثبیت کننده دوربین (به عنوان مثال، سه پایه)

- میکروفون

- نورپردازی

- صفحه سبز

- نرم افزار ویرایش ویدیو

6. در هر ویدیو پیشرفت های کوچکی ایجاد کنید

نکته بازاریابی تند یوتیوب: بدون داشتن ویدیو نمی توانید بازدید و مشترکین داشته باشید.

همانطور که یوتیوببر محبوب علی ابدال میگوید، “اولین ویدیوی شما بد خواهد بود.” او توصیه می کند به جای اینکه سعی کنید هر ویدیویی را “بهترین” کنید، سعی کنید هر بار یک عنصر کوچک را بهبود بخشید. دنباله عنوان جدید را امتحان کنید، مقداری موسیقی پس زمینه اضافه کنید یا یک نرم افزار ویرایش جدید را آزمایش کنید.

این تغییرات کوچک به مرور زمان برای بهبود کانال شما بدون اینکه زیاد باشد اضافه میشوند.

منبع: علی ابدال در یوتیوب

7. تصاویر کوچک چشم نواز ایجاد کنید

تصویر کوچک ویدیوی شما چیزی است که واقعاً مردم را جذب می کند. آنها در یک میلی ثانیه تصمیم می گیرند که آیا ویدیوی شما ارزش تماشا را دارد یا خیر.

برخی از سازندگان تا ۲ ساعت برای ساختن یک تصویر کوچک صرف میکنند. یکی از یوتیوببرها حتی چندین گزینه را انتخاب میکند و میگوید: «طراح من حدود 3-4 ساعت برای ساخت 6-7 ویدیو برای هر ویدیو صرف میکند. اگر یک انگشت شست بد عمل کند، آن را عوض می کنیم.»

تصویر بندانگشتی شما باید آنقدر خوب باشد که مردم حتی نیازی به خواندن عنوان نداشته باشند تا بفهمند ویدیو در مورد چیست.

هنر با ریز عکسهای Flo با یک پالت رنگ و سبک مشترک مارک خوبی دارد، بنابراین بینندگان میتوانند فوراً آموزشهای خود را در نتایج جستجو تشخیص دهند.

چند نکته طراحی بند انگشتی:

- از نمادها یا لوگوها استفاده کنید (در صورت وجود برای موضوع شما)

- متن را حداقل نگه دارید

- عناصر خلاقانه را برای جلب توجه اضافه کنید، مانند نقاشی دستی، نورهای نئون و غیره (بسته به برند شما)

8. توضیحات ویدیوی خود را به طور کامل پر کنید

شما محدودیت کاراکتر 5000 کاراکتری در توضیحات YouTube خود دارید که می تواند برابر با 800 کلمه باشد. این به خودی خود یک وبلاگ کوچک است، بنابراین از اشغال فضایی نترسید.

ابتدا، و در اولین نکته «متوسط» YouTube خود درباره این موضوع بیشتر بحث خواهیم کرد، شما میخواهید یک کلمه کلیدی را در اولین بیت توضیح ویدیوی خود بگنجانید تا به الگوریتم YouTube کمک کند تا به وضوح بفهمد ویدیوی شما چیست.

به این مثال از کانال یوتیوب خود ناب فالوور نگاه کنید. این ویدیو همه چیز در مورد گرایش های رسانه های اجتماعی است و ما مطمئن شده ایم که این کلمه کلیدی را در تمام توضیحات گنجانده ایم:

هنگامی که ویدیوی خود را با توضیحات مختصری و کلمه کلیدی معرفی کردید، بهتر است مهر زمانی را نیز درج کنید. اگر به بالا نگاه کنید، خواهید دید که ما این کار را در توضیحات ویدیوی خودمان انجام داده ایم.

مهرهای زمانی ویدیویی که به عنوان فصل نیز شناخته میشوند، پیوندهای قابل کلیکی هستند که به بینندگان اجازه میدهند از اطراف یک ویدیو رد شوند. بدون آنها، اگر افراد به راحتی نتوانند آنچه را که به دنبال آن هستند پیدا کنند، ممکن است آنجا را ترک کنند.

می توانید مهرهای زمانی را به صورت دستی اضافه کنید یا YouTube می تواند آنها را به طور خودکار ایجاد کند. برای افزودن دستی آنها، آنها را در توضیحات ویدیوی خود تایپ کنید. برای ایجاد یک لیست قابل کلیک، باید حداقل سه مُهر زمانی اضافه کنید و آنها را مانند «01:05 Name of Chapter» قالب بندی کنید.

همچنین میتوانید آپلودهای گذشته را ویرایش کنید تا مُهرهای زمانی را به این روش درج کنید. پس از ذخیره توضیحات، مُهرهای زمانی قابل کلیک مانند مثال بالا را خواهید دید.

از آنجا، میخواهید از بقیه قسمت توضیحات استفاده کنید تا درباره شما، کسبوکارتان به بینندگان بگویید و به پلتفرمهای دیگرتان پیوند دهید.

این میتواند یک الگوی دیگ بخار باشد که تقریباً برای هر ویدیو یکسان است، اگرچه اگر فروش ویژهای دارید یا هر محصولی را در ویدیوی خود ذکر میکنید، آن را تغییر دهید.

در غیر این صورت، همیشه شامل موارد زیر باشد:

- پیوندهایی به پروفایل های اجتماعی دیگر شما

- وب سایت شما و/یا یک صفحه فرود خاص

- یک توضیح کوتاه درباره شما/شرکت شما

- اطلاعات تماس

هنوز کمک می خواهید؟ یکی از قالبهای توضیحات ویدیوی رایگان و قابل ویرایش ما را بگیرید یا از تولیدکننده توضیحات ویدیوی YouTube ما بهره ببرید.

شماره 1 ابزار رسانه های اجتماعی

ايجاد كردن. برنامه. انتشار. مشغول کردن. اندازه گرفتن. پیروزی.

آزمایشی 30 روزه رایگان

5 نکته و ترفند متوسط YouTube

هنگامی که برای مدتی کانال YouTube خود را داشتید، ممکن است آماده باشید تا آن را به سطح بعدی ببرید. این نکات و ترفندهای میانی به شما کمک می کند تا در مسیر درست رشد قرار بگیرید.

9. ویدیوهای خود را برای جستجو بهینه کنید

یوتیوب یک موتور جستجو است، مانند گوگل – به جز نتایج جستجو که همه ویدیو هستند. این بدان معناست که شما باید از تاکتیکهای سئوی YouTube مانند استفاده از کلمات کلیدی تمرکز استفاده کنید که به نمایش ویدیوهای شما در جستجو کمک میکند.

کلمات کلیدی به الگوریتم YouTube کمک می کنند تا بفهمد ویدیوی شما در مورد چیست و احتمال نمایش آن در ستون «پیشنهاد شده» در کنار ویدیوهای مرتبط (در زیر) و همچنین در نتایج جستجوی مرتبط بیشتر می شود. این بدان معناست که شانس بیشتری برای دستیابی به بینندگان جدید دارید.

کلمات کلیدی می توانند به سادگی یک کلمه باشند، اما عبارات دو یا چند کلمه اغلب به YouTube و افراد ایده بهتری از موضوع شما می دهد، مانند “تحلیل رقبای رسانه های اجتماعی”، همانطور که در مثال بالا مشاهده می کنید.

در اینجا زیاده روی نکنید – یک کلمه کلیدی در عنوان شما خوب است. به علاوه: آن را کوتاه نگه دارید.

بررسیها نشان میدهد که عناوین ویدیوهای کمتر از 10 کلمه بهترین عملکرد را در نتایج جستجوی YouTube دارند و 81٪ از ویدیوهای دارای رتبه برتر زیر این محدودیت قرار دارند.

مهمتر از آن، حداکثر 60 کاراکتر برای طول عنوان خود، که حدود 8 تا 10 کلمه (با فاصله) است، هدف بگیرید. شما مجاز به 100 کاراکتر هستید، اما فقط 60 نویسه اول در نتایج جستجو نشان داده می شود.

بی اطلاع از کلمات کلیدی؟ ما نکات بیشتری در مورد جستجوی کلمات کلیدی YouTube داریم، یا یک ابزار آنلاین رایگان مانند KeywordsPeopleUse را برای یافتن سریع … کلمات کلیدی مورد استفاده مردم امتحان کنید.

10. بر تجزیه و تحلیل خود نظارت کنید

برای رفتن به جلو، باید به عقب برگردید … در زمان. نه با Delorean، بلکه با بررسی تجزیه و تحلیل YouTube خود حداقل ماهانه.

تجزیه و تحلیل خود را در منوی سمت چپ در YouTube Studio پیدا کنید.

معیارهای کلیدی برای کمک به درک عملکرد کانالتان:

- مشترکین: از جمله لغو اشتراک

- ویدیوهای برتر: به مخاطبان خود آنچه را که می خواهند بیشتر بدهید

- زمان تماشای کانال: این باید هر ماه روند صعودی داشته باشد، یا ممکن است لازم باشد استراتژی محتوای خود را دوباره مرور کنید

- منابع ترافیک: ببینید بینندگان چگونه شما را پیدا می کنند، از جمله کلمات کلیدی جستجو

بهعلاوه، میتوانید دموگرافیک و موارد دیگر را کاوش کنید، از جمله آمار درآمد آگهی پس از برآورده کردن شرایط واجد شرایط بودن YouTube Partner Program برای کسب درآمد از محتوای خود.

11. محتوای خود را با لیست های پخش سازماندهی کنید

فهرستهای پخش YouTube به شما کمک میکنند در نتایج جستجو رتبهبندی بالاتری داشته باشید، زیرا کاربران بیشتر به تماشای ویدیوی بعدی ادامه میدهند، که بازدید کلی و زمان تماشای شما را افزایش میدهد—و باعث میشود YouTube فکر کند که شما بسیار باحال هستید.

میتوانید ویدیوهای سازندگان دیگر را به فهرستهای پخش خود اضافه کنید – که ایده خوبی برای همکاریهای بعدی است – اما در ابتدا خودتان آن را بسازید. ویدیوهای خود را بر اساس موضوع گروه بندی کنید یا یک سری خاص را با هم نگه دارید. (نکته جایزه: بعداً وقتی با یک حساب تأیید شده فانتزی بزرگ و مشهور شوید، می توانید لیست پخش سریال های رسمی ایجاد کنید.)

میتوانید فهرستهای پخش خود را در استودیوی YouTube مدیریت کنید محتوا > فهرستهای پخش یا با اضافه کردن سریع یک مورد جدید از بالا ايجاد كردن منو.

در اینجا یک نمونه از آنچه می تواند در کانال شما باشد آورده شده است:

12. با سایر کانال های یوتیوب همکاری کنید

یکی از راه های عالی برای افزایش دسترسی شما، همکاری با سایر YouTubers در ویدیوها است. برای مثال، اگر کانال دیگری به شما معرفی یا نام برده است، به مخاطبان جدیدی از مشترکین بالقوه دسترسی پیدا میکنید.

یک کانال YouTube را پیدا کنید که محتوای مشابه شما ایجاد کند (البته اگر یک برند هستید، بهتر است از رقبای مستقیم خودداری کنید و به جای آن روی کار با سازندگان یا مارک های مکمل تمرکز کنید) و در مورد شراکت صحبت کنید.

یک ویدیو (یا دو – یکی برای هر کانال) با هم ایجاد کنید، سپس از آن به عنوان راهی برای تبلیغ کانال های YouTube یکدیگر استفاده کنید.

13. ویدیوهای خود را زیرنویس کنید

زیرنویسهای بسته ویدیوهای شما باعث میشود محتوای شما برای همه قابل دسترس و فراگیر باشد. تقریباً از هر 5 نفر یک نفر درجاتی از اختلال شنوایی را تجربه می کند و حدود 5 درصد از جمعیت جهان ناشنوا یا کم شنوا هستند. زیرنویس تضمین می کند که هیچ یک از مخاطبان بالقوه خود را حذف نمی کنید.

میتوانید رونوشتهای نوشتاری خود را تهیه کنید یا از YouTube بهطور خودکار آن را با تشخیص خودکار گفتار زیرنویس کنید.

برای سازندگانی که تازه شروع به کار کردهاند، زیرنویسهای خودکار YouTube یک گزینه عالی است. اگر یوتیوب هر کلمه ای را اشتباه دریافت کرد، می توانید زیرنویس ها را ویرایش کنید، و ویرایش بسیار سریعتر از تایپ زیرنویس ها از ابتدا است.

با این حال، هنگامی که کانال شما شروع به رشد کرد یا درآمد کسب کرد، فردی را استخدام کنید تا به طور حرفه ای ویدیوهای شما را رونویسی کند. حتی فراتر بروید و روی ویدیوهای خود به چندین زبان زیرنویس کنید—YouTube زیرنویس ها را به زبان دلخواه بینندگان نشان می دهد—تا مخاطب جهانی ایجاد کنید.

5 نکته در سطح متخصص در کانال YouTube

به همه این نکات دیگر تسلط دارید؟ در اینجا چند نکته تخصصی برای کمک به شما برای رسیدن به سطح بعدی با کانال YouTube خود آورده شده است.

14. از کانال خود کسب درآمد کنید

وقتی شروع به رشد کانال خود کردید، چرا از یوتیوب درآمد کسب نکنید؟ این پلتفرم دارای یک طرح درآمدزایی عالی است و بهطور متوسط هر سازنده YouTube تقریباً 5000 دلار در ماه درآمد کسب میکند.

این بدان معناست که اگر بتوانید به آن پایبند باشید و طرفداران زیادی ایجاد کنید، یوتیوب میتواند یک سرگرمی جانبی عالی باشد – یا حتی جایگزین شغل تمام وقت شما شود.

برای کسب درآمد از کانال YouTube خود، باید در برنامه شریک YouTube (YPP) پذیرفته شوید. الزامات واجد شرایط بودن عبارتند از:

- از خط مشی های کسب درآمد از کانال YouTube پیروی کنید

- در یک کشور/منطقه واجد شرایط زندگی کنید

- دستورالعمل های جامعه را دنبال کنید

- تأیید صحت ۲ مرحلهای را روشن کنید

- دسترسی به ویژگیهای پیشرفته (شکل پیشرفته تأیید YouTube)

- یک حساب AdSense فعال مرتبط با کانال YouTube خود داشته باشید

- حداقل 1000 مشترک داشته باشید

- دارند یا 4000 ساعت تماشای عمومی معتبر در 12 ماه گذشته یا 10 میلیون بازدید عمومی معتبر Shorts در 90 روز گذشته

پس از رسیدن به آستانه، می توانید برای برنامه شریک YouTube درخواست دهید. در صورت پذیرش، میتوانید از تبلیغات نشان داده شده در ویدیوهای YouTube خود درآمد دریافت کنید.

15. YouTube Shorts را امتحان کنید

شورت های یوتیوب برای تبلیغ کانال شما بسیار مهم است که به ویژه برای سازندگان جدید مهم است. از سه ماهه دوم 2023، YouTube Shorts بیش از 2 میلیارد کاربر فعال ماهانه دارد.

Short ها ویدئوهای کوتاه عمودی مشابه ویدیوهای TikTok یا حلقه های اینستاگرام هستند. آنها در یک بخش اختصاصی شورتها نمایش داده میشوند که کاربران آنها را تند تند میکشند.

یک قطعه 15 ثانیه ای از آخرین ویدیوی خود بگیرید و آن را به صورت کوتاه آپلود کنید. بهتر از آن، در حین ویرایش هر ویدیو، چند قطعه از آن را بردارید و اکنون 2 تا 3 فیلم کوتاه برای انتشار در طول هفته دارید.

راهنمای YouTube Shorts ما را بخوانید تا نکاتی برای استفاده حداکثری از این قالب جدید هیجان انگیز داشته باشید.

16. استاد ویرایش ویدیو

محتوای YouTube شما – آنچه می گویید، نحوه بیان آن، ویژگی منحصر به فرد آن و غیره- چیزی است که مردم را جذب می کند، اما ویرایش خوب ویدیو چیزی است که باعث می شود آنها را تماشا کنند و برگردند.

ویرایش خیلی بیشتر از فیلمبرداری واقعی ویدیو طول می کشد، اما زمان خوبی صرف شده است. از یوتیوبرهای مورد علاقه خود الهام بگیرید تا شروع به کشف سبک و تکنیک های ویرایش خود کنید. ویدیوهای شما فوراً مانند ویدیوهای آنها شیک به نظر نخواهند رسید، اما بهتر خواهید شد.

روی نرم افزار ویرایش ویدیو با کیفیت بالا سرمایه گذاری کنید و حرفه ای شوید. این نه تنها ویدیوهای شما را بهتر و بهتر می کند، بلکه فرآیند ویرایش را بسیار سریعتر و آسان تر می کند.

بسته به بودجه خود، می توانید به محض راه اندازی کانال خود، به یک ویرایشگر ویدیوی حرفه ای برون سپاری کنید. با این حال، برای اکثر سازندگان، توانایی انجام این کار تنها پس از شروع کسب درآمد کانال آنها به دست می آید.

در هر صورت، مطمئن شوید که در ویرایش ویدیو تسلط دارید، سپس برای خود هدفی تعیین کنید که وقتی حساب YouTube شما شروع به ساخت مبلغ مشخصی در ماه کرد، یک ویرایشگر استخدام کنید. وقت شما را برای تمرکز بر تولید محتوا آزاد می کند.

17. در کنفرانس های یوتیوب شرکت کنید

شرکت در کارگاهها یا کنفرانسهایی را برای YouTuberها در نظر بگیرید که به سازندگان کمک میکنند درباره رشد کانالهایشان بیشتر بیاموزند. اینها همچنین می توانند مکانی عالی برای ایجاد شبکه و ایجاد ارتباط با سایر YouTubers باشند.

چند کنفرانس که باید در نظر گرفته شود عبارتند از:

- VidCon

- VidSummit

- اجلاس وب

این کنفرانسها میتواند مکانی عالی برای دریافت نکات رشد بیشتر، ارائه ایدههای جدید و یادگیری مهارتهای جدید باشد که میتواند به شما در بهبود بیشتر کانالتان کمک کند.

18. یک استراتژی توزیع محتوا ایجاد کنید

انتشار ویدیوهای یوتیوب خود در کانال خود و نامگذاری آن در یک روز تقریباً کافی نیست. شما به یک استراتژی توزیع محتوا نیاز دارید که بتواند به شما کمک کند حتی به مخاطبان بیشتری دسترسی پیدا کنید.

اگرچه تلاشهای سئوی YouTube شما باید به شما کمک کند تا دسترسی خود را در این پلتفرم افزایش دهید، راههای دیگری برای تبلیغ ویدیوهای خود در خارج از پلتفرم وجود دارد.

استراتژی تبلیغ ویدیوی YouTube شما باید شامل تاکتیکهایی مانند موارد زیر باشد:

- در سایر کانال های رسانه های اجتماعی خود به اشتراک بگذارید

- پیوند به خبرنامه ایمیل خود

- در انجمن ها و انجمن های آنلاین به اشتراک بگذارید

- در وبلاگ یا وب سایت خود جاسازی کنید

- از کارتهای ویدیویی YouTube و صفحههای پایانی برای پیوند دادن به ویدیوهای دیگر استفاده کنید

- لیست پخش ایجاد کنید تا محتوای مشابه را گروه بندی کنید

- برای تقویت ویدیوهای خود، تبلیغات YouTube را اجرا کنید

- با اینفلوئنسرهای YouTube شریک شوید تا به مخاطبان بیشتری دسترسی پیدا کنید

- از توضیحات ویدیوی خود به سایر ویدیوهای YouTube پیوند دهید

برای شروع و رشد کانال YouTube خود در سال 2024 آماده اید؟ با ناب فالوور ویدیوهای YouTube خود و سایر محتوای رسانه های اجتماعی خود را در یک مکان برنامه ریزی، منتشر و تجزیه و تحلیل کنید. امروز آن را رایگان امتحان کنید.

با فایل های از کلویی وست.

با ناب فالوور کانال YouTube خود را سریعتر رشد دهید. به راحتی نظرات را تعدیل کنید، ویدیو را برنامه ریزی کنید و در فیس بوک، اینستاگرام و X/Twitter منتشر کنید.