جزئیات پنهان شما ممکن است در WWE 2K25 از دست داده باشید

مواردی وجود دارد که انتظار دارید در هر بازی WWE 2K مشاهده کنید: تصاویر چشمگیر ، سوپراستارهایی که سزاوار رتبه بندی بهتری هستند ، و تخم مرغ های عید پاک و جزئیات کوچک. WWE 2K25 شامل تمام این مجموعه های سری است.

مربوط

9 سوپر استار با رتبه برتر در WWE 2K25

بهترین فوق ستاره های زنان در WWE 2K25.

این بازی پر از اشارات کمی به چیزها ، به ویژه رقیب اصلی WWE ، AEW است. همچنین تخم مرغ های عید پاک در مورد تاریخ WWE و بازی های قبلی در این سریال وجود دارد. در مورد جزئیات ، تعداد زیادی از موارد کوچک در این بازی وجود دارد که به راحتی از دست می روند. آنها تفاوت زیادی در لذت شما از بازی ایجاد نمی کنند ، اما توجه توسعه دهندگان را به جزئیات نشان می دهند. در اینجا برخی از برجسته ترین تخم مرغ ها و جزئیات عید پاک آورده شده است.

10

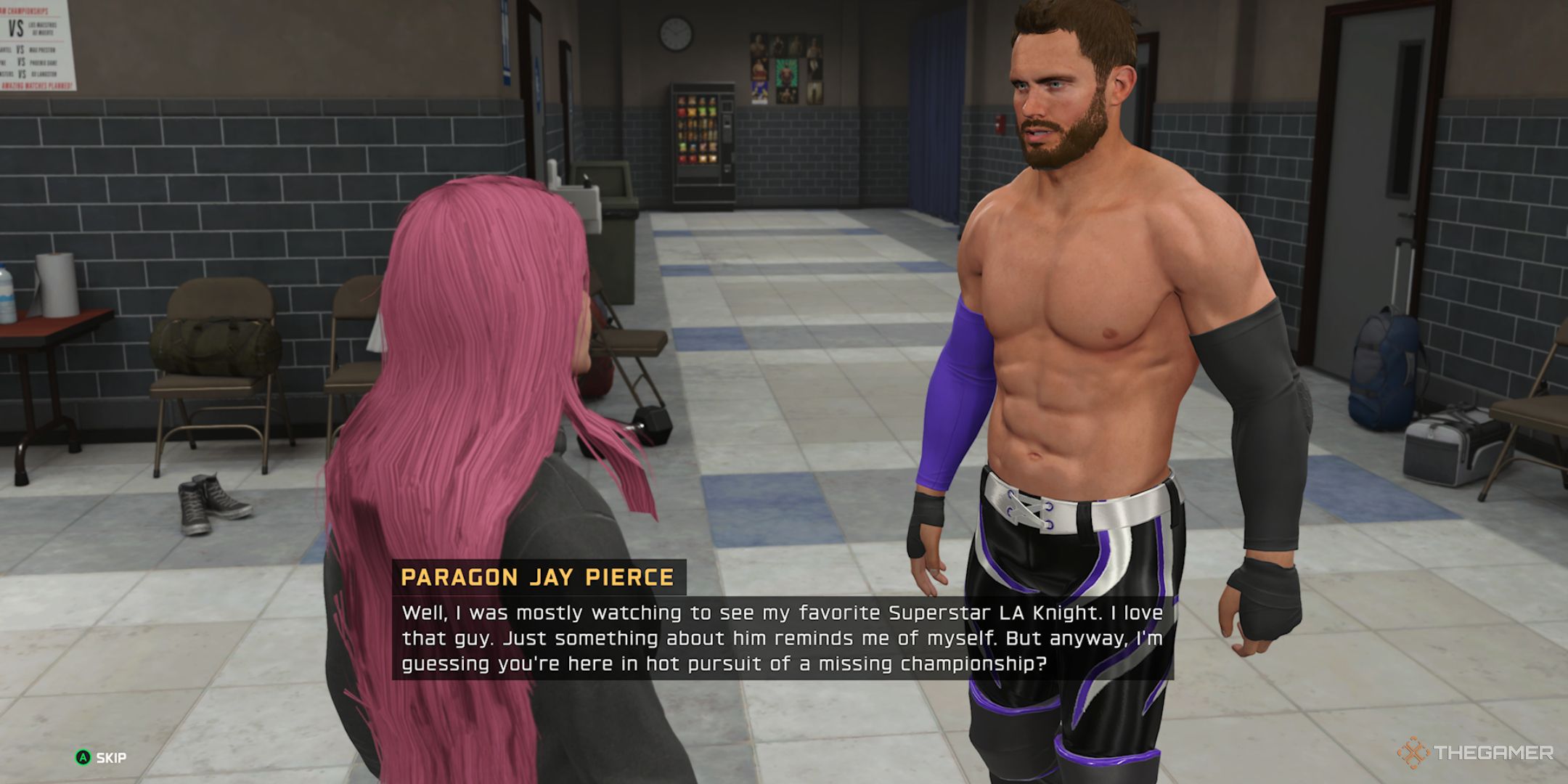

پاراگون جی پیرس عاشق لا نایت است

در myrise شنیده می شود

در حین حالت Myrise ، ممکن است به Paragon Jay Pierce بروید. او یک کشتی گیر داستانی غیر WWE است که گاهی در این بازی ها ظاهر می شود. وقتی او را در WWE 2K25 می بینید ، او داستان را به جلو سوق می دهد و در عین حال ستایش های زیادی را نیز به La Knight می دهد.

او می گوید که نایت کشتی گیر مورد علاقه اوست و آن نایت خودش را به یاد زیادی می برد. این امر به این دلیل است که ، در WWE 2K22 ، La Knight شخصیت را ابراز کرد ، بنابراین این یک مرجع خنده دار به آن است.

در جزیره می توان پیدا کرد

در این جزیره ، اشاراتی روشن زیادی به Superstars WWE وجود دارد ، اما موارد پنهان نیز وجود دارد. به عنوان مثال ، یک گورستان با سنگ قبرهای اختصاص داده شده به برخی از حیواناتی که در تلویزیون WWE دیده می شوند وجود دارد.

یکی برای دیمین وجود دارد ، که نامی به جیک “مار” رابرتز داده شده بود که او به حلقه می آورد. Peper ، که در یک داستان بسیار بحث برانگیز به نمایش در آمد ، یک سنگ برفی است ، یک سنگ بنای گل اسنووواوا ، فلفل ، که در یک داستان بسیار جنجالی به نمایش گذاشته شده بود ، می شود. همچنین یک عنکبوت با یک ورق روی آن وجود دارد ، که به نظر می رسد به تارانتلا که اریک روون برای حمل حلقه استفاده می کرد ، اشاره دارد. سرانجام ، یک قبر اختصاص به Gobbledy Goker ، شخصیتی بدنام که در تلویزیون WWE دیده می شود ، وجود دارد.

8

مرجع شاون اسپیرز

در طول مسابقات می توان شنید

هنگامی که برخی از فوق ستاره ها در طول مسابقه از زیر رینگ سلاح می گیرند ، مفسران خطوط منحصر به فردی در مورد آن دارند. به عنوان مثال ، آنها بخش بزرگی از Sandman را در حال گرفتن چوب کندو می سازند ، حتی آن را یک عصای سنگاپور می نامند ، این همان چیزی است که اغلب هنگام استفاده از آن نامیده می شد.

مربوط

8 نمایش بزرگ مشهور در بازی های WWE

به ستاره مورد علاقه خود آرنج مردم بدهید.

جالب ترین مورد این است که شاون اسپیرز صندلی را به دست می گیرد زیرا مفسران نام مستعار قدیمی خود ، رئیس را مطرح می کنند. این نکته قابل توجه است زیرا وقتی او در تبلیغات رقیب کار می کرد ، حیرت او بود.

7

اتصال آوا و جو گسی

در mygm شنیده می شود

Ava Raine به عنوان مدیر کل در MYGM گزینه ای است. اگر او انتخاب شود و سپس جو گسی را در پیش نویس انتخاب کند ، بایرون ساکستون گفتگوی بی نظیری را ارائه می دهد. او می گوید ، “آوا جو گسی را انتخاب می کند ؛ بدیهی است که هیچ گونه تشییعی در آنجا وجود ندارد.”

اصطلاح “شکاف” به معنای تقسیم بین دو طرف کاملاً مخالف است. تشیع همچنین نام جناح NXT بود که هم جو گسی و هم آوا بخشی از سال 2022 تا 2023 بودند. این یک مرجع هوشمندانه برای تیم است.

6

صداهای امضای میک فولی

در طول مسابقات می توان شنید

اگر تا به حال یک مسابقه را با میک فولی تماشا کرده اید ، ممکن است متوجه سر و صداهای وحشی او هنگام حمله به حریف خود شده باشید. او اغلب مانند یک حیوان وحشی به نظر می رسد.

اگر شما به عنوان یکی از حیله های مختلف او بازی کنید ، در WWE 2K25 نیز این مورد است: بشر ، کاکتوس جک یا عشق شخص. او همان صداهای عجیب و غریب را ایجاد می کند. مفسران در مورد آن صحبت می کنند ، بنابراین شما باید آنها را در تنظیمات صوتی رد کنید تا بتوانید فریادها و جیغ های عجیب و غریب را بشنوید. این یک تخم مرغ عید پاک کوچک خوب برای طرفداران فولی است.

5

کارلیتو در واقع سیب خود را نیش می زند

در طول مسابقات دیده می شود

سلاح امضای کارلیتو در بازی اپل قابل اعتماد اوست. هنگام استفاده از آن ، او یک حمله بی نظیر و منحصر به فرد دارد که او را درگیر نیش سیب خود و تف کردن آن در چهره حریف خود می کند ، همانطور که او شناخته شده است. نکته جالب این است که ، مانند بسیاری از سلاح های دیگر ، اپل استفاده نامحدود ندارد.

این امر به این دلیل است که کارلیتو در واقع نیش را از آن خارج می کند. این کار با یک نیش شروع می شود ، پس اگر این کار را به اندازه کافی انجام دهد ، او فقط با هسته سیب باقی مانده است ، بنابراین او آن را به زمین می اندازد. این یک جزئیات پنهان کوچک اما بسیار جالب است. همچنین باعث می شود کارلیتو از بازی بیشتر از برخی از کشتی گیران با بالاترین رتبه بازی لذت بخش تر شود.

4

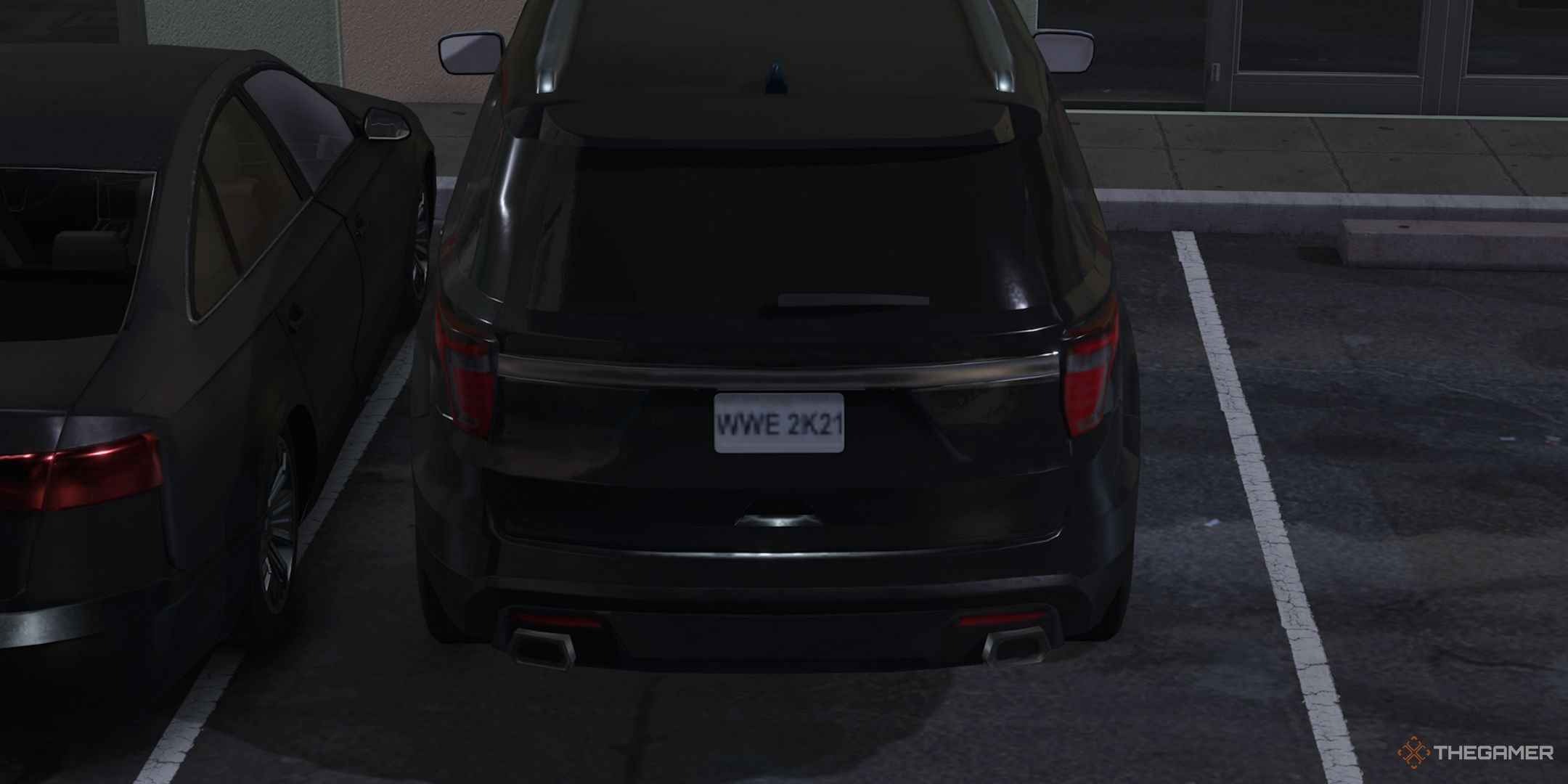

پلاک WWE 2K21

در حین نزاع های پشتی یافت می شود

هنگامی که در پارکینگ NXT می جنگید ، می توانید وسیله نقلیه ای با پلاک “WWE 2K21” پیدا کنید. اهمیت این امر این است که WWE 2K21 بازی ای بود که هرگز بیرون نیامد. ورود قبل از آن یک آشفتگی شکسته بود ، و سپس Covid اتفاق افتاد. بنابراین ، عنوان به پایان رسید.

مربوط

10 کشتی گیر با بیشترین حضور در بازی های WWE

بازی های WWE شامل ستاره های جدید با هر ورودی است ، اما افسانه ها همیشه در آنجا هستند.

با این حال ، 2K با تبدیل شدن به آن به یک پلاک ، یک روش دزدکی پیدا کرده است که هنوز هم WWE 2K21 را در این سریال قرار می دهد. به نظر می رسد هیچ چیز خاصی در مورد وسیله نقلیه ای که به آن وصل شده است خاص نیست. شاید این باید لاستیک های مسطح یا چیزی داشته باشد تا این واقعیت را نشان دهد که WWE 2K21 به جایی نرفت.

3

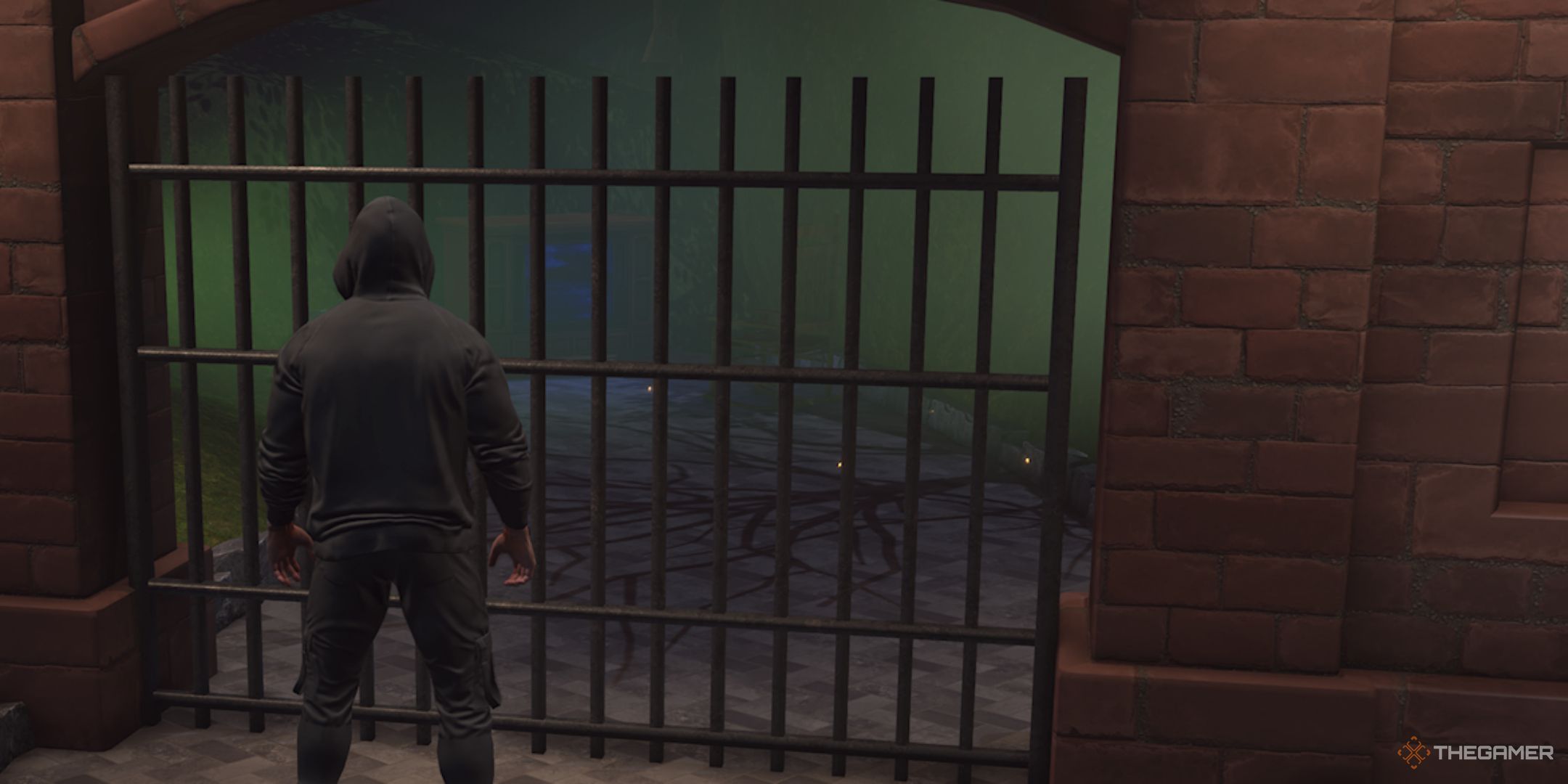

Firefly Funhouse در جزیره

در جزیره می توان پیدا کرد

یکی از تخم های عید پاک سخت تر برای ضربه در پشت دروازه ای در جزیره قفل شده است. اگر به سمت راست آن بروید و از نزدیک نگاه کنید ، می توانید یک مجموعه تلویزیونی مدرسه قدیمی و یک صندلی تکان دهنده را ببینید.

این یک اشاره به اواخر و بزرگ بری ویات است. به طور خاص ، این مربوط به Firefly Funhouse است که یک نسخه پیچیده از نمایش کودکان بود که بری وات برای مدتی میزبان آن بود. این ادای احترام خوبی به سوپراستار نمادین WWE است.

2

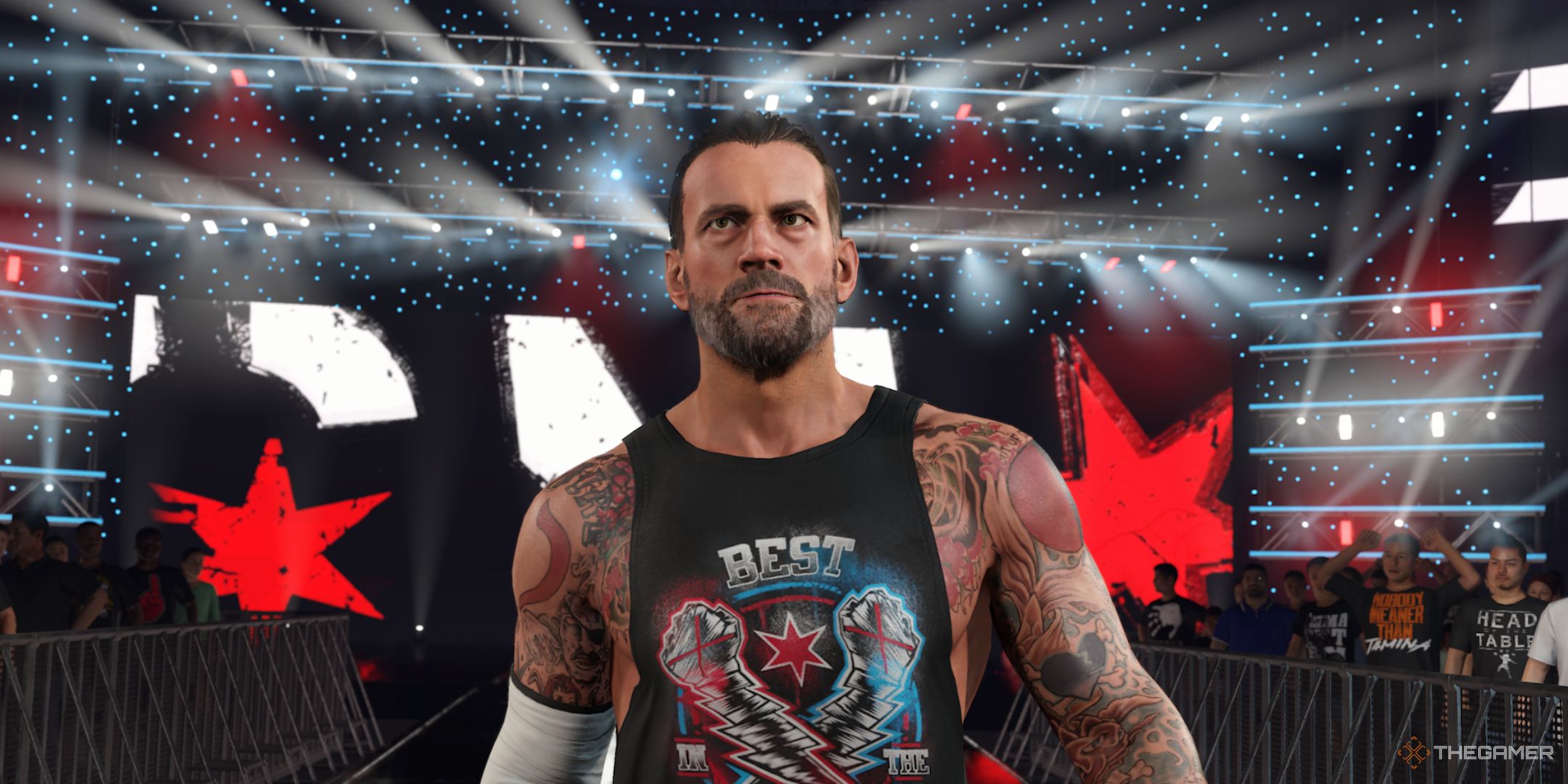

CM Punk به بازدید غافلگیرانه خود از RAW مراجعه می کند

در myrise شنیده می شود

در سال 2023 ، در حالی که هنوز برای AEW کار می کرد ، CM Punk برای یک قسمت از RAW در پشت صحنه قرار گرفت تا به مردم سلام کند. این یک داستان بزرگ بود زیرا پانک هنگام ترک سال 2014 با WWE مشهور بود و اکنون با رقبای خود کار می کرد. او نمی توانست در دوربین یا هر چیز دیگری ظاهر شود ، و افراد مسئول در آن زمان در واقع از او خواستند که ترک کند.

با این وجود ، این یک لحظه قابل توجه در پشت صحنه بود که در حالت Myrise WWE 2K25 به آن اشاره شده است. پانک درون بازی بدون اینکه بیش از حد به قلمرو Myrise Spoiler برود ، می گوید که بازدید وی از RAW منجر به اقدامات وی در داستان شد.

1

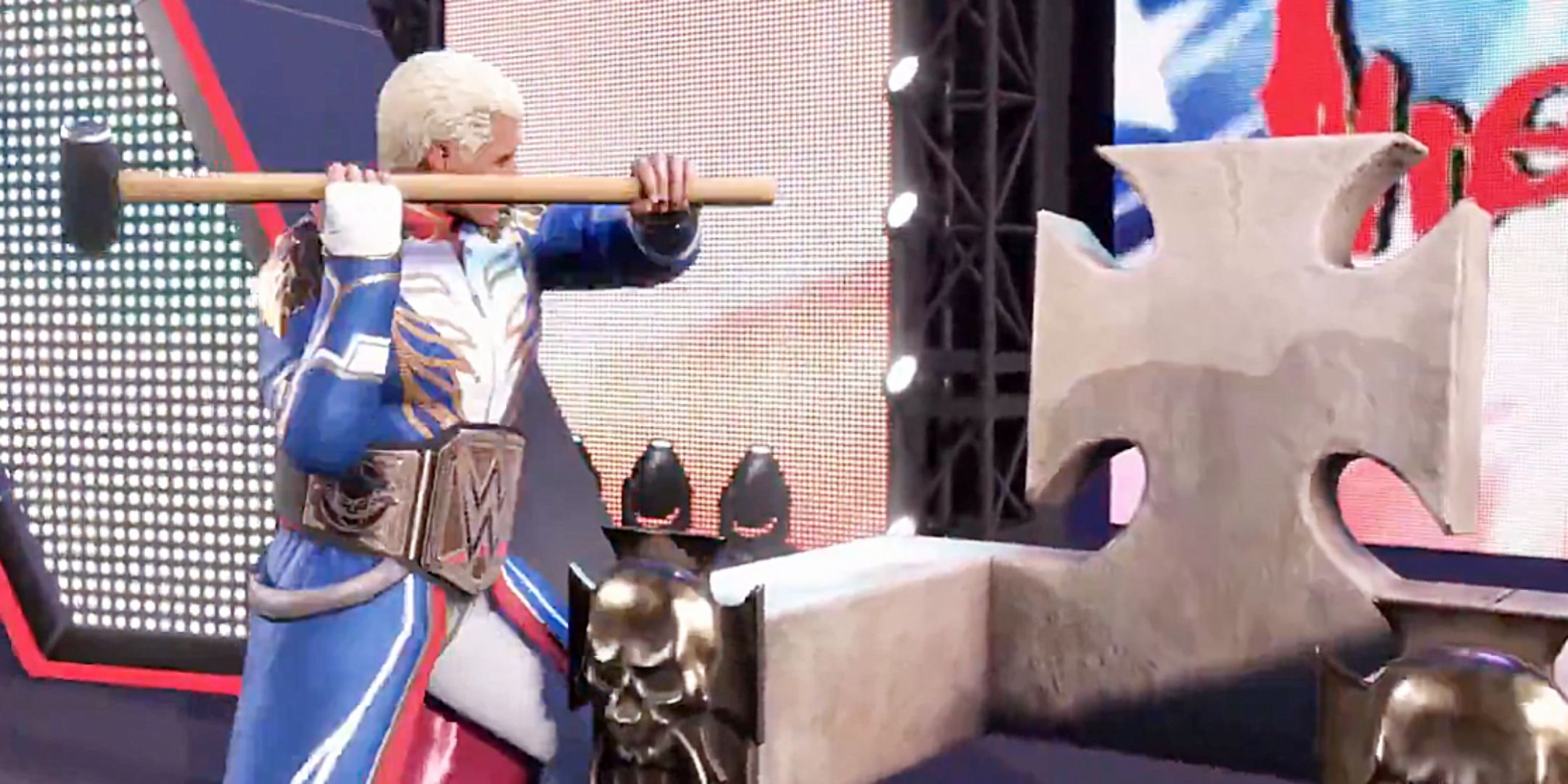

ورودی ویژه با الهام از AEW

می تواند در myrise باز شود

در حین Myrise ، می توانید یک ورودی ویژه “Throne Smasher” را باز کنید ، که شامل یک کشتی گیر است که بیرون می آید و تاج و تخت سنگی را که Triple H قبلاً به عنوان بخشی از ورودی خود استفاده می کرد ، می ریزد. آنها این کار را با سورتمه امضای سوپراستار انجام می دهند تا توهین به آسیب را اضافه کنند.

این یک گره واضح به زمانی است که کودی رودز در زمان حضور خود در AEW ورودی مشابهی را انجام داد. در حقیقت ، اگر آن را به عنوان ورودی رودس تنظیم کنید ، تفسیر ویژه ای وجود دارد که ویرانی وی را از تاج و تخت تصدیق می کند. بنابراین ، در WWE 2K24 ، رودز یکی از بهترین پوشش های بازی سریال را بدست آورد و اکنون او یکی از بهترین ورودی ها را دریافت می کند.