نکات حرفه ای برای Roblox: رشد یک باغ

Roblox: یک باغ را پرورش دهید به عنوان یک بازی ساده کشاورزی شروع می شود ، اما شما به سرعت یاد خواهید گرفت که یک هنر برای قرار دادن محصول و درآمدزایی وجود دارد. مطمئناً ، همه می توانند در یک مزرعه اساسی غرق شوند و یک مزرعه اساسی را راه اندازی کنند ، اما برای دستیابی به عظمت ، کمی بیشتر فکر می کند.

مربوط

اگر به دنبال تبدیل شدن به یک حرفه ای هستید ، به جای مناسب رسیده اید. در این راهنما نگاهی به برخی از نکات حرفه ای برای Roblox خواهیم انداخت: یک باغ را رشد دهید. این فراتر از اصول اولیه است ، بنابراین اگر با بازی خیلی آشنا نیستید ، ممکن است اینها مفیدترین نباشند.

محصولات زراعی کمتری را از بین ببرید

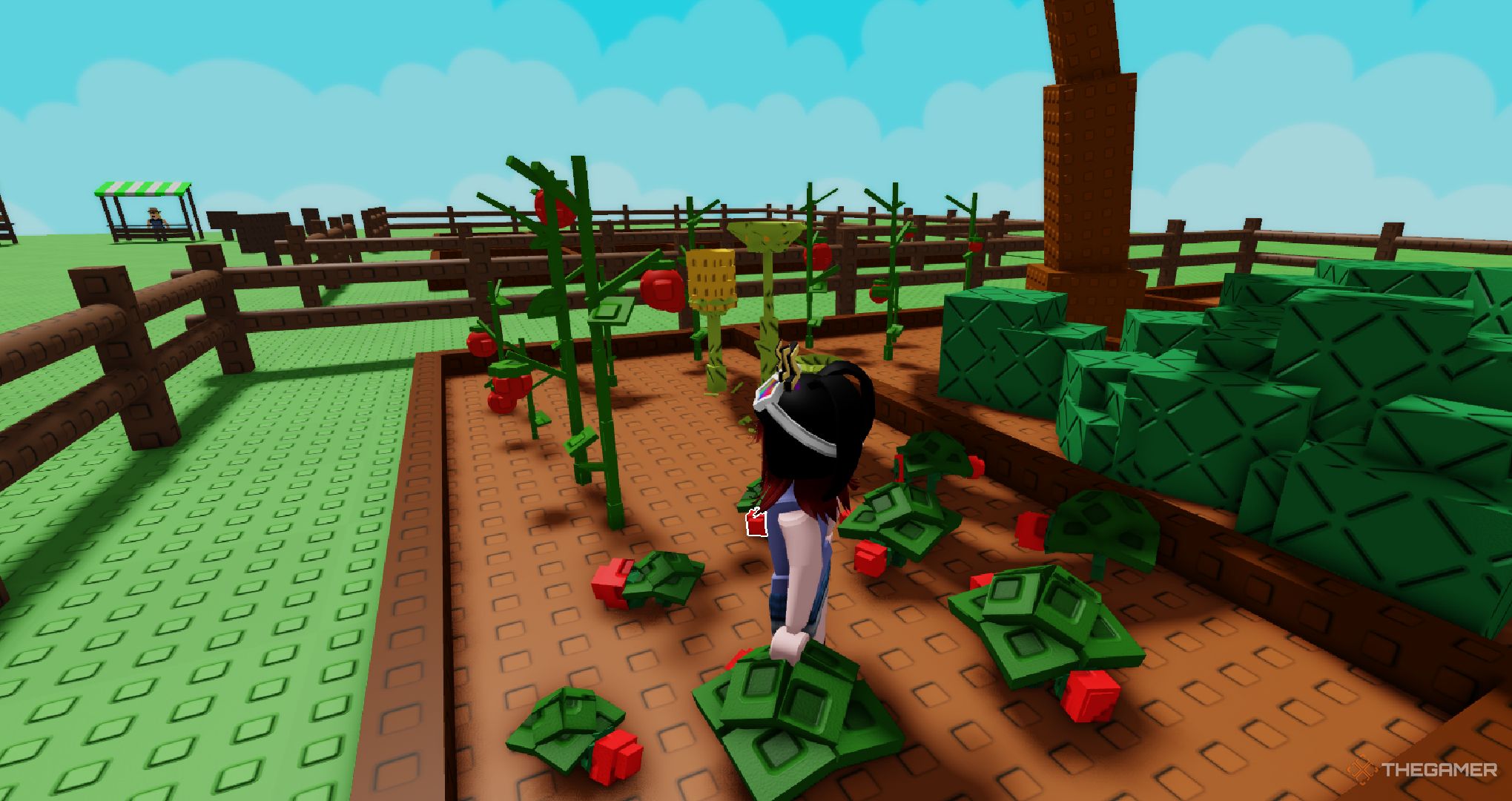

ابزار پیش فرض که با آن شروع می کنید بیل است که برای از بین بردن محصولات زراعی استفاده می شود. اگر هنوز روی زغال اخته و توت فرنگی متمرکز شده اید ، این خیلی مفید نیست ، اما هنگامی که دانه های بهتری را شروع کردید ، می خواهید برای آنها جای دهید.

به جای اینکه بخشی از مزرعه خود را به بوته های زغال اخته اختصاص دهید ، فقط آنها را از بین ببرید تا جایی برای درختان بزرگتر یا قارچ ایجاد کنید. شما از این دانه های گران قیمت بیشتر از گذشته با زغال اخته درآمد بیشتری کسب خواهید کرد. به طور کلی ، دریغ نکنید که هر چیزی را که به اندازه کافی پول شما را به وجود نمی آورد ، از بین نبرید.

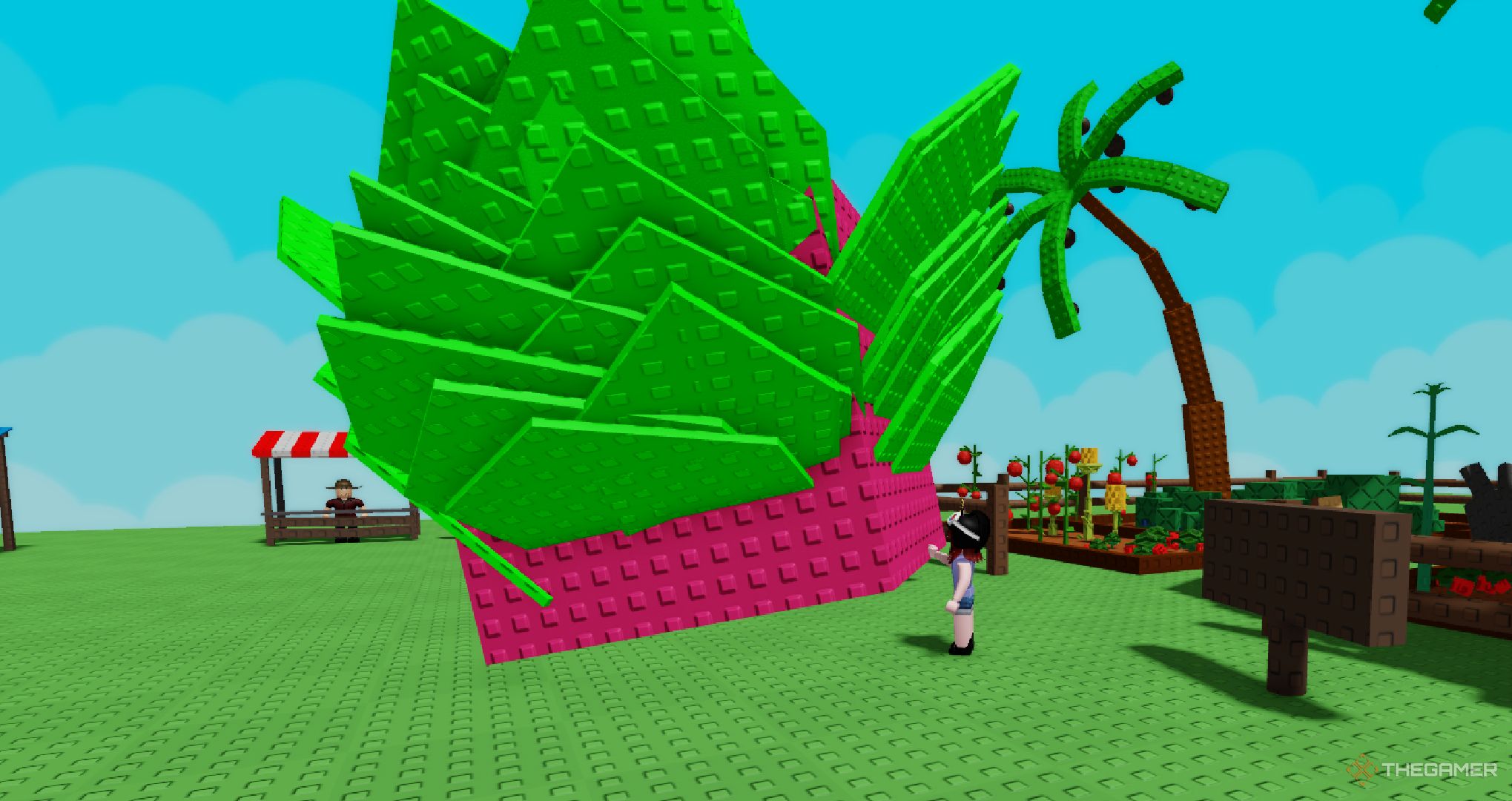

بعضی اوقات ، یک تلاش روزانه شما را ملزم به جمع آوری مقدار مشخصی از محصولات با سطح پایین می کند. با توجه به این نکته ، بهتر است بخش کوچکی از مزرعه خود را به این محصولات زراعی اختصاص دهید. ما دریافتیم که فضای زیر درختان میوه اژدها برای مواردی مانند هویج و کدو تنبل ، یک منطقه بزرگ (و کوچک) در حال رشد را ایجاد می کند.

آبپاش ها را تنظیم کنید

اندازه و جهش های احتمالی محصولات زراعی شما چقدر می فروشد. محصولات زراعی مانند هویج ممکن است در هنگام جهش افزایش یابد ، اما هنگام نگاه به قیمت پایه برخی از کالاهای نادر ، خیلی زیاد نیست. اگر محصولات پرفروش بالایی دارید ، ما به شدت توصیه می کنیم در آبپاش سرمایه گذاری کنید.

به فروشگاه دنده بروید و ببینید که آیا آبپاش ها برای خرید در دسترس هستند یا خیر. شایان ذکر است که گزینه های آبپاش کمی گران هستند ، بنابراین ممکن است شما نیاز به صرفه جویی در مصرف داشته باشید. از طرف دیگر ، در صورت داشتن کافی می توانید آنها را با روبو خریداری کنید.

اردوگاه در فروشگاه بذر

بهترین راه برای گرفتن بذر این است که اساساً فقط اردو زدن در فروشگاه بذر است. اگر احساس نمی کنید محصولات خود را جمع آوری کنید و به طور کلی در حال اجرا هستید ، شما باید در مغازه بذر بایستید و منتظر تازه سازی باشید.

مغازه هر پنج دقیقه دوباره تنظیم می شود ، به این معنی که بعد از پنج دقیقه ، این احتمال وجود دارد که یک دانه نادر در دسترس باشد. در حالی که قطعاً این فرصت زیاد نیست ، اما هنوز هم ارزش انتظار آن را دارد. چه می شود اگر یک بذر فوق العاده نادر کاکائو را از دست دادید؟

از دانه های برداشت یک بار خودداری کنید

دانه هایی که محصول برداشت یک بار را فراهم می کنند ممکن است جذاب به نظر برسند ، اما در دراز مدت ، آنها ارزش آن را ندارند. پس از برداشت ، باید یک دانه دیگر بخرید و سپس روند قرار دادن آن را در مزرعه خود در مکانی که کار می کند طی کنید. پس از رشد ، باید دوباره روند کار را انجام دهید.

محصولات چند برداشت در حال رشد هستند ، به این معنی است شما اساساً محصول را به طور نامحدود دریافت خواهید کرد. پس از کاشت ، شما نیز نیازی به نگرانی در مورد قرار دادن دانه های آینده نخواهید داشت ، زیرا در همان نقطه باقی خواهد ماند (مگر اینکه تصمیم بگیرید آن را نابود کنید).

این قانون قطعی نیست. به عنوان مثال ، ما طرفداران عظیمی از بامبو هستیم ، زیرا می توان از آنها برای صعود به اطراف و رسیدن به محصولات زراعی استفاده کرد که به طور معمول دشوار هستند. سعی کنید بامبو را در نزدیکی درختان کوتاه تر نیز قرار دهید ، که به شما امکان می دهد از بالا صعود کنید!

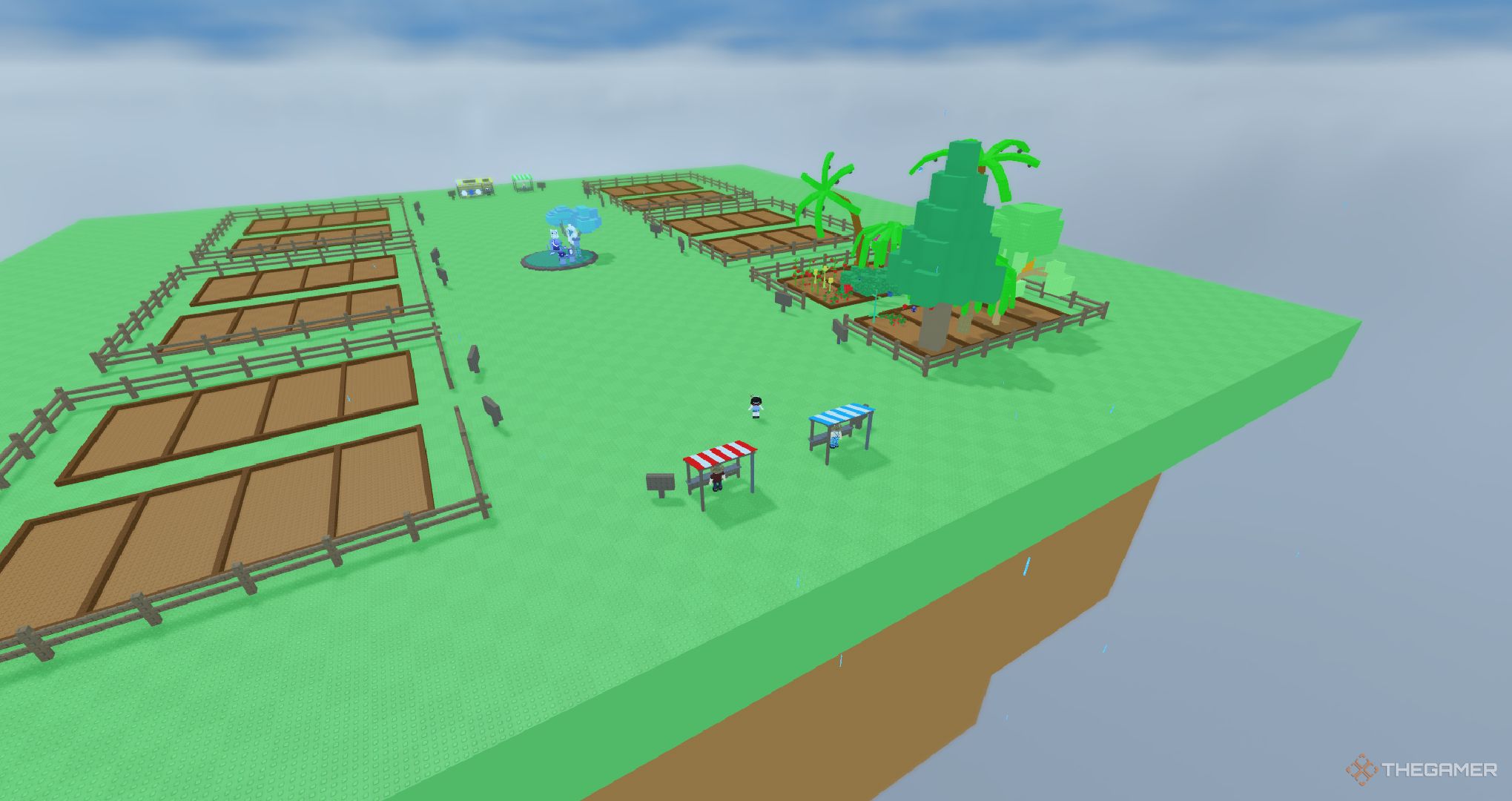

در یک سرور خصوصی در صلح بازی کنید

رشد یک باغ روی Roblox است ، به این معنی که شما مجبور هستید به بازیکنان دیگر بروید. اگر شخصی در سرور شما روبو به اندازه کافی دارد ، آنها حتی ممکن است کمی برای سرقت محصولات شما هزینه کنند. اگر یک محصول ارزشمند در حال رشد است ، ممکن است آن را از شما به سرقت ببرد.

به جای برخورد با سایر بازیکنان ، می توانید سرور خصوصی خود را به صورت رایگان بسازید. پس از ساخت ، فقط بارگذاری کنید و تنها بازیکن خواهید بود. شما می توانید رشد انفرادی یا دعوت از سایر بازیکنان برای پیوستن به شما. به هر صورت ، لازم نیست که اشیاء با ارزش خود را به خطر بیندازید.

دزدی با روبو

اگر می خواهید کمی هرج و مرج ایجاد کنید ، چه می کنید؟ اگر روبوکس را در دست دارید ، شما می توانید از دیگران دزدی کنید. برای سرقت یک مورد ، باید 37 روبو را خرج کنید. اگر می توانید دست خود را به چیزی ارزشمند و جهش یافته بدست آورید ، می توانید پول زیادی کسب کنید.

یا اگر احساس هرج و مرج بیشتری دارید ، می توانید محصول را با بازیکن دیگری یا با بازیکنی که آن را از آن دزدید کرده اید ، تجارت کنید. هرچند از این قدرت سوء استفاده نکنید ، زیرا برخی از افراد فقط به دنبال استراحت و رشد مزرعه خود هستند.

همه فقط سعی می کنند در هنگام بازی اوقات خوبی داشته باشند ، بنابراین اگر کسی ابراز بیزاری خود را نسبت به سرقت شما بیان کند ، سعی کنید از این کار خودداری کنید. اگر نمی خواهید محصولات خود را به سرقت برده باشید ، می توانید ابزار مورد علاقه خود را از فروشگاه Gear با قیمت 20،000،000 دلار خریداری کنید. این مانع از جمع آوری میوه های خاص می شود.

حیوانات خانگی را فراموش نکنید

به نظر می رسد که هر بازی Roblox در آنجا دارای حیوانات خانگی است. در بعضی از بازی ها ، آنها فقط یک نماد وضعیت هستند. هر چند در یک باغ رشد کنید ، حیوانات خانگی یک هدف را ارائه می دهند. به عنوان مثال ، اسم حیوان دست اموز سیاه منفعلانه هویج هایی را که رشد کرده اید می خورد و درآمد کمی بیشتر از آنکه بخواهید آن را به مغازه بفروشید.

برخی از حیوانات خانگی حتی توانایی های منفعل بهتری دارند. به عنوان مثال ، جوجه تیغی (که در تخم مرغ شب یافت می شود) خواهد شد برای میوه های خاردار که در مزرعه خود در حال رشد هستید ، یک امتیاز اندازه فراهم کنید. اگر پول کافی برای پس انداز دارید ، توصیه می کنیم فروشگاه تخم مرغ را بررسی کنید.

رویدادها همچنین می توانند تخم مرغ های جدیدی را به صورت رایگان و با هزینه روبو به همراه آورد.

محصولات برداشت انبوه

آخرین و مهم نیست ، لازم به ذکر است که می توانید محصولات زراعی برداشت انبوه بدون صرف هرگونه روبو. اگر در رایانه شخصی بازی می کنید ، می توانید دکمه برداشت (E) را نگه دارید و تمام محصولات موجود در مجاورت خود برداشت می شوند.

بنابراین ، اگر در میان زمینه ای از بوته های زغال اخته ایستاده اید ، می توانید در مرکز بایستید و فقط E را نگه دارید تا همه آنها را بگیرید. این اراده به طور مداوم یکی را در یک زمان جمع کنید ، اما قطعاً در حالی که مواجهه با هر محصول است ، به طور مکرر فشار می یابد.

همچنین خوب است بدانید که وقتی در حال برداشت از مناطق با دسترسی سخت هستید ، می تواند مفید باشد. به عنوان مثال ، بیایید بگوییم که برای برداشت نارگیل خود از کنار درخت نخل بالا می روید ، اما برخی از آنها دور از دسترس هستند. به جای اینکه آنها را ترک کنند ، هنگام نگه داشتن E از درخت از درخت پرش کنید. این باعث می شود شما هرگونه نارگیل را به طور خودکار در محدوده بگیرید.

طرف دیگر

Roblox: رشد یک باغ – راهنمای کامل آب و هوا

از طریق باران و رعد و برق ، بهترین راه برای مقابله با آب و هوا در باغ شما است.