بهترین فضایل سلطنتی برای افزایش اول در استعاره: ReFantazio

Summarize this content to 400 words in Persian Lang

استعاره: ReFantazio در هسته خود درباره شخصیت هایی است که با آنها ملاقات می کنید و پیوندهایی که با آنها ایجاد می کنید. اما برای به حداکثر رساندن تمام پیوندها با پیروان مختلف خود، باید قهرمان داستان را به رهبری تبدیل کنید که بتواند از صمیم قلب حمایت کند، و برای این کار، باید روی فضایل سلطنتی او کار کنید.

مرتبط

استعاره: ReFantazio – 8 کاری که بعد از شکست بازی باید انجام دهید

اجازه ندهید زمان شما در Metaphor: ReFantazio بدون بررسی این موارد به پایان برسد.

پنج مورد از این ویژگیهای شخصیتی وجود دارد که میتوانید در طول بازی آنها را ارتقا دهید، و در حالی که همه آنها مهم هستند، برخی از آنها به تلاش فعالتری نسبت به دیگران نیاز دارند. برای به حداکثر رساندن همه پیوندها، باید هر یک از این ویژگی ها را به حداکثر برسانید، اما برای داشتن راحت ترین سفر ممکن. بهترین فضایل سلطنتی برای افزایش ابتدا در استعاره: ReFantazio کدامند؟

5

شجاعت

قرار دادن در چهره شجاع

در طول داستان Metaphor: ReFantazio، قهرمان شما باید شجاعت خود را به روشهای مختلف نشان دهد، اما برای نشان دادن این شجاعت در داستانهای باند، باید روی ارتقای آمار شجاعت خود کار کنید.

در حالی که این وضعیت اجتماعی برای ارتقای اوراق قرضه بیشتر در اواسط یا اواخر بازی مورد نیاز است، شما نیازی به توجه فعالانه به این پیوند ندارید، زیرا بیشترین فرصت ها برای کار روی این فضیلت سلطنتی در طول بازی های دیگر به شما داده می شود. وظایف

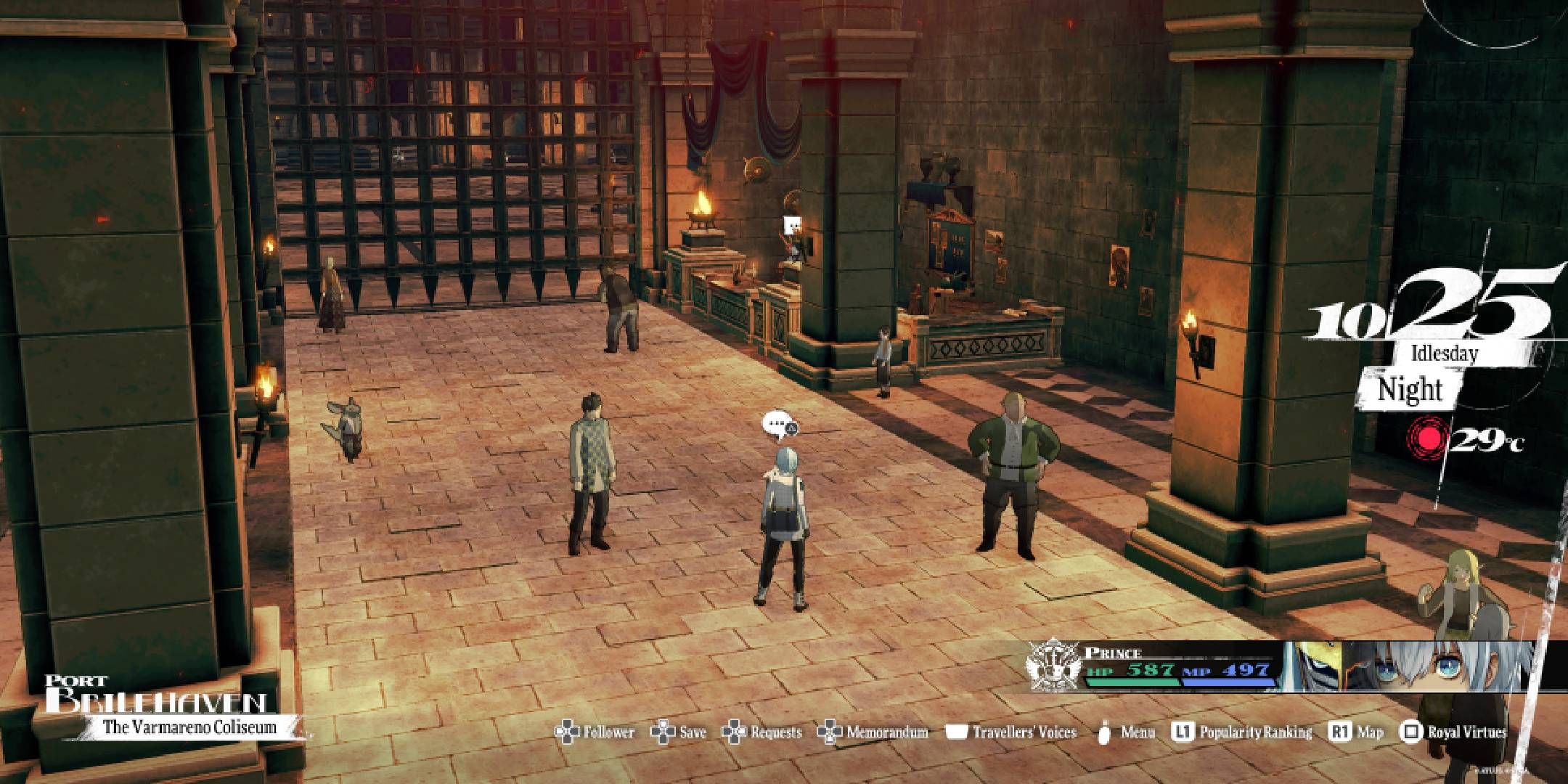

به عنوان مثال، توصیه میشود که تمام پاداشهای موجود را تکمیل کرده و کیف پول خود را پر نگه دارید، اما برای هر یک از این موارد، چند امتیاز شجاعت نیز دریافت خواهید کرد. علاوه بر این، اگر قبل از یک ضرب الاجل وقت آزاد دارید، توصیه میشود در کولیزئوم در Brilehaven تلاش کنید و کار کنید، و علاوه بر پاداشها و تجربههای بینظیری که از این کار به دست میآورید، جسارت نیز خواهید داشت.

همچنین فرصتهای زیادی برای بالا بردن شجاعت خود در دونده دستکش به دست خواهید آورد، زیرا استرول، یکی از اولین اعضای حزبی که به دست میآورید، اغلب این فرصت را به شما میدهد که در سفر با او شجاعت خود را افزایش دهید. با تشکر از تعداد شانسهایی که برای ارتقای این آمار در طول فعالیتهای دیگر دارید، نیازی نیست که به این آمار توجه فعال داشته باشید.

4

خرد

دانش پادشاهی شما

به لطف مدت زمان ماجراجویی Metaphor: ReFantazio، در نهایت در مورد کشور Euchronia و مردم آن چیزهای زیادی یاد خواهید گرفت، اما باید زمان زیادی را صرف آموزش این درسها به قهرمان داستان با بالا بردن آمار خرد او کنید.

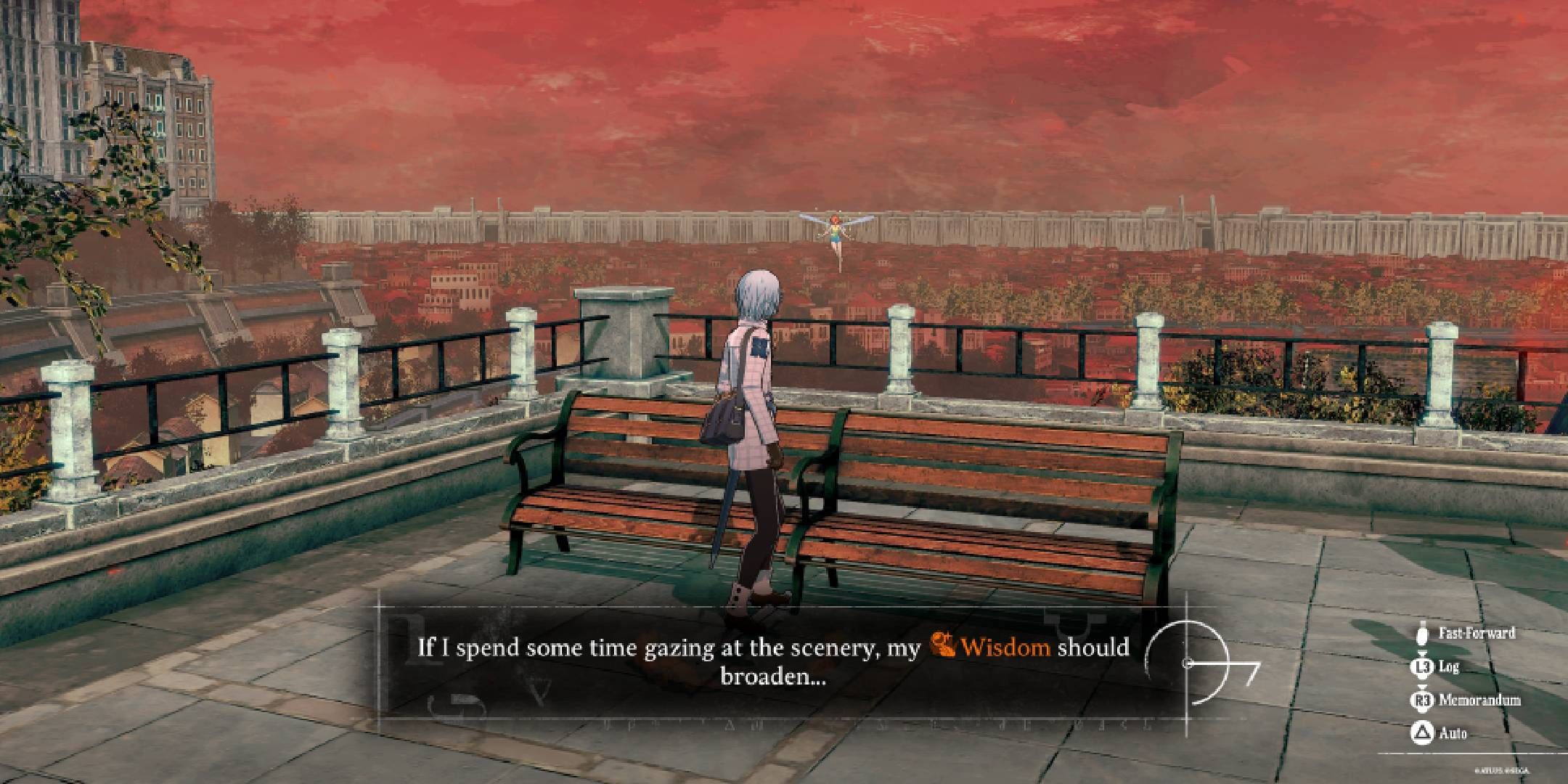

مشابه شجاعت، می توانید با انجام کارهایی که در غیر این صورت انجام می دادید، خرد به دست آورید. به عنوان مثال، زمانی که با Gauntlet Runner سفر میکنید، گاهی اوقات برای تماشای مناظر و گپ زدن با اعضای مهمانی خود استراحت میکنید. هر بار که این اتفاق میافتد، قفل کارتپستالی از Neuras را باز میکنید که میتوانید به ماریا بدهید، اما همچنین یک کمک هزینه خرد سالم نیز دریافت خواهید کرد.

مرتبط

استعاره: ReFantazio – 8 بهترین مهارت برای به ارث بردن

ترکیب و مطابقت کهن الگوها در استعاره: ReFantazio با به ارث بردن مهارت ها.

علاوه بر این، هالکنبرگ به محض اینکه قفل این حالت حمل و نقل را باز کنید، در دونده Gauntlet شما خواهد بود، و او اغلب آزاد است تا درس های استراتژی ارائه دهد تا در طول ماجراجویی نیز خرد بیشتری به شما بدهد.

فقط با درگیر شدن با بیشتر ویژگی های ارائه شده به شما باید بتوانید مقدار کاملی از خرد را در اواسط یا اواخر بازی به دست آورید، اما ممکن است لازم باشد در ابتدا آن را کمی فعال تر کنید، زیرا چند مورد قبلی پیوندها برای پیشرفت نیاز به خرد پایینی دارند. با این حال، اینها به سرعت از بین نمی روند، بنابراین عجله زیادی نیز وجود ندارد.

3

تحمل

یاد بگیرید که مردم خود را دوست داشته باشید

در مقایسه با شجاعت و خرد، سه فضیلت سلطنتی دیگر بسیار کمتر در طول فعالیتهای استاندارد انجام میشوند، و به همین دلیل، این سه فضیلت هستند که به احتمال زیاد در طول داستان به آنها نیاز دارید.

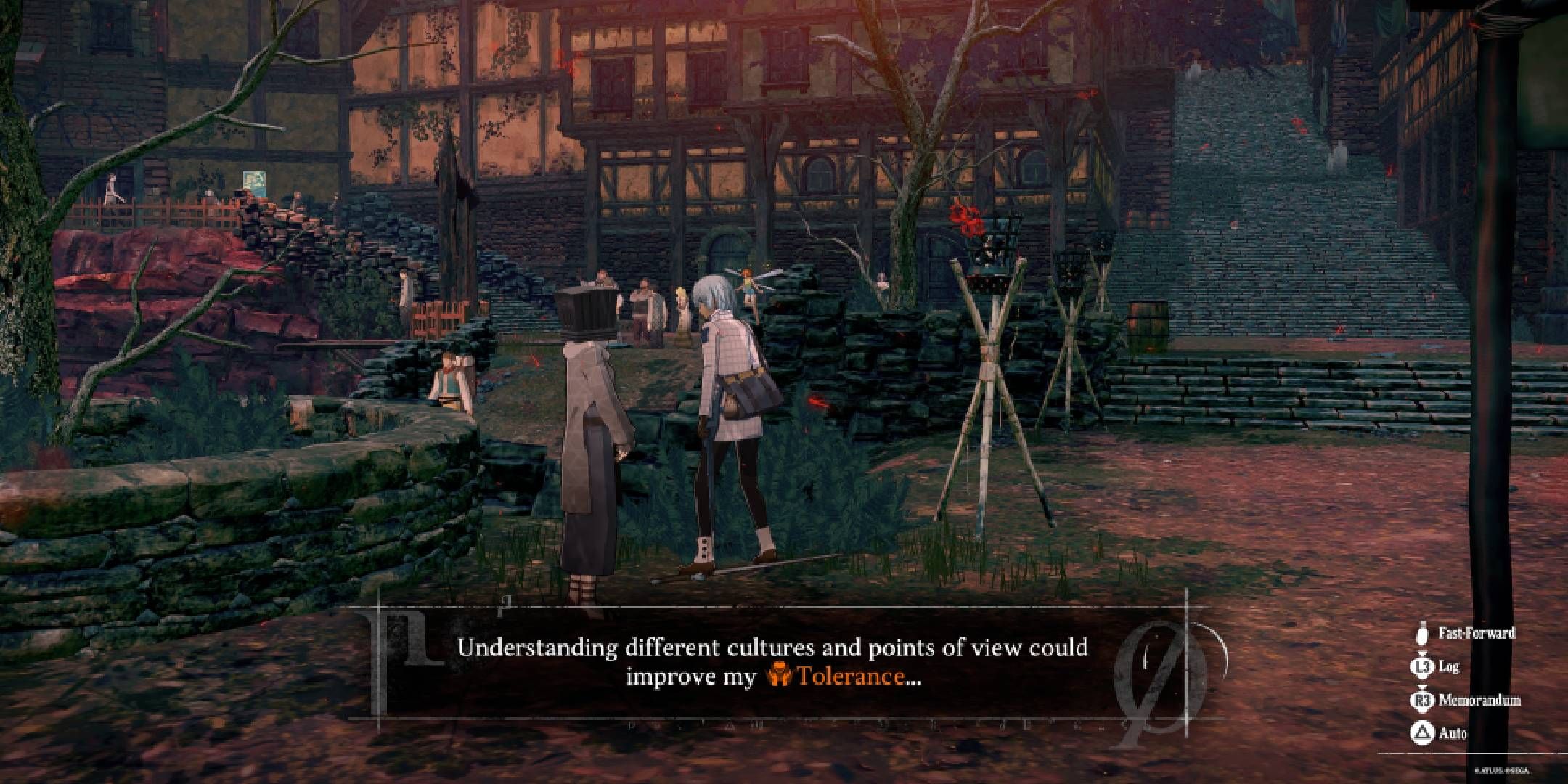

به لطف تمرکز بر تنوع قبیلهها در Metaphor: ReFantazio، تحمل یکی از مهمترین آمارهایی است که میتوان از لحاظ داستانی، و از نظر گیمپلی کار کرد، به طور مداوم در طول داستانهای باند آزمایش میشود، اما به ویژه در ابتدای کار. و پایان بازی

خوشبختانه، از آنجایی که هیزمی در اوایل ماجراجویی به مهمانی شما میپیوندد، شما شانس زیادی برای ارتقای فضیلت تحمل خود با گذراندن وقت با او در دونده دستکش خواهید داشت، و این تعاملات با امتیاز دعواهای گاه به گاه با عنصرها همراه است. یک راه عالی برای باز کردن قفل MAG بیشتر نیز هستند.

2

تخیل

آینده ای روشن تر را تصور کنید

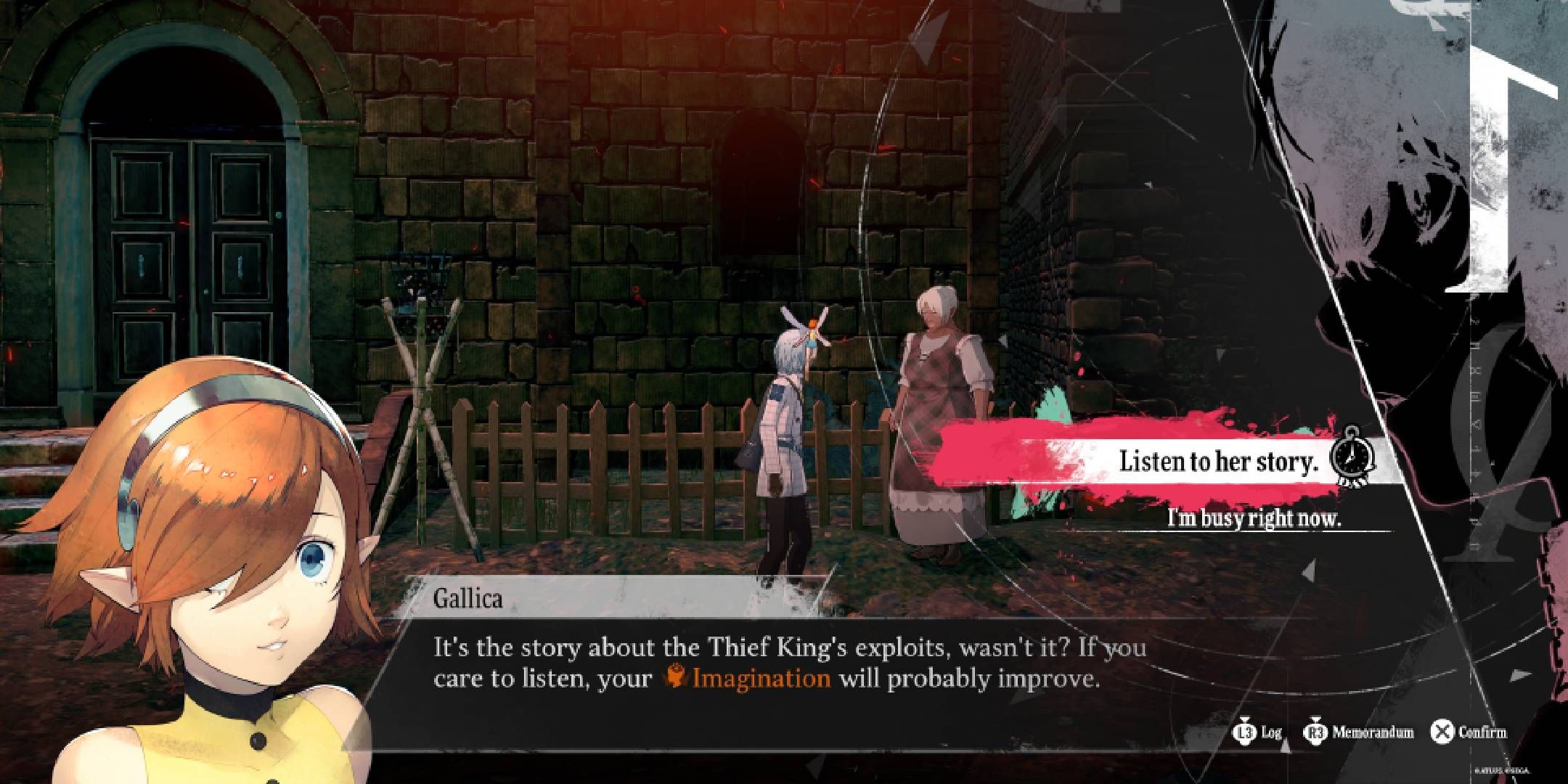

یکی از ویژگیهای منحصربهفرد سلطنتی که میتوانید در سراسر Metaphor روی آن کار کنید: ReFantazio تخیل است، و در حالی که احتمال کمتری دارد در طول ماموریتها و فعالیتهای معمولی این جایزه را دریافت کنید، NPCهای زیادی وجود دارند که تعاملات مختلفی را ارائه میکنند که میتواند این آمار را افزایش دهد.

مرتبط

استعاره: ReFantazio – 7 بهترین لوازم جانبی بازی های اولیه

با این لوازم جانبی بهترین شروع را در Metaphor: ReFantazio داشته باشید.

تخیل شما نیز به طور مرتب در طول خط داستانی باند مورد آزمایش قرار می گیرد، بنابراین می خواهید پیشرفت آن را در طول کمپین زیر نظر داشته باشید. تا اواسط/اواخر بازی هیچ عضو اختصاصی برای بالا بردن این آمار در Gauntlet Runner نخواهید داشت، اما اعضای حزب شما اغلب در طول شب هنگام سفر تعاملاتی را ارائه می دهند که تخیل شما را بالا می برد.

1

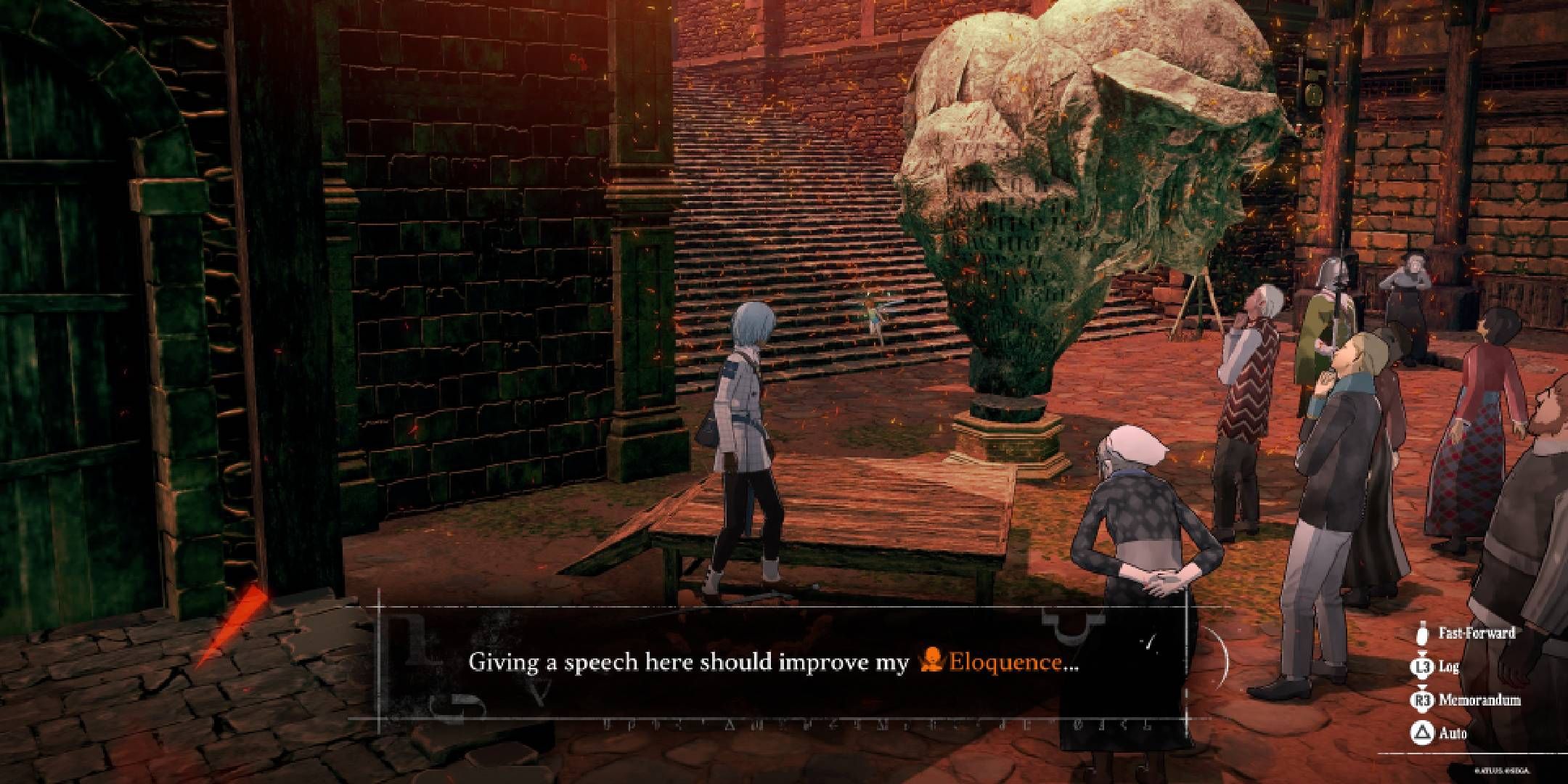

سخنوری

زبان نقره ای

مسلماً، خصیصهای که برای مطرح کردن آن به فعالترین تلاش نیاز دارد، سخنوری است، که توانایی قهرمان داستان را در صحبت کردن و متقاعد کردن شهروندان Euchronia میآزماید. روشهای غیرفعال بسیار کمی برای افزایش این آمار وجود دارد، و این یکی از نادرترین آمارهایی است که میتوان در حین سفر در Gauntlet Runner کسب کرد، و کتابها تنها روش در بیشتر بازیها هستند.

فصاحت در اواسط بازی اهمیت بیشتری پیدا می کند، بنابراین تا این مرحله، شما می خواهید که آمار فصاحت خود را حداقل به سطح 3 ارتقا دهید. اما مطمئن شوید که در مورد گزینههای دیالوگ خود مراقب هستید، زیرا هرچه در بحث بهتر عمل کنید، فصاحت بیشتری خواهید داشت. اگر در مناظره ها استعداد دارید، بالا بردن سطح فصاحت تان چالش کمتری است، اما اگر در انتخاب های دیالوگ تان بیشتر احمق باشید، این چالش برانگیزترین فضیلت برای کار خواهد بود.

RPG

JRPG

اقدام

ماجراجویی

منتشر شد

11 اکتبر 2024

توسعه دهندگان

استودیو صفر

موتور

GFD

ESRB

T برای نوجوانان // خون، زبان، مضامین تلقین کننده خفیف، استفاده از الکل، خشونت

چه مدت به ضرب و شتم

65 ساعت

X|S بهینه شده است

بله

اندازه فایل سری Xbox

81.15 گیگابایت

تعداد بازیکنان

1

سازگاری عرشه بخار

قابل پخش

چه مدت برای ضرب و شتم (دوهای تکمیل کننده)

104 ساعت

رتبه بندی OpenCritic

توانا

تاریخ انتشار PC

11 اکتبر 2024

تاریخ انتشار PS5

11 اکتبر 2024

تاریخ انتشار Xbox Series X|S

11 اکتبر 2024

گسترش دهید

استعاره: ReFantazio در هسته خود درباره شخصیت هایی است که با آنها ملاقات می کنید و پیوندهایی که با آنها ایجاد می کنید. اما برای به حداکثر رساندن تمام پیوندها با پیروان مختلف خود، باید قهرمان داستان را به رهبری تبدیل کنید که بتواند از صمیم قلب حمایت کند، و برای این کار، باید روی فضایل سلطنتی او کار کنید.

مرتبط

پنج مورد از این ویژگیهای شخصیتی وجود دارد که میتوانید در طول بازی آنها را ارتقا دهید، و در حالی که همه آنها مهم هستند، برخی از آنها به تلاش فعالتری نسبت به دیگران نیاز دارند. برای به حداکثر رساندن همه پیوندها، باید هر یک از این ویژگی ها را به حداکثر برسانید، اما برای داشتن راحت ترین سفر ممکن. بهترین فضایل سلطنتی برای افزایش ابتدا در استعاره: ReFantazio کدامند؟

5

شجاعت

قرار دادن در چهره شجاع

در طول داستان Metaphor: ReFantazio، قهرمان شما باید شجاعت خود را به روشهای مختلف نشان دهد، اما برای نشان دادن این شجاعت در داستانهای باند، باید روی ارتقای آمار شجاعت خود کار کنید.

در حالی که این وضعیت اجتماعی برای ارتقای اوراق قرضه بیشتر در اواسط یا اواخر بازی مورد نیاز است، شما نیازی به توجه فعالانه به این پیوند ندارید، زیرا بیشترین فرصت ها برای کار روی این فضیلت سلطنتی در طول بازی های دیگر به شما داده می شود. وظایف

به عنوان مثال، توصیه میشود که تمام پاداشهای موجود را تکمیل کرده و کیف پول خود را پر نگه دارید، اما برای هر یک از این موارد، چند امتیاز شجاعت نیز دریافت خواهید کرد. علاوه بر این، اگر قبل از یک ضرب الاجل وقت آزاد دارید، توصیه میشود در کولیزئوم در Brilehaven تلاش کنید و کار کنید، و علاوه بر پاداشها و تجربههای بینظیری که از این کار به دست میآورید، جسارت نیز خواهید داشت.

همچنین فرصتهای زیادی برای بالا بردن شجاعت خود در دونده دستکش به دست خواهید آورد، زیرا استرول، یکی از اولین اعضای حزبی که به دست میآورید، اغلب این فرصت را به شما میدهد که در سفر با او شجاعت خود را افزایش دهید. با تشکر از تعداد شانسهایی که برای ارتقای این آمار در طول فعالیتهای دیگر دارید، نیازی نیست که به این آمار توجه فعال داشته باشید.

4

خرد

دانش پادشاهی شما

به لطف مدت زمان ماجراجویی Metaphor: ReFantazio، در نهایت در مورد کشور Euchronia و مردم آن چیزهای زیادی یاد خواهید گرفت، اما باید زمان زیادی را صرف آموزش این درسها به قهرمان داستان با بالا بردن آمار خرد او کنید.

مشابه شجاعت، می توانید با انجام کارهایی که در غیر این صورت انجام می دادید، خرد به دست آورید. به عنوان مثال، زمانی که با Gauntlet Runner سفر میکنید، گاهی اوقات برای تماشای مناظر و گپ زدن با اعضای مهمانی خود استراحت میکنید. هر بار که این اتفاق میافتد، قفل کارتپستالی از Neuras را باز میکنید که میتوانید به ماریا بدهید، اما همچنین یک کمک هزینه خرد سالم نیز دریافت خواهید کرد.

مرتبط

استعاره: ReFantazio – 8 بهترین مهارت برای به ارث بردن

ترکیب و مطابقت کهن الگوها در استعاره: ReFantazio با به ارث بردن مهارت ها.

علاوه بر این، هالکنبرگ به محض اینکه قفل این حالت حمل و نقل را باز کنید، در دونده Gauntlet شما خواهد بود، و او اغلب آزاد است تا درس های استراتژی ارائه دهد تا در طول ماجراجویی نیز خرد بیشتری به شما بدهد.

فقط با درگیر شدن با بیشتر ویژگی های ارائه شده به شما باید بتوانید مقدار کاملی از خرد را در اواسط یا اواخر بازی به دست آورید، اما ممکن است لازم باشد در ابتدا آن را کمی فعال تر کنید، زیرا چند مورد قبلی پیوندها برای پیشرفت نیاز به خرد پایینی دارند. با این حال، اینها به سرعت از بین نمی روند، بنابراین عجله زیادی نیز وجود ندارد.

3

تحمل

یاد بگیرید که مردم خود را دوست داشته باشید

در مقایسه با شجاعت و خرد، سه فضیلت سلطنتی دیگر بسیار کمتر در طول فعالیتهای استاندارد انجام میشوند، و به همین دلیل، این سه فضیلت هستند که به احتمال زیاد در طول داستان به آنها نیاز دارید.

به لطف تمرکز بر تنوع قبیلهها در Metaphor: ReFantazio، تحمل یکی از مهمترین آمارهایی است که میتوان از لحاظ داستانی، و از نظر گیمپلی کار کرد، به طور مداوم در طول داستانهای باند آزمایش میشود، اما به ویژه در ابتدای کار. و پایان بازی

خوشبختانه، از آنجایی که هیزمی در اوایل ماجراجویی به مهمانی شما میپیوندد، شما شانس زیادی برای ارتقای فضیلت تحمل خود با گذراندن وقت با او در دونده دستکش خواهید داشت، و این تعاملات با امتیاز دعواهای گاه به گاه با عنصرها همراه است. یک راه عالی برای باز کردن قفل MAG بیشتر نیز هستند.

2

تخیل

آینده ای روشن تر را تصور کنید

یکی از ویژگیهای منحصربهفرد سلطنتی که میتوانید در سراسر Metaphor روی آن کار کنید: ReFantazio تخیل است، و در حالی که احتمال کمتری دارد در طول ماموریتها و فعالیتهای معمولی این جایزه را دریافت کنید، NPCهای زیادی وجود دارند که تعاملات مختلفی را ارائه میکنند که میتواند این آمار را افزایش دهد.

مرتبط

استعاره: ReFantazio – 7 بهترین لوازم جانبی بازی های اولیه

با این لوازم جانبی بهترین شروع را در Metaphor: ReFantazio داشته باشید.

تخیل شما نیز به طور مرتب در طول خط داستانی باند مورد آزمایش قرار می گیرد، بنابراین می خواهید پیشرفت آن را در طول کمپین زیر نظر داشته باشید. تا اواسط/اواخر بازی هیچ عضو اختصاصی برای بالا بردن این آمار در Gauntlet Runner نخواهید داشت، اما اعضای حزب شما اغلب در طول شب هنگام سفر تعاملاتی را ارائه می دهند که تخیل شما را بالا می برد.

1

سخنوری

زبان نقره ای

مسلماً، خصیصهای که برای مطرح کردن آن به فعالترین تلاش نیاز دارد، سخنوری است، که توانایی قهرمان داستان را در صحبت کردن و متقاعد کردن شهروندان Euchronia میآزماید. روشهای غیرفعال بسیار کمی برای افزایش این آمار وجود دارد، و این یکی از نادرترین آمارهایی است که میتوان در حین سفر در Gauntlet Runner کسب کرد، و کتابها تنها روش در بیشتر بازیها هستند.

فصاحت در اواسط بازی اهمیت بیشتری پیدا می کند، بنابراین تا این مرحله، شما می خواهید که آمار فصاحت خود را حداقل به سطح 3 ارتقا دهید. اما مطمئن شوید که در مورد گزینههای دیالوگ خود مراقب هستید، زیرا هرچه در بحث بهتر عمل کنید، فصاحت بیشتری خواهید داشت. اگر در مناظره ها استعداد دارید، بالا بردن سطح فصاحت تان چالش کمتری است، اما اگر در انتخاب های دیالوگ تان بیشتر احمق باشید، این چالش برانگیزترین فضیلت برای کار خواهد بود.