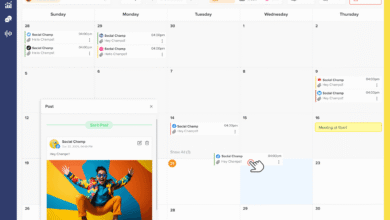

شبکه های اجتماعی

پادکست Later's Beyond Influence

چه کسی پادکست Beyond Influence را میزبانی می کند؟

پادکست توسط خودم و کوامه آپیا.

ممکن است او را از نمایش نتفلیکس، Love Is Blind بشناسید، اما او همچنین سالها در توسعه کسبوکار کار کرده است – به همین ترتیب با هم آشنا شدیم.

زمانی که زمان استخدام یک رئیس جدید اینفلوئنسر Engagement در Later (و میزبان مشترک!) فرا رسید، Kwame یک تناسب طبیعی بود.

او ترکیبی منحصر به فرد از تجربه را به ارمغان می آورد: او فناوری و فروش را می شناسد، سال ها محتوای عکاسی زیبایی در اینستاگرام ایجاد کرد و پس از پخش عشق کور است، تأثیر ناگهانی به دست آورد.

او می تواند با مخاطبان در سراسر اکوسیستم اینفلوئنسر مارکتینگ صحبت کند، و من بی صبرانه منتظر شنیدن درس های او هستم.