Llama 4: انقلاب چندمودال Moe-Moe

Meta's Llama 4 نشانگر تغییر پارادایم در هوش مصنوعی با وزن باز است و معماری پیشگامانه را با راندمان عملی ترکیب می کند. به عنوان اولین مدل های بومیان چند حالته در خانواده Llama ، Scout و Maverick تعریف می کنند که توسعه دهندگان می توانند با هوش مصنوعی با منبع باز دست یابند. در اینجا آنچه شما باید بدانید آورده شده است:

معماری: کارآیی از طریق تخصص

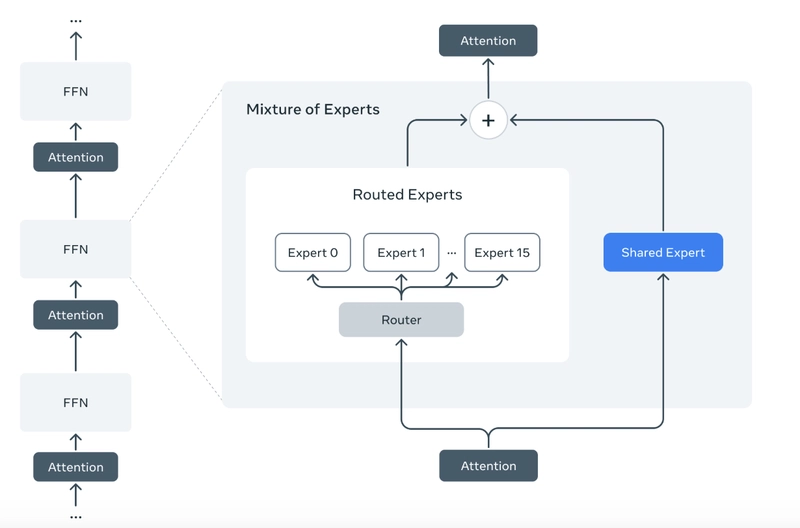

Llama 4 تصویب می کند مخلوط پراکنده (MOE) طراحی ، جایی که فقط یک زیر مجموعه از پارامترها در هر پرس و جو فعال می شود[5]بشر به عنوان مثال:

- با 4 پیشاهنگ تماس بگیرید: 17B پارامترهای فعال (109b در کل) با 16 متخصص ، بهینه شده برای کد و کارهای طولانی متن.

- با 4 ماوریک تماس بگیرید: 17B پارامترهای فعال (400B کل) با 128 متخصص ، تعالی در گردش کار چند زبانه و خلاق[8]بشر

این معماری نشانه ها را به زیر شبکه های تخصصی (“کارشناسان”) هدایت می کند ، و هزینه های محاسبه را 83 ٪ پوند در مقایسه با مدل های متراکم مانند Llama 3 کاهش می دهد[5]بشر برای ماوریک ، این به معنای عملکرد سطح GPT-4 در 1/9 هزینه برای هر نشانه است[7]بشر

مدل ها نیز استفاده می کنند مولتی و فیوژن زودهنگام، پردازش متن ، تصاویر و قاب های ویدیویی به عنوان توالی توکن یکپارچه از لایه اول[1][5]بشر بر خلاف مدل های قبلی که اجزای بینش/متن زنجیره ای دارند ، این استدلال عمیق تر از نظر متقابل را امکان پذیر می کند-مانند توضیح جریان UI با استفاده از کد و تصاویر[2]بشر

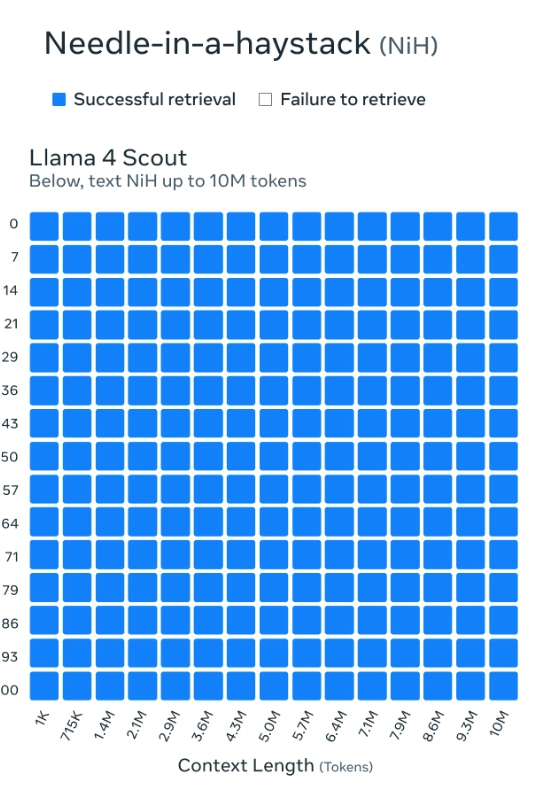

10 متر توکن: دستیابی به موفقیت در پنجره

Llama 4 Scout's 10 میلیون متن توکن (کلمات 5m) یک جهش کوانتومی برای آنالیز کد و داده است[1][3]بشر برای چشم انداز این:

- این می تواند هسته لینوکس را بخورد (توکن 7 میلیون پوند) وت مستندات آن در یک پاس.

- بدون استفاده از محرک های بازگشتی ، بازگرداندن پایگاه کد جامع را قادر می سازد.

این توسط شادی، یک معماری توجه در هم تنیده که بین لایه های موقعیتی و غیر هدف قرار می گیرد تا انسجام در مسافت های شدید حفظ شود[7]بشر در حالی که استقرار اولیه در سیستم عامل هایی مانند CloudFlare در حال حاضر زمینه های CAP در نشانه های 131K ، مقیاس 10 متر در حال انجام است.

استفاده از موارد: فراتر از چت بابات

1) هوش

زمینه طولانی پیشاهنگ امکان تجزیه و تحلیل معماری از کل مخازن را فراهم می کند. تصور کنید:

# Analyze a 5M-token codebase in one pass

context = load_entire_repo("my_project")

response = llama4.scout_query(

prompt="Find race conditions in this async code",

context=context

)

2) برنامه های چند زبانه چند ضلعی

ماوریک از 12 زبان و تصویر/متن فیوژن پشتیبانی می کند – IDEAL برای برنامه های جهانی که نیاز به زمینه بصری دارند (به عنوان مثال ، کتابچه راهنمای عیب یابی با نمودارها)[8]بشر

3) استنباط مقرون به صرفه

فعال سازی انتخابی MOE به Scout اجازه می دهد تا در یک پردازنده گرافیکی H100 واحد اجرا شود و دسترسی به AI در مقیاس شرکت را دموکراتیک کند.

چرا مهم است

Llama 4 فقط LLM دیگری نیست – این یک ابزار ابزار برای تجسم مجدد گردش کار هوش مصنوعی است. طراحی MOE ثابت می کند که بزرگتر همیشه بهتر نیست: استفاده از پارامتر باهوش تر عملکرد بالاتر را با هزینه های پایین تر امکان پذیر می کند. برای توسعه دهندگان ، این به معنای ساختن برنامه های کاربردی غیر عملی (مانند تجزیه یکپارچه در زمان واقعی) بدون خوشه های GPU است.

از آنجا که جامعه منبع باز در این مدل ها تکرار می شود ، انتظار می رود که در عوامل چند مدلی ، ابزارهای تجزیه و تحلیل متقابل و IDE های AIG AUGEMED افزایش یابد. آینده هوش مصنوعی فقط مربوط به مقیاس نیست – در مورد کار دقیق تر است ، و Llama 4 این مسئولیت را بر عهده دارد.

آماده آزمایش هستید؟ مدل ها را در بغل کردن صورت بگیرید و پروژه های خود را در زیر به اشتراک بگذارید!

منابع:

[1] https://azure.microsoft.com/en-us/blog/introducing-the-llama-4-herd-in-azure-ai-foundry-and-azure-databricks/

[2] https://dev.to/maxprilutskiy/llama-4-breaking-metas-latest-powerhouse-model-3k0p

[3] https://www.youtube.com/watch؟v=xcxune2wmpa

[4] https://economictimes.com/tech/technology/how-to-use-metas-llama-4a-quick-guide-for-developers-and-enterprises/articleshow/120031266.cms

[5] https://blog.cloudflare.com/meta-llama-4-is-now-available-on-workers-ai/

[6] https://www.googlecloudcommunity.com/gc/community-blogs/introducing-llama-4-on-vertex-ai/ba-p/892578

[7] https://apidog.com/blog/llama-4-api/

[8] https://www.together.ai/blog/llama-4

[9] https://venturebeat.com/ai/metas-answer-to-deepseek-is-here-llama-4-launches-with-context-scout-and-2t-parameter-behemoth-on-the-way///

[10] https://www.snowflake.com/en/blog/meta-llama-4-now-available-snowflake-cortex-ai/

[11] https://www.ibm.com/think/topics/context-window

[12] https://groq.com/llama-4-now-live-on-groq-build-fast-at-the-howest-cost-without-compromise/

[13] https://www.aboutamazon.com/news/aws/aws/aws-meta-llama-4-models-available

[14] https://codingscape.com/blog/llms-with-largest-context-windows

[15] https://www.llama.com/developer-use-guide/

[16] https://www.databricks.com/blog/introducing-metas-llama-4-databricks-data-intelligence-platform

[17] https://www.reddit.com/r/singulary/comments/1jsb7ug/do_you_think_llama_4_will_have_a_10_million_token/

[18] https://developers.redhat.com/articles/2025/04/05/llama-4-herd-here-day-zero-inference-support-vllm

[19] https://www.llama.com

[20] https://www.instagram.com/artificialintelligencenews.in/reel/difmw79oxxq/