تقویت عملکرد: افزایش دامنه داده با Fetch XML

مقدمه:

هنگام کار با Microsoft DataVerse و Power Automate ، بهینه سازی نمایش داده شدگان شما می تواند عملکرد را به میزان قابل توجهی بهبود بخشد و گردش کار شما را ساده تر کند. در این وبلاگ ، ما دو نکته اساسی را برای تقویت عملکرد داده های شما بررسی خواهیم کرد: انتخاب ستون های خاص و استفاده از FetchXML. این استراتژی ها بخشی از مفهوم وسیع تر از الگوی پرس و جو است که به جلوگیری از گرفتاری های مشترک کمک می کند و اطمینان حاصل می کند که فرآیندهای بازیابی داده های شما تا حد امکان کارآمد هستند.

راه اندازی:

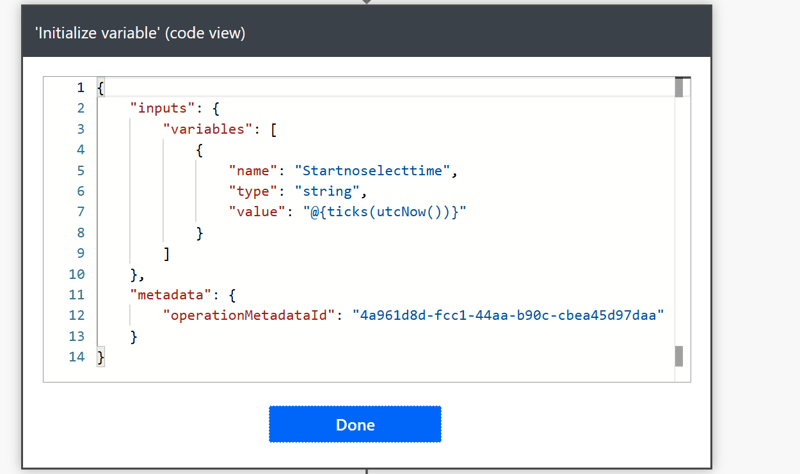

هنگام کار با Power Automate ، اندازه گیری زمان صرفه جویی شده بین مراحل مختلف برای بهینه سازی عملکرد بسیار مهم است. یکی از راه های مؤثر برای دستیابی به این هدف ، استفاده از کنه است که نشان دهنده کوچکترین واحد زمان در برق است. در این راهنما ، ما شما را در طی مراحل محاسبه زمان صرفه جویی شده بین دو مرحله با استفاده از کنه طی می کنیم.

ticks(utcNow())

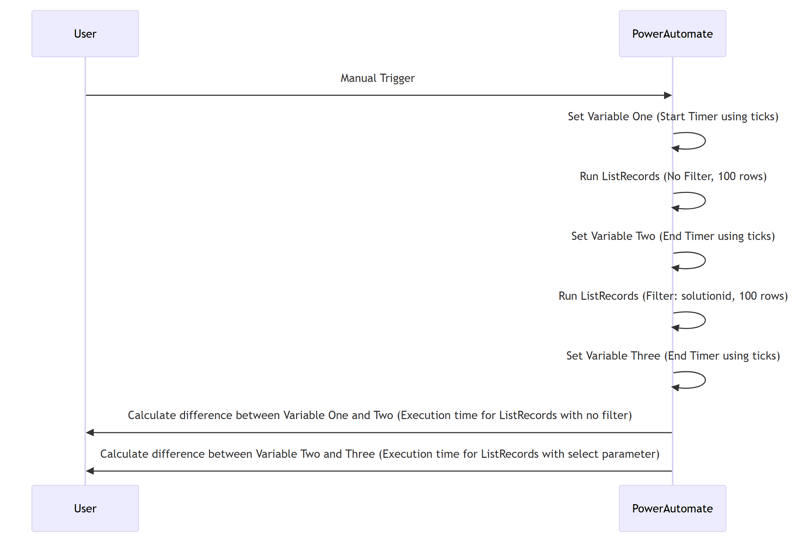

تنظیم جریان چیزی شبیه به این است. من تعداد ردیف را به 100 محدود کرده ام.

نکته 1:

هنگام کار با DataVerse ، بهینه سازی نمایش داده های خود برای اطمینان از بازیابی داده های کارآمد بسیار مهم است. یکی از راه های مؤثر برای دستیابی به این هدف ، استفاده از پارامتر ستون Select در عملیات ListreCords شماست. نمایش داده شدی که تمام ستون ها را برمی گرداند یا تعداد زیادی ستون را شامل می شود می تواند به دلیل اندازه مجموعه داده یا پیچیدگی پرس و جو با مشکلات عملکرد روبرو شود.

برای لیست 100 سوابق با استفاده از عملیات ListRecords ، این عمل 465.1485 میلی ثانیه طول کشید. در حالی که اگر پارامتر ستون را انتخاب کنیم ، محاسبات 190.0756 بود که به a ترجمه می شود 59.12 ٪ کاهش زمان اجرای.

نکته 2:

یکی دیگر از تکنیک های بهینه سازی مهم هنگام کار با نمایش داده های DataVerse ، جلوگیری از استفاده از بند “سفارش توسط” است. در حالی که سفارش داده ها می توانند در سناریوهای خاص مفید باشند ، سربار محاسباتی اضافی را به عمل اضافه می کند. این می تواند به زمان اجرای پرس و جو کندتر و افزایش بار سرور منجر شود.

با جلوگیری از بند “سفارش توسط” ، می توانید نمایش داده شد و میزان پردازش مورد نیاز را کاهش داده و کاهش دهید. این امر به ویژه هنگام برخورد با مجموعه داده های بزرگ یا نمایش داده های پیچیده مفید است. درعوض ، در صورت لزوم ، مرتب سازی داده ها پس از بازیابی ، با استفاده از پردازش سمت مشتری یا سایر روش هایی که بر عملکرد سرور تأثیر نمی گذارد ، در نظر بگیرید.

بوها 69.12 ٪ اگر “سفارش توسط” اضافه کنید ، افزایش زمان مشاهده می شود

نکته 3:

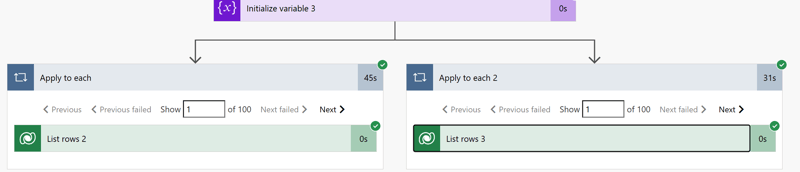

برای نشان دادن بصری کارآیی FetchXML ، من در مرحله قبل 100 رکورد از موجودیت راه حل ها را انتخاب کردم و برای بازیابی اجزای سازنده از طریق راه حل ها حلقه کردم. یک شاخه از جریان Automate Power از پرس و جو fetchxml استفاده نمی کند ، در حالی که شاخه دیگر این کار را انجام می دهد.

برای بهینه سازی بیشتر نمایش داده های DataVerse ، استفاده از FetchXML را در نظر بگیرید. FetchXML یک زبان پرس و جو قدرتمند است که به شما امکان می دهد دامنه داده ها را دستکاری کرده و دقیقاً اطلاعات مورد نیاز خود را بازیابی کنید. با استفاده از FETCHXML ، می توانید عملکرد نمایش داده های خود را به میزان قابل توجهی افزایش دهید.

این پرس و جو FetchXML اجزای راه حل را بر اساس نوع آنها گروه بندی می کند و تعداد اجزای مربوط به هر نوع را شمارش می کند. این یک روش قدرتمند برای جمع آوری داده ها و بازیابی اطلاعات خلاصه شده به طور کارآمد است.

با استفاده از FetchXML ، شما توانستید زمان اجرای را از 45 ثانیه به 31 ثانیه کاهش دهید ، و یک پیشرفت قابل توجه عملکرد را نشان می دهید. 30 ٪ بهبود

سخنان پایانی:

با استفاده از پارامتر ستون Select ، جلوگیری از بند “سفارش توسط” و استفاده از FetchXML ، می توانید عملکرد نمایش داده های خود را به میزان قابل توجهی افزایش دهید. این استراتژی ها به کاهش سربار محاسباتی ، بازیابی داده ها کمک می کنند و اطمینان حاصل می کنند که گردش کار شما به راحتی اجرا می شود.

به یاد داشته باشید ، بهینه سازی پرس و جوهای شما نه تنها زمان اجرای را بهبود می بخشد بلکه بار سرور را به حداقل می رساند و منجر به عملکرد کلی بهتر می شود. اجرای این نکات به شما در ایجاد راه حل های قوی و کارآمد در برق خودکار و DataVerse کمک می کند. برای بینش های بیشتر و بهترین شیوه ها برای حفظ عملکرد داده های خود در بهترین حالت خود با ما در ارتباط باشید.

مرجع:

پرس و جو ضد الگوی