RLVR استدلال LLM را گسترش نمی دهد ، فقط نمونه گیری را بهینه می کند: مطالعه جدید

این یک خلاصه مقاله انگلیسی ساده از یک مقاله تحقیقاتی به نام RLVR استدلال LLM را گسترش نمی دهد ، فقط نمونه گیری را بهینه می کند: مطالعه جدید. اگر این نوع تحلیل ها را دوست دارید ، باید به Aimodels.fyi بپیوندید یا ما را در توییتر دنبال کنید.

به چالش کشیدن روایت خود بهبود RLVR در LLMS

یادگیری تقویت شده با پاداش های قابل تأیید (RLVR) اخیراً پیشرفت های قابل توجهی را در مدلهای بزرگ زبان استدلال محور (LLMS) مانند OpenAI-O1 ، Deepseek-R1 و Kimi-1.5 ایجاد کرده است. این مدل ها قابلیت های قابل توجهی را در کارهای منطقی پیچیده شامل ریاضیات و برنامه نویسی نشان داده اند.

بر خلاف رویکردهای تنظیم شده توسط دستورالعمل سنتی که به حاشیه نویسی های رنگی انسان متکی هستند ، RLVR با یک مدل پایه پیش ساخته شروع می شود و آن را از طریق یادگیری تقویت شده با استفاده از پاداش های قابل محاسبه خودکار بهینه می کند. این جوایز از روشهای تأیید ساده دریافت می شود: تطبیق راه حل های حقیقت زمین در ریاضیات یا تست های واحد عبور به صورت کد.

اعتقاد متعارف معتقد است که RLVR مدل ها را قادر می سازد تا رفتارهای استدلال پیشرفته ای را فراتر از قابلیت های مدل های پایه خود توسعه دهند. این چشم انداز خود بهبود RLVR را به عنوان راهی برای پیشرفت مداوم هوش مصنوعی با گسترش قابلیت های استدلال قرار می دهد.

اما آیا RLVR واقعاً قابلیت های استدلال جدید را فعال می کند؟ یا آیا اتفاق دیگری در زیر سطح اتفاق می افتد؟

این تحقیق به طور انتقادی این فرض را با استفاده از متریک Pass@K با مقادیر بزرگ K برای کشف مرزهای توانایی استدلال در خانواده ها و معیارهای مختلف مدل بررسی می کند. این روش امکان آزمایش دقیق این را فراهم می کند که آیا RLVR واقعاً مدل ها را قادر می سازد تا مشکلات را فراتر از قابلیت های مدل های پایه خود حل کنند.

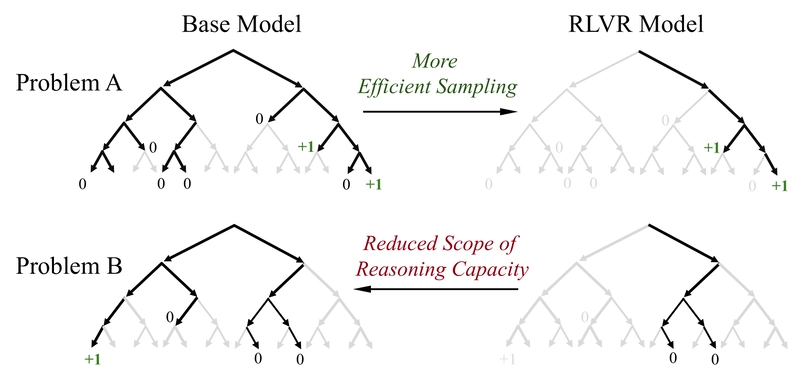

یافته های غافلگیرکننده درک متعارف را به چالش می کشد: RLVR الگوهای استدلال اساساً جدید را استخراج نمی کند. در حالی که مدلهای آموزش دیده RL هنگام تولید پاسخ های مجرد (K = 1) از مدل های پایه بهتر عمل می کنند ، مدل های پایه در صورت امکان تلاش های متعدد (مقادیر بزرگ K) به نرخ موفقیت قابل مقایسه یا حتی بالاتر می رسند. این نشان می دهد که مدلهای آموزش زبان برای استدلال از طریق RLVR ممکن است توانایی های اساسی آنها را گسترش ندهد ، بلکه بهینه سازی رفتار نمونه گیری آنها است.

درک چگونگی اندازه گیری قابلیت های استدلال در LLMS

مکانیک یادگیری تقویت با جوایز قابل اثبات

RLVR با LLM شروع می شود که توالی توکن را بر اساس اعلان ها تولید می کند. یک تأیید کننده قطعی پاداش های باینری را بر اساس صحت فراهم می کند – پاداش 1 اگر پاسخ نهایی مدل با حقیقت زمین مطابقت داشته باشد و در غیر این صورت 0. پاداش های قالب نیز ممکن است برای تشویق جدایی مناسب استدلال و پاسخ ها اضافه شود.

هدف RLVR به حداکثر رساندن پاداش مورد انتظار در همه اعلان ها است. الگوریتم های اجرای محبوب عبارتند از:

- بهینه سازی سیاست پروگزیمال (PPO): از یک هدف جانشین بریده شده با مزایای تخمین زده شده توسط یک شبکه ارزش استفاده می کند

- GRPO: یک نوع بدون منتقد که پاداش در گروه های پاسخ را عادی می کند

- باکره: یک پایه مرخصی را در هر دسته آموزشی تصویب می کند

این روشهای شیب سیاست با هدف افزایش احتمال پاسخهای پاداش در ضمن کاهش احتمال موارد غیرقانونی ، به تدریج مدل را به سمت مسیرهای استدلال موفق تر هدایت می کنند.

ایجاد معیارهایی برای مرزهای ظرفیت استدلال

روشهای ارزیابی سنتی مانند نرخ موفقیت تک پاسی یا نمونه گیری هسته ، عملکرد مورد نظر متوسط را به جای پتانسیل استدلال واقعی یک مدل منعکس می کند. این رویکردها ممکن است در صورت عدم موفقیت مدل ها تنها پس از چند تلاش برای مشکلات دشوار ، قابلیت ها را دست کم بگیرند ، حتی اگر آنها بتوانند با نمونه گیری بیشتر موفق شوند.

برای ارزیابی صحیح مرزهای استدلال ، این تحقیق از متریک Pass@K استفاده می کند ، که در صورتی که هر یک از نمونه های K پاسخ صحیحی داشته باشد ، مشکل حل شده را در نظر می گیرد. این رویکرد نشان می دهد که آیا یک مدل از ظرفیت اساسی برای حل یک مشکل برخوردار است ، حتی اگر راه حل به طور کارآمد نمونه برداری نشود.

برآوردگر بی طرفانه برای پاس@k به این صورت محاسبه می شود:

عبور@k: = e[1 – (n-c choose k)/(n choose k)]

جایی که C تعداد نمونه های صحیح از تلاش های N است.

برای مشکلات ریاضی ، در جایی که “حدس های خوش شانس” می تواند رخ دهد ، محققان مشکلات را به راحتی هک می کنند و به طور دستی صحت زنجیره های استدلال را تأیید می کنند. این رویکرد دقیق ، ارزیابی دقیق از قابلیت های استدلال واقعی را به جای پاسخ های صحیح تصادفی تضمین می کند.

جدول نشان می دهد مجموعه آزمایشی در کارهای مختلف (ریاضیات ، تولید کد ، استدلال بصری) ، با استفاده از خانواده های مختلف مدل ، چارچوب های RL ، الگوریتم ها و معیارها.

بررسی اثرات RLVR در کارهای مختلف استدلال

این تحقیق تأثیر RLVR را در سه حوزه نماینده ارزیابی می کند: ریاضیات ، تولید کد و استدلال بصری. تمام آزمایشات پارامترهای نمونه گیری مداوم را حفظ می کنند: دمای 0.6 ، مقدار برتر P 0.95 و حداکثر تولید 16384 نشانه.

برای اطمینان از انصاف ، ارزیابی از تعداد کمی عکس برای مدل های پایه جلوگیری می کند و اثرات مخدوش احتمالی را از نمونه های درون متن از بین می برد. هر دو مدل Base و RLVR هر یک از پیش فرض های صفر شات یا پیش فرض های ارائه شده به معیار را دریافت می کنند.

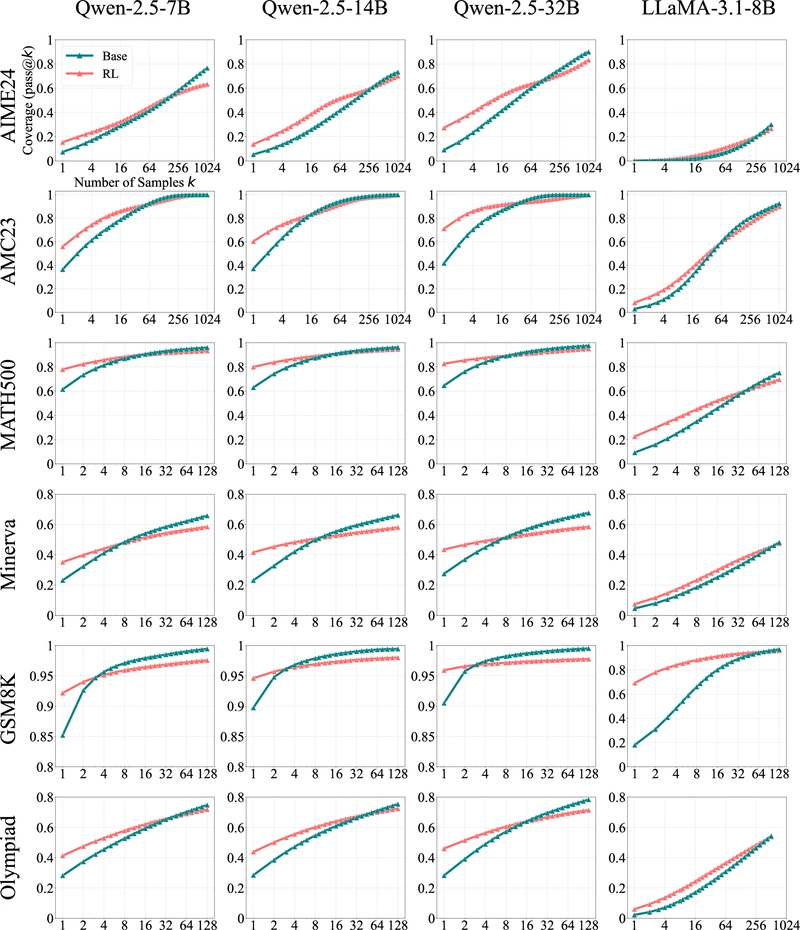

استدلال ریاضی: بهره وری با هزینه پوشش

ارزیابی استدلال ریاضی از چندین خانواده LLM (QWEN-2.5 در اندازه 7b/14b/32b و Llama-3.1-8B) در معیارهای با سطح دشواری مختلف ، از جمله GSM8K ، MATH500 ، مینروا ، المپیاد ، Aime24 و AMC23 استفاده کرد.

نتایج یک الگوی سازگار را نشان می دهد: در مقادیر کم K (به عنوان مثال K = 1) ، مدل های آموزش دیده RL به طور قابل توجهی از همتایان پایه خود بهتر عمل می کنند. با این حال ، با افزایش K ، مدل های پایه منحنی های بهبود تندتر را نشان می دهند و در نهایت از مدل های RL پیشی می گیرند. به عنوان مثال ، در معیار مینروا با یک مدل 32B ، مدل پایه از مدل RL تقریباً 9 ٪ در K = 128 استفاده می کند.

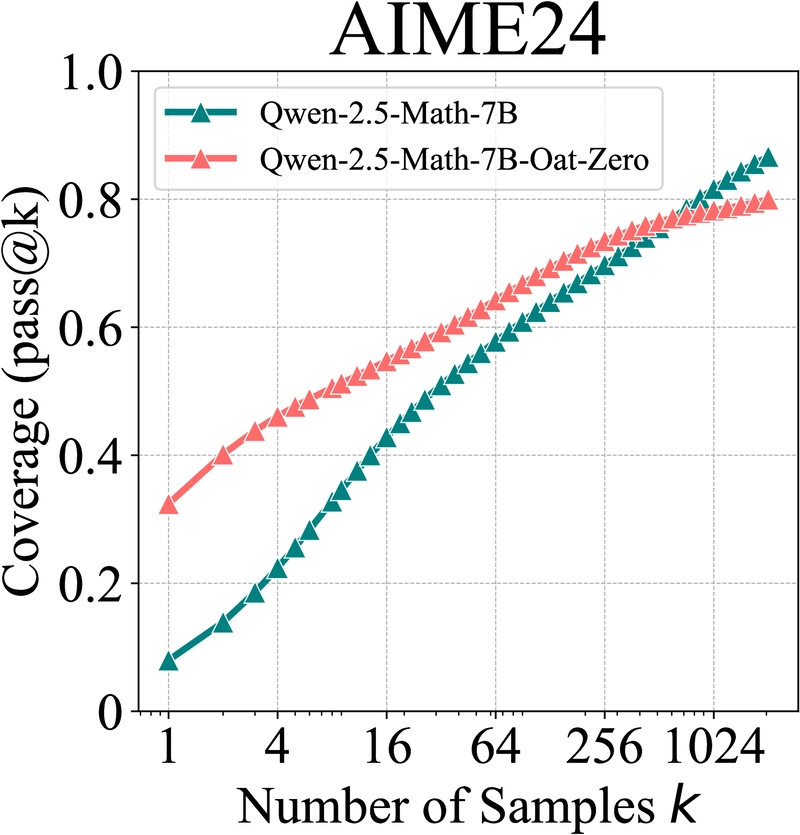

نمودار نشان می دهد که چگونه OAT-Zero در AIME24 در مقایسه با مدل پایه ، با رفتار متقاطع مشابه در مقادیر K بزرگ عمل می کند.

حتی برای جو دوسر ، که تقریباً 30 ٪ عملکرد بالاتر از مدل پایه خود را در K = 1 در معیار AIME24 به چالش کشیده نشان می دهد ، مدل پایه در نهایت با نمونه گیری کافی از آن پیشی می گیرد.

برای اعتبارسنجی این یافته ها ، محققان زنجیرهای فکری را برای چالش برانگیزترین مشکلات قابل حل بررسی کردند. نتایج تأیید کرد که حتی در سؤالات بسیار دشوار ، پاسخ های صحیح عمدتاً از مسیرهای استدلال معتبر به جای حدس های خوش شانس ناشی می شود. این نشان می دهد که عبور@k در مقادیر بزرگ به طور قابل اعتماد نشانگر مرز استدلال واقعی یک مدل است.

این یافته ها با بینش تقویت تفکر از طریق مدلهای پاداش با استدلال ، که اهمیت درک آنچه RLVR در واقع در LLM ها بهینه سازی می کند ، مطابقت دارد.

تولید کد: تأیید الگوی

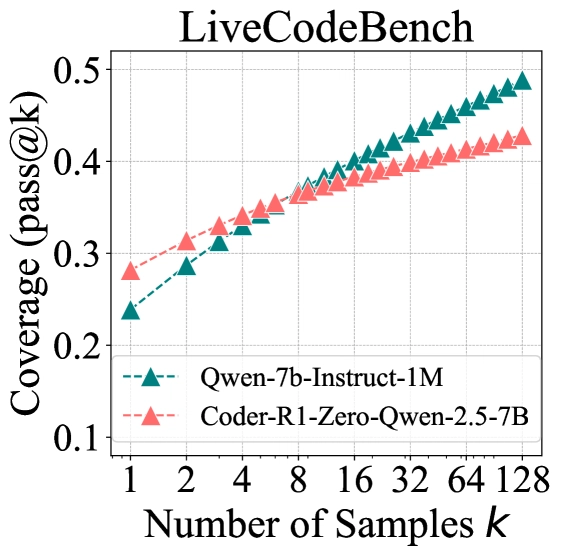

برای تولید کد ، محققان مدل آموزش داده شده RLVR Code-R1 (بر اساس Intruct QWEN2.5-7B) را در LiveCodebench V5 ، Humaneval+و MBPP+ارزیابی کردند.

نمودار نشان دادن الگوی عملکرد در کارهای تولید کد با مقایسه مدل های پایه و RLVR.

نتایج آینه یافته های استدلال ریاضی را نشان می دهد. در LiveCodebench ، مدل اصلی به نمره پاس@1 23.8 ٪ می رسد ، در حالی که مدل آموزش دیده RLVR به 28.1 ٪ می رسد. با این حال ، در K = 128 ، تقریباً 50 ٪ از مشکلات برنامه نویسی توسط مدل اصلی در مقایسه با تنها 42.8 ٪ توسط مدل RLVR حل شد.

نکته قابل توجه ، منحنی مدل پایه همچنان در K = 128 به شدت افزایش می یابد ، که نشان می دهد پتانسیل بهبود بیشتر با نمونه های بیشتر است. در مقابل ، منحنی مدل RLVR ، که نشانگر مرز پوشش باریک تر است.

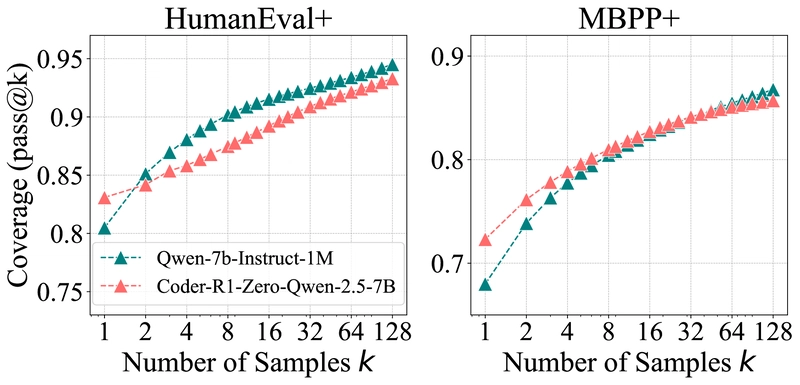

نمودارهایی که منحنی های عبور@k را برای هر دو کدهای تولید و وظایف استدلال بصری نشان می دهد ، الگوی مداوم در حوزه ها را نشان می دهد.

استدلال بصری: این الگوی در کارهای چند حالته ادامه دارد

آزمایش های استدلال بصری از چارچوب EASYR1 برای آموزش QWEN-2.5-VL-7B در Geometry3K استفاده کرد و در نسخه های فیلتر شده Mathvista-Testmini و Mathvision-Testmini ارزیابی شد. برای جلوگیری از مزایای ساده حدس ، سؤالات چند گزینه ای حذف شد.

نتایج همان الگوی مشاهده شده در حوزه های دیگر را تأیید می کنند: مدل های اصلی از مدل های RLVR در مقادیر بزرگ K استفاده می کنند. بازرسی دستی از مشکلات چالش برانگیز تأیید کرد که افزایش عملکرد به جای حدس های خوش شانس به دلیل مسیرهای استدلال معتبر بوده است.

این قوام در وظایف ریاضی ، کد و استدلال بصری شواهد محکمی را ارائه می دهد که یادگیری تقویت کننده اساساً ظرفیت استدلال را فراتر از آنچه در مدل های پایه وجود دارد ، افزایش نمی دهد.

درک اینکه چرا RLVR نتواند مرزهای استدلال را گسترش دهد

مدل های پایه در حال حاضر حاوی الگوهای استدلال پیشرفته هستند

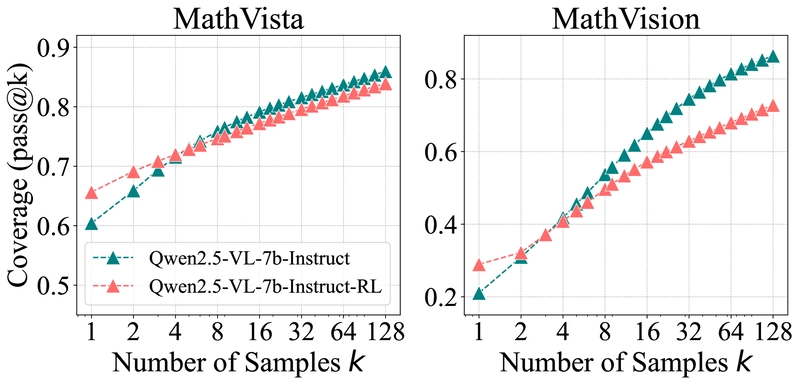

تجزیه و تحلیل عمیق تر نشان می دهد که مشکلات قابل حل توسط مدل های RLVR یک زیر مجموعه تقریبی از آن را که توسط مدل های پایه قابل حل هستند ، تشکیل می دهند. در AIME24 ، تقریباً تمام مشکلات حل شده توسط مدل RL آموزش دیده نیز می تواند توسط مدل پایه با نمونه گیری کافی حل شود.

نمودار سمت چپ توزیع گیج کننده پاسخ ها از منابع مختلف را نشان می دهد. نمودار سمت راست پوشش مدل های پایه ، آموزش ، RL و مدل های مقطر را مقایسه می کند.

تجزیه و تحلیل احتمالی نشان می دهد که پاسخ های مدل های آموزش دیده RL از نزدیک با قسمت پایین توزیع مدل پایه مطابقت دارد – مربوط به پاسخ ها ، مدل پایه احتمالاً تولید می کند. این نشان می دهد که RLVR قابلیت های استدلال جدیدی را ایجاد نمی کند بلکه مدل را به سمت مسیرهایی که قبلاً رمزگذاری می کند ، سوگیری می کند.

سه نتیجه گیری کلیدی پدیدار می شود:

-

RLVR استدلال رمان را استخراج نمی کند: تمام مسیرهای استدلال مورد استفاده در مدل های RL در حال حاضر در مدل های پایه خود وجود دارد که توسط Pass@K در مقادیر بزرگ و توزیع های گیج کننده تأیید شده است.

-

RLVR کارآیی نمونه برداری را بهبود می بخشد: با تعصب توزیع خروجی به سمت پاسخ های بالا ، RL احتمال نمونه برداری از مسیرهای استدلال صحیح را که قبلاً در مدل پایه رمزگذاری شده اند ، افزایش می دهد.

-

rlvr مرز استدلال را باریک می کند: افزایش بهره وری به هزینه پوشش می رسد ، زیرا آموزش RL باعث کاهش آنتروپی خروجی می شود و اکتشاف را محدود می کند.

این یافته ها با تحقیقات در مورد یادگیری تقویت کننده ، واقعاً باعث تحریک ظرفیت استدلال می شود ، که درک متعارف از چگونگی تأثیر آموزش RL بر LLM ها را زیر سوال می برد.

تقطیر مرز استدلال را گسترش می دهد

بر خلاف RLVR ، تقطیر از مدل های استدلال قدرتمند می تواند واقعاً قابلیت های استدلال یک مدل را گسترش دهد. محققان Deepseek-R1-Distill-Qwen-7B (تقطیر شده از Deepseek-R1 به QWEN-2.5-MATH-7B) را با مدل پایه ، همتای آموزش دیده RL و نسخه تنظیم شده با آن مقایسه کردند.

مدل تقطیر شده به طور مداوم از مدل پایه در تمام مقادیر K بهتر عمل می کند ، نشان می دهد که تقطیر الگوهای استدلال جدیدی را که از مدل معلم قوی تر آموخته می شود ، معرفی می کند. این اساساً تقطیر را از RLVR متمایز می کند ، که با قابلیت های مدل پایه محدود می شود.

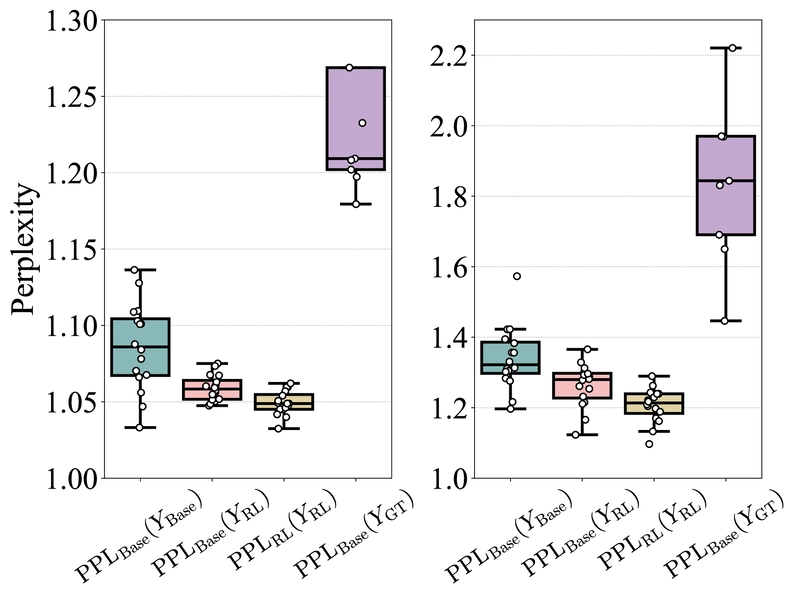

مقایسه الگوریتم های مختلف RL: محدودیت های مشابه

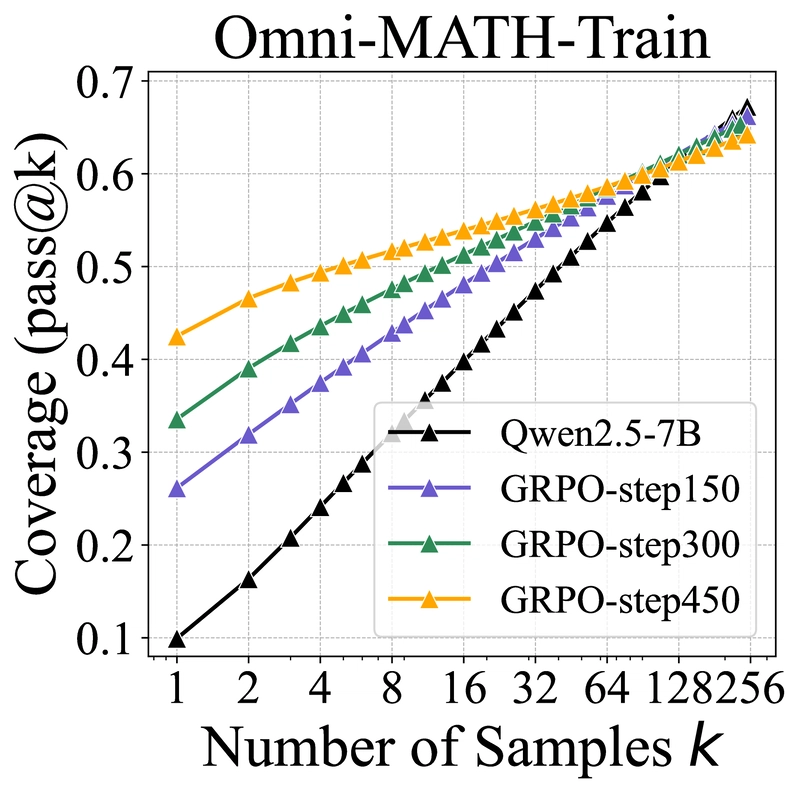

نمودارهای مقایسه الگوریتم های مختلف RL (بالا) و مراحل آموزشی (پایین) ، عملکرد را در مقادیر مختلف K نشان می دهد.

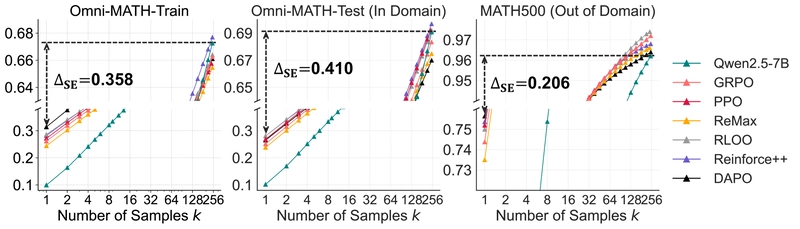

برای تعیین کمیت تأثیر RLVR بر کارآیی نمونه برداری ، محققان شکاف کارآیی نمونه برداری (ΔSE) را معرفی کردند – تفاوت بین یک مدل RL Pass@1 و مدل پایه آن Pass@256. ΔSE پایین تر نشان دهنده راندمان نمونه برداری بهتر است.

مقایسه الگوریتم های محبوب RL (PPO ، GRPO ، Revorce ++ ، Rloo ، Remax و DAPO) نشان می دهد که در حالی که آنها تغییرات جزئی دارند ، تفاوت ها اساسی نیست. ΔSE به طور مداوم بالاتر از 40 امتیاز در سراسر الگوریتم ها باقی مانده است ، نشان می دهد که رویکردهای فعلی به دور از بهینه هستند و ممکن است روشهای جدید برای نزدیک شدن به مرز فوقانی نظری مورد نیاز باشد.

| مدل | امنی | امنی | Math500 | |||

|---|---|---|---|---|---|---|

| 9.9 | 67.2 | 10.2 | 69.1 | 34.5 | 96.2 | |

| GRPO | 26.1 | 66.3 | 25.1 | 68.3 | 74.4 | 97.2 |

| PPO | 27.2 | 65.8 | 26.8 | 69.2 | 75.2 | 97.2 |

| بازپرداخت کردن | 24.4 | 65.5 | 23.8 | 67.5 | 73.5 | 96.6 |

| باکره | 28.6 | 66.4 | 28.1 | 69.2 | 75.0 | 97.4 |

| تقویت ++ | 28.2 | 67.7 | 28.0 | 69.7 | 75.4 | 96.8 |

| ترکیب کردن | 31.4 | 66.1 | 26.5 | 67.0 | 75.6 | 96.4 |

جدول 2: مقادیر دقیق برای هر نقطه در Pass@1 و عبور@256 در الگوریتم های مختلف RL در شکل 7.

نکته قابل توجه ، DAPO نمرات پاس@1 کمی بالاتر را کسب کرد اما در طول تمرین به 3-6 برابر نمونه بیشتر نیاز داشت و افت عملکرد قابل توجهی را در K = 256 نشان داد. RLOO و تقویت ++ ضمن حفظ هزینه های آموزش کارآمد ، به طور مداوم در تمام مقادیر K انجام می شود. Remax عملکرد کمتری را نشان داد ، احتمالاً به دلیل برآورد مزیت کمتر پایدار در تنظیمات پاداش باینری.

کاهش بازده آموزش RL گسترده

| مدل | امنی | امنی | Math500 | |||

|---|---|---|---|---|---|---|

| 9.9 | 67.2 | 10.2 | 69.1 | 34.5 | 96.2 | |

| GRPO-Step150 | 26.1 | 66.3 | 25.1 | 68.3 | 74.4 | 97.2 |

| GRPO-Step300 | 33.6 | 65.3 | 27.1 | 66.6 | 75.4 | 96.0 |

| GRPO-Step450 | 42.5 | 64.3 | 28.3 | 63.9 | 76.3 | 95.4 |

جدول 3: مقادیر دقیق در Pass@1 و Pass@256 در مراحل مختلف آموزش RL در شکل 7.

با پیشرفت آموزش RL ، عبور از@1 در مجموعه آموزش به طور مداوم بهبود می یابد (از 26.1 به 42.5) ، اما چندین روند مربوط به آن پدیدار می شود:

-

بهبود در مجموعه های آزمون (هر دو دامنه و خارج از دامنه) پس از 150 مرحله به طرز چشمگیری کاهش می یابد ، و این نشان می دهد که بیش از حد بالقوه به داده های آموزش می پردازد.

-

Pass@256 با افزایش مراحل آموزشی در تمام مجموعه داده ها کاهش می یابد و این نشانگر مرز استدلال در حال کوچک شدن است.

این نشان می دهد که آموزش طولانی تر آنتروپی و توانایی اکتشاف خروجی مدل را کاهش می دهد و ظرفیت استدلال آن را بیشتر می کند.

چرا RLVR نمی تواند مرزهای مدل پایه را بشکند

دو تفاوت کلیدی RLVR را برای LLM ها از برنامه های یادگیری سنتی تقویت کننده مانند Alphago Zero متمایز می کند:

-

فضای عمل گسترده: فضای اکشن مدل زبان از نظر ظاهری بزرگتر از بازی هایی مانند Go یا Atari است. الگوریتم های RL در ابتدا برای چنین فضاهای عظیم طراحی نشده بودند و اکتشافات مؤثر را از ابتدا غیرممکن می کردند.

-

مقدمات مقدماتی: بر خلاف RL سنتی که از ابتدا شروع می شود ، RLVR با یک مدل پیش ساخته حاوی مقدمات مفید آغاز می شود. این مدل را به سمت پاسخ های معقول راهنمایی می کند و بازخورد پاداش مثبت را قادر می سازد.

این مقدمات به عنوان یک شمشیر دو لبه عمل می کنند. در حالی که آنها یادگیری اولیه را تسهیل می کنند ، اکتشاف را نیز محدود می کنند. در چنین فضای پیچیده ای ، بیشتر پاسخهای ایجاد شده در طول آموزش از مدل پایه پیروی می کنند. انحرافات به احتمال زیاد با پاداش منفی خروجی های نامعتبر تولید می کنند.

الگوریتم های شیب خط مشی احتمال پاسخ های پاداش در قبل را به حداکثر می رسانند و در عین حال احتمال پاسخ های غیرقابل پیش بینی در خارج از آن را به حداقل می رساند. در نتیجه ، خط مشی آموزش دیده پاسخ هایی را که قبلاً در مرزهای قبلی و محدود کننده در مرزهای مدل پایه وجود دارد ، ایجاد می کند.

این بینش نشان می دهد که استدلال پزشکی در حال ظهور از RLVR و سایر برنامه های تخصصی ممکن است بدون توجه به اینکه آموزش RLVR چقدر گسترده است ، محدود به مرزهای مدل های پایه آنها باشد.

رویکردهای آینده ممکن است نیاز به فراتر از محدوده های قبلی داشته باشد یا پارادایم های جایگزین فراتر از RLVR خالص را توسعه دهند تا واقعاً قابلیت های استدلال را تقویت کنند.

واقع در این کار در چشم انداز تحقیقاتی گسترده تر

مرحله پس از آموزش برای تقویت توانایی های حل مسئله LLM بسیار مهم بوده است. رویکردهای سنتی شامل تنظیم دقیق با استفاده از داده های انسانی ، تکرار خود بهبود و یادگیری تقویت شده است.

RLVR برای بهبود استدلال در حوزه های ریاضیات و برنامه نویسی کشش قابل توجهی به دست آورده است. مدل O1 Openai پیشگام RL در مقیاس بزرگ برای استدلال بود ، و پس از آن Deepseek-R1 ، که تنظیم “صفر” را معرفی می کند-استفاده از یادگیری تقویت کننده مستقیماً در پایه های پایه بدون تنظیم نظارتی متوسط.

این امر تلاشهای متعددی برای منبع باز برای تکثیر یا گسترش روش R1 و بهبود الگوریتم های RL ایجاد کرد. به موازات ، یادگیری تقویت شده در استدلال چند حالته مورد توجه قرار گرفته است.

با وجود این پیشرفت ها ، درک عمیق از اثرات RLVR بر استدلال LLM و محدودیت های آن فاقد آن است. تحقیقات قبلی خاطرنشان كردند كه رفتارهای بازتابنده در مدل های RLVR از مدلهای پایه به جای آموزش RL پدیدار می شوند ، اما این مطالعه بیشتر پیش می رود – به طور سیستماتیک نشان می دهد كه تمام مسیرهای استدلال در حال حاضر در مدلهای پایه تعبیه شده اند و RLVR توانایی های استدلال جدیدی را ایجاد نمی كند.

تجسم مجدد آینده استدلال LLM

RLVR به طور گسترده ای به عنوان یک رویکرد امیدوارکننده برای فعال کردن LLM ها به طور مداوم خود بهبود و به دست آوردن توانایی های استدلال جدید در نظر گرفته شده است. با این حال ، این تحقیق به طور قطعی نشان می دهد که RLVR الگوهای استدلال اساساً جدید را استخراج نمی کند.

| مدل | شاخص های مشکل |

|---|---|

| پایه qwen-7b | 0،1،4،6،7،8،9،11،12،14،15،16،17،18،19،22،23،24،25،26،28،29 |

| Simplerll-Swen-7B | 0،1،6،7،8،9،12،14،15،16،18،22،23،24،25،26،27،28،29 |

جدول 4: شاخص های مشکلات قابل حل در AIME24 (شروع از 0). یک رابطه تقریبی زیر مجموعه قابل مشاهده است: بیشتر مشکلات حل شده توسط مدل RL نیز توسط مدل پایه قابل حل است.

در عوض ، RL در درجه اول باعث افزایش کارآیی نمونه برداری می شود – ساخت مدل ها بیشتر می توانند مسیرهای استدلال صحیح را تولید کنند که قبلاً در مدل های پایه رمزگذاری شده اند. این افزایش بهره وری به هزینه پوشش می رسد ، زیرا مرز استدلال با قابلیت های مدل پایه محدود است.

الگوریتم های RL فعلی از دستیابی به راندمان نمونه گیری بهینه ، تعریف شده توسط مرز استدلال مدل های پایه ، به دور باقی مانده است. در مقابل ، تقطیر نقش مهمی در معرفی الگوهای استدلال واقعی جدید و گسترش مرزهای استدلال دارد.

این یافته ها محدودیت اساسی در رویکردهای فعلی برای پیشبرد استدلال LLM را نشان می دهد و نشان می دهد که پارادایم های جدید ممکن است برای پیشی گرفتن از قابلیت های مدل پایه لازم باشد. برای محققان و دست اندرکاران در حال بررسی مرزهای استدلال هوش مصنوعی ، این کار بینش های اساسی در مورد مکانیسم های اساسی و محدودیت های یادگیری تقویت در مدل های زبان ارائه می دهد.

نمودار نمایش عملکرد پاس@k در مجموعه داده های فیلتر شده AIME24 ، تقویت یافته های اصلی.

برای خواندن خلاصه کامل این مقاله اینجا را کلیک کنید