باز کردن قفل استدلال منطقی در مدل های زبان بزرگ از طریق ادغام احتمالی

Summarize this content to 400 words in Persian Lang

این یک خلاصه مقالات انگلیسی ساده از یک مقاله تحقیقاتی به نام باز کردن قفل استدلال منطقی در مدلهای زبان بزرگ از طریق ادغام احتمالی است. اگر این نوع تحلیل ها را دوست دارید، باید به AImodels.fyi بپیوندید یا من را دنبال کنید توییتر.

بررسی اجمالی

توضیح انگلیسی ساده

این مقاله راه جدیدی را برای بهتر کردن مدلهای زبان بزرگ (LLM) در استدلال منطقی و تصمیمگیری ارائه میکند. LLM ها سیستم های هوش مصنوعی هستند که می توانند متنی شبیه انسان را درک و تولید کنند، اما گاهی اوقات با استدلال سازگار و قابل اعتماد فراتر از پردازش زبان طبیعی مبارزه می کنند.

ایده کلیدی این است که تکنیک های استدلال احتمالی را در LLM ادغام کنیم. این بدان معناست که مدلها فقط یک پاسخ را ارائه نمیکنند، بلکه چندین پیامد ممکن و احتمال آنها را در نظر میگیرند. این می تواند به مدل ها کمک کند منطقی تر استدلال کنند و تصمیمات متفکرانه تر و دقیق تری بگیرند.

این مقاله این رویکرد را با دیگر تلاشهای اخیر برای بهبود تواناییهای استدلالی LLM مقایسه میکند، مانند معیارهایی برای ارزیابی سیستماتیک استدلال منطقی، بررسی تکنیکهای استدلال مختلف، و روشهایی برای ترکیب استدلال احتمالی مستقیماً در مدلهای زبان.

توضیح فنی

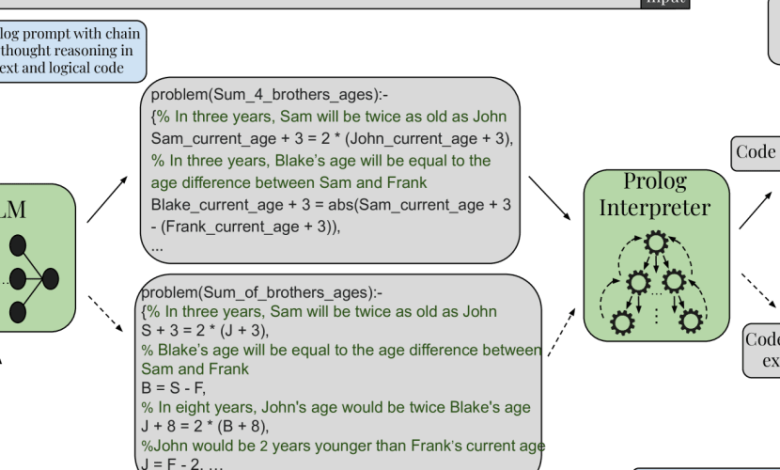

این مقاله یک رویکرد جدید برای افزایش قابلیتهای استدلال مدلهای زبان بزرگ (LLMs) با ادغام تکنیکهای استدلال احتمالی ارائه میکند. LLM های سنتی اغلب با حفظ ثبات منطقی و قابلیت اطمینان زمانی که فراتر از محدوده پردازش زبان طبیعی عمل می کنند، مشکل دارند.

برای پرداختن به این موضوع، نویسندگان روشی را پیشنهاد میکنند که به LLMها اجازه میدهد تا به صورت احتمالی، با در نظر گرفتن چندین پیامد ممکن و احتمالات مرتبط با آنها، استدلال کنند. این مؤلفه استدلال احتمالی به طور یکپارچه در معماری LLM ادغام شده است و مدل را قادر می سازد تا تصمیمات منطقی تر و منطقی تری اتخاذ کند.

این مقاله این رویکرد را با دیگر پیشرفتهای اخیر در این زمینه مقایسه میکند، مانند LogicBench، که معیاری برای ارزیابی تواناییهای استدلال منطقی LLMs، استدلال در مدلهای زبان بزرگ: یک نظرسنجی، که تکنیکهای استدلال مختلف اعمال شده در LLM را بررسی میکند، و احتمالاتی را ارائه میدهد. استدلال در مدلهای زبان بزرگ مولد، که ادغام استدلال احتمالی را مستقیماً در معماری مدل زبان بررسی میکند.

تحلیل انتقادی

این مقاله یک رویکرد امیدوارکننده برای افزایش قابلیتهای استدلال منطقی LLM ارائه میکند، اما در نظر گرفتن برخی محدودیتها و زمینههای بالقوه برای تحقیقات بیشتر مهم است.

یکی از اخطارهای بالقوه، پیچیدگی موجود در ادغام یکپارچه اجزای استدلال احتمالی در معماری های LLM موجود است. نویسندگان چالشهای فنی در دستیابی به این ادغام را تصدیق میکنند و ممکن است تحقیقات بیشتری برای اصلاح پیادهسازی و اطمینان از مقیاسپذیر و کارآمد بودن رویکرد مورد نیاز باشد.

علاوه بر این، این مقاله ارزیابی جامعی از عملکرد روش پیشنهادی در مقایسه با سایر رویکردهای پیشرفته ارائه نمیکند، مانند رویکردهایی که در فراتر از دقت: ارزیابی رفتار استدلالی در مدلهای زبان بزرگ و به سمت مدلهای زبانی منطقی سازگار از طریق احتمالاتی مورد بحث قرار گرفتهاند. . مطالعات تجربی بیشتر و محک زدن در برابر این تلاشهای مرتبط به زمینهسازی نقاط قوت و محدودیتهای رویکرد پیشنهادی کمک میکند.

نتیجه

این مقاله یک روش جدید برای افزایش قابلیتهای استدلال منطقی مدلهای زبان بزرگ (LLM) با ادغام تکنیکهای استدلال احتمالی معرفی میکند. نوآوری کلیدی، ادغام یکپارچه یک جزء استدلال احتمالی در معماری LLM است که به مدل اجازه میدهد تا نتایج ممکن متعدد و احتمالات مرتبط با آنها را هنگام تصمیمگیری در نظر بگیرد.

این رویکرد نشان دهنده یک گام مهم رو به جلو در بهبود قابلیت اطمینان و سازگاری LLM ها در هنگام کار فراتر از پردازش زبان طبیعی است. با ترکیب استدلال احتمالی، مدلها میتوانند تصمیمات متفکرانهتر و منطقیتری بگیرند که این پتانسیل را دارد که به طور قابلتوجهی بر طیف گستردهای از کاربردها، از هوش مصنوعی مکالمه تا سیستمهای پشتیبانی تصمیم، تأثیر بگذارد.

تحقیقات و ارزیابی بیشتر برای درک کامل نقاط قوت، محدودیتها و پیامدهای گستردهتر این روش ضروری خواهد بود، اما سهم مقاله در تلاشهای مداوم برای بهبود تواناییهای استدلالی LLMها افزودهای ارزشمند به این زمینه است.

اگر از این خلاصه لذت بردید، به AImodels.fyi بپیوندید یا من را دنبال کنید توییتر برای محتوای بیشتر هوش مصنوعی و یادگیری ماشین.

این یک خلاصه مقالات انگلیسی ساده از یک مقاله تحقیقاتی به نام باز کردن قفل استدلال منطقی در مدلهای زبان بزرگ از طریق ادغام احتمالی است. اگر این نوع تحلیل ها را دوست دارید، باید به AImodels.fyi بپیوندید یا من را دنبال کنید توییتر.

بررسی اجمالی

توضیح انگلیسی ساده

این مقاله راه جدیدی را برای بهتر کردن مدلهای زبان بزرگ (LLM) در استدلال منطقی و تصمیمگیری ارائه میکند. LLM ها سیستم های هوش مصنوعی هستند که می توانند متنی شبیه انسان را درک و تولید کنند، اما گاهی اوقات با استدلال سازگار و قابل اعتماد فراتر از پردازش زبان طبیعی مبارزه می کنند.

ایده کلیدی این است که تکنیک های استدلال احتمالی را در LLM ادغام کنیم. این بدان معناست که مدلها فقط یک پاسخ را ارائه نمیکنند، بلکه چندین پیامد ممکن و احتمال آنها را در نظر میگیرند. این می تواند به مدل ها کمک کند منطقی تر استدلال کنند و تصمیمات متفکرانه تر و دقیق تری بگیرند.

این مقاله این رویکرد را با دیگر تلاشهای اخیر برای بهبود تواناییهای استدلالی LLM مقایسه میکند، مانند معیارهایی برای ارزیابی سیستماتیک استدلال منطقی، بررسی تکنیکهای استدلال مختلف، و روشهایی برای ترکیب استدلال احتمالی مستقیماً در مدلهای زبان.

توضیح فنی

این مقاله یک رویکرد جدید برای افزایش قابلیتهای استدلال مدلهای زبان بزرگ (LLMs) با ادغام تکنیکهای استدلال احتمالی ارائه میکند. LLM های سنتی اغلب با حفظ ثبات منطقی و قابلیت اطمینان زمانی که فراتر از محدوده پردازش زبان طبیعی عمل می کنند، مشکل دارند.

برای پرداختن به این موضوع، نویسندگان روشی را پیشنهاد میکنند که به LLMها اجازه میدهد تا به صورت احتمالی، با در نظر گرفتن چندین پیامد ممکن و احتمالات مرتبط با آنها، استدلال کنند. این مؤلفه استدلال احتمالی به طور یکپارچه در معماری LLM ادغام شده است و مدل را قادر می سازد تا تصمیمات منطقی تر و منطقی تری اتخاذ کند.

این مقاله این رویکرد را با دیگر پیشرفتهای اخیر در این زمینه مقایسه میکند، مانند LogicBench، که معیاری برای ارزیابی تواناییهای استدلال منطقی LLMs، استدلال در مدلهای زبان بزرگ: یک نظرسنجی، که تکنیکهای استدلال مختلف اعمال شده در LLM را بررسی میکند، و احتمالاتی را ارائه میدهد. استدلال در مدلهای زبان بزرگ مولد، که ادغام استدلال احتمالی را مستقیماً در معماری مدل زبان بررسی میکند.

تحلیل انتقادی

این مقاله یک رویکرد امیدوارکننده برای افزایش قابلیتهای استدلال منطقی LLM ارائه میکند، اما در نظر گرفتن برخی محدودیتها و زمینههای بالقوه برای تحقیقات بیشتر مهم است.

یکی از اخطارهای بالقوه، پیچیدگی موجود در ادغام یکپارچه اجزای استدلال احتمالی در معماری های LLM موجود است. نویسندگان چالشهای فنی در دستیابی به این ادغام را تصدیق میکنند و ممکن است تحقیقات بیشتری برای اصلاح پیادهسازی و اطمینان از مقیاسپذیر و کارآمد بودن رویکرد مورد نیاز باشد.

علاوه بر این، این مقاله ارزیابی جامعی از عملکرد روش پیشنهادی در مقایسه با سایر رویکردهای پیشرفته ارائه نمیکند، مانند رویکردهایی که در فراتر از دقت: ارزیابی رفتار استدلالی در مدلهای زبان بزرگ و به سمت مدلهای زبانی منطقی سازگار از طریق احتمالاتی مورد بحث قرار گرفتهاند. . مطالعات تجربی بیشتر و محک زدن در برابر این تلاشهای مرتبط به زمینهسازی نقاط قوت و محدودیتهای رویکرد پیشنهادی کمک میکند.

نتیجه

این مقاله یک روش جدید برای افزایش قابلیتهای استدلال منطقی مدلهای زبان بزرگ (LLM) با ادغام تکنیکهای استدلال احتمالی معرفی میکند. نوآوری کلیدی، ادغام یکپارچه یک جزء استدلال احتمالی در معماری LLM است که به مدل اجازه میدهد تا نتایج ممکن متعدد و احتمالات مرتبط با آنها را هنگام تصمیمگیری در نظر بگیرد.

این رویکرد نشان دهنده یک گام مهم رو به جلو در بهبود قابلیت اطمینان و سازگاری LLM ها در هنگام کار فراتر از پردازش زبان طبیعی است. با ترکیب استدلال احتمالی، مدلها میتوانند تصمیمات متفکرانهتر و منطقیتری بگیرند که این پتانسیل را دارد که به طور قابلتوجهی بر طیف گستردهای از کاربردها، از هوش مصنوعی مکالمه تا سیستمهای پشتیبانی تصمیم، تأثیر بگذارد.

تحقیقات و ارزیابی بیشتر برای درک کامل نقاط قوت، محدودیتها و پیامدهای گستردهتر این روش ضروری خواهد بود، اما سهم مقاله در تلاشهای مداوم برای بهبود تواناییهای استدلالی LLMها افزودهای ارزشمند به این زمینه است.

اگر از این خلاصه لذت بردید، به AImodels.fyi بپیوندید یا من را دنبال کنید توییتر برای محتوای بیشتر هوش مصنوعی و یادگیری ماشین.