نحوه استفاده از Later’s AI Caption Writer برای اینستاگرام

نحوه استفاده از Caption Writer بعدی هوش مصنوعی برای اینستاگرام (و زمان بندی پست ها)

Later یک پلت فرم مدیریت رسانه اجتماعی است که بیش از 4 میلیون برند، سازندگان و مدیران رسانه های اجتماعی برای زمان بندی محتوا، تجزیه و تحلیل داده ها و موارد دیگر به آن اعتماد دارند.

در اینجا نحوه استفاده از تولید کننده کپشن اینستاگرام ما با هوش مصنوعی (و ارسال محتوای خود) در شش مرحله ساده آمده است:

مرحله 1: پروفایل اینستاگرام خود را متصل کنید

ارتقا دهید یا در یک طرح جدید با پرداخت بعداً ثبت نام کنید و پروفایل اینستاگرام خود را وصل کنید.

نکته: برای افزودن، حذف یا انتقال نمایه اینستاگرام خود در Later، بررسی کنید این صفحه مفید.

مرحله 2: محتوای خود را در کتابخانه رسانه Later’s آپلود کنید

از آنجا، روی «آپلود رسانه» کلیک کنید و محتوا را از رایانه، Dropbox یا Google Drive خود آپلود کنید.

همچنین میتوانید فایلها را مستقیماً به کتابخانه رسانه بکشید و رها کنید سریعتر روند!

مرحله 3: محتوا را برای زمانبندی انتخاب کنید

نمایه اینستاگرامی را که می خواهید در آن منتشر کنید انتخاب کنید (دایره هایلایت شده را دوبار بررسی کنید).

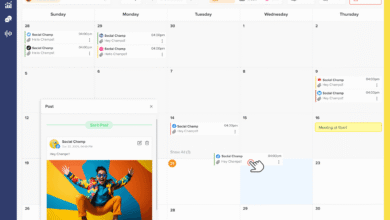

سپس، یک تصویر یا ویدیو را از کتابخانه رسانه خود به تقویم محتوا بکشید و رها کنید:

مرحله چهارم: ابزار AI Caption Writer را انتخاب کنید

برای ایجاد کپشن خود، روی “AI Caption Writer” در قسمت Post Caption کلیک کنید:

مرحله پنجم: متن خود را تایپ کنید

متن ورودی (بین 3 تا 80 کاراکتر) که پست شما را توصیف می کند.

این می تواند شرح تصویر یا ویدیویی باشد که استفاده می کنید، یا موضوع کلی پست – به عنوان مثال، جشن راه اندازی یک محصول جدید.

سعی کنید از کلمات کلیدی خاصی استفاده کنید و به یاد داشته باشید که لحن صدای برند خود را نیز درج کنید.

روی «ایجاد شرحها» کلیک کنید و در عرض چند ثانیه زیرنویسهای جدیدی خواهید داشت:

حداکثر سه عنوان ایجاد خواهد شد – با طولهای مختلف، سبکهای کپی، و گاهی اوقات شکلکها یا هشتگها.

روی عنوانی که میخواهید استفاده کنید کلیک کنید و به طور خودکار به قسمت شرح پست شما اضافه میشود:

از آنجا میتوانید عنوان را ویرایش کنید، ایموجیها یا هشتگهای مرتبطتری را وارد کنید، اولین نظر را اضافه کنید، عناصر طراحی را به محتوای خود اضافه کنید (مانند فیلترها)، و حسابهای دیگر را تگ کنید.

توجه داشته باشید: همچنین میتوانید یک علامت شست به بالا یا انگشت شست را روی زیرنویسهای ایجاد شده اعمال کنید – این به Later’s AI Caption Writer اجازه میدهد تا با سبک شما سازگار شود.

مرحله ششم: تاریخ و زمان را برای برنامه ریزی پست خود انتخاب کنید

اگر نمایه کسب و کار اینستاگرام دارید، «انتشار خودکار» را از لیست کشویی انتخاب کنید و تاریخ و ساعتی را که میخواهید پست شما منتشر شود، انتخاب کنید.

روی “ذخیره” کلیک کنید – و voila!

توجه داشته باشید: اگر یک نمایه سازنده یا شخصی اینستاگرام دارید، به دلیل محدودیت های API اینستاگرام نمی توانید پست ها را به صورت خودکار منتشر کنید. در عوض، زمانی که زمان ارسال است، یک اعلان تلفن همراه دریافت خواهید کرد.

بنابراین، آیا ما فکر می کنیم که باید به آن تغییر دهید؟ فقط با استفاده از تولید کننده کپشن اینستاگرام؟ خیر

اما آنها می توانند یک ویژگی عالی برای کمک به شما در صرفه جویی در زمان و به جریان افتادن آن آب میوه های خلاق باشند.

بعلاوه، با قضاوت بر اساس رونق ناگهانی ابزارهای مبتنی بر هوش مصنوعی برای رسانه های اجتماعی، این تازه شروع کار است.

گوش به زنگ باشید. 👀