بازیگر Fallout، کایل مک لاکلان، نمایش را با کار دیوید لینچ مقایسه کرد

بازیگر کایل مکلاکلان نمایش Fallout را با کار دیوید لینچ مقایسه میکند و نمایش و جهانسازی آن را ستایش میکند.

مک لاکلان در صحبت با TheGamer قبل از نمایش Fallout نشان می دهد که قبل از پذیرفتن این نقش با سری بازی آشنا نبوده است. از طریق تحقیقات خود، او می گوید که متوجه شده است که این یک معامله “بسیار بزرگتر” از آن چیزی است که او پیش بینی می کرد، و دنیای Fallout را به عنوان “بسیار پیچیده، خوب طراحی شده” توصیف کرد. [and] واقع بین.”

چگونه دنیای Fallout با Twin Peaks مقایسه می شود

مکلاکلان میگوید: «غیر منتظرهترین بخش آن تغییر لحن بود، که چندان بی شباهت به کاری که دیوید لینچ انجام میدهد نیست. او چیزی را که واقعاً ظریف و شیرین به نظر می رسد در مقابل چیزی بسیار خشن و ساینده قرار می دهد.

“این مورد در Fallout بود، زیرا شما این لحظات بسیار خشونت آمیز را سپری می کنید، و سپس یک آهنگ شیرین را در پشت آن پخش می کنید. مغز شما به نوعی قطع می کند. شما کاملا مطمئن نیستید که کدام مسیر را دنبال کنید. من آن را جذاب بیابید.”

MacLachlan ادامه می دهد: “این تقریباً یک واقعیت سوم را برای آنچه می بینید ایجاد می کند. شما واقعاً نمی دانید چیست. این ترکیبی از همه چیز است.”

27:25

مصاحبه: چگونه نمایش Fallout عاشق جهان و طرفدارانش شد

ما با هاوارد کامینگز، طراح تولید Fallout صحبت کردیم که با تماشای ویدیوهای داستانی ساخته شده توسط طرفداران در یوتیوب، درباره این سریال تحقیق کرد.

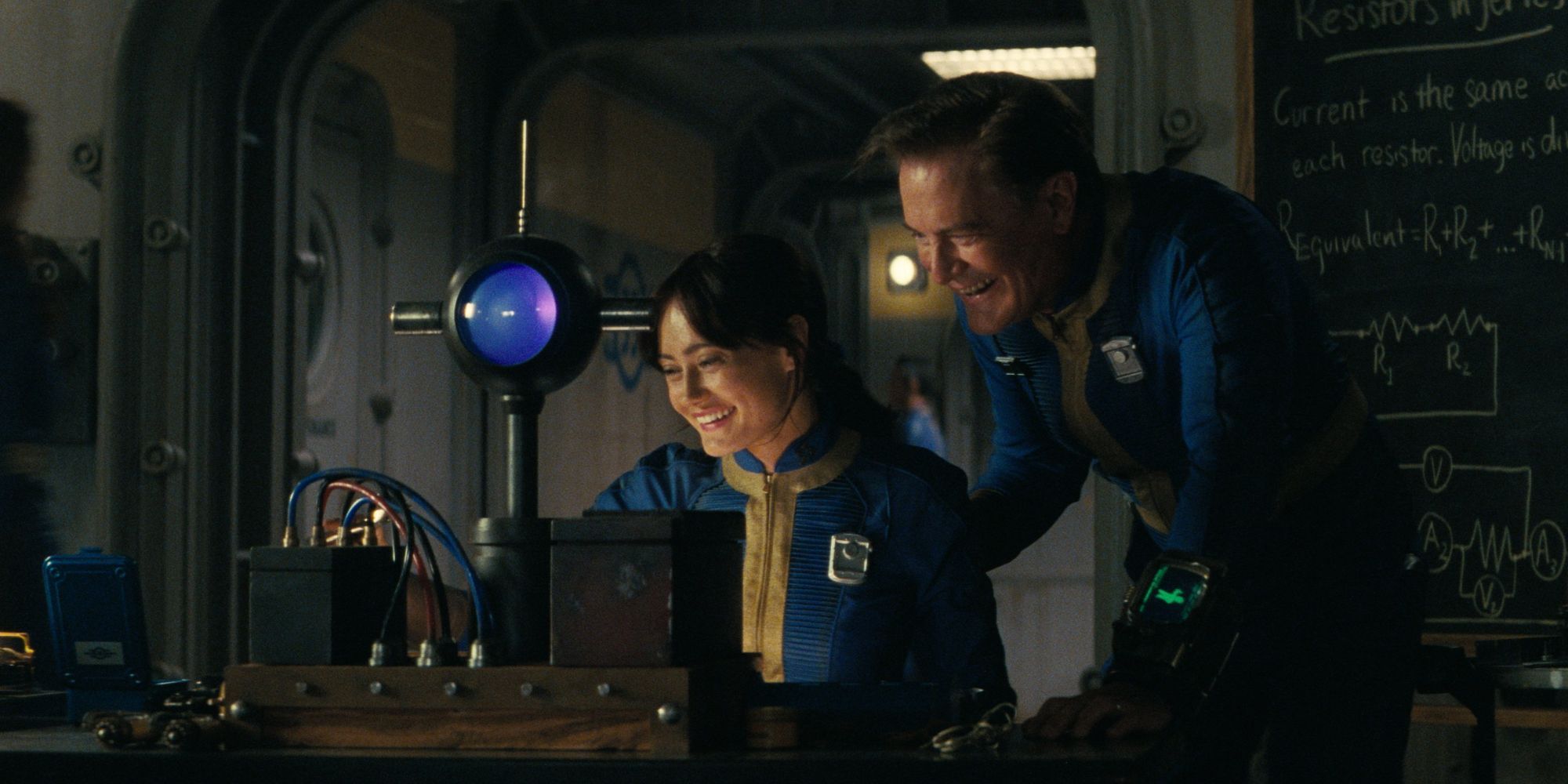

مک لاکلان از زمان اقتباس کارگردان فیلم Dune در سال 1984، یکی از همکاران قدیمی دیوید لینچ بوده است. او را شاید بتوان بیشتر به عنوان مامور دیل کوپر در Twin Peaks به یاد آورد، نقشی که او در سال 2017 احیا کرد. در Fallout، او نقش هنک، ناظر Vault 33 و پدر یکی از شخصیت های اصلی ما، لوسی را بازی می کند.

اگر فکر میکنید یک نمایش ماوراء خشونت که شرکتهای بزرگ را فراخوانی میکند، برای Amazon Prime Video مناسب است، تنها نیستید. ما همچنین با مجریان برنامه Fallout صحبت کردیم که از “پوچی” آمازون در تبلیغ یک برنامه Fallout آگاه هستند. با این حال، آنها اضافه کردند که این “بخشی از جذابیت” برای آنها هنگام پیوستن به پروژه بود و اصرار داشتند که اصل بازی ها همچنان در نمایش پیدا خواهد شد.

طرفداران می توانند خودشان تصمیم بگیرند که Fallout چه زمانی به Prime Video این هفته برسد. در تاریخ 11 آوریل از طریق سرویس استریم پخش می شود و هر هشت قسمت به طور همزمان در دسترس قرار می گیرد.

وجود ماتریس 5 به طور فعال امتیاز را کاهش می دهد

بدون واچوفسکی ها، من تماشا نمی کنم.